XTuner V1이란 무엇인가요?

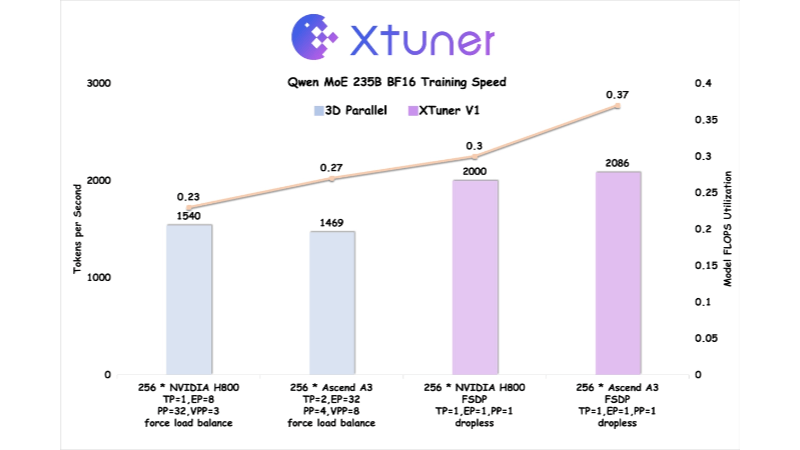

XTuner V1은 상하이 인공 지능 연구소에서 오픈 소스화한 차세대 대규모 모델 훈련 엔진으로, 초대형 스파스 혼합 전문가(MoE) 모델 훈련을 위해 설계되었습니다. 파이토치 FSDP를 기반으로 개발된 XTuner V1은 메모리, 통신, 부하 등의 다차원 최적화를 통해 고성능 훈련을 달성합니다. XTuner V1은 최대 1조 개의 파라미터를 가진 MoE 모델의 훈련을 지원하며, 처음으로 2000억 개 이상의 규모 모델에서 훈련 처리량 측면에서 기존의 3D 병렬 솔루션을 능가합니다. 시퀀스 병렬 처리 기술 없이 64k의 긴 시퀀스 훈련을 지원하여 전문가의 병렬 처리 의존성을 크게 줄이고 긴 시퀀스 훈련 효율을 향상시킵니다.

XTuner V1의 특징

- 비파괴 교육2000억 규모의 MoE 모델은 전문가 병렬 처리 없이 학습할 수 있으며, 6000억 모델은 노드 내 전문가 병렬 처리만 필요합니다.

- 긴 시퀀스 지원시퀀스 병렬 처리 없이 2,000억 개의 MoE 모델에 대한 64k 시퀀스 길이 학습을 지원합니다.

- 높은 효율성기존 3D 병렬 처리를 통해 1조 개의 파라미터와 2000억 개 이상의 모델 훈련 처리량으로 MoE 모델 훈련을 지원합니다.

- 비디오 메모리 최적화자동 청크 손실 메커니즘과 비동기 체크포인트 스왑 기술을 통해 그래픽 메모리 급증을 줄입니다.

- 커뮤니케이션 범위메모리 최적화 및 인트라노드 도미노-EP 기술을 통해 통신 시간 소비를 차단합니다.

- DP 로드 밸런싱가변 길이 주의로 인한 계산 널 버블 문제를 완화하고 병렬 차원의 데이터에서 로드 밸런싱을 유지합니다.

- 하드웨어 공동 최적화화웨이 라이즈와 협력하여 Ascend A3 NPU 슈퍼노드에 최적화되어 훈련 효율성이 NVIDIA H800을 능가합니다.

- 오픈 소스 및 도구 체인 지원XTuner V1, DeepTrace 및 ClusterX 오픈 소스를 완벽하게 지원합니다.

XTuner V1의 핵심 이점

- 효율적인 교육최대 1조 개의 파라미터에 대한 MoE 모델 학습을 지원하며, 2000억 개 이상의 규모 모델에 대해 기존 3D 병렬 솔루션보다 뛰어난 학습 처리량을 제공합니다.

- 긴 시퀀스 처리강화 학습과 같은 긴 텍스트 처리 시나리오에 적합한 시퀀스 병렬 처리 없이 2,000억 개의 MoE 모델에 대한 64k 시퀀스 길이 학습.

- 낮은 리소스 요구 사항2000억 개의 파라메트릭 모델에는 전문가 병렬 처리가 필요하지 않으며, 6000억 개의 모델에는 노드 내 전문가 병렬 처리만 필요하므로 하드웨어 리소스 요구 사항이 줄어듭니다.

- 비디오 메모리 최적화이 시스템에 새로 추가된 기술은 자동 청크 손실 및 비동기 체크포인트 스왑을 통해 메모리 스파이크를 크게 줄여 대규모 모델 학습을 지원하는 새로운 기술입니다.

- 커뮤니케이션 최적화메모리 최적화 및 노드 내 도미노-EP 기술을 통해 통신 시간 소비를 마스킹하여 통신 오버헤드가 훈련 효율에 미치는 영향을 줄입니다.

- 로드 밸런싱가변 길이 주의로 인한 계산 널 버블 문제 완화, 데이터 병렬 차원의 로드 밸런싱 보장, 학습 효율성 향상.

XTuner V1의 공식 웹사이트는 무엇인가요?

- 프로젝트 웹사이트:: https://xtuner.readthedocs.io/zh-cn/latest/

- GitHub 리포지토리:: https://github.com/InternLM/xtuner

XTuner V1의 대상 사용자

- 대규모 모델 연구자초대형 희소 혼합 전문 지식(MoE) 모델을 훈련해야 하는 연구자를 위해 XTuner V1은 최대 1조 개의 파라미터로 모델 훈련을 지원하는 고성능 훈련 엔진을 제공합니다.

- 딥러닝 엔지니어대규모 분산 교육 작업을 하는 엔지니어를 위해 XTuner V1은 최적화된 통신 및 메모리 관리 기능을 제공하여 교육 효율성을 크게 향상시킵니다.

- AI 인프라 개발자하드웨어 공동 최적화 및 고성능 컴퓨팅에 중점을 둔 개발자를 위해 XTuner V1은 화웨이의 Rise 기술 팀과 협력하여 심층적인 하드웨어별 최적화를 제공합니다.

- 오픈 소스 커뮤니티 기여자오픈 소스 프로젝트에 관심이 있고 기여하고자 하는 개발자에게는 XTuner V1의 오픈 소스 코드가 풍부한 개발 및 최적화 기회를 제공합니다.

- 엔터프라이즈 AI 팀대규모 모델 트레이닝을 위한 효율적이고 문턱이 낮은 솔루션이 필요한 엔터프라이즈 팀을 위해 사용하기 쉬운 고성능 툴체인 지원을 제공하는 XTuner V1.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...