일반 소개

XRAG(eXamining the Core)는 고급 검색 증강 생성(RAG) 시스템의 기본 구성 요소를 평가하기 위해 고안된 벤치마킹 프레임워크입니다. 각 핵심 모듈을 프로파일링하고 분석함으로써 XRAG는 다양한 구성과 구성 요소가 RAG 시스템의 전체 성능에 어떤 영향을 미치는지에 대한 인사이트를 제공합니다. 이 프레임워크는 여러 검색 방법과 평가 지표를 지원하며 연구자와 개발자가 RAG 시스템의 모든 측면을 최적화하고 개선할 수 있도록 설계되었습니다.

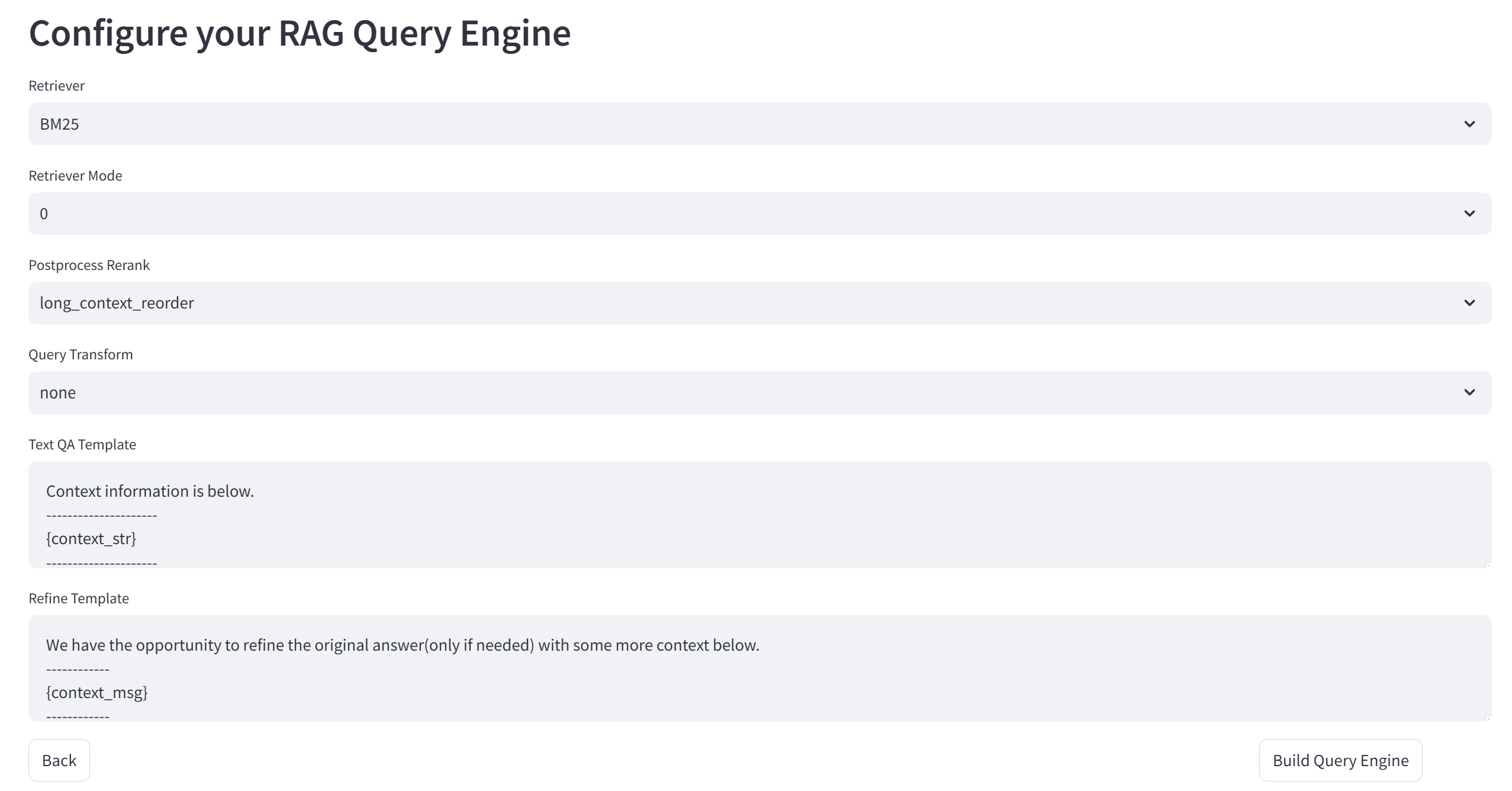

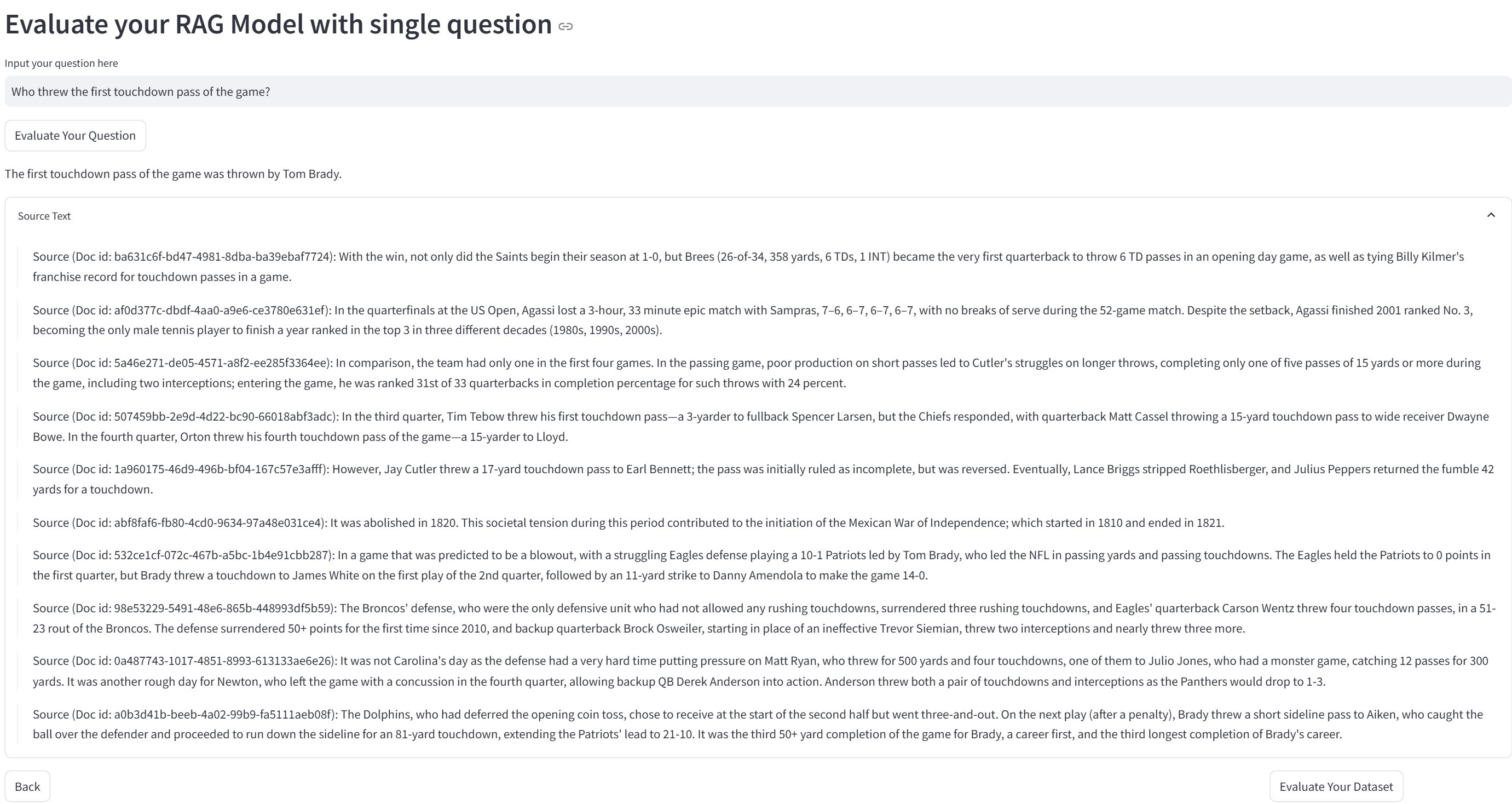

XRAG는 50개 이상의 테스트 메트릭과 RAG 종합 평가 및 장애 지점 최적화를 다루는 종합적인 RAG 평가 벤치마크 및 툴킷을 지원하고, 4가지 유형의 고급 RAG 모듈(쿼리 재구성, 고급 검색, 질문 및 답변 모델, 후처리)의 비교를 지원하며, 모듈 내에서 여러 특정 구현을 통합하고, OpenAI 빅 모델 API를 지원합니다. 또한 XRAG 버전 1.0은 간단한 웹 UI 데모, 가벼운 대화형 데이터 업로드 및 통합된 표준 형식을 제공하며, RAG 오류 감지 및 최적화 방법을 통합합니다. 이 문서와 코드는 이제 오픈 소스입니다.

기능 목록

- 통합 평가 프레임워크LLM 기반 평가, 심층 평가 및 기존 메트릭을 포함한 다차원 평가 지원.

- 유연한 아키텍처다양한 검색 방법과 맞춤형 검색 전략을 지원하는 모듈식 설계.

- 멀티-LLM 지원OpenAI 모델과의 원활한 통합 및 네이티브 모델 지원(예: Qwen, LLaMA 등).

- 다양한 평가 지표 세트:: 기존 지표(F1, EM, MRR 등) 및 LLM 기반 지표(진실성, 관련성 등)를 포함합니다.

- 고급 검색 방법BM25, 벡터 시맨틱 검색, 트리 구조 검색 및 기타 검색 방법을 지원합니다.

- 사용자 친화적인 인터페이스대화형 평가 및 시각화를 지원하는 명령줄 인터페이스와 웹 UI를 제공합니다.

도움말 사용

설치 프로세스

- 클론 창고::

git clone https://github.com/DocAILab/XRAG.git

cd XRAG

- 종속성 설치::

pip install -r requirements.txt

- 구성 환경필요에 따라 수정

config.toml파일을 사용하여 모델 매개변수 및 API 설정을 구성할 수 있습니다.

사용 가이드라인

- 웹 UI 시작하기::

xrag-cli webui

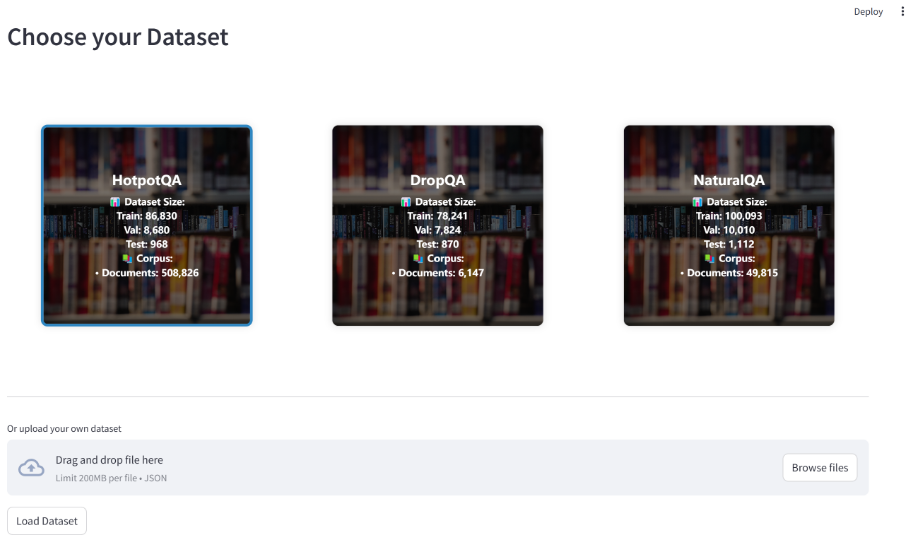

여러 벤치마크 데이터 세트(예: HotpotQA, DropQA, NaturalQA)를 지원하는 웹 UI를 통해 데이터 세트를 업로드하고 구성하세요.

- 운영 평가명령줄 도구를 사용하여 평가를 실행합니다:

xrag-cli evaluate --dataset <dataset_path> --config <config_path>

평가 결과에 대한 자세한 보고서와 시각화 차트가 생성됩니다.

- 맞춤형 검색 전략수정 : 수정

src/xrag디렉터리 코드를 사용하여 검색 전략 및 평가 모델을 추가하거나 조정할 수 있습니다.

주요 기능

- 데이터 세트 업로드 및 구성웹 UI를 통해 데이터셋을 업로드하고 필요에 따라 구성합니다.

- 평가 실행평가 지표 및 검색 방법을 선택하고 평가를 실행한 후 결과를 확인합니다.

- 결과 분석: 생성된 보고서와 시각적 다이어그램을 통해 평가 결과를 분석하고 시스템 성능을 최적화합니다.

올라마 프레임워크: XRAG에서 효율적인 지역화된 검색 추론 구현하기

Ollama는 XRAG-Ollama 지역화된 검색 추론 프레임워크에서 중요한 역할을 합니다. 로컬 빅 모델을 실행하기 위한 사용하기 쉬운 오픈 소스 프레임워크인 Ollama는 강력한 지역화된 검색 추론 기능을 XRAG에 제공하여 XRAG가 검색 향상 생성 기능을 최대한 활용할 수 있게 해줍니다.

XRAG 배포를 현지화해야 하는 이유는 무엇인가요?

- 외부 위험 감소: 로컬 배포를 사용하면 외부 서비스에 대한 의존도가 줄어들고 불안정한 타사 서비스 또는 데이터 유출과 관련된 잠재적 위험이 줄어듭니다.

- 오프라인 가용성현지화된 RAG 시스템은 인터넷 연결에 의존하지 않으며 네트워크 중단 시에도 정상적으로 작동할 수 있어 서비스의 연속성과 안정성을 보장합니다.

- 자율적인 데이터 관리로컬 배포를 통해 사용자는 개인 데이터를 로컬 벡터 데이터베이스에 포함시켜 조직의 자체 보안 표준 및 비즈니스 요구 사항에 따라 데이터가 처리되도록 하는 등 데이터 저장, 관리 및 처리 방식을 완벽하게 제어할 수 있습니다.

- 데이터 프라이버시 및 보안로컬 환경에서 RAG 시스템을 실행하면 네트워크를 통해 민감한 데이터를 전송하여 데이터가 손상될 위험을 방지하고 데이터를 항상 로컬에서 제어할 수 있습니다. 이는 기밀 정보를 다루는 조직에 특히 중요합니다.

왜 올라마입니까?

올라마는 로컬 머신에서 대규모 언어 모델(LLM)을 구축하고 실행하기 위한 가볍고 확장 가능한 프레임워크입니다. 모델을 생성, 실행 및 관리할 수 있는 간단한 API와 다양한 애플리케이션에서 쉽게 사용할 수 있는 사전 구축된 모델 라이브러리를 제공합니다. DeepSeek, Llama 3.3, Phi 3, Mistral, Gemma 2 등과 같은 다양한 모델을 지원할 뿐만 아니라 최신 하드웨어 가속 계산을 활용할 수 있어 XRAG를 위한 고성능 추론 지원도 제공합니다. 또한, 올라마는 모델 양자화를 지원하여 그래픽 메모리 요구 사항을 크게 줄일 수 있습니다. 예를 들어 4비트 양자화는 FP16 정밀도 가중치 파라미터를 4비트 정수 정밀도로 압축하여 모델 가중치 볼륨과 추론에 필요한 그래픽 메모리를 크게 줄여줍니다. 따라서 일반 가정용 컴퓨터에서 대규모 모델을 실행할 수 있습니다.

Ollama와 결합하면 복잡한 환경 구성과 대량의 컴퓨팅 리소스에 의존하지 않고도 대규모 언어 모델을 로컬에서 효율적으로 실행할 수 있어 배포 및 운영 비용을 크게 절감할 수 있습니다. 동시에 로컬 배포 솔루션은 개발자에게 데이터 처리에 대한 완전한 제어권을 부여하여 원시 데이터 정리, 벡터화된 처리(예: ChromaDB를 통한 비공개 지식 기반 구축)부터 최종 애플리케이션 구현에 이르는 전체 사용자 지정 체인을 지원합니다. 로컬 인프라 기반 배포 아키텍처는 자연스럽게 오프라인 운영이 가능하여 서비스 연속성을 보장할 뿐만 아니라 특수 환경(예: 기밀 네트워크 등)에서의 시스템 안정성에 대한 엄격한 요구 사항도 충족합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...