로컬 GPU가 없는 프라이빗 배포 DeepSeek-R1 32B

와 관련하여 DeepSeek-R1 일상적인 사무실 사용의 경우 다른 우려 사항이나 특별한 요구 사항이 있는 경우 공식 웹 사이트에서 직접 사용하는 것이 최선의 선택입니다. 반드시 DeepSeek-R1의 로컬 배포(원클릭 설치 프로그램 사용)여기에 있는 백서 튜토리얼을 참고하세요.

컴퓨터가 제대로 구성되지 않았지만 여전히 비공개 DeepSeek-R1을 사용하여 배포하려는 경우 ... 그렇다면 오래 전에 모두에게 가르쳐준 무료 GPU 사용을 고려해 보세요. 무료 GPU 성능으로 딥시크-R1 오픈 소스 모델을 온라인으로 배포하기그러나 치명적인 단점이 있습니다. 즉, 무료 GPU는 14B 만 설치할 수 있으며 32B를 설치하면 매우 카드가 될 것이지만 테스트 후 DeepSeek-R1 32B 이상의 출력 품질 만 설치하여 일상적인 작업의 요구를 충족시킬 수 있습니다.

그래서... 우리가 할 일은 효율적으로 실행되는 무료 GPU를 딥시크-R1 32B의 정량적 버전. 그가 온다!

무료 GPU에서는 초당 2 ~ 6 단어의 출력에서 수행 할 수 있습니다 (문제 출력 속도의 복잡성에 따라 변동),이 방법의 단점은 때때로 서비스를 켜야한다는 것입니다.

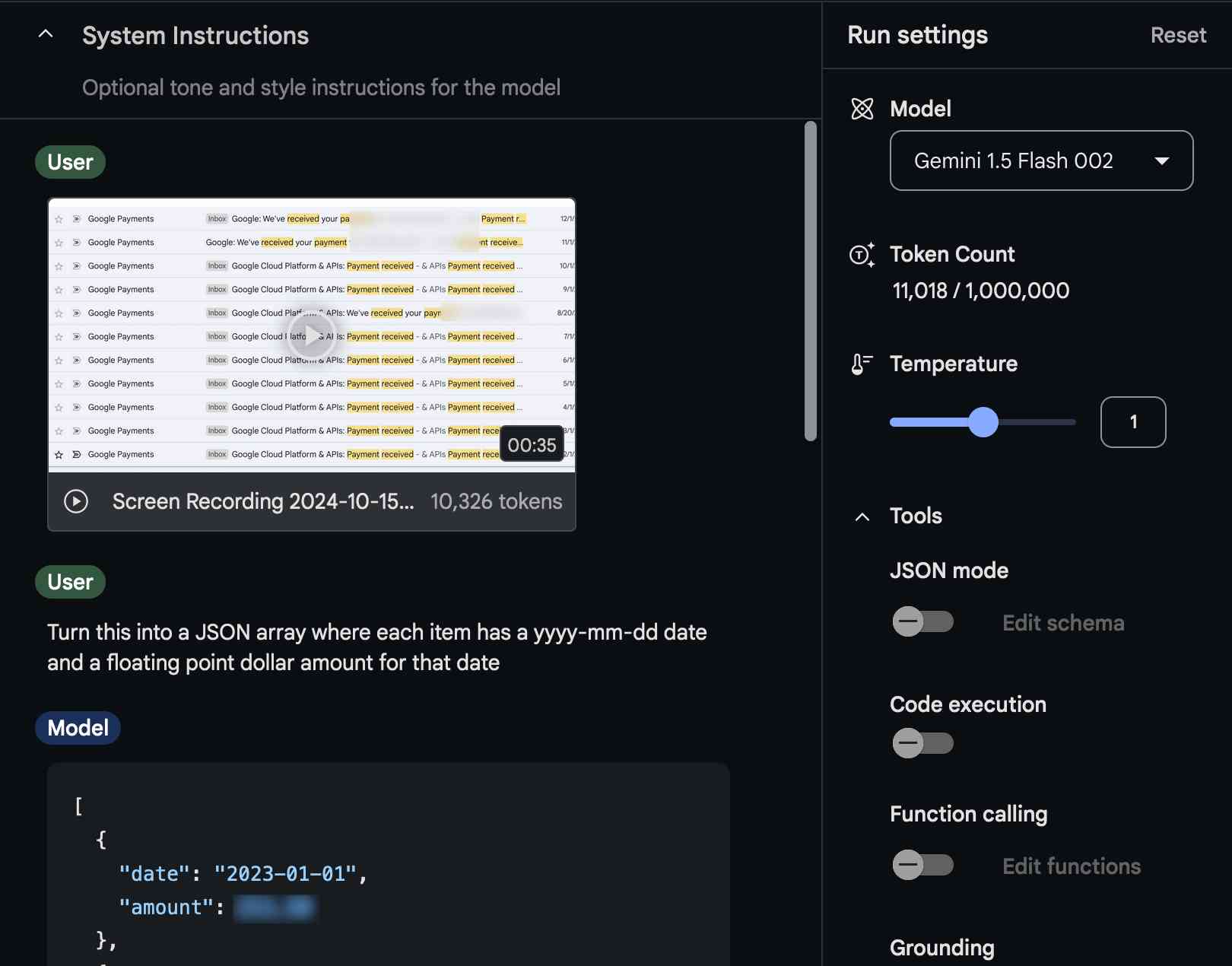

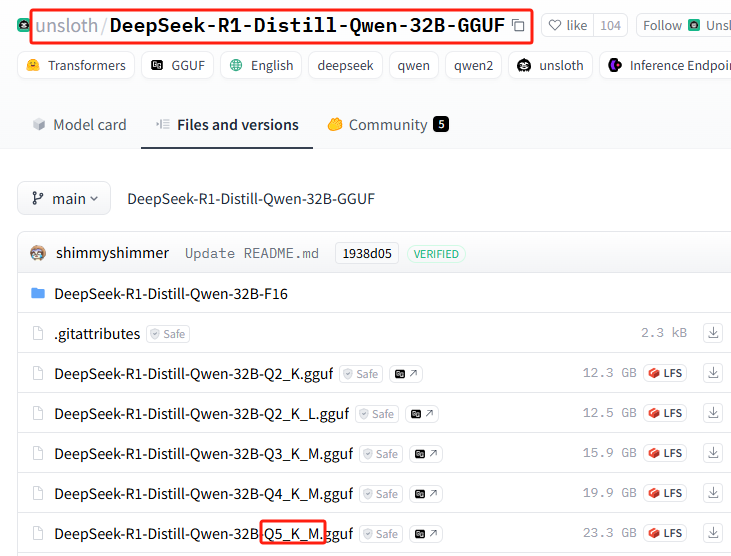

언슬로스 팀 정량화 버전 DeepSeek-R1

unsloth 제공되는 Qwen-32B-Q4_K_M 버전은 20GB로 압축되어 이미 소비자용 단일 카드에서 실행할 수 있습니다..

정량화된 버전에 대한 컴퓨터 성능 요구 사항을 간략하게 요약합니다.

DeepSeek-R1-Distill-Qwen-32B-GGUF다양한 정량적 모델 버전에 대한 설명

각 파일의 접미사(예: Q2_K_L, Q4_K_M 등)는 서로 다른 양자화를 나타냅니다. 주요 차이점은 다음과 같습니다:

Q2_K_L, Q3_K_M, Q4_K_M, Q5_K_M, Q6_K, Q8_0

Q2및Q3및Q4및Q5및Q6및Q8는 계산할 비트 수를 나타냅니다(예Q4(4비트 계산을 나타냄).K게다가M정량적 전략이나 정확도 수준이 다를 수 있습니다.Q8_0일반적으로 8비트 양자화, FP16 정밀도에 가깝고 계산 요구량이 가장 높지만 추론 품질이 더 우수합니다.

DeepSeek-R1-Distill-Qwen-32B-F16

F16표시16비트 부동 소수점(FP16)는 계산되지 않은 모델로, 정확도는 가장 높지만 비디오 메모리를 가장 많이 사용합니다.

여기에서 정량화의 개념에 대해 자세히 알아보세요:모델 정량화란 무엇인가: FP32, FP16, INT8, INT4 데이터 유형 설명

올바른 버전을 선택하려면 어떻게 해야 하나요?

- 낮은 비디오 메모리 장치(예: 소비자용 GPU) →선택Q4, Q5 정량화예

Q4_K_M어쩌면Q5_K_M성능과 정확성 사이의 균형입니다. - 극도로 낮은 메모리 장치(예: CPU 작동) →선택2분기 또는 3분기 정량화예

Q2_K_L어쩌면Q3_K_M를 사용하여 메모리 공간을 줄입니다. - 고성능 GPU 서버→선택Q6 또는 Q8 정량화예

Q6_K어쩌면Q8_0를 사용하여 더 나은 추론 품질을 얻을 수 있습니다. - 가장 효과적→선택

F16버전을 사용해야 하지만 상당한 양의 대용량 저장 공간(약 60GB 이상)이 필요합니다.

무료 GPU 권장 설치 버전

Q2_K_L

DeepSeek-R1 32B 설치 시작

무료 GPU를 얻는 방법부터 설치까지 Ollama 프로세스 스키밍 또는 읽기:무료 GPU 성능으로 딥시크-R1 오픈 소스 모델을 온라인으로 배포하기이전 튜토리얼과 유일한 차이점은 설치 명령이 약간 변경되었다는 점입니다.

Ollama에서 특정 정량화된 버전을 설치하는 방법으로 바로 이동하세요. 다행히 Ollama는 전체 설치 과정을 극도로 간소화하여 설치 명령어 하나만 배우면 됩니다.

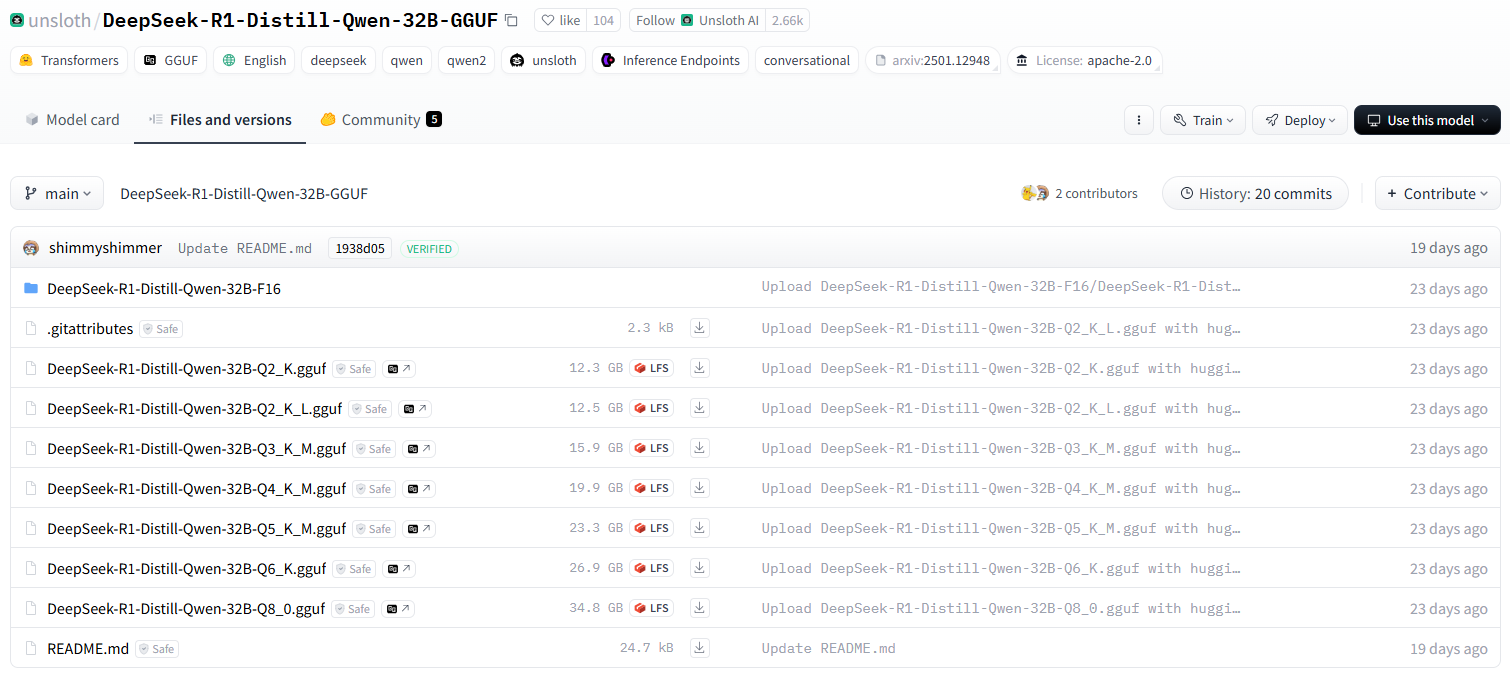

1. 허깅페이스 정량적 버전 관리 모델 기본 명령 형식 설치하기

다음 설치 명령 형식을 기억하세요.

ollama run hf.co/{username}:{reponame}

2. 정량적 버전 선택

모든 정량적 버전 목록: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

이 설치는 다음을 사용합니다: Q5_K_M(데모용으로만 사용되며다시 한 번 무료 GPU 권장 버전을 설치하세요!(실제 설치 시 Q5에는 23G의 하드 드라이브 공간이 필요합니다.)

3. 스플라이스 설치 명령

{사용자 이름}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

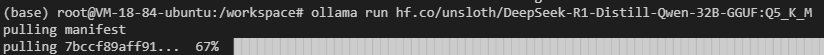

전체 설치 명령을 얻으려면 함께 연결하세요:ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

4. Ollama에서 설치를 수행합니다.

설치 명령을 실행합니다.

네트워크 오류가 발생할 수 있으므로 설치 명령을 몇 번 더 반복하고...

여전히 작동하지 않나요? 다음 명령을 실행하여 시도해 보세요(국내 미러 주소로 전환):ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

공식 주소를 먼저 사용한 다음 미러 주소를 사용하는 대신 미러 주소를 사용하여 다운로드하는 것은 어떨까요?

통합 설치가 더 빠르기 때문입니다!

물론 이 정량화된 버전이 필요하지 않으시다면, 최근 인기 있는 무수정 버전이 있습니다: ollama run huihui_ai/deepseek-r1-abliterated:14b

5. 소외된 사람들이 올라마에 접근할 수 있도록 하기

터미널에 명령을 입력하여 올라마 포트를 확인합니다.

ollama serve

11414 또는 6399

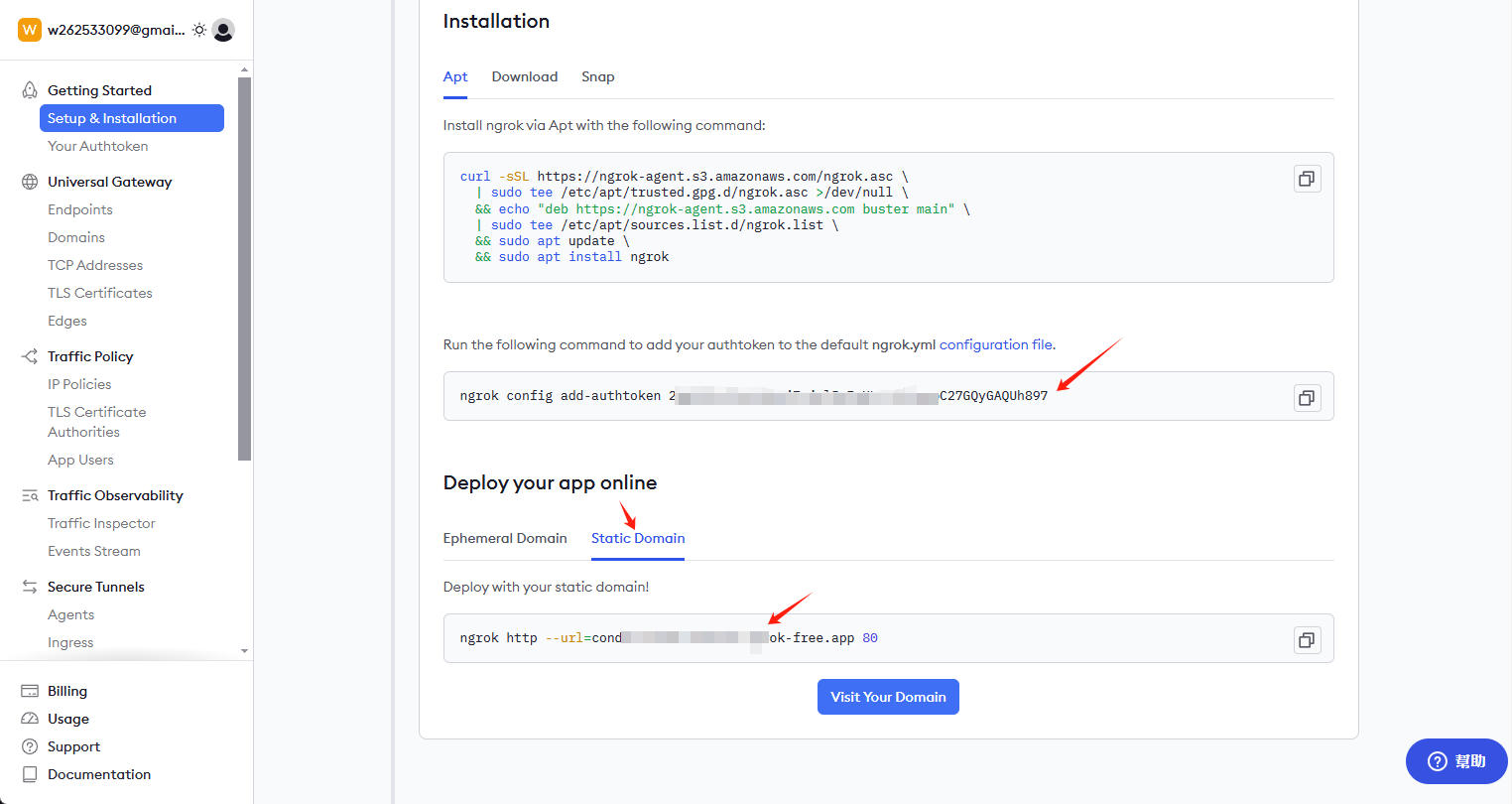

ngrok 설치

curl -sSL https://ngrok-agent.s3.amazonaws.com/ngrok.asc \ | tee /etc/apt/trusted.gpg.d/ngrok.asc >/dev/null \ && echo "deb https://ngrok-agent.s3.amazonaws.com buster main" \ | tee /etc/apt/sources.list.d/ngrok.list \ && apt update \ && apt install ngrok

키 및 영구 링크 받기

ngrok.com을 방문하여 계정에 가입하고 홈페이지로 이동하여 키와 영구 링크를 받으세요.

키를 설치하고 외부 액세스 주소를 활성화합니다.

클라이언트에서 다음 명령을 입력합니다:

ngrok config add-authtoken 这里是你自己的密钥

외부 액세스를 열려면 다음 명령을 계속 입력하십시오: 6399 이 포트는 모든 사람과 다를 수 있으므로 직접 확인하고 수정하십시오.

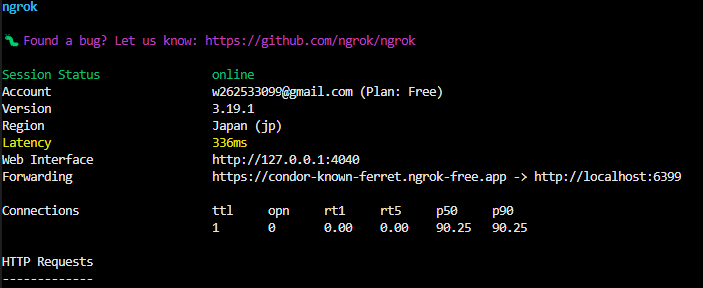

ngrok http --url=condor-known-ferret.ngrok-free.app 6399

성공하면 터미널에 다음과 같은 내용이 표시됩니다.

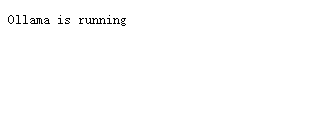

https://condor-known-ferret.ngrok-free.app 은 모델 인터페이스의 액세스 주소이며, 이를 열면 다음 내용을 볼 수 있습니다.

활용

https://condor-known-ferret.ngrok-free.app如何使用 에서 가져온 것입니까?

가장 쉬운 방법은 다음을 설치하는 것입니다. 페이지 지원 함께 사용하는 이 도구는 자체적으로 설치되는 브라우저 플러그인입니다.

구성

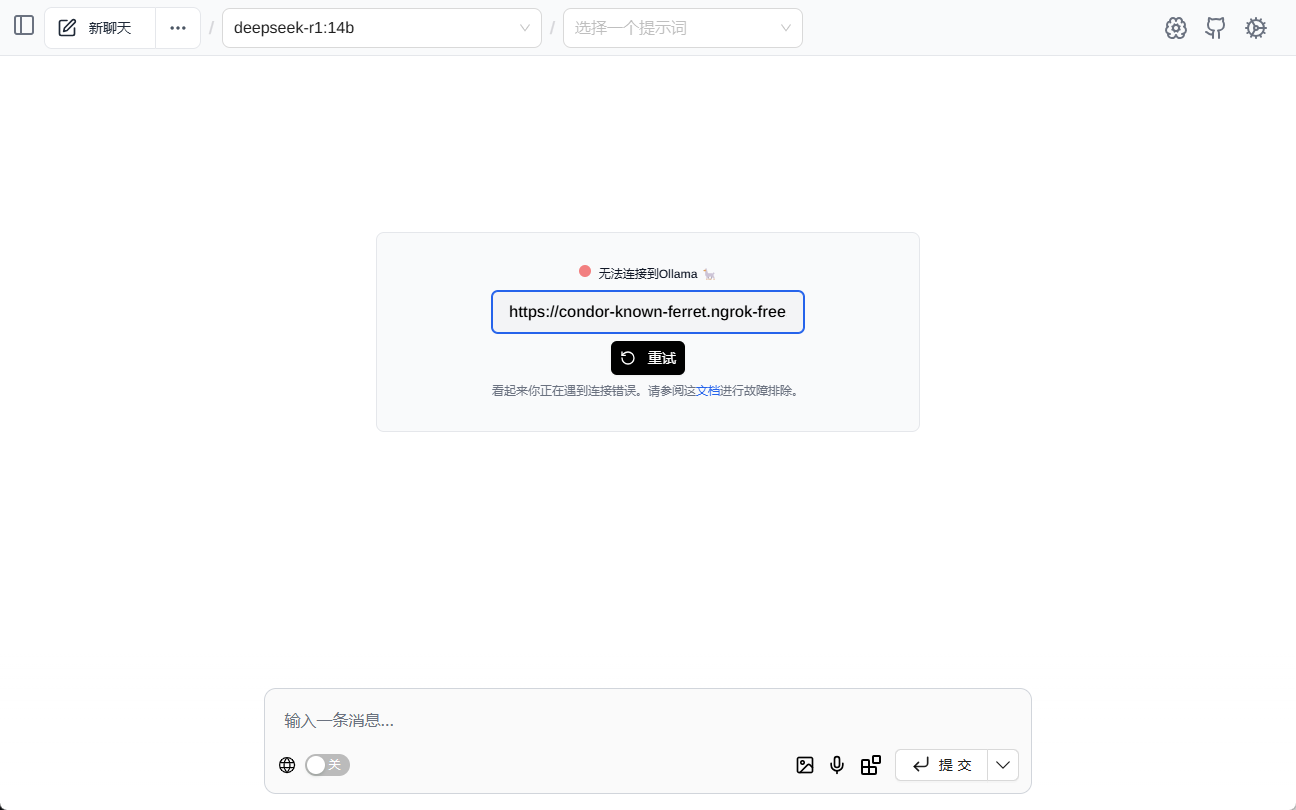

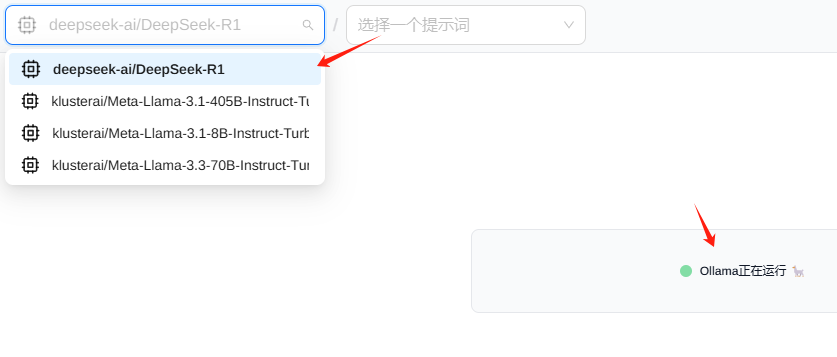

쇼(티켓) 페이지 지원 그 후 다음 인터페이스가 표시되며, 인터페이스 주소를 입력하세요.

일반적으로 모델이 자동으로 로드되는 것을 볼 수 있습니다.

테스트(기계 등)

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...