일반 소개

비디오그레인은 멀티그레인 비디오 편집에 초점을 맞춘 오픈 소스 프로젝트로, xAI 팀에서 개발하여 GitHub에서 호스팅하고 있습니다. 이 프로젝트는 ICLR 2025 컨퍼런스에 선정된 논문 "VideoGrain: Modulating Space-Time Attention for Multi-Grained Video Editing"을 기반으로 합니다. 확산 모델에서 시공간적 주의 메커니즘을 변조하여 카테고리, 인스턴스, 로컬 수준에서 동영상 콘텐츠를 세밀하게 편집할 수 있습니다. 기존 방식에 비해 비디오그레인은 텍스트와 영역 제어의 의미 정렬 문제와 특징 결합 문제를 해결하고, 추가 교육 없이도 고품질 편집을 완료할 수 있습니다. 이 프로젝트는 개발자, 연구자 및 비디오 편집 애호가를 위해 완전한 코드, 설치 가이드 및 사전 훈련된 모델을 제공하며 이미 학계 및 오픈 소스 커뮤니티에서 주목을 받고 있습니다.

기능 목록

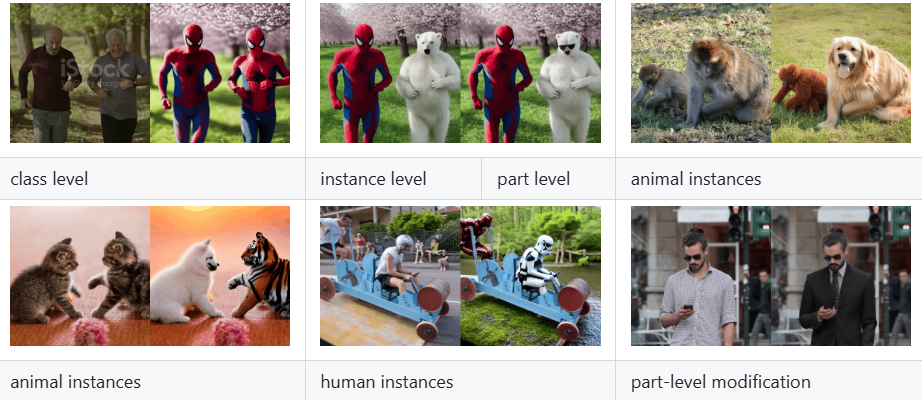

- 다중 세분화 비디오 편집동영상에서 카테고리(예: '사람'을 '로봇'으로 바꾸기), 인스턴스(예: 특정 개체), 로컬 세부 사항(예: 손동작)의 정밀한 수정을 지원합니다.

- 제로 샘플 편집 기능특정 동영상에 대해 다시 교육할 필요 없이 텍스트 프롬프트에 입력하기만 하면 편집이 완료됩니다.

- 시공간적 주의력 변조교차 주의(텍스트와 영역 간) 및 자체 주의(영역 내 기능 분리)를 강화하여 편집 정확도와 동영상 품질을 개선합니다.

- 오픈 소스 코드 및 모델링전체 구현 코드와 사전 학습된 모델이 제공되어 사용자가 쉽게 재현하고 확장할 수 있습니다.

- 확산 호환 모델기존 동영상 생성 프로세스에 쉽게 통합할 수 있도록 디퓨저 및 FateZero와 같은 프레임워크를 기반으로 합니다.

- 여러 문서 지원사용자가 업로드한 동영상, 이미지 및 기타 콘텐츠를 처리하고 편집된 동영상 결과물을 출력할 수 있습니다.

도움말 사용

비디오그레인은 약간의 프로그래밍 지식과 하드웨어 지원이 필요하지만, 설치 및 운영 절차는 GitHub 저장소에 자세히 설명되어 있습니다. 아래는 사용자가 빠르게 시작할 수 있도록 자세한 설치 및 사용 가이드를 제공합니다.

설치 프로세스

- 콘다 환경 만들기

터미널에 다음 명령을 입력하여 독립 실행형 Python 3.10 환경을 생성하고 활성화합니다:

conda create -n videograin python=3.10

conda activate videograin

Conda가 설치되어 있는지 확인하고, 설치되어 있지 않은 경우 Anaconda 웹사이트로 이동하여 다운로드하세요.

- PyTorch 및 관련 종속성 설치하기

VideoGrain은 PyTorch와 CUDA를 지원하므로 GPU 가속을 권장합니다. 다음 명령을 실행하여 설치하세요:

conda install pytorch==2.3.1 torchvision==0.18.1 torchaudio==2.3.1 pytorch-cuda=12.1 -c pytorch -c nvidia

pip install --pre -U xformers==0.0.27

x포머는 메모리와 속도에 최적화할 수 있으며, 필요하지 않은 경우 건너뛸 수 있습니다.

- 추가 종속성 설치

리포지토리 루트에서 다음 명령을 실행하여 모든 종속 라이브러리를 설치합니다:

pip install -r requirements.txt

인터넷이 열려 있는지 확인하세요. 일부 패키지를 다운로드하려면 과학적인 인터넷 액세스가 필요할 수 있습니다.

- 사전 학습된 모델 다운로드

VideoGrain에는 Stable Diffusion 1.5 및 ControlNet과 같은 모델 가중치가 필요합니다. 리포지토리에 제공된 스크립트를 실행합니다:

bash download_all.sh

그러면 기본 모델이 지정된 디렉토리에 자동으로 다운로드됩니다. 수동으로 다운로드하려면 허깅 페이스 또는 Google 드라이브 링크를 방문하세요(자세한 내용은 README 참조).

- 컨트롤넷 전처리기 가중치 준비하기

약 4GB의 어노테이터 가중치(예: DW-Pose, depth_midas 등)를 다운로드합니다. 다음 명령을 사용합니다:

gdown https://drive.google.com/file/d/1dzdvLnXWeMFR3CE2Ew0Bs06vyFSvnGXA/view?usp=drive_link

tar -zxvf videograin_data.tar.gz

파일의 압축을 풀고 파일을 ./annotator/ckpts 카탈로그.

사용법

설치가 완료되면, 사용자는 명령줄을 통해 비디오그레인을 실행하여 동영상 편집을 할 수 있습니다. 주요 기능의 작동 흐름은 다음과 같습니다:

1. 다중 세분화 비디오 편집

- 입력 파일 준비하기

편집할 비디오 파일을 프로젝트 디렉토리에 넣습니다(예./input_video.mp4). MP4, AVI와 같은 일반적인 형식을 지원합니다. - 문자 알림 준비하기

예를 들어 스크립트에서 편집 지침을 지정합니다:

prompt = "将视频中的汽车替换为保时捷"

지원 카테고리 교체(예: "자동차"를 "포르쉐"로), 인스턴스 수정(예: "특정 캐릭터"를 "아이언맨 ") 및 로컬 조정(예: "손 움직임"을 "손 흔들기"로).

- 편집 명령을 실행합니다.

터미널에 입력합니다:

python edit_video.py --input ./input_video.mp4 --prompt "将视频中的汽车替换为保时捷" --output ./output_video.mp4

편집 후 결과는 다음 주소로 저장됩니다. ./output_video.mp4.

2. 샘플 편집 제로

- 교육 없이 직접 편집

VideoGrain의 핵심 강점은 제로 샘플 기능입니다. 사용자는 사전 교육이 필요 없이 동영상과 단서만 제공하면 됩니다. 예시:

python edit_video.py --input ./sample_video.mp4 --prompt "将狗替换为猫" --output ./edited_video.mp4

- 조정 매개변수

통과 가능--strength이 매개변수는 편집 강도(0.0-1.0, 기본값 0.8)를 제어합니다:

파이썬 편집_비디오.py --input . /sample_video.mp4 --prompt "개를 고양이로 교체" --strength 0.6

3. 시간적 주의력 조절

- 향상된 텍스트 영역 제어

비디오그레인은 자동으로 교차 주의를 최적화하여 프롬프트가 대상 영역에만 영향을 미치도록 합니다. 예를 들어 "캐릭터의 의상을 빨간색으로 변경"이라는 안내가 있는 경우, 불필요한 배경은 영향을 받지 않습니다. - 향상된 기능 분리

자체 주의 메커니즘은 지역 내 세부 사항의 일관성을 향상시키고 지역 간 간섭을 줄입니다. 사용자가 수동으로 조정할 필요가 없으며 런타임에 자동으로 적용됩니다.

취급 시 주의사항

- 하드웨어 요구 사항

최소 12GB의 비디오 메모리를 갖춘 NVIDIA GPU(예: A100 또는 RTX 3090)를 권장합니다. CPU가 느리게 실행될 수 있습니다. - 큐 단어 제안

예를 들어 "왼쪽의 캐릭터를 로봇으로 교체"와 같이 구체적이고 명확해야 하며, 모호한 "캐릭터 수정"보다는 "왼쪽의 캐릭터를 로봇으로 교체"가 더 좋습니다. - 디버깅 및 로깅

문제가 발생하면./logs디렉터리에 추가하거나 명령 뒤에 로그 파일을 추가하여--verbose자세한 출력 보기.

주요 기능

- 실제 다중 입도 편집

사용자가 동영상에서 '자전거'를 '오토바이'로 바꾸고 싶다고 가정하고, 동영상 경로와 큐 단어를 입력하기만 하면 VideoGrain이 모든 자전거를 인식하고 액션과 배경을 일관되게 유지하면서 오토바이로 대체합니다. - 오픈 소스 확장

사용자 수정 가능edit_video.py모델 매개변수를 변경하거나, 더 높은 해상도 또는 더 많은 편집 유형 지원 등 디퓨저 프레임워크에 기반한 새로운 기능을 추가할 수 있습니다. - 커뮤니티 지원

GitHub 리포지토리는 사용자가 문제를 제출하거나 다른 사용자가 수행한 작업을 확인할 수 있는 이슈 게시판을 제공합니다.

위의 단계를 통해 사용자는 VideoGrain을 빠르게 시작하고 간단한 교체부터 복잡한 로컬 조정까지 다양한 동영상 편집 작업을 완료할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...