트랜스포머는 2017년 Vaswani 등이 제안한 자연어 처리(NLP)를 위한 딥러닝 모델 아키텍처입니다. 주로 기계 번역, 텍스트 생성 등과 같은 시퀀스 간 작업을 처리하는 데 사용됩니다.

간단히 말해, 텍스트 생성을 위한 트랜스포머 모델은 '다음 단어 예측'이라는 원리로 작동합니다.

사용자가 텍스트(프롬프트)를 입력하면 모델은 다음 단어가 무엇일 가능성이 가장 높은지 예측합니다. 트랜스포머의 핵심 혁신이자 강점은 자기 주의 메커니즘을 사용하여 전체 시퀀스를 처리하고 이전 아키텍처(RNN)보다 장거리 종속성을 더 효율적으로 포착할 수 있다는 점입니다.

또한 주목할 만한 점은 깃허브의 huggingface/transformers에 트랜스포머 구현과 사전 학습된 수많은 모델을 포함한 허깅페이스의 트랜스포머 구현 저장소가 있다는 점입니다.

현재 LLM은 기본적으로 트랜스포머 아키텍처를 기반으로 하며, 최적화 기술과 트레이닝 방법이 개선되었습니다.

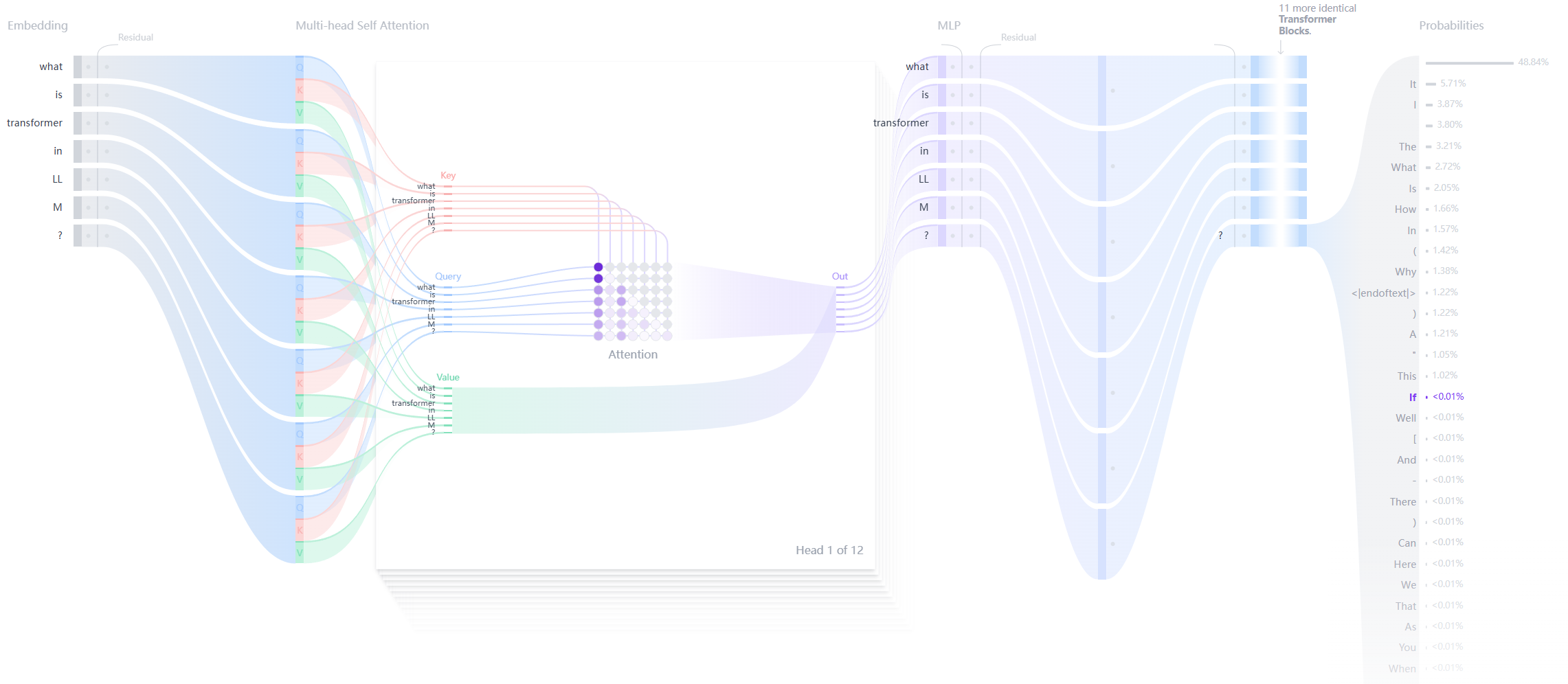

트랜스포머의 구조

각 텍스트 생성 트랜스포머는 세 가지 주요 구성 요소로 이루어져 있습니다:

임베딩 레이어(임베딩) ::

- 텍스트 입력은 토큰이라는 작은 단위로 나뉘며, 토큰은 단어 또는 하위 단어가 될 수 있습니다.

- 이러한 어휘 요소는 임베딩이라는 숫자 벡터로 변환됩니다.

- 이러한 임베딩 벡터는 단어의 의미적 의미를 포착합니다.

변압기 블록 ::

이는 모델이 입력 데이터를 처리하고 변환하기 위한 기본 빌딩 블록입니다. 각 블록은 다음으로 구성됩니다:

- 주의 메커니즘 ::

- 트랜스포머 블록의 핵심 구성 요소

- 어휘 요소가 서로 통신할 수 있도록 허용하기

- 문맥 정보 및 단어 간의 관계 파악하기

- 다층 퍼셉트론(MLP) 레이어 ::

- 각 어휘 요소를 독립적으로 처리하는 피드 포워드 네트워크

- 주의 계층의 목표는 어휘 요소 간에 정보를 라우팅하는 것입니다.

- MLP의 목표는 각 어휘 요소의 표현을 최적화하는 것입니다.

출력 확률 ::

- 최종 리니어 및 소프트맥스 레이어

- 처리된 임베딩을 확률로 변환하기

- 모델이 시퀀스의 다음 어휘 요소를 예측할 수 있도록 합니다.

트랜스포머의 장점:

- 병렬화 트랜스포머는 RNN과 달리 데이터를 순차적으로 처리할 필요가 없으므로 병렬 계산을 위해 GPU를 더 잘 활용하고 학습 속도를 향상시킬 수 있습니다.

- 장거리 의존성 자체 주의 메커니즘을 통해 트랜스포머는 장거리 종속성을 순서대로 효율적으로 캡처할 수 있습니다.

- 손재주 트랜스포머는 더 큰 모델(예: BERT, GPT 등)로 쉽게 확장할 수 있으며 다양한 NLP 작업에서 우수한 성능을 발휘합니다.

트랜스포머의 단점:

- 높은 계산 복잡성 자기 주의 메커니즘의 계산 복잡도는 O(n^2)로, 입력 시퀀스의 길이가 길면 더 많은 계산 리소스를 소비합니다.

- 데이터에 대한 높은 수요 트랜스포머는 일반적으로 성능을 충분히 활용하기 위해 훈련에 많은 양의 데이터가 필요합니다.

- 내재적 서열 정보 부족 내장된 시퀀스 처리 메커니즘(예: RNN의 시간 단계)이 없으므로 시퀀스 정보를 도입하려면 추가 메커니즘(예: 위치 인코딩)이 필요합니다.

참조

이 두 가지 참고 문헌 중 첫 번째는 트랜스포머에 관한 고전적인 논문인 '주의 집중'입니다. 트랜스포머를 처음 제안한 것은 이 논문입니다.

두 번째는 변압기에 대한 시각적 설명으로, 변압기의 내부 구조를 확인할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...