일반 소개

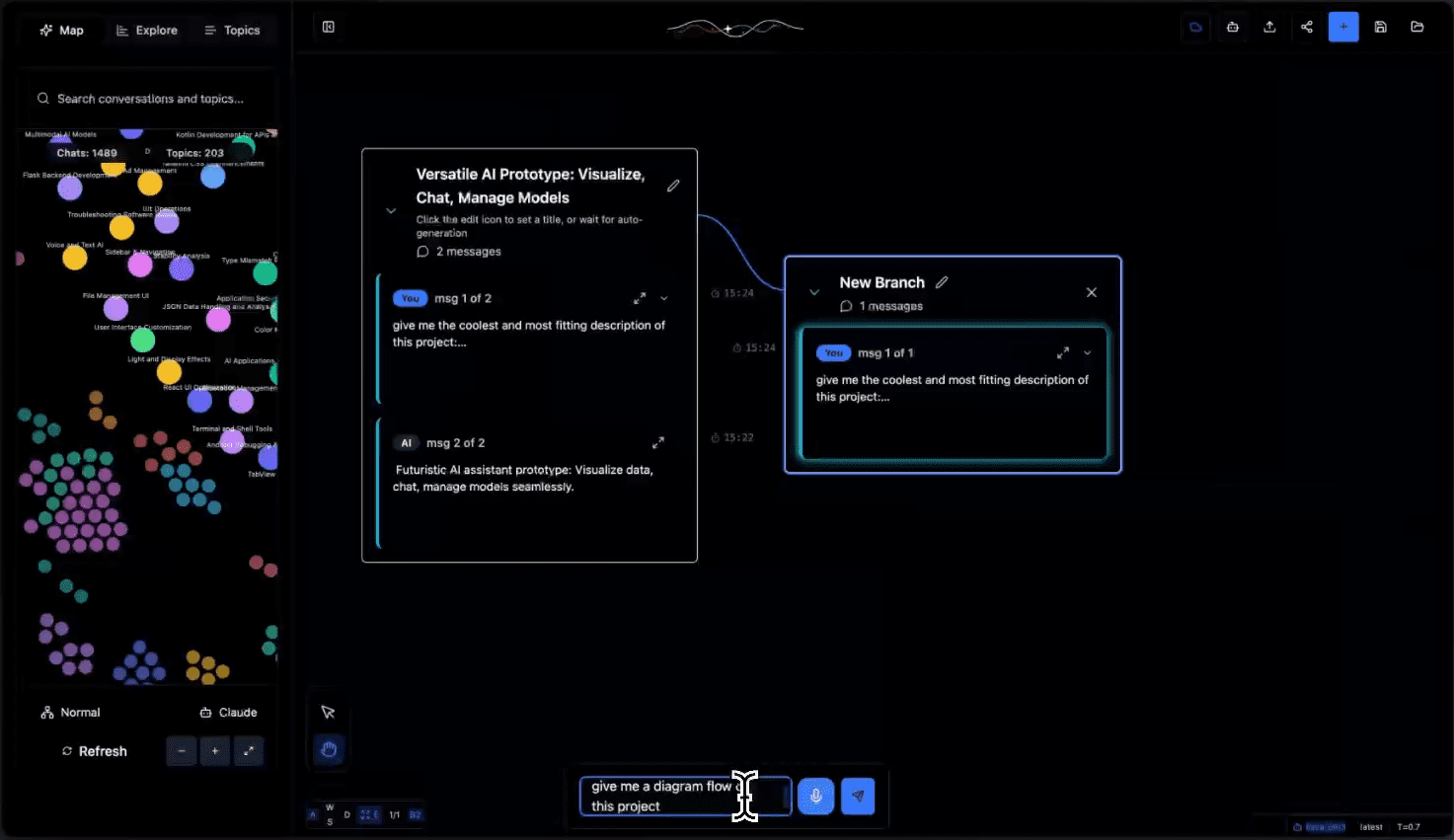

Tangent는 엑스칼리드로우의 시각적 상호작용과 ComfyUI의 유연성을 결합한 혁신적인 AI 대화 캔버스 도구로, LLM(대규모 언어 모델) 대화를 위한 새로운 탐색 환경을 만드는 데 중점을 두고 있습니다. 기존 채팅 인터페이스와 달리 Tangent는 AI 대화를 시각적 실험으로 전환하여 사용자가 다양한 대화 경로를 자유롭게 분기, 병합 및 비교할 수 있도록 합니다. 전적으로 로컬 모델에 의존하는 오프라인 우선 로컬 배포 모델을 지원하며, 현재 주로 Ollama를 통해 구현되어 있으며, 더 많은 백엔드를 지원하도록 확장할 계획입니다. 이 프로젝트는 Apache 2.0 라이선스에 따라 오픈 소스이며, 커뮤니티의 기여를 장려하고 AI 대화 탐색을 위한 새로운 실험적 플랫폼을 제공합니다.

기능 목록

- 대화 복구 및 지속: 컨텍스트 제약을 극복하고 이전 대화를 원활하게 복구합니다.

- 분기 탐색 시스템: 모든 대화 노드에 분기를 생성하여 여러 대화 방향을 테스트할 수 있습니다.

- 오프라인 로컬 배포: 전적으로 로컬 모델에서 실행되며 개인 데이터를 보호합니다.

- 동적 토픽 클러스터링: 대화 주제를 자동으로 추론하고 카테고리로 정리하여 탐색 환경을 최적화합니다.

- 내보내기 데이터 호환성: Claude 및 ChatGPT 데이터 내보내기 형식 지원

- 시각적 대화 트리: 대화 가지와 실험 프로세스를 트리 구조로 표시하기

- API 지원: 대화 데이터를 처리하고 관리하기 위해 전체 REST API를 사용할 수 있습니다.

- 실시간 상태 추적: 대화 처리 진행 상황 및 작업 상태 모니터링

도움말 사용

1. 환경 준비

1.1 필요한 종속성을 설치합니다:

- Whisper.cpp: 음성 처리용

git clone https://github.com/ggerganov/whisper.cpp cd whisper.cpp sh ./models/download-ggml-model.sh base.en make

- 올라마: 로컬 모델 런타임 환경

- https://ollama.com/ 방문하여 시스템에 적합한 버전을 다운로드하세요.

- 설치를 확인합니다:

ollama --version - 필요한 모델을 다운로드하세요:

ollama pull all-minilm ollama pull qwen2.5-coder:7b

1.2 올라마 서비스를 시작합니다:

ollama serve

2. 백엔드 설정

2.1 Python 환경을 초기화합니다:

cd tangent-api

source my_env/bin/activate

pip install -r requirements.txt

2.2 로컬 모델을 구성합니다:

cd src

python3 app.py --embedding-model "custom-embedding-model" --generation-model "custom-generation-model"

백엔드 서비스는 http://localhost:5001/api 에서 시작됩니다.

3. 프런트엔드 설정

cd simplified-ui

npm i

npm start

인터페이스를 사용하려면 http://localhost:3000 방문하세요.

4. 주요 기능의 사용 설명

4.1 대화 관리:

- 새 대화 만들기: 화면 오른쪽 상단에 있는 '+' 버튼을 클릭합니다.

- 브랜치 대화: 대화 노드를 마우스 오른쪽 버튼으로 클릭하고 "브랜치 만들기"를 선택합니다.

- 대화 병합: 서로 다른 브랜치에서 대상 노드로 대화 상자를 끌어다 놓아 병합할 수 있습니다.

4.2 주제 구성:

- 자동 클러스터링: 시스템이 대화 내용을 자동으로 분석하여 주제 태그를 생성합니다.

- 토픽 필터링: 왼쪽의 토픽 목록을 통해 관련 대화를 빠르게 찾을 수 있습니다.

- 수동 라벨링: 사용자 지정 주제 라벨 및 카테고리 지원

4.3 데이터 가져오기 및 내보내기:

- Claude 및 ChatGPT에서 대화 로그 가져오기 지원

- 대화 로그를 여러 형식으로 내보낼 수 있습니다.

- 처리 자동화를 위한 API 인터페이스 제공

5. API 사용 가이드라인

주요 엔드포인트:

- POST

/api/process업로드된 대화 데이터 처리 - GET

/api/process/status/<task_id>쿼리 처리 상태 - POST

/api/chats/save대화 데이터 저장 - GET

/api/chats/load/<chat_id>: 특정 대화 불러오기 - GET

/api/topics생성된 토픽 목록 보기

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...