초록

잘 설계된 힌트는 LLM(대규모 언어 모델)의 추론 기능을 향상시키는 동시에 다양한 도메인의 작업 요구 사항에 맞게 출력을 조정하는 데 필수적입니다. 하지만 힌트를 수동으로 디자인하려면 전문 지식과 반복적인 실험이 필요합니다. 기존의 힌트 최적화 방법은 이 과정을 자동화하는 것을 목표로 하지만 실제 답변이나 사람의 피드백과 같은 외부 참조에 크게 의존하기 때문에 이러한 데이터를 사용할 수 없거나 비용이 많이 드는 실제 시나리오에서는 적용이 제한됩니다. 이 문제를 해결하기 위해 외부 참조 없이도 폐쇄형 및 개방형 작업에 효과적인 프롬프트를 발견할 수 있는 효율적인 프레임워크인 자기 지도 프롬프트 최적화(SPO)를 제안합니다. 큐 품질이 LLM 출력에 직접 반영되고 LLM이 작업 요구사항 준수 정도를 효율적으로 평가할 수 있다는 점에 착안하여, 출력 비교만으로 평가 및 최적화 신호를 도출합니다. 구체적으로, SPO는 LLM 평가자가 평가한 쌍별 출력 비교를 통해 우수한 단서를 선택한 다음 LLM 최적화기를 통해 출력을 작업 요구사항에 맞게 조정합니다. 광범위한 실험을 통해 SPO는 기존 최첨단 큐 최적화 방법보다 훨씬 적은 비용(예: 기존 방법의 1.11 TP3T에서 5.61 TP3T)과 더 적은 샘플(예: 3개 샘플만 필요)을 사용하면서도 뛰어난 성능을 발휘하는 것으로 나타났습니다. 코드는 https://github.com/geekan/MetaGPT获取 에서 확인할 수 있습니다.

전체 데모 코드: https://github.com/geekan/MetaGPT/blob/main/examples/spo/README.md

1. 소개

LLM(대규모 언어 모델)이 계속 발전함에 따라, 이를 극대화하려면 잘 설계된 프롬프트가 필수적입니다.추론 능력 (Wei 외, 2022; Zheng 외, 2024; Deng 외, 2023) 및 다양화 의무 요건(Hong 외, 2024b; Liu 외, 2024a; Zhang 외, 2024b; Hong 외, 2024a)과의 일관성을 보장하는 것이 매우 중요해졌습니다. 중요. 그러나 효과적인 단서를 만들려면 일반적으로 광범위한 시행착오 실험과 작업별 심층 지식이 필요합니다.

이러한 문제를 해결하기 위해 연구자들은 프롬프트를 자동으로 개선하기 위해 LLM의 자체 기능을 사용하는 프롬프트 최적화(PO) 방법을 모색했습니다. PO는 기존의 수동 프롬프트 엔지니어링을 넘어 보다 체계적이고 효율적인 프롬프트 디자인 접근 방식을 제공합니다. 그림 1(a)에서 볼 수 있듯이 이러한 방법에는 일반적으로 프롬프트 최적화, 실행 및 평가의 반복적인 프로세스가 포함됩니다. 이러한 구성 요소의 설계 선택은 최적화의 효과와 효율성에 큰 영향을 미칩니다. 기존의 방법들은 수치적 평가 메커니즘(Wang et al., 2024e; Yang et al., 2024a; Fernando et al., 2024)과 텍스트 "그라데이션" 최적화 전략(Wang et al., 2024c; Yuksekgonul et al., 2024)으로 개발되어 왔으며 수치적 평가 메커니즘 측면에서 개발되었습니다(Wang et al., 2024e; Yang et al., 2024a; Fernando et al.) 외., 2024). 이러한 혁신을 통해 PO 방법은 수작업을 줄이면서 작업 성과를 개선했습니다(Pryzant 외., 2023; Zhang 외., 2024a; Zhou 외., 2024).

잠재력에도 불구하고 기존 PO 방법은 아래에 설명된 바와 같이 실제 시나리오에서 상당한 어려움에 직면해 있습니다. 첫째, 현재의 접근 방식법은 일반적으로 평가를 위해 외부 참조에 크게 의존합니다.. 평가를 위해 정답을 사용하는 방법(양 외, 2024a; Fernando 외, 2024; 육세고눌 외, 2024; 프리잔트 외, 2023)은 단서 품질을 평가하기 위해 많은 양의 주석이 달린 데이터가 필요하지만 많은 실제 응용 분야, 특히 개방형 과제에서는 이러한 표준 답변을 사용할 수 없는 경우가 많습니다. 마찬가지로 수동 의존적 방법(Chen et al., 2024; Lin et al., 2024)은 피드백을 생성하기 위해 수동 평가 또는 수동으로 설계된 규칙이 필요하므로 시간이 많이 걸리고 자동화의 목표와 모순되는 측면이 있습니다. 둘째, 기존 방법은 일반적으로 신뢰할 수 있는 피드백을 얻기 위해 많은 수의 샘플을 평가해야 하므로 상당한 계산 오버헤드를 초래합니다(Wang et al., 2024e; Fernando et al., 2024).

이러한 문제의 핵심에는 큐 품질을 평가하기 위한 신뢰할 수 있고 효율적이며 참조가 필요 없는 방법이 부족하다는 점이 있습니다. LLM 동작을 분석한 결과, 우리의 접근 방식을 알려주는 두 가지 핵심 인사이트가 드러났습니다. 첫째, 단계적 추론 경로가 연쇄적 사고 단서의 성공을 입증하는 방법에서 알 수 있듯이 단서 품질은 본질적으로 모델 출력에 반영됩니다(Wei 외., 2022; Deng 외., 2023). 둘째, 판사로서의 LLM에 대한 광범위한 연구에 따르면 LLM은 산출물이 과제 요건을 어느 정도 따르는지를 평가하는 데 효과적입니다(Zheng et al., 2023; Li et al., 2024b). 이러한 관찰은 LLM을 사용하여 큐 품질을 자연스럽게 반영하는 출력의 고유한 능력을 평가함으로써 참조 없이 큐 최적화가 가능하다는 것을 시사합니다.

이러한 인사이트에서 영감을 얻어, 자기 지도 학습이 데이터에서 학습 신호를 도출하는 방식과 유사하게 LLM 결과물에서만 평가 및 최적화 신호를 생성하는 효율적인 프레임워크를 제안합니다. 우리는 이 접근 방식을 자기 지도형 프롬프트 최적화(SPO)라고 부릅니다. 그림 1에서 볼 수 있듯이 SPO는 기본적인 최적화-실행-평가 사이클을 기반으로 몇 가지 혁신적인 메커니즘을 도입합니다:

- 쌍별 평가를 위한 참조로 출력SPO의 핵심은 서로 다른 단서에서 나온 결과물의 상대적 품질을 평가하기 위해 쌍별 비교를 사용하는 것입니다. 이 평가 메커니즘은 외부 참조 없이도 작업 요구 사항을 이해하고 최적화의 효과를 검증하는 LLM의 고유한 기능을 활용합니다.

- 최적화 가이드로서의 출력SPO는 현재 최상의 출력에 대한 더 나은 솔루션에 대한 LLM의 이해를 통해 단서를 최적화합니다. 이 프로세스는 명시적인 최적화 신호에 의존하지 않고 모델의 최상의 작업 솔루션에 대한 이해에 따라 큐 수정을 자연스럽게 조정합니다.

헌신. 주요 기여 사항은 다음과 같습니다:

- 자체 감독 큐 최적화 프레임워크. LLM 출력의 쌍별 비교를 사용하여 외부 참조 없이 큐 최적화를 안내하는 새로운 프레임워크인 SPO를 소개합니다.

- 비용 효율성 최적화SPO는 최소한의 계산 오버헤드(데이터 세트당 $0.15)와 샘플 요구 사항(샘플 3개)으로 프롬프트를 최적화하여 리소스 요구 사항을 크게 줄입니다.

- 광범위한 평가. 그림 2에서 볼 수 있듯이 SPO는 폐쇄형 및 개방형 작업 모두에서 우수한 성능을 유지하면서 기존 방법의 1.11 TP3T ~ 5.61 TP3T 비용만 필요합니다.

2. 예비

2.1 문제의 정의

프롬프트 최적화는 주어진 작업에 대한 프롬프트의 유효성을 자동으로 향상시키는 것을 목표로 합니다. 공식적으로 T = (Q, Gt)는 Q는 입력 문제를 나타내고 Gt 는 선택적 벤치마크 팩트입니다. 목표는 작업별 프롬프트 Pt* 를 사용하여 작업 T 의 성능을 극대화합니다. 이 최적화 목표는 공식적으로 다음과 같이 표현할 수 있습니다:

Pt = 인자 최대Pt∈P* ET∼D[ϕ평가(ϕexe(Q, Pt))], (1)

여기서 P는 가능한 모든 프롬프트의 공간을 나타냅니다. 그림 1에서 볼 수 있듯이 이 최적화 프로세스에는 일반적으로 세 가지 기본 함수가 포함됩니다. (1) 최적화 함수(ϕopt): 후보 프롬프트를 기반으로 수정된 프롬프트를 생성하고, (2) 실행 함수(ϕexe): 수정된 힌트는 LLM과 함께 추론 경로와 최종 답을 포함한 출력 O를 생성하는 데 사용되며, (3) 평가 함수(ϕ평가): O의 품질을 평가하고 피드백 F를 제공하여 추가 최적화를 유도하고 후보 큐를 반복적으로 개선합니다.

이러한 기능 중 평가 기능은 출력(피드백 F)이 큐의 평가와 개선을 안내하기 때문에 핵심적인 역할을 합니다. 2.2절에서 큐 최적화를 위한 평가 프레임워크에 대해 설명합니다.

2.2 큐 최적화의 평가 프레임워크

이 섹션에서는 그림 3과 같이 평가의 출처, 평가 방법, 피드백 유형이라는 세 가지 주요 구성 요소를 다루는 신속한 최적화 평가 프레임워크에 대한 개요를 제공합니다. 마지막으로, SPO를 위한 평가 프레임워크를 소개합니다.

소스 평가. 그림 3(a)에서 볼 수 있듯이 두 가지 주요 평가 소스를 사용할 수 있습니다: LLM에서 생성된 출력과 과제별 정답입니다. 이러한 소스는 즉각적인 성과를 평가하기 위한 기초를 제공합니다.

평가 방법론. 평가 방법은 평가의 출처와 관련 비용을 평가하는 방법을 정의합니다. 일반적으로 사용되는 세 가지 방법은 다음과 같습니다. (1) 벤치마킹은 사전 정의된 메트릭(Suzgun 외, 2023; Rein 외, 2023) 또는 규칙(Chen 외, 2024)에 의존합니다. (2) 작업 요구사항에 따라 산출물을 이해하고 평가하는 LLM의 능력을 활용하는 판단자로서의 LLM(Zheng et al., 2023). (3) 수동 피드백(Lin et al., 2024)은 산출물을 직접 수동으로 평가하여 가장 포괄적인 평가를 제공합니다.

수동 피드백은 사람의 선호도와 업무별 요구 사항을 파악하여 가장 철저한 평가를 제공하지만, 벤치마킹이나 LLM-as-a-judge 접근 방식보다 비용이 더 많이 들기 때문에 평가 품질과 실현 가능성 간에 상충되는 부분이 있습니다.

피드백 유형. 평가 방법에서 생성되는 피드백은 일반적으로 세 가지 형태를 취합니다.(1) 수치 피드백은 전체 데이터 세트에 걸쳐 정량적 성능 지표를 제공합니다. 그러나 평가의 안정성을 보장하기 위해 많은 수의 샘플이 필요하며 인스턴스별 세부 사항을 무시할 수 있습니다(Zhang et al., 2024a). (2) 텍스트 피드백은 최적화 신호를 직접 생성하는 제안을 분석하고 제공함으로써 풍부한 인스턴스별 지침을 제공합니다(육세곤울 외, 2024). (3) 랭킹 또는 선택 피드백(Liu et al., 2024b)은 전체 랭킹 또는 쌍별 비교를 통해 출력 간의 상대적 품질 순위를 설정하여 절대적인 품질 지표 없이도 명시적인 최적화 방향을 제공합니다.

평가 프레임워크. 앞서 설명한 피드백의 출처, 방법 및 유형을 기반으로 평가 프레임워크는 단서 최적화의 맥락에서 소스를 비교하고 평가하는 방법을 결정합니다. 구체적으로, 큐 최적화를 위한 피드백 F를 생성하기 위한 두 가지 평가 프레임워크를 도출합니다:

(1) 출력 대 정답(OvG): 출력 O와 정답 G를 결합하여 다음과 같이 계산합니다.T 비교를 통해 피드백을 생성하세요:

fOvG(Oi, Gi) = φ평가(φexe(Qi, Tpi), G**i**)

이 접근 방식은 외부 참조를 통해 직접적인 품질 평가가 가능하지만, 정답을 명확하게 정의해야 하므로 정답이 없거나 정답을 정의하는 것이 비현실적인 개방형 과제에는 적합하지 않습니다.

(2) 출력 대 출력(OvO): 정답이 없는 경우 직접 출력 비교를 사용하는데, OvO의 핵심 아이디어는 완벽한 정답이 없는 경우에도 다양한 힌트에서 생성된 출력을 비교하면 상대적인 품질에 대한 유용한 신호를 제공할 수 있다는 것입니다. 이 접근 방식은 외부 참조에 의존할 필요가 없으며, 특히 정답이 여러 개 있는 개방형 과제에 유용합니다. 공식적으로 다음과 같이 표현할 수 있습니다:

fOvO(O1, ... , Ok) = φ평가({φexe(Qi, Pti)}ki=1)

OvG와 OvO 평가 프레임워크를 소개하면서 OvO가 자체 감독형 프롬프트 최적화(SPO)의 핵심 방법이라는 점을 강조했습니다. OvO는 다양한 단서에서 생성된 결과물을 비교함으로써 외부 참조에 의존하지 않고도 상대적인 품질에 대한 귀중한 피드백을 제공합니다. 이 접근 방식은 출력 자체에서 피드백을 생성하여 폐쇄형 및 개방형 작업 모두에 대한 반복적인 최적화를 촉진한다는 목표와 일치합니다.

3. 자가 모니터링 팁 최적화

이 섹션에서는 먼저 접근 방식을 간략히 설명하고(섹션 3.1) 그 효과를 분석합니다(섹션 3.2).

3.1 SPO 개요

참조 없는 큐 최적화의 핵심 과제는 효과적인 평가 및 최적화 신호를 구성하는 방법입니다. 유니티는 기본 최적화-실행-평가 사이클을 유지하면서 모델 출력만을 평가 및 최적화 지침의 소스로 활용하는, 간단하면서도 효과적인 참조 없는 최적화를 위한 프레임워크인 자기 감독형 프롬프트 최적화(SPO)를 제안합니다.

알고리즘 1에서 볼 수 있듯이 SPO는 세 가지 주요 구성 요소를 통해 작동하며, 해당 힌트는 부록 A.1에 나와 있습니다:

- 최적화 기능 (φopt): 현재 가장 적합한 프롬프트와 해당 출력을 분석하여 새 프롬프트를 생성합니다.

- 실행 기능 (φexe): 생성된 프롬프트를 적용하여 출력을 얻습니다.

- 평가 기능 (φ평가): LLM을 사용하여 출력을 비교하고 쌍별 비교를 통해 더 나은 단서를 결정합니다.

이 반복 프로세스는 기본 프롬프트 템플릿(예: 연쇄 사고(Wei et al., 2022))과 데이터 세트에서 샘플링한 작은 질문 세트로 시작합니다. 각 반복에서 SPO는 새로운 프롬프트를 생성하고, 이를 실행하고, 결과를 쌍으로 평가하여 작업 요구 사항을 얼마나 잘 따르는지 평가합니다.

이 큐를 더 나은 출력과 연관시키는 것이 다음 반복을 위한 최적의 후보로 선택됩니다. 이 프로세스는 미리 정해진 최대 반복 횟수에 도달할 때까지 계속됩니다.

3.2 SPO의 효과에 대한 이해

SPO의 이론적 토대는 두 가지 핵심 관찰에 기반을 두고 있습니다:

첫째, 단계적 추론 경로가 연쇄적 사고 단서의 성공을 입증하는 방법에서 알 수 있듯이 LLM의 출력은 단서의 유효성을 직접적으로 반영하는 질적 정보가 풍부합니다(Wei et al., 2022). 둘째, LLM은 인간과 유사한 작업 이해력을 보여줌으로써 답변 품질을 평가하고 작업 요구사항에 따라 우수한 솔루션을 식별할 수 있습니다. 이러한 상호 보완적인 기능을 통해 SPO는 외부 참조 없이도 단서 평가 및 최적화를 수행할 수 있습니다. 모델 출력을 활용하는 이 두 가지 측면이 함께 작동하여 효과적인 즉각적인 최적화를 달성합니다:

출력을 최적화 가이드로 사용할 수 있습니다. φ의 경우opt 설계 측면에서 신호의 명시적 최적화를 도입하는 다른 방법(Fernando 외, 2024; Yuksekgonul 외, 2024; Pryzant 외, 2023)과 달리, φopt 최적화는 단서와 해당 출력에 직접적으로 기반합니다. 최적화 신호는 출력의 품질을 평가하는 LLM의 고유한 능력에서 비롯되며, 최적화 동작은 무엇이 더 나은 솔루션을 구성하는지에 대한 이해에 따라 안내됩니다. 따라서 명시적인 최적화 신호가 없는 경우에도 SPO의 최적화는 본질적으로 작업에 대한 LLM의 최적 이해에 대한 단서를 제공합니다.

출력을 쌍별 평가를 위한 참조로 사용합니다. φ 정보평가 설계에서는 평가 모델이 쌍별 선택을 수행하도록 허용함으로써 평가 모델 고유의 과제에 대한 선호도 이해를 효과적으로 활용합니다. 이 내부 신호는 출력의 간단한 쌍별 비교를 통해 얻을 수 있으므로 채점 피드백 방식에 종종 필요한 채점 안정성을 보장하기 위해 많은 수의 샘플을 사용할 필요가 없습니다.

네 차례의 무작위 평가를 통해 잠재적인 편향성을 완화하지만 이러한 편향성을 완전히 제거할 수는 없습니다(Zhou et al., 2024). 그러나 평가의 피드백은 다음 최적화 라운드의 참고 자료로만 사용되기 때문에 이러한 편향은 전체 최적화 추세에 영향을 미치지 않습니다. 전체 최적화 프로세스는 최적화 모델의 작업 이해와 자연스럽게 연계되며, 평가 메커니즘은 각 반복의 효과를 검증하는 데만 사용됩니다.

4. 실험

4.1 실험 설정

데이터 집합. SPO의 효과를 충분히 평가하기 위해 비공개 작업과 공개 작업을 포함한 다양한 작업 세트에 대해 평가했습니다.

비공개 작업에는 5개의 기존 벤치마크를 사용했습니다:

- GPQA(Rein et al., 2023)

- AGIEval-MATH(Zhong et al., 2024)

- LIAR (왕, 2017)

- WSC(레베스크 외, 2012)

- BBH-navigate(Suzgun et al., 2023)

WSC, LIAR 및 BBH-Navigate의 경우, Yan 등(2024)과 원본 데이터 세트의 샘플 일부를 테스트 세트로 사용합니다. GPQA의 경우, 보다 난이도가 높은 GPQA-Diamond 하위 집합을 테스트 세트로 사용했으며, AGIEval-Math의 경우 레벨 5 문제를 테스트 세트로 사용했습니다. 개방형 과제의 경우 MT-Bench에서 글쓰기, 역할극, 인문학 과제를 선택했습니다(Zheng et al., 2023). 데이터 세트의 크기가 제한되어 있기 때문에 이러한 과제에 대해 세 가지 검증 세트를 수동으로 구성했습니다. 데이터 세트에 대한 자세한 설명과 검증 및 테스트 세트의 구축 절차는 부록 A.3에서 확인할 수 있습니다.

기준선(측지 측량에서). 우리는 (1) io(직접 LLM 호출), 체인씽크(Wei 외, 2022), 리워딩(Deng 외, 2023), 폴백 추상화(Zheng 외, 2024) 등 전통적인 프롬프트 방법과 (2) APE (...)를 포함한 자동 프롬프트 최적화 방법의 두 가지 클래스에 대해 폐쇄형 작업에서 SPO를 평가했습니다. Zhou 외, 2023), OPRO(Yang 외, 2024a), PromptAgent(Wang 외, 2024e), PromptBreeder(Fernando 외, 2024), TextGrad(Yuksekgonul 외, 2024)와 같은 알고리즘 세트에 기반하여 평가하는 APE(Deng 외, 2023) 및 폴백 추상화(Zheng 외, 2024); (2) APE를 포함한 자동 프롬프트 최적화 방법( 2024), 평가 프레임워크 설정은 표 2에 자세히 나와 있습니다.

MT-Bench의 개방형 과제(Zheng et al., 2023)에서는 GPT-4o를 사용하여 SPO에서 생성한 결과와 모델에서 직접 생성한 결과를 비교했습니다.

4.2 실험 결과 및 분석

비공개 위임의 주요 결과. 표 1에서 볼 수 있듯이, SPO 최적화 프롬프트는 평균적으로 모든 기존 프롬프트 방법보다 성능이 뛰어나며 최적 기준선을 1.9배 초과합니다. 동시에 대부분의 데이터 세트에서 진실한 답변에 의존하는 프롬프트 최적화 방법과 비슷한 성능을 보이며 GPQA 및 BBH-navigate 데이터 세트에서 최적의 결과를 달성합니다. 특히, 다른 최적화 방법에 비해 SPO의 평균 성능 우위는 쌍별 평가 방법이 외부 참조에 의존하는 다른 방법보다 더 효율적인 최적화 신호를 생성할 수 있다는 것을 시사합니다. 또한, 다양한 최적화 모델에 대한 방법의 효율성을 검증하기 위해 GPT-4o를 최적화 모델로 사용하여 실험을 수행한 결과 평균 66.3의 성능을 달성했습니다. 이는 Claude-3-5-Sonnet을 최적화 모델로 사용하여 얻은 결과보다 약간 낮지만, 비교한 모든 방법 중 세 번째로 좋은 성능입니다.

비용 분석. 표 1에서 다른 최적화 방법과 SPO(최적화 모델로 Claude-3.5-Sonnet 및 GPT-4o 사용)의 최적화 비용 및 성능을 종합적으로 비교하고 있습니다. 실제 답변에 의존하는 다른 힌트 최적화 방법과 비슷한 성능을 유지하면서도 SPO는 1.11 TP3T에서 5.61 TP3T의 최적화 비용만 필요하며, 데이터 세트당 평균 최적화 비용은 다음과 같습니다. $0.15. 이처럼 계산 오버헤드가 크게 감소하고 실제 답변에 의존하지 않기 때문에 SPO는 실제 애플리케이션에 매우 매력적입니다.

표 3. 다양한 평가 모델(행)과 실행 모델(열)을 사용한 BBH-navigate의 성능 비교: 큐잉 방법(IO 및 COT)과 SPO. 최적화 모델은 Claude-3.5-Sonnet으로 설정되었습니다.

| GPT-4o-mini | Llama3-70B | 클로드-3-하이쿠 | |

| IO | 91.3 | 82.7 | 62.2 |

| COT | 89.7 | 86.2 | 68 |

| 클로드-3.5-소네트 | 95 | 86.8 | 68.2 |

| Llama3-70B | 94.5 | 94.2 | 82.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

절제 연구. 다양한 최적화, 평가 및 실행 모델에 걸쳐 SPO의 이전 가능성을 평가하기 위해 BBH-Navigate 데이터 세트에서 제거 실험을 수행했습니다. 표 3과 4의 실험 결과는 SPO가 여러 모델에서 강력한 성능을 발휘한다는 것을 보여줍니다. 특히, 최적화, 실행 및 평가 모델로 GPT-4o-mini를 사용했을 때 최고의 성능(97.8)을 달성했습니다. 실행 측면에서 SPO는 약한 모델의 성능을 62.2에서 89.7로 향상시킴으로써 약한 모델의 성능을 효과적으로 개선했으며, 이는 약한 모델에 대한 SPO의 적용 능력을 입증하고 실제 적용 가능성을 더욱 확대했습니다.

표 4. 다양한 최적화 모델(행)과 실행 모델(열)에서 BBH-navigate의 성능 비교. 평가 모델은 GPT-4o-mini로 설정되었습니다.

| GPT-4o-mini | Llama3-70B | 클로드-3-하이쿠 | |

| 클로드-3.5-소네트 | 97.2 | 86.7 | 89.7 |

| GPT-40 | 96.3 | 85.5 | 73.0 |

| GPT-4o-mini | 97.8 | 90.7 | 82.0 |

| DeepSeek-V3 | 94.7 | 83.7 | 77.2 |

그림 5와 같이 BBH-Navigate 데이터 세트를 사용하여 샘플 크기가 SPO 성능에 미치는 영향을 조사하기 위해 제거 연구를 수행했습니다. 세 가지 최적화 모델의 성능 곡선은 모두 비슷한 패턴을 보였는데, 처음에는 샘플 크기가 증가함에 따라 성능이 향상되지만 결국에는 정체되거나 감소하는 것으로 나타났습니다. 이러한 현상은 두 가지 요인에 기인합니다. 샘플이 충분하지 않으면 큐 최적화에서 과적합이 발생할 수 있고, 샘플이 너무 많으면 계산 비용이 증가할 뿐만 아니라 모델을 평가하는 데 더 긴 컨텍스트가 필요해져 평가의 품질이 떨어질 수 있습니다. 광범위한 실험을 통해 3의 샘플 크기가 비용 효율성과 성능 간의 균형을 가장 잘 맞추는 것으로 확인했습니다.

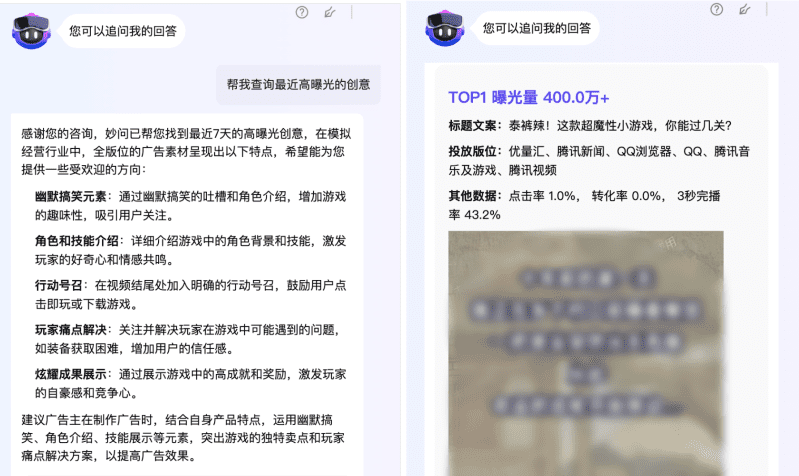

개방형 위임의 주요 결과개방형 과제에서 SPO의 능력을 검증하기 위해 MT-Bench에서 세 가지 카테고리를 선정하여 평가했습니다. 개방형 과제에서 SPO의 능력을 검증하기 위해 MT-Bench에서 "글쓰기", "역할극", "인문학" 등 세 가지 카테고리를 선택하여 평가했습니다. ". 최적화 모델로는 Claude-3.5-Sonnet을, 평가 모델로는 Gpt-4o-mini를 사용했으며, 실행 모델로는 Claude-3.5-Sonnet, DeepSeek-V3, GPT-4omini를 선택하여 5번의 반복을 거쳤습니다. 이후 (Zheng et al., 2023)의 평가 방법에 따라 GPT-4o를 사용하여 그림 6과 같이 모델 A와 모델 B의 출력을 쌍으로 비교했습니다. 그림 6에 표시된 실험 결과는 SPO가 모든 모델 구성에서 모델 성능을 크게 향상시키는 것으로 나타났습니다. 최적화 단서를 사용하는 작은 모델(예: GPT-4omini)이 대부분의 경우 큰 모델보다 성능이 더 뛰어나다는 점에 주목할 필요가 있습니다.

4.3 사례 연구

데이터 세트가 없는 추가 개방형 과제에 대한 최적화 결과와 SPO의 최적화 궤적은 부록 A.4에 나와 있습니다. 또한 부록 자료에서 5개의 폐쇄형 과제에 대해 SPO가 찾은 최적의 힌트를 제공합니다. 실제 애플리케이션은 종종 데이터 세트가 제한적이라는 문제에 직면한다는 점을 감안하여 기존 벤치마크 없이 작업에 대한 SPO의 성능을 평가했습니다. 실험 결과와 SPO의 비용 효율성을 결합하여 실제 시나리오에서 실질적인 가치를 입증합니다. 구체적으로 광고 디자인, 소셜 미디어 콘텐츠, 현대시 쓰기, 개념 설명의 네 가지 작업에 대해 최적화 모델로는 Claude-3.5-Sonnet, 평가 모델로는 GPT-4o-mini, 실행 모델로는 Llama3-8B를 사용하여 10회 반복한 최적화 결과를 보여줍니다. 또한 부록 A.4.1의 BBH-navigate 데이터 세트에 대한 SPO의 최적화 궤적을 종합적으로 분석하여 성공 사례와 실패 사례를 모두 보여줌으로써 최적화 프로세스에 대한 심층적인 인사이트를 제공합니다.

5. 관련 작업

5.1 큐 엔지니어링

효과적인 프롬프트 방법에 대한 연구는 크게 두 가지 방향으로 진행되어 왔습니다. 첫 번째 방향은 LLM의 일반화 가능성을 높이는 과제 독립적 프롬프트 기법에 초점을 맞추고 있습니다. 주목할 만한 예로는 다양한 작업에서 추론을 향상시키는 연쇄적 사고(Wei 등, 2022; Kojima 등, 2022), 단발성 추론을 향상시키는 기법(Deng 등, 2023; Zheng 등, 2024; Wang 등, 2024d), 출력 형식 사양을 위한 방법(장 등, 2024a) 등이 있습니다. 방법(장 외, 2024a; He 외, 2024; 탐 외, 2024). 이러한 기법들은 인간의 통찰력과 광범위한 실험 개발을 통해 오토큐 최적화 연구에 중요한 최적화 씨앗을 제공합니다.

두 번째 방향은 도메인별 단서를 다루며, 연구자들은 코드 생성(홍 외, 2024b; 리드닉 외, 2024; 쉔 외, 2024a), 데이터 분석(홍 외, 2024a; 리우 외, 2024a; 리 외, 2024a), 질문( 우 외, 2024b; 주 외, 2024; 양 외, 2024b), 의사결정(장 외, 2024b; 왕 외, 2024a) 및 기타 분야(구오 외, 2024b; 예 외, 2024; 셴 외, 2024b). ) 전문화된 기술을 개발했습니다. 그러나 LLM의 적용 범위가 점점 더 복잡한 실제 시나리오로 확장됨에 따라 각 도메인에 효과적인 단서를 수동으로 생성하는 것은 비현실적이 되었습니다(Zhang et al., 2024a). 이러한 도전은 일반적인 큐잉 원리를 발견하기보다는 효과적인 도메인별 큐를 체계적으로 개발하는 것을 목표로 하는 큐 최적화 연구에 동기를 부여했습니다.

5.2 큐 최적화

신속 최적화(PO)에서 평가 프레임워크의 설계는 최적화의 효과와 계산 효율성을 결정하기 때문에 매우 중요하며, PO의 평가 메커니즘은 단순한 평가 피드백 수집에서 복잡한 최적화 신호 생성으로 진화해 왔습니다(Chang et al., 2024). 기존의 PO 방법은 평가 소스와 메커니즘에 따라 분류할 수 있습니다.

가장 일반적인 접근 방식은 벤치마크에 기반한 수치 평가를 활용하여 진솔한 답변을 평가의 원천으로 삼는 것입니다(Zhou 외, 2023; Guo 외, 2024a; Yang 외, 2024a; Fernando 외, 2024; Wang 외, 2024e; Khattab 외, 2023). ). 이러한 방법은 특정 작업에서는 성공적이지만, 일반적으로 평가 안정성을 보장하기 위해 많은 수의 반복과 샘플이 필요하므로 상당한 계산 오버헤드를 초래합니다.

샘플 요구 사항을 줄이기 위해 일부 방법(Yan et al., 2024; Yuksekgonul et al., 2024; Wu et al., 2024a; Wang et al., 2024c; Pryzant et al., 2023; Li et al., 2025)에서는 LLM을 판정자로 사용하여 상세한 텍스트 피드백을 생성합니다(Zheng et al. ..., 2023)를 심사위원으로 사용하여 상세한 텍스트 피드백을 생성합니다. 이 접근 방식은 더 풍부한 평가 신호를 제공하고 더 적은 샘플을 필요로 하지만, 여전히 실제 답안 데이터에 의존하기 때문에 참조 답이 존재하지 않을 수 있는 개방형 과제에는 적용이 제한됩니다.

다른 접근 방식은 수동으로 설계된 평가 규칙이나 사람의 직접적인 피드백을 통해 사람의 선호도에 초점을 맞추는 것입니다(Chen et al., 2024; Lin et al., 2024). 이러한 접근 방식은 개방형 작업에는 효과적일 수 있지만, 광범위한 인간 개입이 필요하다는 점에서 자동화의 목표와 모순됩니다. 한편, 일부 연구자들은 출력 일관성을 통해 단서의 유효성을 평가하는 Zhang 등(2024c)의 제안과 같은 다양한 평가 기준을 탐색했습니다. 그러나 이 접근 방식은 일관성과 유효성 간의 비선형적 관계로 인해 일반적으로 평가 신호가 좋지 않다는 근본적인 문제에 직면해 있습니다.

이러한 방법과 달리 SPO는 효율성을 유지하면서 외부 참조에 의존하지 않는 새로운 평가 패러다임을 도입합니다. SPO는 쌍별 비교를 통해서만 모델 결과를 활용하기 때문에 실제 답변, 사람의 피드백 또는 광범위한 샘플링 없이도 강력한 평가가 가능하므로 특히 현실적인 애플리케이션에 적합합니다.

6. 결론

이 백서에서는 큐 최적화의 근본적인 문제, 즉 현실적인 적용을 제한하는 외부 레퍼런스에 대한 의존성을 다룹니다. 이 종속성을 극복하는 동시에 각 데이터 세트에 대한 참조만 있는 프레임워크를 구현하는 자체 감독형 프롬프트 최적화(SPO)를 소개합니다. $0.15 SPO는 자기 지도 학습에서 영감을 얻어 모델 출력의 쌍별 비교를 통해 평가 및 최적화 신호를 혁신적으로 구성하여 효율성을 저하시키지 않고 참조 없는 최적화를 가능하게 합니다.

종합적인 평가 결과, SPO는 폐쇄형 및 개방형 작업 모두에서 기존의 최신 방법보다 우수한 성능을 보였으며, 기존 방법의 1.11 TP3T ~ 5.61 TP3T에 불과한 비용으로 최신 결과를 달성한 것으로 나타났습니다. 표준 벤치마크와 다양한 실제 애플리케이션에서의 성공은 SPO의 효과와 일반화 능력을 입증합니다. 리소스 요구 사항과 운영 복잡성을 크게 줄임으로써 SPO는 큐잉 최적화를 실제 애플리케이션에서 접근 가능하고 실용적으로 만드는 데 중요한 진전을 이루었으며, 다양한 도메인에서 LLM 기술 채택을 가속화할 수 있는 잠재력을 가지고 있습니다.

영향 성명서

SPO는 다양한 작업에서 접근의 민주화, 비용 절감, 성능 향상 등의 이점을 제공하면서 LLM을 위한 단서 엔지니어링에 상당한 진전을 가져왔습니다. 하지만 편견 증폭 가능성, 유해한 콘텐츠 생성 사용, LLM에 대한 과도한 의존 등의 위험도 있습니다.

A. 부록

A.1 SPO를 위한 자세한 팁

이 섹션에서는 반복에 대한 메타 힌트를 보여드립니다. 여기에서는 가장 간단하고 직관적인 힌트만 사용했습니다. 특정 도메인에 맞게 다음 메타 힌트를 최적화하여 개선할 여지가 아직 남아 있습니다.

기능 최적화를 위한 팁

이 프롬프트 템플릿은 LLM이 구조화된 XML 분석을 통해 기존 프롬프트를 반복적으로 개선하도록 안내합니다. 이를 위해서는 참조 프롬프트 출력의 약점을 파악하고, 변경 사항을 제안하며, 최적화된 버전을 생성해야 합니다. 이 템플릿은 요구 사항의 일관성을 유지하면서 점진적인 개선을 강조합니다.

기능 평가를 위한 팁

평가 템플릿은 비교 분석을 사용하여 응답의 품질을 평가합니다. 두 개의 응답(A/B)의 강점과 약점에 대한 XML 형식의 합리적인 분석을 수행한 다음 명확한 선택을 해야 합니다.

A.2. 반복 시작을 위한 상세 프롬프트 템플릿

이 YAML 파일은 BBH 탐색 작업을 반복하기 위한 초기 구성을 보여줍니다. 간단한 초기 프롬프트 및 요구 사항과 함께 세 가지 특정 질문을 구성하여 반복 최적화를 수행할 수 있습니다. 여기에 표시된 내용은 파일의 전체 내용이며, 답변 섹션의 내용은 실제 답변이 아니라 사고 과정과 올바른 출력 형식에 대한 참조용이라는 점에 유의하세요.

A.3 실험의 세부 사항

A.3.1 작업 및 데이터 세부 정보

LIAR

LIAR(Wang, 2017)는 각각 문맥 정보와 거짓말 레이블이 포함된 4000개의 문장이 포함된 영어 가짜 뉴스 탐지 데이터 세트입니다. 실험에서는 Yan 등(2024)의 방법을 따르고 원본 데이터 세트의 일부를 샘플로 테스트 세트로 사용합니다.

BBH-Navigate

BBH-Navigate(Suzgun et al., 2023)는 빅 벤치 데이터 세트의 하위 집합인 빅 벤치 하드 데이터 세트의 과제입니다. 이 작업은 탐색 추론에 초점을 맞추고 있으며, 에이전트가 일련의 탐색 단계를 수행한 후 시작점으로 돌아갈지 여부를 판단하는 모델에 요구됩니다. 실험에서는 무작위 샘플링(시드 = 42)을 사용하여 200/25/25 테스트/훈련/검증 스플릿을 얻었습니다.

표 A1. 데이터 세트 크기 및 데이터 파티셔닝

| 데이터 집합 이름 | 테스트(기계 등) | 교육 및 검증 |

|---|---|---|

| LIAR | 461 | 3681 |

| BBH-Navigate | 200 | 50 |

| WSC | 150 | 50 |

| AGIEval-MATH | 256 | 232 |

| GPQA | 198 | 250 |

| MT-벤치 | 80 | 0 |

WSC

Winograd 스키마 챌린지(WSC)는 문맥에서 대명사 참조를 파싱하여 상식적인 추론을 수행하는 시스템의 능력을 평가하기 위해 고안된 벤치마크입니다(Levesque et al., 2012). 실험에서는 Yan 등(2024)과 원본 데이터 세트의 샘플 일부를 테스트 세트로 사용합니다.

AGIEval-MATH

AGIEval-MATH(Zhong et al., 2024)는 수학적 문제 해결 과제에 초점을 맞춘 AGIEval 벤치마크의 하위 집합입니다. 여기에는 추론 및 계산 능력을 평가하기 위해 고안된 다양한 수학 문제가 포함되어 있습니다. 실험에서는 레벨 5 문제를 테스트 세트로, 레벨 4 문제를 훈련 및 검증 세트로 사용합니다.

GPQA

GPQA(Rein et al., 2023)는 생물학, 물리학, 화학 등 다양한 분야의 대학원 수준의 문제에 대한 언어 모델의 성능을 평가하기 위해 고안된 데이터 세트입니다. 실험에서는 GPQA-Diamond 하위 집합을 테스트 집합으로 사용하면서 GPQA-main에만 존재하는 문제(즉, GPQA-main에는 존재하지만 GPQA-Diamond에는 없는 문제)로 훈련 및 검증 집합을 구성합니다.

MT-벤치

MT-bench는 텍스트 분류, 요약, 질의응답 등 다양한 과제에서 언어 모델의 일반화 능력을 평가하도록 설계된 다중 과제 벤치마크입니다(Zheng et al., 2023). 실험에서는 MT-Bench에서 글쓰기, 롤플레잉, 인문학 과제를 선택했습니다. 이러한 검증 질문은 보충 자료에 나와 있습니다.

A.3.2 구성

실험에서는 최적화 비용을 가능한 한 일관되게 유지하기 위해 다양한 최적화 프레임워크를 구성했습니다. 이러한 프레임워크에서는 일반적으로 반복 횟수 및 반복당 생성되는 힌트 수를 포함하여 최적화 비용을 조정하기 위해 여러 가지 매개변수를 설정할 수 있습니다.

APE

APE는 3라운드 반복 최적화 프로세스를 사용하여 현재 풀에서 상위 10%(비율 = 0.1) 큐가 각 라운드에서 엘리트 큐로 선택됩니다. 큐 풀의 다양성과 크기를 유지하기 위해 변형 샘플링을 사용하여 이러한 엘리트 큐를 변경하여 총 큐 수를 50개로 유지합니다. 원본 논문(Zhou et al., 2023)의 설정에 따라 최적화 프로세스에는 LLM 큐 최적화를 안내하기 위한 샘플별 실행 결과가 포함되지 않습니다. 대신, 전체 훈련 세트의 단서를 평가하여 성능 점수를 얻습니다.

OPRO

OPRO는 라운드당 10개의 후보 큐를 생성하는 10라운드 반복 최적화 프로세스를 사용하며, 전체 훈련 세트에서 큐 성능을 평가하고 평가 점수에 따라 필터링합니다.OPRO는 고정된 크기의 큐 풀을 유지하지 않고 각 라운드에서 현재 최고의 큐를 기반으로 새로운 후보를 직접 생성합니다. 최적화 방향은 전체 훈련 데이터에 대한 성능 평가에 따라 결정됩니다.

프롬프트 에이전트

학습 및 검증 세트 모두에서 150개의 데이터를 샘플링한 거짓말쟁이 데이터 세트를 제외한 다른 데이터 세트는 표 A1에 지정된 크기를 따릅니다. PromptAgent는 몬테카를로 트리 검색(MCTS) 프레임워크를 사용하여 프롬프트를 최적화합니다. 초기 큐로 시작하여 모델 오류 피드백을 기반으로 새로운 후보를 생성합니다. 이 프로세스는 샘플링된 훈련 세트에 대한 벤치마크 평가를 사용하여 작업 성능을 개선하기 위한 고수익 경로를 식별합니다. 마지막으로 검증 세트에서 가장 성능이 좋은 처음 5개의 단서를 테스트하여 가장 좋은 단서를 선택하며, MCTS의 주요 파라미터로는 확장 폭 3, 깊이 제한 8, 12회의 반복이 있습니다.

프롬프트 브리더

프롬프트브리더를 구현할 때, 초기화를 위해 5가지 변형 단서와 5가지 사고 스타일을 사용하도록 시스템을 구성했습니다. 진화 프로세스는 20세대 동안 실행되며, 각 세대는 무작위로 샘플링된 훈련 예제에 대해 20번의 평가를 수행합니다. 최적화 모델은 기본값이 Claude-3.5-Sonnet이고 실행 모델은 기본값이 GPT-4o-mini입니다.

TextGrad

모든 데이터 세트는 50개의 샘플로 축소된 Liar 데이터 세트의 Train&Validate 세트를 제외하고 표 A1에 지정된 크기를 따르며, TextGrad는 배치 크기 3을 사용하여 확률적 그라데이션 하강을 수행하기 위해 에포크당 세 단계(epoch_{-3}, steps_{-3})의 세 가지 최적화 프로세스를 사용합니다. 각 단계에서 TextGrad는 최적화 도구인 LLM(Claude-3.5-Sonnet)의 피드백을 통해 그라데이션을 생성하여 시스템 단서를 업데이트합니다. 프레임워크는 유효성 검사 기반 축소 메커니즘을 유지합니다. 업데이트된 큐가 이전 반복보다 유효성 검사 세트에서 성능이 더 나빠지면 업데이트가 거부되고 큐가 이전 상태로 복원됩니다. 최적화 프로세스는 평가 LLM으로 Claude-3.5-Sonnet을 사용하여 큐를 평가하고 실제 작업 실행은 실행 LLM으로 GPT-4o-mini를 사용하여 안내하며, 실험 구성은 공식 TextGrad 리포지토리에서 제공하는 큐 최적화 설정을 따릅니다(Yuksekgonul et al., 2024).

SPO

SPO는 작업당 10번의 반복을 수행하여 최적화하며, 각 반복마다 미리 분할된 훈련 및 검증 데이터 세트에서 무작위로 3개의 질문(답변 없음)이 선택됩니다. 최적화 모델은 기본값이 Claude-3.5-Sonnet, 평가 모델은 기본값이 GPT-4o-mini, 실행 모델은 기본값이 GPT-4o-mini이며, 실제 답이 없는 질문만으로 효과적인 큐 최적화를 달성하여 SPO의 기능을 검증하는 것은 주목할 만한 사실입니다.

A.3.3 기준 프롬프트

이 섹션에서는 비교에 사용되는 기준 큐를 제공합니다. 큐의 초기 반복이 필요한 모든 큐 최적화 작업의 경우 항상 아래에 표시된 COT 큐를 제공합니다.

응답이 다음 형식으로 끝나는지 확인하세요.

A.3.4. SPO 최적화를 위한 팁

이 섹션에서는 주요 실험에서 얻은 최적화 단서를 보여드리며, Claude-3.5-Sonnet을 최적화 모델로, GPT-4o-mini를 평가 및 실행 모델로 사용했습니다.

GPQA 팁

아래 가이드라인에 따라 효율적이고 효과적으로 질문에 답변하세요:

- 문제 전체를 주의 깊게 읽고 모든 관련 정보와 핵심 개념을 파악하세요.

- 문제 유형에 따라 가장 적합한 문제 해결 방법을 선택하세요.

- 아래 단계에 따라 문제를 해결하세요:

a. 관련 공식, 원칙 또는 가정에 대한 설명

b. 필요한 모든 계산 또는 개념 분석을 표시합니다.

c. 모든 답안을 평가하고 잘못된 선택이 왜 틀렸는지 설명합니다(해당되는 경우). - 아래 구조에 따라 답변을 정리하세요:

[분석]

주요 이슈 및 핵심 메시지에 대한 간략한 설명(최대 2~3문장)

[솔루션]

- 모든 관련 계산 및 추론을 포함한 작업의 단계별 프레젠테이션

- 개념적 문제에 대한 명확하고 논리적인 설명 제공

[결론]

최종 답을 한 문장으로 명확하게 서술하세요.

- 이 답은 정답이고 다른 답은 틀린 이유를 간략하게 설명합니다(해당되는 경우).

명확성과 단순성을 우선시하여 이 구조를 다양한 문제 유형에 맞게 조정하세요. 답변이 문제의 모든 측면을 다루고 명확한 문제 해결 프로세스를 보여줄 수 있도록 하세요.

BBH-내비게이션 팁

아래 단계에 따라 주어진 지침을 분석하세요:

- 초기 조건을 명시합니다:

- 시작점: (0, 0)

- 초기 방향: 양의 X축(별도 명시되지 않은 경우)

- 좌표계를 사용합니다:

- X축: 왼쪽(-) 및 오른쪽(+)

- Y축: 뒤로(-) 및 앞으로(+)

- 각 단계를 분석합니다:

- 방향이 없는 모호한 지시(예: 방향이 없는 "X보 걷기")의 경우 앞으로 이동한다고 가정합니다.

- 각 이동 후 좌표 업데이트

- 가정한 사항을 간략하게 설명하세요.

- 모든 단계를 분석한 후

- 각 방향의 총 움직임 요약

- 최종 위치 명시

- 최종 위치와 시작 지점을 비교합니다:

- (0, 0)에서 거리를 계산합니다.

- "추론"이라는 레이블이 붙은 간결한 추론을 제공하세요.

- 주요 동작과 포지션에 미치는 영향 설명

- 결론에 대한 이유 제공

- "최종 답안:"이라는 레이블이 붙은 최종 답안을 작성합니다.

다음 XML 형식으로 응답을 끝냅니다: [예 또는 아니요].

분석이 구체적인 지침과 모호한 지침을 모두 다루면서 모든 문제 유형에 맞게 조정되었는지 확인합니다.

거짓말 팁

주어진 문장을 주의 깊게 분석하고 각 문제에 대해 아래 단계를 따르세요:

- 문장과 화자의 배경(제공된 경우), 문맥을 고려하세요.

- 성명서와 관련된 관련 사실과 수치를 조사하고 인용하세요.

- 이용 가능한 증거에 비추어 진술의 타당성을 평가합니다.

- 발표자의 잠재적인 편견이나 동기를 고려하세요.

각 문장에 대해 다음 구조에 따라 분석을 정리하세요:

사실 확인: [출처가 있는 핵심 사실 1] [출처가 있는 핵심 사실 2] [필요에 따라 추가] 분석: [진술의 타당성에 대한 간략한 분석 제공] 채점: [다음 척도 사용]

불확실성: [낮음/중간/높음 - 사용 가능한 증거의 질과 양에 근거] 요약: [진술의 타당성에 대한 한 문장으로 요약한 결론]

결정을 내리기 위한 정보가 충분하지 않은 경우 어떤 추가 정보가 필요한지 명확하게 명시하고 설명하세요.

각 분석은 [예 또는 아니요] XML 태그로 끝냅니다.

모든 문항을 분석한 후 결과를 전체적으로 요약하세요.

답변이 객관적이고 검증 가능한 정보를 기반으로 하며 분석에 사용된 모든 주요 사실에 대한 출처를 인용해야 합니다.

AGIEval-MATH 팁

- 주요 정보를 빠르게 식별

- 가장 빠른 솔루션 전략 설계

- 최소한의 계산 수행

- 답안 다시 확인

규칙:

가능한 경우 바로 가기 및 견적 사용

자세한 설명 생략

최종 답안에서 단위 생략

- 최종 답은 항상 다음 형식으로 제시하세요: \boxed{}

속도와 정확성을 우선시하세요. 시간을 효과적으로 관리하세요. 가장 짧은 시간에 효과적인 해결책을 찾기 위해 노력합니다. 제출하기 전에 답안 형식을 확인합니다. 어려운 문제가 발생하면 너무 많은 시간을 소비하기보다는 교육적인 추측을 하세요.

A.4 사례 연구

A.4.1 궤적 최적화

최적화 모델, 평가 모델, 실행 모델 역할을 하는 BBH-navigate 데이터 세트에서 GPT-4o-mini의 큐 최적화 궤적을 보여줍니다. 여기에는 당시 최적의 큐와 관련된 각 반복의 성공 여부와 해당 큐 콘텐츠가 포함됩니다.

반복 0 - 성공

차근차근 생각해 주세요. 응답이 [예 또는 아니요] 형식으로 끝나야 합니다.

반복 1 - 실패

다음 문제를 단계별로 분석하여 추론이 명확한지 확인하세요. 분석이 끝나면 지정된 XML 형식(예 또는 아니요)으로 최종 답을 입력합니다.

질문: [여기에 질문 삽입]

반복 2 - 실패

주어진 지침을 단계별로 분석하고 자신의 추론을 명확하게 요약하세요. 응답이 다음 XML 형식으로 끝나야 합니다: (예 또는 아니오).

반복 3 - 실패

제공된 단계를 철저히 분석하고 각 조치를 기록하세요. 전체적으로 추론이 명확하고 논리적인지 확인하세요. (예 또는 아니요)와 같은 XML 형식으로 마무리하세요.

반복 4 - 성공

문제를 단계별로 세분화하여 명확하고 논리적으로 추론하는 과정을 통해 문제에 접근하시기 바랍니다. 최종 답변을 말하기 전에 [예 또는 아니오]와 같은 XML 형식을 사용하여 결과를 명확하게 요약하세요. 예를 들어, 일련의 작업 후 출발점으로 돌아갈지 여부에 대한 질문인 경우 각 작업을 자세히 설명하고 그에 따라 자신의 위치를 업데이트한 후 출발점으로 돌아갈지 여부를 결론지으세요.

최종 답변: [예 또는 아니요]

반복 5 - 성공

문제를 단계별로 세분화하여 철저히 분석하세요. 각 움직임이나 행동을 명확하게 설명하고 그에 따라 자신의 위치나 상태를 업데이트하세요. 마지막으로, 결과를 요약하여 시작점으로 돌아갔는지 또는 명시된 결과를 달성했는지 판단하세요. 마지막으로, [예 또는 아니오]와 같은 XML 형식을 사용하여 명확하게 답을 제시합니다. 예를 들어, 일련의 작업 후 시작 지점으로 돌아갔는지 묻는 경우 각 작업을 명확하게 기록하고 위치를 추적한 후 시작 지점으로 돌아갔는지 여부를 명시하세요.

최종 답변: [예 또는 아니요]

반복 6 - 성공

문제를 체계적으로 분석하고 명확하고 연속적인 단계로 세분화하세요. 각 작업의 시작점과 방향을 정의하고 그에 따라 각 단계가 끝난 후 위치를 업데이트하세요. 마지막으로 여정을 요약하고 최종 위치가 시작 지점으로 돌아가는지 또는 원하는 결과를 달성하는지 명확하게 표시하세요. 다음 XML 형식을 사용하여 최종 답변을 [예 또는 아니오]로 명확하게 제시하세요. 예를 들어 일련의 작업 후 시작 지점으로 돌아갔는지 묻는 경우 각 단계를 명확하게 기록하고 위치를 추적한 다음 시작 지점으로 돌아갔는지 여부를 명시하세요.

최종 답변: [예 또는 아니요]

반복 7 - 실패

각 조치를 명확하게 설명하고 결과 위치를 추적하면서 문제를 단계별로 평가하세요. 분석이 끝나면 여정을 요약하고 최종 위치가 시작 지점으로 돌아갔는지 또는 예상 기준을 충족하는지 표시하세요. 최종 답변이 [예 또는 아니오]와 같은 XML 형식으로 명확하게 표시되는지 확인하세요. 예를 들어 일련의 작업 후 시작 지점으로 돌아갔는지 묻는 경우 각 단계를 간결하게 기록하고, 위치를 추적하고, 시작 지점으로 돌아갔는지 표시해야 합니다.

최종 답변: [예 또는 아니요]

반복 8 - 성공

문제를 체계적으로 분석하고 이를 간결한 조치로 세분화하세요. 정의된 위치에서 시작하여 각 단계가 자신의 위치에 미치는 영향을 추적하세요. 각 조치를 자세히 설명한 후 전체 여정을 요약하고 최종 위치가 시작 지점으로 돌아가는지 또는 원하는 결과를 달성하는지 명확하게 표시하세요. 다음 XML 형식을 사용하여 예 또는 아니요라는 최종 답변을 명확하게 제시하세요. 예를 들어 일련의 작업을 수행한 후 시작 지점으로 돌아갔는지 묻는 경우 각 단계를 명확하게 문서화하고 위치를 정확하게 추적한 후 결과를 명시하세요.

최종 답변: [예 또는 아니요]

반복 9 - 실패

움직임을 체계적으로 설명하는 것부터 시작하세요. 정해진 위치에서 시작하여 이동한 방향과 거리를 포함하여 각 단계를 자세히 설명하세요. 동작이 완료되면 전체 여정을 요약하고 최종 위치가 출발점으로 돌아가는지 또는 원하는 결과를 달성했는지 명확하게 표시하세요. 최종 답변과 함께 예 또는 아니오의 XML 형식으로 자신의 행동을 제시해야 합니다. 예를 들어, 일련의 기동 후 출발 지점으로 돌아갔는지 묻는 경우 각 단계를 기록하고 위치를 정확하게 추적한 후 결과를 명시해야 합니다.

최종 답변: [예 또는 아니요]

반복 10 - 성공

제공된 동작 지침을 철저히 분석하고 각 단계를 명확하게 기록하세요. 초기 위치를 정의하는 것부터 시작하여 체계적으로 움직임을 추적하고 각 단계마다 위치를 업데이트하세요. 동작을 완료한 후에는 여정을 요약하고 최종 위치가 시작 지점과 일치하는지 또는 원하는 결과를 달성했는지 확인합니다. 다음 XML 형식을 사용하여 예 또는 아니오로 최종 답변을 명확하게 표시하세요. 예를 들어, 일련의 작업을 수행하면 시작 지점으로 돌아가는지 묻는 질문이라면 각 단계를 체계적으로 설명하고 위치를 정확하게 추적한 후 결과에 도달해야 합니다.

최종 답변: [예 또는 아니요]

성공/실패 상자는 SPO가 10번의 반복을 통해 BBH 내비게이션 단서를 최적화하는 과정을 보여줍니다. 성공적인 버전(녹색)은 단서를 점진적으로 개선하여 더 나은 사고 과정을 유도하는 반면, 실패한 시도(빨간색)는 최적이 아닌 단서로 인해 지나치게 단순화되거나 중복된 사고로 이어질 수 있습니다. 이 궤적은 시스템의 시행착오를 통한 개선 메커니즘을 보여줍니다.

기능 최적화를 위한 팁

请逐步思考。

确保响应以以下 XML 格式结束:<answer>[是或否]</answer>。

이슈

如果您遵循这些指示,您是否返回起点?始终面向前方。

- 向右走1步。

- 向左走3步。

- 向右走2步。

选项:

- 是

- 否

솔루션

让我们逐一步分析这些步骤:

1. **起点**:我们从起点开始,面向前方。

2. **第1步**:向右走1步。现在我们位于起点右侧1步的位置。

3. **第2步**:向左走3步。从我们当前的位置(1步右侧),向左移动3步意味着:

- 1步向左使我们回到起点。

- 2步向左使我们位于起点左侧1步的位置。

- 3步向左使我们位于起点左侧2步的位置。

4. **第3步**:向右走2步。从我们当前的位置(2步左侧),向右移动2步意味着:

- 1步向右使我们回到起点左侧1步的位置。

- 2步向右使我们回到起点。

모든 단계를 완료하고 나면 다시 시작점으로 돌아옵니다.

따라서 답은 다음과 같습니다:

be

通过比较迭代0的初始提示和迭代10的最终提示的输出结果,“思考过程的迭代优化”变得显而易见。在这种情况下,模型从最初使用文本描述来推理位置演变为最终展示出使用坐标的能力,即使提示中并未明确强调使用坐标。

**A.4.2. 现实应用**

在本节中,我们展示了使用 Claud-3.5-Sonnet 作为优化模型,GPT-4o-mini 作为评估模型,Llama-3-8B 作为执行模型,经过10次迭代后的优化结果,涵盖四个任务:广告设计、社交媒体内容、现代诗歌写作和概念解释。此外,我们还提供了迭代过程中使用的 YAML 配置文件以及从过程中获得的优化提示。

**广告设计**

**优化前的性能**

**提示** = """分析给定的广告任务并创建引人注目的文案。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """1. **黑色星期五警报:店内有不可错过的科技优惠!**

2. **科技盛宴:黑色星期五顶级品牌高达50%的折扣!**

3. **别错过!为您准备的独家黑色星期五科技优惠**"""

**优化后的性能**

**提示** = """分析给定的广告任务,并根据指定的平台(s)和行业创建引人注目的文案。考虑当前趋势、竞争对手策略以及目标受众的人口统计和心理特征。提供至少3种不同的创意选项,每个选项都有独特的角度或方法。包括您选择的原因,并解释它们如何与品牌声音和营销目标保持一致。整合行业最佳实践和特定平台的格式指南。建议如何为不同的渠道或格式调整文案,包括对语气、风格和结构的特定说明。此外,提供有关视觉元素或多媒体内容增强广告文案效果的建议。"""

**问题** = "为黑色星期五科技促销活动写电子邮件主题行"

**答案** = """**广告任务:** 创建引人注目的电子邮件主题行,针对的是对最新科技产品和优惠感兴趣的技术爱好者。

**目标受众:**

* 人口统计:25-45岁,男女皆可

* 心理特征:科技爱好者、早期采用者和讨价还价猎人

* 兴趣:科技、产品创新和节省开支

**竞争对手策略:**

* 强调折扣和促销

* 突出新产品发布和限时优惠

* 使用紧迫性策略,例如倒计时计时器和稀缺性消息传递

**当前趋势:**

* 移动优先方法

* 个性化和细分

* 讲故事和情感联系

**创意选项:**

**选项1:** "解锁未来:高达50%的顶级科技优惠"

* 角度:专注于获得最新科技的兴奋感和刺激感

* 理由:这个主题行营造了一种 FOMO(害怕错过)的氛围,并强调了销售的价值

* 品牌声音:有趣、充满活力和顽皮

* 营销目标:推动销售和提高品牌知名度

**选项2:** "您的黑色星期五科技盛宴等着您"

* 角度:强调等待被发现的科技优惠宝藏的想法

* 理由:这个主题行营造了一种期待感和好奇心,鼓励读者打开电子邮件

* 品牌声音:友好、亲切和邀请

* 营销目标:推动参与和转化

**选项3:** "别错过:独家黑色星期五优惠给科技爱好者"

* 角度:突出销售独家性和限时性

* 理由:这个主题行营造了一种紧迫感和重要性,让读者感觉自己是特殊群体的一部分

* 品牌声音:自信、权威和独家

* 营销目标:推动转化和建立品牌忠诚度

사전 최적화된 광고 헤드라인은 "블랙 프라이데이 알림: 매장에서 테크 딜을 놓칠 수 없습니다!"와 같이 일반적입니다. 와 같이 구체성과 창의성이 부족하고 타겟 오디언스의 특성이나 브랜드 개성을 강조하지 못합니다. "잠금 해제 미래: 최대 50%의 최고 기술 거래"와 같이 최적화된 헤드라인은 "잠금 해제 미래"를 사용하여 기술 혁신을 강조하고 할인과 결합하여 호기심을 자극하고 가치를 강조하는 것이 더 매력적이며 다음과 같이 더 부합합니다. "미래를 열어라"를 사용하여 기술 혁신을 강조하고 할인 메시지와 결합하여 호기심을 자극할 뿐만 아니라 가치를 강조하는 것은 기술 애호가의 심리적 요구에 더 부합합니다.

BBH 탐색 데이터 집합에서 템플릿 반복하기

소셜 미디어 콘텐츠

최적화 전 성능

STH에 주목하세요. = """매력적인 트윗 만들기.""""

솔루션 = """트윗. "커피 애호가 여러분, 좋은 아침입니다! 커피를 가장 좋아하는 방법을 댓글로 공유해주신 선착순 10명에게 스페셜티 커피 한 잔 무료 쿠폰을 증정합니다.# 커피 # 커피 중독 # 모닝 파워"

이 트윗은 여러 가지 방법으로 오디언스와 소통할 수 있도록 설계되었습니다:

- 클릭 유도 문안이 트윗은 팔로워들에게 자신이 가장 좋아하는 커피를 공유하도록 요청하여 브랜드와 소통하고 참여하도록 유도했습니다.

- 인센티브무료 커피를 제공한다는 약속은 사람들이 트윗에 참여하고 아이디어를 공유하도록 유도하는 훌륭한 인센티브입니다.

- 탭 (창의) (컴퓨팅)# 커피, # 커피 중독, # 모닝 파워와 같은 관련 해시태그를 사용하면 더 많은 사람들에게 도달하고 새로운 팔로워를 유치하는 데 도움이 됩니다.

- 개인화된 연락처"좋은 아침"이라는 친근한 인사말로 시작하는 이 트윗은 청중을 '커피 애호가'라고 지칭하여 더욱 개인적이고 친밀한 느낌을 줍니다.

커피 브랜드는 이 트윗에 응답함으로써 팔로워와 대화를 시작하고 피드백을 수집하며 브랜드에 대한 공동체 의식을 구축할 수 있습니다("""").

최적화된 성능

STH에 주목하세요. = """주어진 주제나 브랜드를 기반으로 매력적인 소셜 미디어 콘텐츠를 만듭니다. 아래 가이드라인을 따르세요:

- 대상 고객과 플랫폼을 식별합니다(지정된 경우).

- 콘텐츠의 주요 목표(예: 가시성, 참여도, 홍보)를 명시합니다.

| 3. 적절한 콘텐츠 형식(예: 텍스트, 이미지, 동영상)을 선택합니다. | |

| 4. 현재 트렌드와 관련된 독특한 각도 또는 컨셉을 개발합니다. | |

| 5. 눈에 띄는 제목 또는 시작 멘트를 작성합니다(최대 10단어). | |

| 6. 간결하고 플랫폼에 적합한 콘텐츠를 개발합니다(50~100단어). | |

| 7. 관련 태그를 2~3개 포함합니다. | |

| 8. 명확한 클릭 유도 문안을 추가합니다. | |

| 9. 시각적 요소 또는 개선 사항을 제안합니다. | |

| 이 가이드라인에 따라 주어진 주제나 브랜드에 맞게 조정된 소셜 미디어 콘텐츠를 제공합니다. | |

| 타겟 오디언스와 공감대를 형성하고 현재 소셜 미디어 트렌드에 부합하는 진정성 있고 관련성 있는 콘텐츠를 만드는 데 집중하세요. 구체적인 요구 사항이 제시되지 않은 경우 합리적인 가정을 하고 선택 사항을 설명해 주세요(""""). | |

| 질문 = "커피 브랜드에 대한 참여 트윗 만들기" | |

| 답변 = | |

| **대상: 커피 애호가, 젊은 층(18~35세) | |

| **플랫폼:** 트위터 | |

| **주요 목표:** 참여 | |

| **콘텐츠 형식:** 텍스트 | |

| **독특한 관점:** 커피 애호가들이 공감할 수 있는 감동적인 순간을 공유하세요. | |

| **눈길을 끄는 헤드라인: "커피가 방 안에 유일한 어른일 때" | |

| **내용: "커피 한 잔으로 모든 것이 정돈되는 아침을 경험해 보지 않은 사람이 있을까요? 가장 혼란스러웠던 아침 이야기를 공유하고 # 커피가 하루를 살리는 # 모닝 파워를 한탄해 봅시다" | |

| **태그:** # 커피가 하루를 살리는 # 아침 동기 부여 | |

| **행동 유도: **댓글로 나만의 지저분한 아침 이야기를 공유하세요! | |

| **시각적 요소:** 중앙에 커피 한 잔이 놓인 혼돈에 둘러싸인 사람의 흥미로운 모달 또는 GIF. | |

| 이 트윗은 많은 사람들이 공감할 수 있는 감동적인 순간을 공유함으로써 커피 애호가들의 참여를 유도하는 것을 목표로 했습니다. 유머와 가벼운 어조를 사용하여 청중과 쉽게 소통할 수 있었습니다. '# 커피가 하루를 살린다'와 '# 모닝 파워'라는 해시태그는 인기와 연관성이 모두 높아 트윗의 가시성을 높였습니다. | |

| 이 행동 유도 문안은 사용자들이 자신의 이야기를 공유하도록 장려하여 공동체 의식을 함양하고 참여를 독려합니다. | |

| II | |

사전 최적화된 트윗은 "좋은 아침, 커피 애호가 여러분!"과 같이 감정적 공감이 부족한 직설적인 콘텐츠로 공짜를 미끼로 사용합니다. 공짜 커피 한 잔을 드립니다..." . 최적화된 트윗은 "커피가 유일한 어른일 때"라는 유머러스한 표현을 통해 커피를 일상 생활 시나리오에 은근히 녹여내어 관련성과 상호작용성을 높였습니다. 예를 들어 "커피가 있어야만 일이 진행되는 아침을 겪어보지 않은 사람이 어디 있을까요? " 사용자 참여와 정서적 연결을 자극하는 데 성공했습니다.

BBH 탐색 데이터 세트의 반복 템플릿입니다:

성능 최적화 전

STH에 주목하세요. = """요청된 스타일과 형식으로 시를 작성합니다.""""

이슈 = "기후 변화에 대한 현대 소네트 쓰기"

솔루션 = """타오르는 하늘에서 우리는 탄소 배출이 전염병처럼 퍼지면서 지구의 고대 전설이자 우리의 무분별한 통제의 희생자인 기온 상승에 대한 경고를 봅니다.

연약한 왕좌, 녹아 내리는 바다, 인간의 탐욕, 우리가 갚을 수없는 빚을 속죄하기 위해 떠오르는 극지방 얼음 기후 변화로 위기가 전복됩니다.

그러나 여전히 우리는 주저하고 부정의 소용돌이에 중독되어 있습니다 과학자들은 고뇌에 울고기도합니다 너무 늦기 전에 빨리 행동하여 우리의 무모한 방식에서 지구를 구하십시오.

하지만 우리는 여전히 사랑과 인간의 힘으로 조류를 바꾸고 새로운 빛을 가져올 수 있기를 희망합니다."""

성능 최적화

STH에 주목하세요. = """기존의 경계를 허물고 기존의 기대를 깨는 시를 만들려면 다음과 같은 강화된 가이드라인을 따릅니다:

- 요청된 시적 형식을 해체하고 재구성하여 그 본질을 유지하면서 구조적 한계를 뛰어넘습니다.

- 무생물, 추상적인 개념 또는 미세한 실체의 관점 등 전혀 예상치 못한 관점에서 주제에 접근하세요.

- 초현실적이고 아방가르드한 이미지를 사용하여 독자의 현실 인식에 도전하는 동시에 주제의 핵심인 감정적 진실을 전달합니다.

- 수학 표기법, 과학 기호 또는 프로그래밍 언어와 같은 색다른 요소를 통합하여 독특한 언어 환경을 만들 수 있습니다.

- 타이포그래피, 줄 바꿈 및 공백을 실험하여 주제에 대한 탐구를 강화하는 시각적 시를 만들어 보세요.

- 다양한 감각을 놀라운 방식으로 혼합하는 플럭스 같은 감각 경험을 결합하여 강한 감정적 반응을 불러일으킵니다.

- 혼란스러우면서도 깨달음을 주는 결말로 끝나는 이 작품은 독자에게 깊은 변화의 느낌을 남깁니다.

글을 쓰기 전에 주제와 시적 형식에 접근하는 가장 급진적인 방법을 상상해 보세요. 시의 정의에 도전하는 동시에 깊은 수준의 정서적 공감을 불러일으키는 작품을 만드는 것이 목표입니다.

시는 답변으로만 제공되며 추가적인 해석이나 분석은 포함되지 않습니다.""""

이슈 = "기후 변화에 대한 현대 소네트 쓰기"

솔루션 = """프랙탈 속삭임 속에서 지구의 맥박은 천천히 뛴다 탄소의 어두운 얼룩이 눈 속으로 스며들면서 절망의 미적분, 방정식은 커진다 기하급수적인 붕괴, 미래의 슬픔

엔트로피의 차가운 손이 지구의 심장을 움켜쥐면서 생명의 열역학적 춤이 펼쳐집니다. 한때 푸른 하늘은 이제 무거운 미립자 안개 덩어리로 묶여 햇빛을 가리고 있습니다.

이 으스스한 황혼에 그림자가 남아 빙하의 유령이 속삭입니다 "여기가 집이야" 얼음을 위한 레퀴엠, 추억이 저장된 얼어붙은 메아리 속에서 과거를 탐험합니다.

하지만 이 황량한 풍경 속에서도 한 줄기 불꽃은 남아 있습니다.

사랑이 지속되는 희망의 비약적인 도약입니다."

사전 최적화된 소네트는 깔끔하게 구성되어 있지만 '기온 상승'이나 '얼음 녹기'와 같은 전통적인 이미지의 사용에서 참신함이 부족합니다. 최적화된 시는 "프랙탈 속삭임" 및 "열역학적 엔트로피"와 같은 과학적 개념을 도입합니다(예: "프랙탈 속삭임에서 지구의 맥박은 천천히 뛴다" 및 "지구의 맥박은 천천히 뛴다"). "생명의 열역학적 춤이 펼쳐진다"와 같은 학제 간 은유를 사용하여 기후 주제에 더 깊은 철학적 성찰을 부여하여 시의 예술적, 지적 깊이를 높입니다.

BBH 탐색 데이터 세트의 반복 템플릿입니다:

개념 설명

성능 최적화 전

STH에 주목하세요. = """복잡한 개념을 일반인이 이해하기 쉬운 용어로 설명하세요.""""

이슈 = "요리 비유를 이용한 mRNA 백신 설명"

솔루션 ="""당신이 훌륭한 요리사이고 손님을 위해 맛있는 요리를 준비하고 있다고 상상해 보세요. 모든 재료가 준비되어 있지만 완벽한 맛과 식감을 내기 위해서는 올바른 순서와 조합으로 재료를 준비해야 합니다.

mRNA 백신의 세계에서 '접시'는 특정 바이러스나 질병에 대한 면역 체계의 반응입니다. "성분"은 신체에 특정 단백질을 만드는 방법을 알려주는 유전적 지침(mRNA)으로, 면역 반응을 유발하는 데 사용됩니다.

다음과 같이 작동합니다:

레시피 선택mRNA 백신은 레시피 북을 선택하는 것과 같습니다. 특정 바이러스나 질병에 대한 면역 반응을 유발하는 데 핵심이 되는 단백질에 해당하는 특정 mRNA 서열을 선택하면 됩니다.

2. 재료 준비mRNA 염기서열은 신체에 특정 단백질을 만드는 방법을 알려주는 일련의 지침과 같으며, 단백질을 만들기 위해 각 성분(아미노산)의 정확한 양을 측정하는 것과 마찬가지로 실험실에서 mRNA를 준비합니다.

3. 배달음식에 재료를 넣는 것과 같은 방식으로 mRNA를 체내에 전달합니다. 이 경우 mRNA는 지질 나노입자(LNP)라는 작은 입자에 포장되어 체내 세포에 도달하는 데 도움이 됩니다.

4. 셀룰러 요리mRNA가 세포에 도달하면 냄비에 재료를 넣는 것과 같습니다. 세포는 mRNA의 지시를 읽고 특정 단백질을 만들기 시작합니다. 그런 다음 이 단백질은 세포 표면에 깃발처럼 표시되어 면역계에 외부 침입자의 존재를 경고합니다.

- 면역 반응면역 체계는 항체를 생성하고 면역 세포를 활성화하여 단백질에 반응합니다. 마치 요리사가 맛있는 향에 반응하여 요리의 마지막 터치를 더하는 것처럼 말이죠. 그러면 면역 체계는 특정 단백질에 반응하는 방법을 기억하여 나중에 다시 해당 단백질을 접할 경우 신속하게 방어할 수 있습니다.

간단히 말해, mRNA 백신은 면역 체계를 위한 레시피와 같습니다. 특정 단백질을 만들도록 신체에 유전적 지침을 제공하여 면역 반응을 촉발하고 질병으로부터 보호하는 데 도움이 됩니다.""""

성능 최적화

STH에 주목하세요. = """복잡한 개념을 일반인이 이해하기 쉬운 용어로 설명하세요.""""

이슈 = "요리 비유를 이용한 mRNA 백신 설명"

솔루션 = """정의mRNA 백신은 메신저 RNA(mRNA)라는 일종의 유전 물질을 사용하여 세포에 질병과 싸우는 방법을 가르치는 백신입니다.

아날로그여러분이 마스터 셰프이고 맛있는 요리를 위한 새로운 레시피를 만들고 싶다고 상상해 보세요. 수석 수셰프를 가게에 보내 모든 재료를 사게 한 다음 혼자서 요리를 조립하는 방법을 알아내도록 내버려 두지는 않을 것입니다. 대신 따라야 할 정확한 단계를 설명하는 레시피 카드를 제공하겠죠. 마찬가지로 mRNA 백신은 면역 체계가 질병과 싸우는 데 도움이 되는 특정 단백질을 만드는 지침이 담긴 레시피 카드(mRNA)를 세포에 제공함으로써 작동합니다.

주요 구성 요소::

- mRNA특정 단백질을 만들기 위한 지침이 담긴 레시피 카드입니다. 세포가 따라야 할 청사진이라고 생각하세요.

- 세포질우리 몸속의 수셰프, 그들은 mRNA 레시피 카드를 받아 단백질을 만드는 데 사용합니다.

- 탄수화물우리 몸의 면역 체계가 질병을 인식하고 싸우는 데 도움을 주는 세포가 만들어내는 궁극의 요리입니다.

관련(이야기 또는 정보)mRNA 백신을 접종하면 세포는 레시피 카드(mRNA)를 받아 특정 단백질을 만드는 데 사용합니다. 그러면 이 단백질이 면역 반응을 일으켜 우리 몸에 질병을 인식하고 싸우는 방법을 알려줍니다. 마치 세포가 레시피 카드를 따라 건강을 유지하는 데 도움이 되는 맛있는 요리를 만드는 것과 같습니다!

대화형 요소누군가로부터 레시피를 받아 요리를 만들기 위해 따라해야 했던 때가 생각나요? 기분이 어땠나요? 세포가 mRNA 백신의 레시피 카드를 받아 질병과 싸우는 데 도움이 되는 단백질을 만드는 데 사용한다고 상상해 보세요. 기분이 어떠신가요?

시각적 성능mRNA 분자, mRNA를 받는 세포, 생성되는 단백질을 보여주는 간단한 다이어그램입니다.

제한 사항mRNA 백신은 아직 비교적 새로운 기술이며 장기적인 효과와 잠재적인 부작용을 이해하려면 더 많은 연구가 필요합니다.

평결에 도달하기mRNA 백신은 질병과의 싸움에서 판도를 바꿀 수 있습니다. 세포에 레시피 카드를 제공함으로써 면역 체계가 질병을 더 효과적으로 인식하고 퇴치하는 방법을 가르칠 수 있습니다. mRNA 백신의 미래는 어떻게 될까요?""?

미리 최적화된 설명은 요리 비유를 사용하지만 "당신이 마스터 셰프라고 상상해 보세요..."와 같이 길고 집중력이 부족합니다. . 최적화된 버전은 "레시피 카드"와 같은 핵심 은유를 사용하여 복잡한 개념을 이해하기 쉬운 단계로 단순화합니다(예: "mRNA 서열은 신체에 특정 단백질을 만드는 방법을 알려주는 일련의 지침과 같습니다"). "셰프-수셰프" 역할을 사용하여 설명을 더욱 생생하고 직관적으로 표현하여 독자가 핵심을 빠르게 파악할 수 있도록 돕습니다.

BBH 탐색 데이터 집합의 반복 템플릿 힌트: | 복잡한 개념을 알기 쉽게 설명하세요.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...