딥서치+디파이의 프라이빗 배포: 안전하고 제어 가능한 로컬 AI 어시스턴트 시스템 구축

개요

DeepSeek 는 고급 알고리즘 아키텍처와 리플렉티브 체인 기능을 통해 AI 대화 상호 작용에 혁신적인 경험을 제공하는 획기적인 오픈 소스 빅 언어 모델입니다. 비공개 배포를 통해 데이터 보안 및 사용 보안을 완벽하게 제어할 수 있습니다. 또한 배포 체계를 유연하게 조정하고 편리한 사용자 지정 시스템을 구현할 수 있습니다.

Dify 동일한 오픈 소스 AI 애플리케이션 개발 플랫폼으로서 완벽한 프라이빗 배포 솔루션을 제공합니다. 로컬에 배포된 DeepSeek 서비스를 Dify 플랫폼에 원활하게 통합함으로써 조직은 데이터 프라이버시를 보장하면서 로컬 서버 환경 내에서 강력한 AI 애플리케이션을 구축할 수 있습니다.

비공개 배포 옵션의 장점은 다음과 같습니다:

- 뛰어난 성능 비즈니스 모델에 필적하는 대화 상호 작용 경험 제공

- 환경 격리 완전 오프라인 운영으로 데이터 유출 위험 제거

- 데이터 제어 가능성 데이터 자산을 완벽하게 제어하여 규정 준수 요건 충족

사전 포지셔닝

하드웨어 환경:

- CPU >= 2코어

- 비디오 메모리/RAM ≥ 16기가바이트(권장)

소프트웨어 환경:

- Docker

- 도커 컴포즈

- Ollama

- Dify 커뮤니티 에디션

배포 시작

1. 올라마 설치

Ollama는 딥시크, 라마, 미스트랄 등과 같은 대규모 언어 모델(LLM)을 원활하게 배포하도록 설계된 크로스 플랫폼 대규모 모델 관리 클라이언트(MacOS, Windows, Linux)입니다. Ollama는 원클릭으로 대규모 모델을 배포할 수 있으며 모든 사용 데이터는 컴퓨터에 로컬로 저장되므로 완벽한 데이터 프라이버시 보호 보안을 제공합니다.

Ollama 웹사이트를 방문하여 안내에 따라 Ollama 클라이언트를 다운로드하고 설치합니다. 설치 후 다음을 실행합니다. ollama -v 명령은 버전 번호를 출력합니다.

➜~ollama-v

ollamaversionis0.5.5

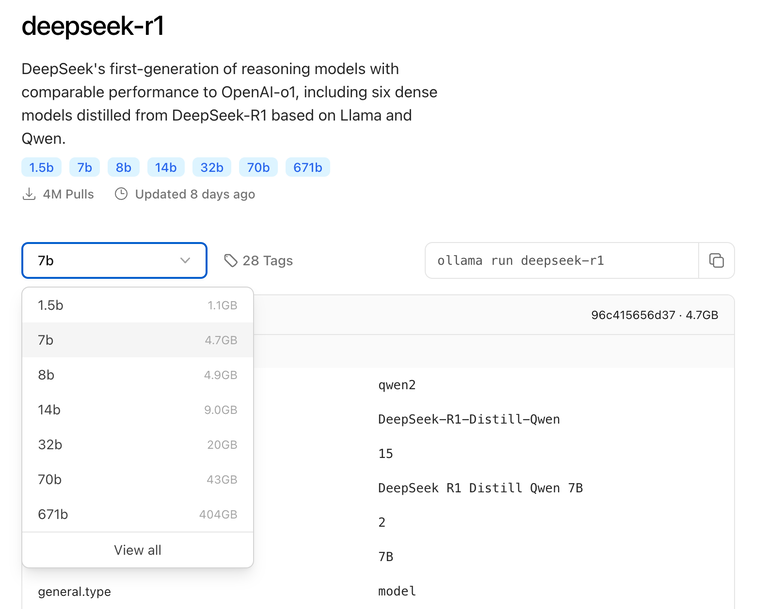

실제 환경 구성에 따라 배포에 적합한 DeepSeek 크기 모델을 선택합니다. 초기 설치에는 7B 크기 모델을 권장합니다.

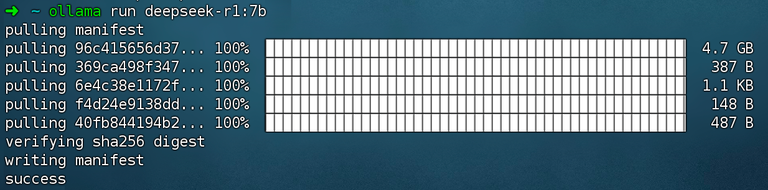

명령 실행 ollama run deepseek-r1:7b 마운팅 DeepSeek R1 모델.

2. Dify 커뮤니티 에디션 설치

Dify GitHub 프로젝트 주소를 방문하여 다음 명령을 실행하여 코드 저장소 풀링 및 설치 프로세스를 완료하세요.

gitclonehttps://github.com/langgenius/dify.git

cddify/docker

cp.env.example.env

dockercomposeup-d# 如果版本是 Docker Compose V1,使用以下命令:docker-compose up -d

명령을 실행하면 모든 컨테이너의 상태와 포트 매핑을 확인할 수 있습니다. 자세한 지침은 다음을 참조하세요. 도커 컴포즈 배포.

Dify 커뮤니티 에디션은 기본적으로 포트 80을 사용합니다. http://your_server_ip 개인화된 Dify 플랫폼에 액세스하세요.

3. 딥시크와 디파이 연결하기

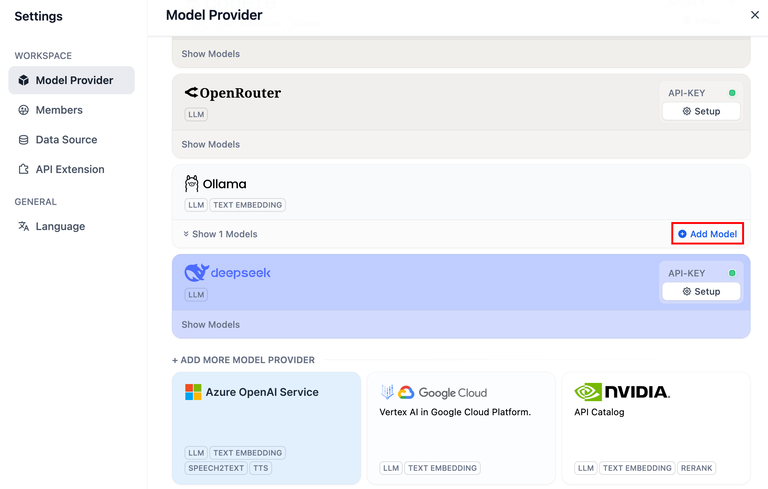

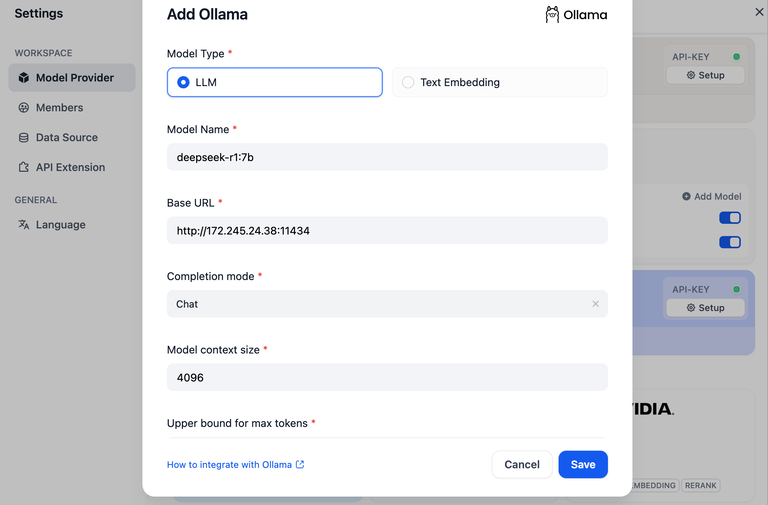

Dify 플랫폼의 오른쪽 상단을 클릭합니다. 아바타 → 설정 → 모델 공급업체 올라마를 선택하고 모델 추가를 탭합니다.

모델 공급자 내의 DeepSeek는 온라인 API 서비스에 해당하며, 로컬로 배포된 DeepSeek 모델은 Ollama 클라이언트에 해당합니다. 위의 배포 지침에 자세히 설명된 대로 Ollama 클라이언트에서 DeepSeek 모델이 성공적으로 배포되었는지 확인하세요.

LLM 모델 유형을 선택합니다.

- 모델 이름에 배포된 모델의 모델 이름을 입력합니다. 위에 배포된 모델은 deepseek-r1 7b이므로, 모델 이름에

deepseek-r1:7b - 기본 URL: Ollama 클라이언트가 실행되는 주소, 일반적으로 다음과 같습니다.

http://your_server_ip:11434. 연결에 문제가 있는 경우일반적인 문제. - 다른 옵션은 기본값으로 유지됩니다. 에 따라 DeepSeek 모델에 대한 설명생성되는 최대 토큰 길이는 32,768개입니다.

AI 애플리케이션 구축

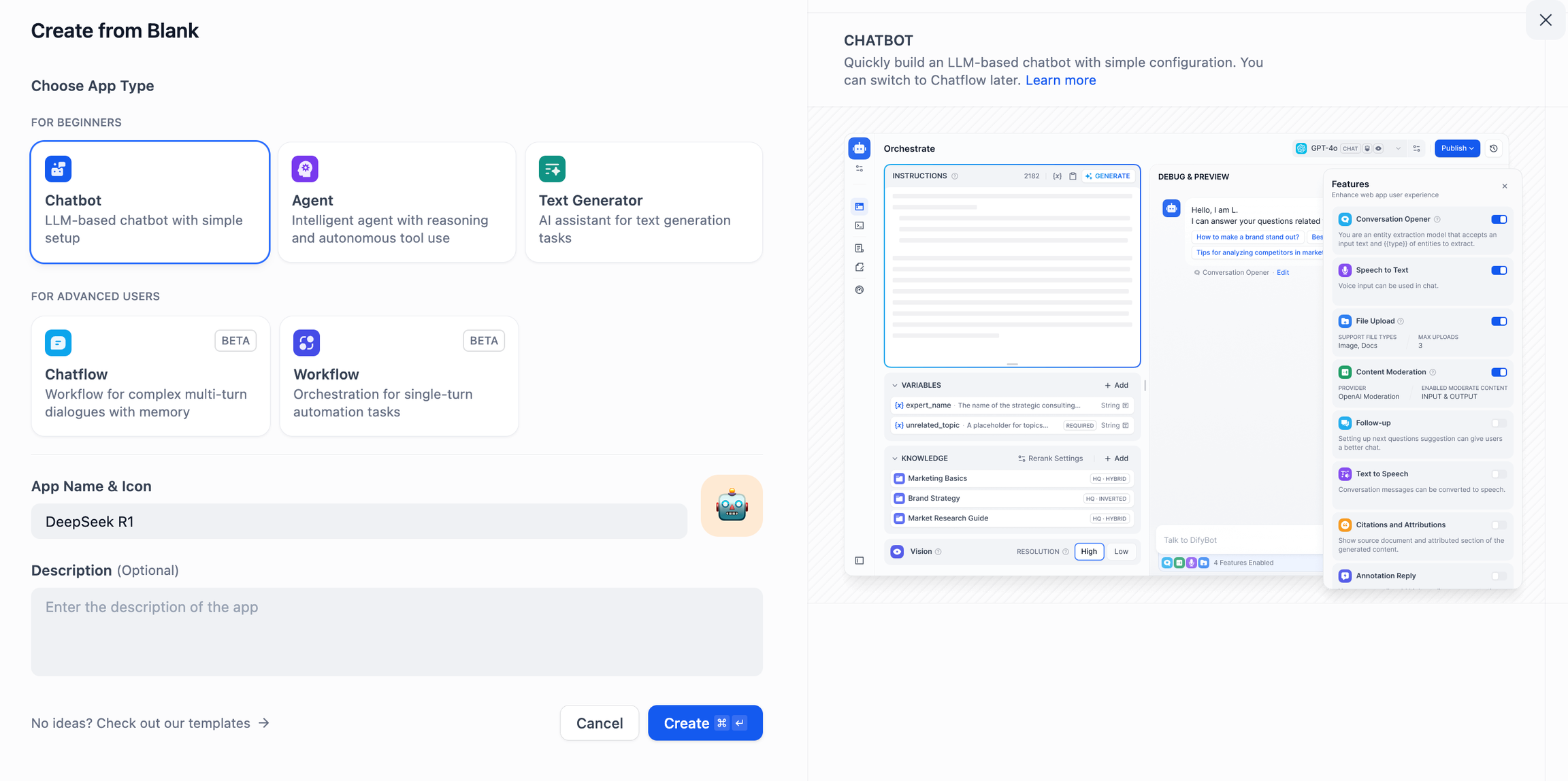

딥서치 AI 챗봇(간단한 애플리케이션)

- Dify 플랫폼 홈페이지 왼쪽에서 "빈 앱 만들기"를 탭하고 "채팅 도우미" 유형의 앱을 선택한 후 간단히 이름을 지정합니다.

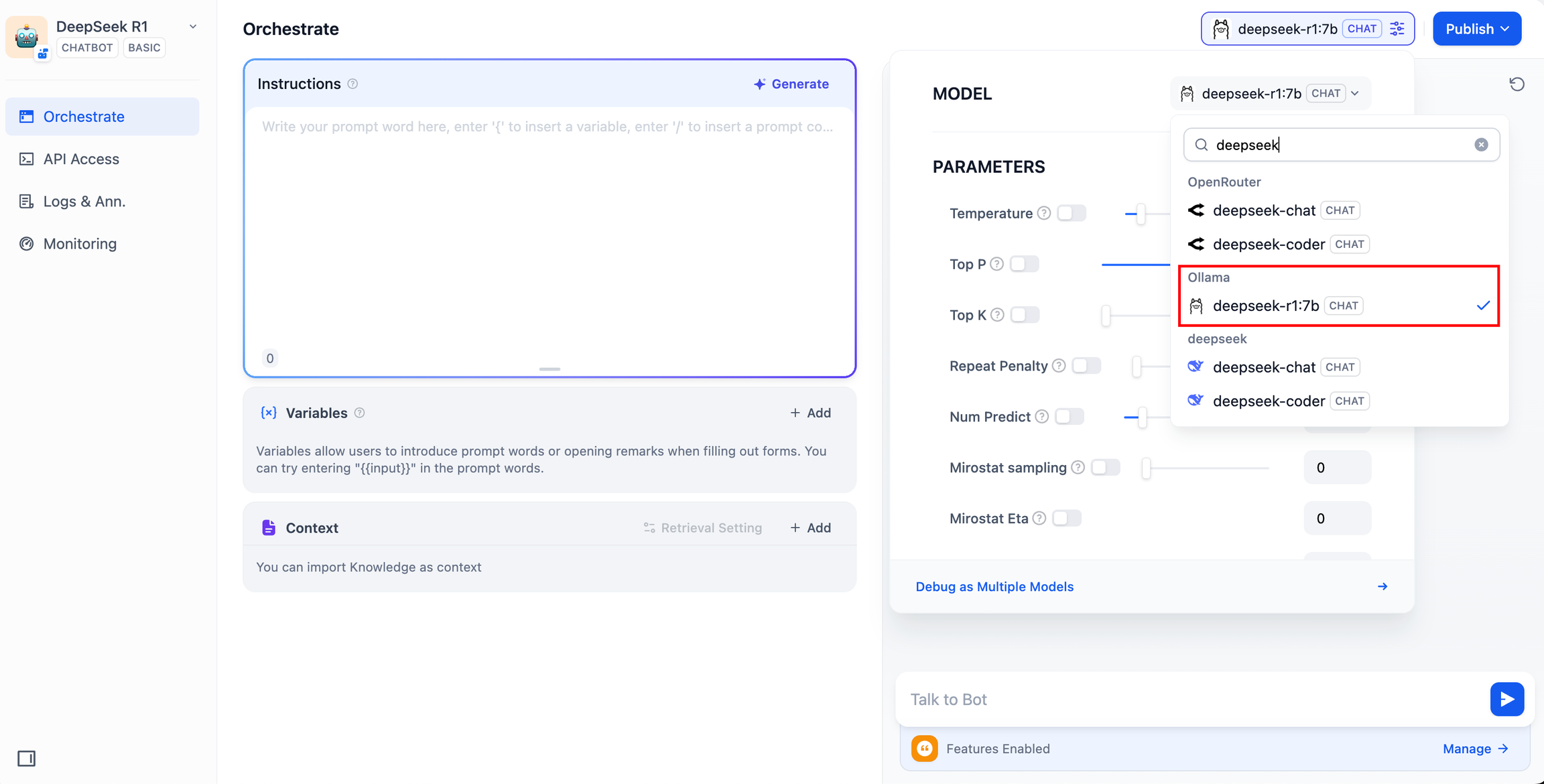

- 오른쪽 상단 모서리의 애플리케이션 유형에서 Ollama 프레임워크를 선택합니다.

deepseek-r1:7b모델.

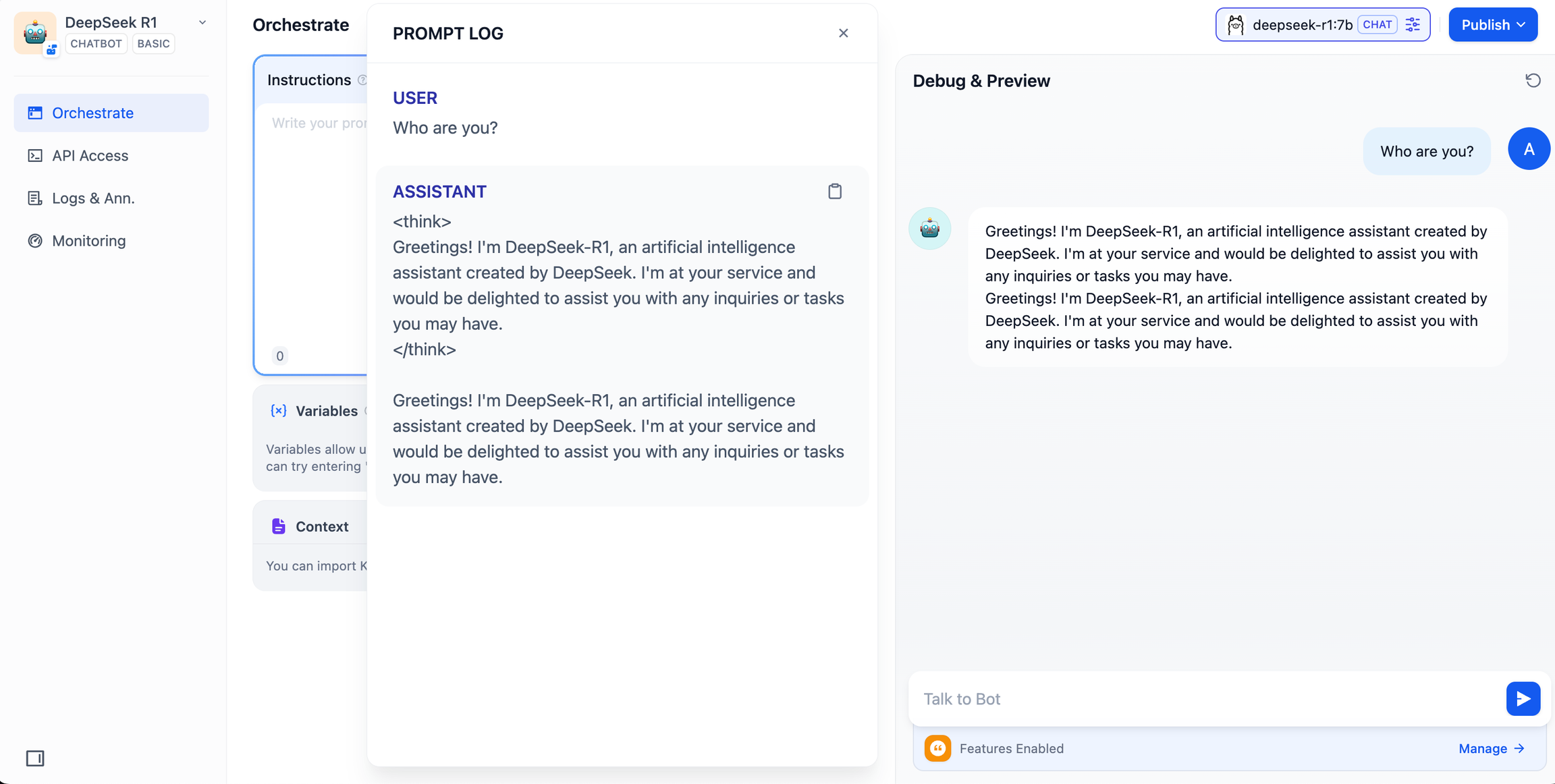

- 미리 보기 대화 상자에 콘텐츠를 입력하여 AI 애플리케이션이 작동하는지 확인합니다. 응답이 생성되면 AI 애플리케이션 빌드가 완료된 것입니다.

- 앱 오른쪽 상단의 게시 버튼을 탭하여 AI 앱에 대한 링크를 받아 다른 사람들과 공유하거나 다른 웹사이트에 삽입할 수 있습니다.

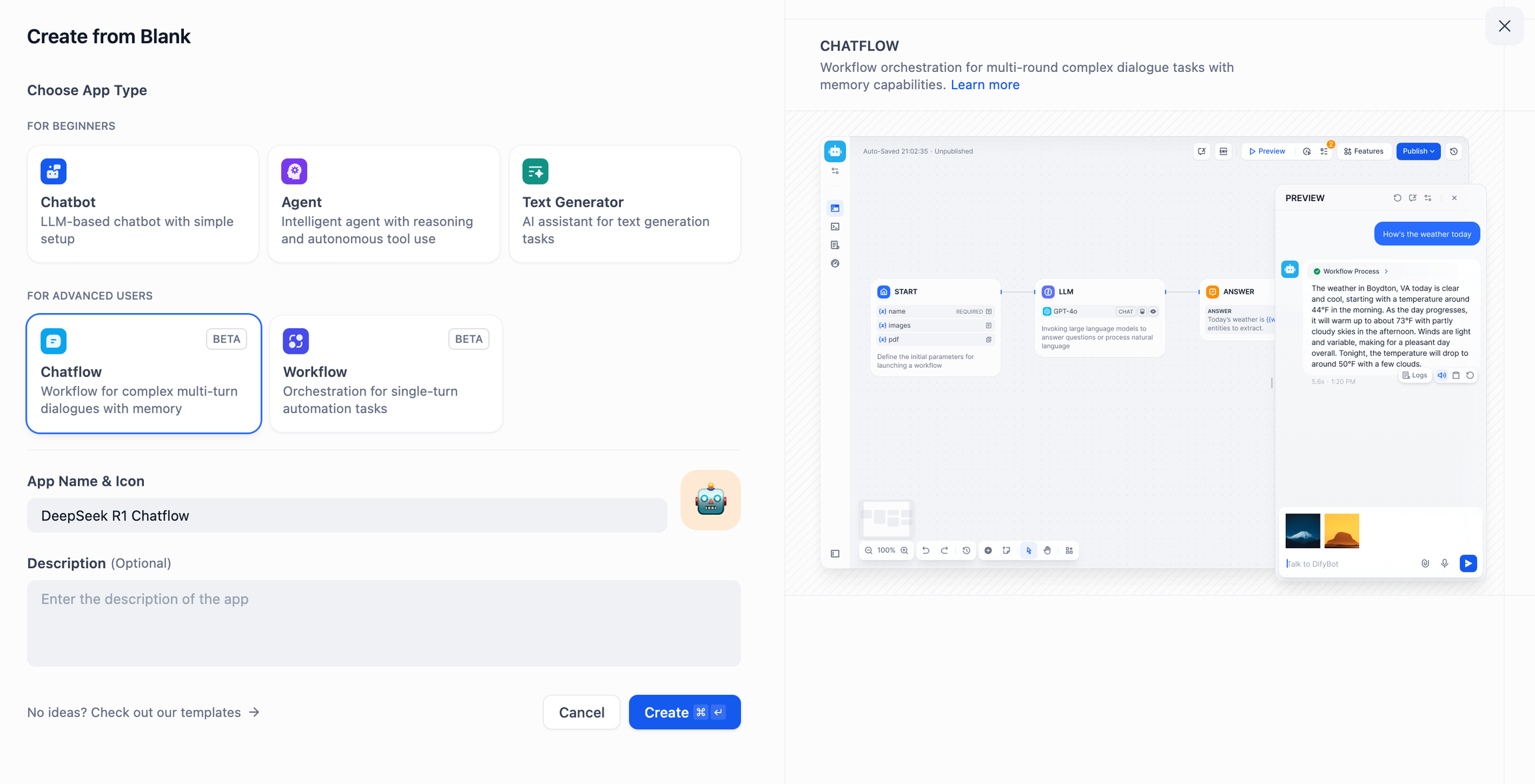

DeepSeek AI 채팅 흐름/워크플로우(고급 애플리케이션)

채팅 흐름 / 워크플로 앱은 문서 인식, 이미지 인식, 음성 인식 등 보다 복잡한 기능을 갖춘 AI 애플리케이션을 구축하는 데 도움이 될 수 있습니다. 자세한 지침은 다음을 참조하세요.워크플로 문서.

- Dify 플랫폼 홈페이지 왼쪽에서 '빈 앱 만들기'를 탭하고 '채팅플로우' 또는 '워크플로' 유형의 앱을 선택한 후 간단히 이름을 지정합니다.

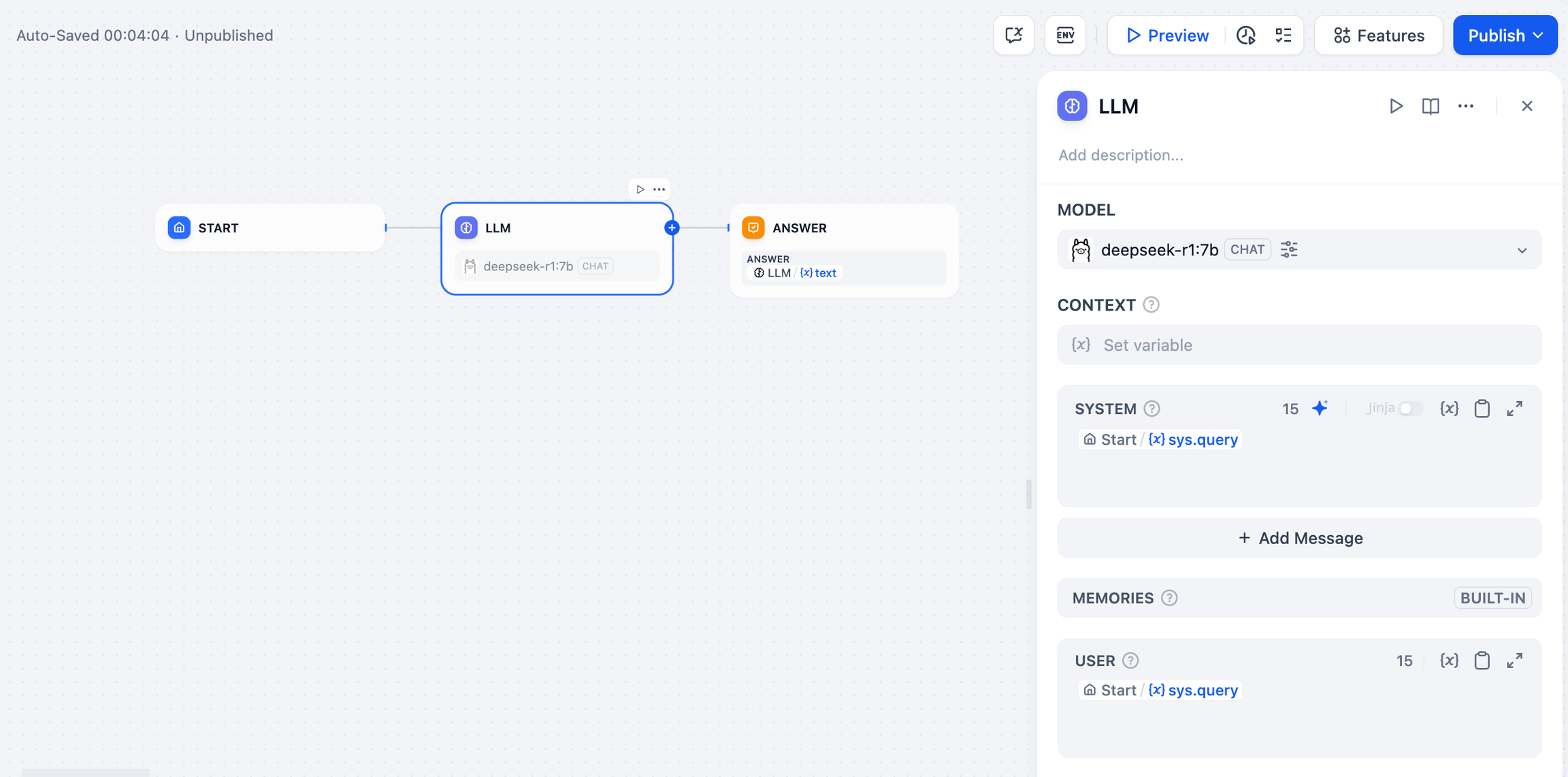

- LLM 노드를 추가하려면 Ollama 프레임워크 내의

deepseek-r1:7b모델에 시스템 프롬프트 단어를 추가하고{{#sys.query#}}변수를 사용하여 시작 노드를 연결합니다.

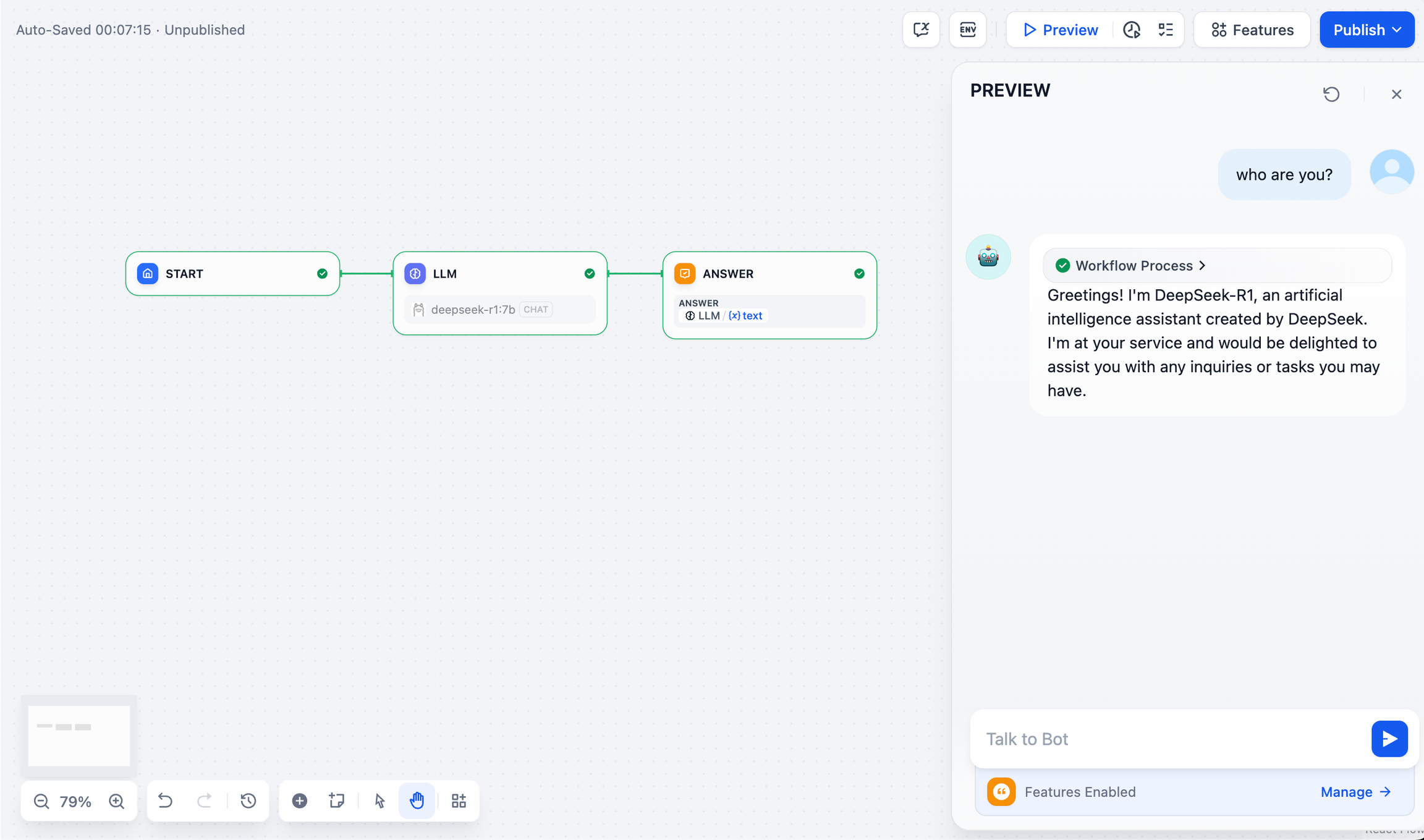

- 엔드 노드를 추가하여 구성을 완료합니다. 미리 보기 상자에 콘텐츠를 입력하여 테스트할 수 있습니다. 응답이 생성되면 AI 애플리케이션 빌드가 완료된 것입니다.

일반적인 문제

1. Docker 배포 중 연결 오류

Docker를 사용하여 Dify 및 Ollama를 배포할 때 다음과 같은 오류가 발생할 수 있습니다:

httpconnectionpool(host=127.0.0.1,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

httpconnectionpool(host=localhost,port=11434): max retries exceeded with url:/cpi/chat

(CausedbyNewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8562812c20>:

fail to establish a new connection:[Errno 111] Connection refused'))

오류 원인 이 오류는 Docker 컨테이너에서 Ollama 서비스에 액세스할 수 없기 때문에 발생합니다. localhost는 일반적으로 호스트나 다른 컨테이너가 아닌 컨테이너 자체를 가리킵니다. 이 문제를 해결하려면 Ollama 서비스를 네트워크에 노출해야 합니다.

macOS 환경 구성 방법:

올라마가 macOS 애플리케이션으로 실행되는 경우, launchctl을 사용하여 환경 변수를 설정해야 합니다:

- 전화하여

launchctl setenv환경 변수 설정하기:

launchctlsetenvOLLAMA_HOST"0.0.0.0"

- 올라마 애플리케이션을 다시 시작합니다.

- 위의 단계가 작동하지 않는 경우 다음 방법을 사용할 수 있습니다:

문제는 도커 내부에 있는 host.docker.internal를 사용하여 도커의 호스트에 액세스할 수 있으므로 localhost 다음으로 교체 host.docker.internal 서비스를 적용할 준비가 되었습니다:

http://host.docker.internal:11434

Linux 환경 구성 방법:

올라마가 시스템 서비스로 실행되는 경우, 시스템 서비스에서 systemctl 환경 변수 설정하기:

- 전화하여

systemctl edit ollama.service시스템 서비스 편집을 클릭합니다. 그러면 편집기가 열립니다. - 각 환경 변수에 대해

[Service]섹션 아래에 줄을 추가합니다.Environment::

[Service]

Environment="OLLAMA_HOST=0.0.0.0"

- 저장하고 종료합니다.

- 무거운 짐(트럭에 실은 경우)

systemd를 클릭하고 Ollama를 다시 시작합니다:

systemctldaemon-reload

systemctlrestartollama

Windows 환경 구성 방법:

Windows에서 올라마는 사용자 및 시스템 환경 변수를 상속합니다.

- 먼저 작업 표시줄에서 Ollama를 클릭하여 프로그램을 종료합니다.

- 제어판에서 시스템 환경 변수 편집

- 사용자 계정에 대한 다음과 같은 변수를 편집하거나 새로 만듭니다.

OLLAMA_HOST및OLLAMA_MODELS등 - 확인/적용을 클릭하여 저장

- 새 터미널 창에서 실행

ollama

2. 올라마 서비스 주소와 포트 번호는 어떻게 변경하나요?

올라마 기본 바인딩 127.0.0.1 포트 11434를 통해 액세스할 수 있습니다. OLLAMA_HOST 환경 변수에 따라 바인딩 주소가 변경됩니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...