일반 소개

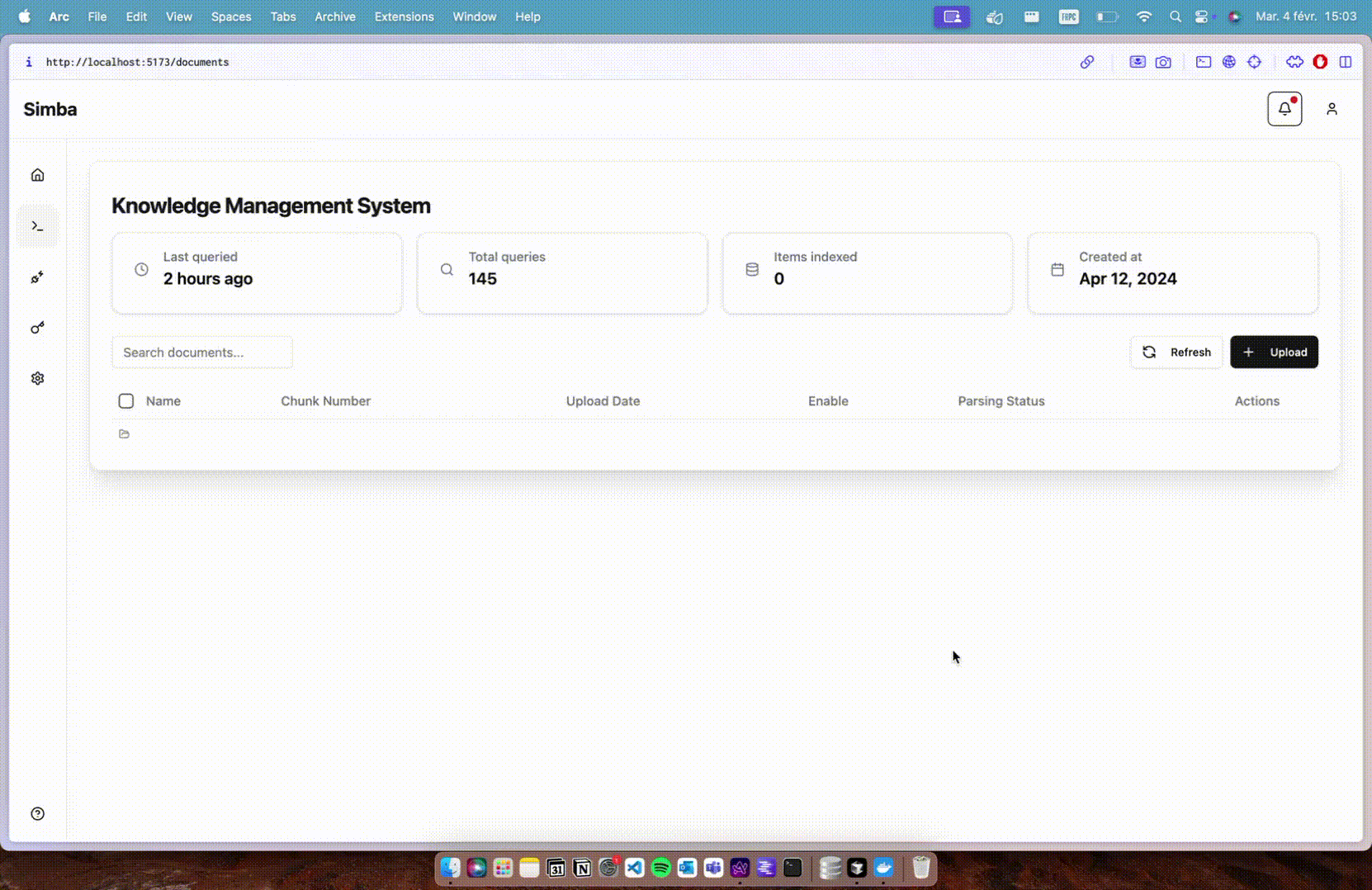

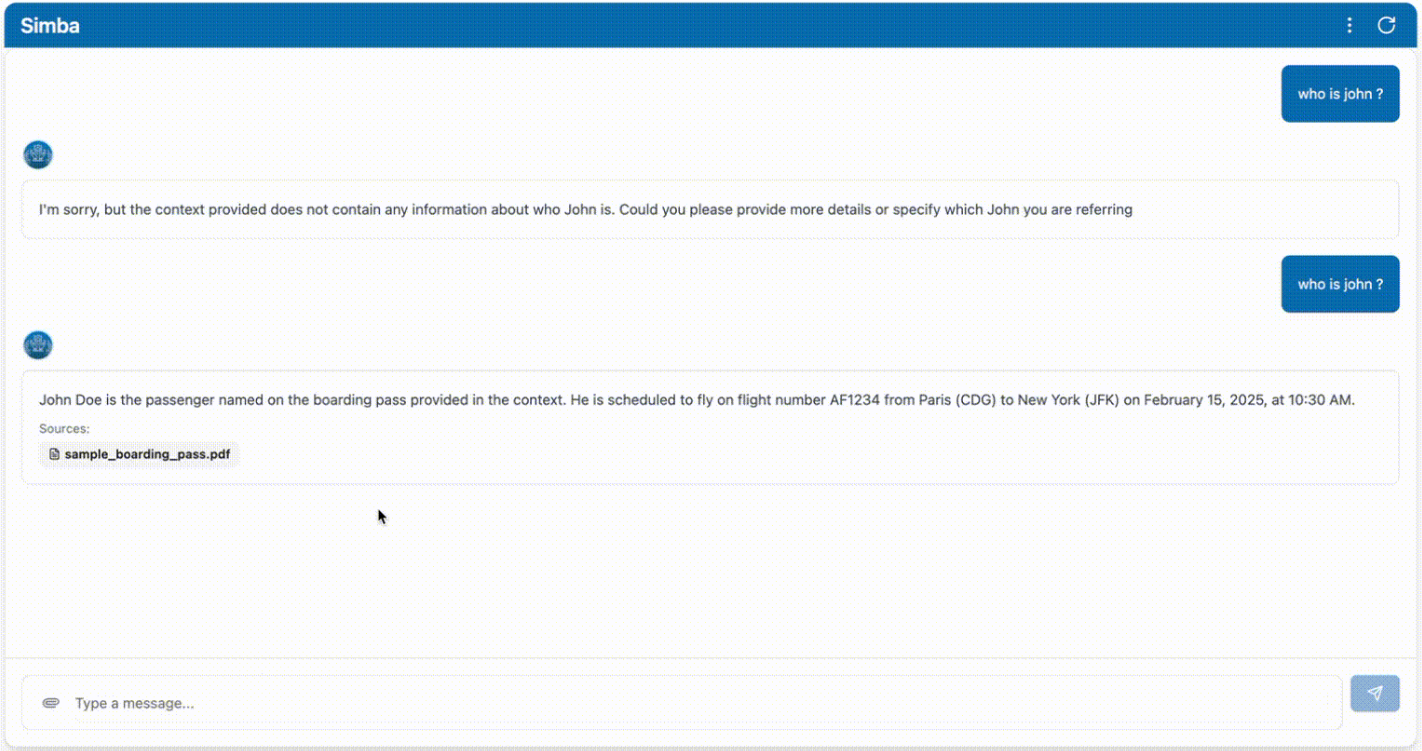

Simba는 모든 검색 증강 생성(RAG) 시스템과 원활하게 통합되도록 설계된 휴대용 지식 관리 시스템(KMS)입니다. GitHub 사용자 GitHamza0206이 만든 이 프로젝트는 다양한 애플리케이션 시나리오를 위한 효율적인 지식 관리 솔루션을 제공하며, 지식 관리 프로세스를 간소화하고 정보 검색 및 생성의 정확성과 효율성을 개선하는 것을 목표로 설계되었습니다. RAG 시스템과의 통합을 통해 Simba는 복잡한 데이터를 처리하고 콘텐츠를 생성하는 데 강력한 지원을 제공할 수 있습니다.

기능 목록

- 지식 관리지식의 저장, 분류 및 검색을 지원하는 포괄적인 지식 관리 기능을 제공합니다.

- RAG 시스템 통합검색 고도화 생성 시스템과의 원활한 통합을 통해 정보 생성의 정확성을 향상시킵니다.

- 휴대성쉽게 배포하고 사용할 수 있는 휴대용 시스템으로 설계되었습니다.

- 오픈 소스 프로젝트오픈 소스 프로젝트이므로 사용자는 소스 코드에 자유롭게 액세스하고 사용자 정의할 수 있습니다.

- 효율적인 검색필요한 지식을 빠르게 찾을 수 있도록 정보 검색을 최적화했습니다.

- 사용자 친화적인 인터페이스: 직관적인 사용자 인터페이스를 제공하여 작업 프로세스를 간소화합니다.

도움말 사용

설치 프로세스

- 클론 창고먼저 Git 명령을 사용하여 Simba 프로젝트의 GitHub 리포지토리를 복제합니다.

git clone https://github.com/GitHamza0206/simba.git

- 종속성 설치프로젝트 디렉토리로 이동하여 필요한 종속성 패키지를 설치합니다.

cd simba

지역 개발

- 백엔드 설정::

- 백엔드 디렉토리로 이동합니다:

cd backend- 운영 체제에 Redis가 설치되어 있는지 확인합니다:

redis-server- 환경 변수 설정하기:

cp .env.example .env그런 다음 .env 파일을 편집하고 값을 입력합니다:

OPENAI_API_KEY="" LANGCHAIN_TRACING_V2= #(optional - for langsmith tracing) LANGCHAIN_API_KEY="" #(optional - for langsmith tracing) REDIS_HOST=redis CELERY_BROKER_URL=redis://redis:6379/0 CELERY_RESULT_BACKEND=redis://redis:6379/1- 종속성을 설치합니다:

poetry install poetry shell또는 Mac/Linux에서:

source .venv/bin/activateWindows에서:

.venv\Scripts\activate- 백엔드 서비스를 실행합니다:

python main.py또는 자동 새로 고침을 사용하세요:

uvicorn main:app --reload그런 다음 다음으로 이동합니다.

http://0.0.0.0:8000/docs스웨거 UI에 액세스(선택 사항).- 셀러리를 사용하여 구문 분석기를 실행합니다:

celery -A tasks.parsing_tasks worker --loglevel=info- 필요에 따라 수정

config.yaml문서화:

project: name: "Simba" version: "1.0.0" api_version: "/api/v1" paths: base_dir: null # Will be set programmatically markdown_dir: "markdown" faiss_index_dir: "vector_stores/faiss_index" vector_store_dir: "vector_stores" llm: provider: "openai" #or ollama (vllm coming soon) model_name: "gpt-4o" #or ollama model name temperature: 0.0 max_tokens: null streaming: true additional_params: {} embedding: provider: "huggingface" #or openai model_name: "BAAI/bge-base-en-v1.5" #or any HF model name device: "cpu" # mps,cuda,cpu additional_params: {} vector_store: provider: "faiss" collection_name: "migi_collection" additional_params: {} chunking: chunk_size: 512 chunk_overlap: 200 retrieval: k: 5 #number of chunks to retrieve features: enable_parsers: true # Set to false to disable parsing celery: broker_url: ${CELERY_BROKER_URL:-redis://redis:6379/0} result_backend: ${CELERY_RESULT_BACKEND:-redis://redis:6379/1} - 프런트엔드 설정::

- Simba 루트 디렉토리에 있는지 확인하세요:

bash

cd frontend - 종속성을 설치합니다:

bash

npm install - 프런트엔드 서비스를 실행합니다:

bash그런 다음 다음으로 이동합니다.

npm run devhttp://localhost:5173프런트엔드 인터페이스에 액세스합니다.

- Simba 루트 디렉토리에 있는지 확인하세요:

Docker로 부팅(권장)

- Simba 루트 디렉토리로 이동합니다:

export OPENAI_API_KEY="" #(optional)

docker-compose up --build

프로젝트 구조

simba/

├── backend/ # 核心处理引擎

│ ├── api/ # FastAPI端点

│ ├── services/ # 文档处理逻辑

│ ├── tasks/ # Celery任务定义

│ └── models/ # Pydantic数据模型

├── frontend/ # 基于React的UI

│ ├── public/ # 静态资源

│ └── src/ # React组件

├── docker-compose.yml # 开发环境

└── docker-compose.prod.yml # 生产环境设置

구성

config.yaml파일은 백엔드 애플리케이션을 구성하는 데 사용됩니다. 다음을 변경할 수 있습니다:

- 모델 임베딩

- 벡터 스토리지

- 청크

- 검색(데이터)

- 기능

- 해결자

자세한 내용은 다음을 참조하세요.backend/README.md.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...