일반 소개

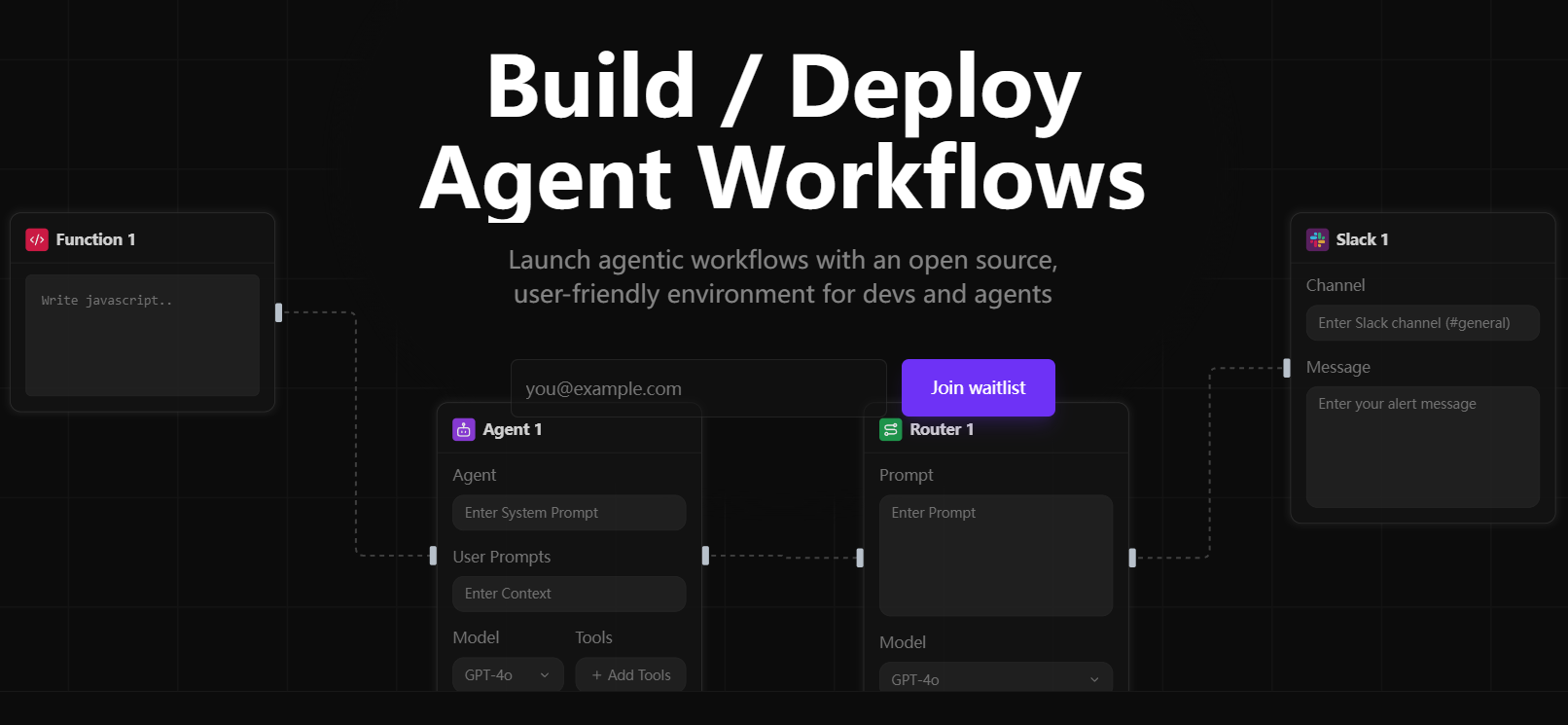

Sim Studio는 가볍고 직관적인 시각적 인터페이스를 통해 사용자가 대규모 언어 모델(LLM) 워크플로를 빠르게 설계, 테스트 및 배포할 수 있도록 지원하는 데 중점을 둔 오픈 소스 AI 에이전트 워크플로 구축 플랫폼입니다. 사용자는 심층적인 프로그래밍 없이 드래그 앤 드롭으로 복잡한 멀티 에이전트 애플리케이션을 만들 수 있습니다. 로컬 및 클라우드 모델을 모두 지원하며 Slack 및 데이터베이스와 같은 다양한 도구 통합과 호환됩니다.Sim Studio는 모듈식으로 설계되어 개발자, 연구원 및 기업 사용자에게 적합합니다. 공식 클라우드 호스팅 버전(https://simstudio.ai)과 자체 호스팅 옵션을 통해 다양한 요구 사항을 충족할 수 있습니다.

요즘 AI 에이전트 프레임워크가 봇물을 이루고 있는데, 특히 Sim Studio를 추천하는 이유는 무엇인가요? 현재 사용 가능한 몇 가지 주요 오픈 소스 AI 에이전트 프레임워크의 기능 목록을 정리해 보았습니다:

| 프레임워크 이름 | 핵심 패러다임 | 주요 이점 | 적용 가능한 시나리오 |

|---|---|---|---|

| LangGraph | 그래프 기반 프롬프트 워크플로 | 명시적 DAG 제어, 브랜칭 및 디버깅 | 복잡한 다단계 작업, 고급 오류 처리 |

| OpenAI 에이전트 SDK | OpenAI 고급 툴체인 | 웹 및 파일 검색과 같은 도구의 통합 | OpenAI 에코시스템에 의존하는 팀 |

| 스몰래그먼트 | 코드 중심의 최소 에이전트 루프 | 간단한 설정, 직접 코드 실행 | 복잡한 절차 없이 신속한 작업 자동화 |

| CrewAI | 멀티 에이전트 협업(승무원) | 공유 메모리를 사용한 역할 기반 병렬 워크플로 | 여러 전문가의 협업이 필요한 복잡한 작업 |

| 자동 생성 | 비동기 멀티 에이전트 채팅 | 실시간 대화, 이벤트 중심 | 실시간 동시 및 멀티-LLM '음성' 상호 작용이 필요한 시나리오 |

| Sim Studio | 비주얼 워크플로 빌더 | 직관적인 인터페이스, 신속한 배포, 오픈 소스 유연성 | 신속한 프로토타이핑 및 프로덕션 환경 배포 |

현재 시중에는 로우코드/노코드 AI 에이전트 구축 플랫폼이 꽤 많이 있으며, Sim Studio와 비교한 목록을 정리해 보았습니다:

| 평지붕 건물 | 특수성 | 적용 가능한 시나리오 | 가격 |

|---|---|---|---|

| 버텍스 AI 빌더 | 복잡한 API를 갖춘 엔터프라이즈급 노코드 플랫폼 | 대규모 엔터프라이즈 워크플로 자동화 | 비용 충당 |

| 빔 AI | 여러 온-프레미스 에이전트를 지원하는 수평적 플랫폼 | 다분야 자동화(규정 준수, 고객 서비스 등) | 비용 충당 |

| Microsoft 기업 부조종사 스튜디오 | 로우 코드, 1200개 이상의 데이터 커넥터 | 내부 챗봇, 주문 관리 | 비용 충당 |

| Lyzr 에이전트 스튜디오 | 모듈식으로 프로토타입 제작에 적합 | 재무, 인사 자동화 | 비용 충당 |

| Sim Studio | 오픈 소스, 시각적 인터페이스, 유연한 배포 | 프로토타입부터 생산까지 전체 프로세스 | 무료 오픈 소스 |

보시다시피, 오픈 소스 프로젝트인 Sim Studio는 기능성과 유연성 측면에서 결코 뒤지지 않으며, 사용 비용에 대한 부담도 없습니다.

기능 목록

- 시각적 워크플로 편집기 조건부 로직 및 다단계 작업을 지원하는 드래그 앤 드롭 인터페이스로 AI 상담원 워크플로우를 설계하세요.

- 다중 모델 지원 클라우드 및 로컬 LLM과 모두 호환 가능 : 예를 들어 Ollama 로컬 모델 실행.

- 도구 통합 Slack, 데이터베이스 및 확장 프록시 기능과 같은 외부 도구에 대한 연결 지원.

- API 배포 클릭 한 번으로 워크플로 API를 생성하여 다른 시스템과 쉽게 통합할 수 있습니다.

- 로컬 배포 개인 정보 보호에 민감한 시나리오의 경우 도커를 통해 또는 수동으로 셀프 호스팅을 지원합니다.

- 모듈식 확장 기능 기능 블록과 도구를 사용자 지정할 수 있어 유연성이 향상됩니다.

- 로깅 및 디버깅 워크플로 최적화 및 오류 문제 해결을 위한 자세한 로그를 제공합니다.

- 개발 컨테이너 지원 VS Code 개발 컨테이너로 로컬 개발 환경 설정을 간소화하세요.

도움말 사용

Sim Studio의 핵심은 가볍고 직관적인 워크플로 구축 기능입니다. 다음은 사용자가 빠르게 시작할 수 있도록 설치 과정, 주요 기능의 작동 및 특수 기능 사용 방법에 대한 자세한 설명입니다.

설치 프로세스

Sim Studio는 Docker(권장), 개발 컨테이너, 수동 설치의 세 가지 셀프 호스팅 옵션을 제공합니다. 다음은 주로 Docker와 수동 설치이며, 개발 컨테이너는 VS 코드에 익숙한 개발자에게 적합합니다.

방법 1: 도커 설치(권장)

Docker는 대부분의 사용자에게 적합한 일관된 런타임 환경을 제공합니다. Docker 및 Docker Compose를 먼저 설치해야 합니다.

- 코드 베이스 복제

터미널에서 실행됩니다:git clone https://github.com/simstudioai/sim.git cd sim

- 환경 변수 구성

환경 파일을 복사하여 편집합니다:cp sim/.env.example sim/.env

를 .env 파일에 구성합니다:

- BETTER_AUTH_SECRET: 인증을 위한 임의의 키를 생성합니다.

- RESEND_API_KEY: 사서함 인증에 사용되며, 설정하지 않으면 인증 코드가 콘솔에 출력됩니다.

- 데이터베이스 설정: 기본적으로 PostgreSQL이 사용되므로 데이터베이스 서비스가 실행 중인지 확인해야 합니다.

- OLLAMA_HOST: 로컬 모델을 사용하는 경우 http://host.docker.internal:11434 로 설정합니다.

- 서비스 시작

다음 명령을 실행합니다:docker compose up -d --build

또는 스크립트를 사용합니다:

./start_simstudio_docker.sh

서비스가 시작되면 http://localhost:3000/w/ 을 방문하여 워크플로 인터페이스에 액세스합니다.

- 관리 서비스

- 로그 보기:

docker compose logs -f simstudio

- 서비스 중단:

docker compose down

- 서비스를 다시 시작합니다(코드 업데이트 후):

docker compose up -d --build

- 로그 보기:

- 로컬 모델 사용

로컬 LLM이 필요한 경우(예: LLaMA) 모델을 가져옵니다:./sim/scripts/ollama_docker.sh pull <model_name>

로컬 모델을 지원하는 서비스를 시작하세요:

./start_simstudio_docker.sh --local

또는 하드웨어에 따라 선택하세요:

# 有 NVIDIA GPU docker compose up --profile local-gpu -d --build # 无 GPU docker compose up --profile local-cpu -d --build

이미 Ollama 인스턴스가 있는 경우 docker-compose.yml을 수정하여 추가합니다:

extra_hosts: - "host.docker.internal:host-gateway" environment: - OLLAMA_HOST=http://host.docker.internal:11434

모드 2: 수동 설치

Node.js, npm 및 PostgreSQL이 설치된 사용자 정의 환경이 필요한 개발자용입니다.

- 종속성 복제 및 설치

git clone https://github.com/simstudioai/sim.git cd sim/sim npm install

- 구성 환경

환경 파일을 복사하여 편집합니다:cp .env.example .env

BETTER_AUTH_SECRET, 데이터베이스 연결 등을 구성합니다.

- 데이터베이스 초기화하기

푸시 데이터베이스 아키텍처:npx drizzle-kit push

- 개발 서버 시작

npm run dev

http://localhost:3000 방문하기.

접근 방식 3: 컨테이너 개발

- VS Code에서 원격 - 컨테이너 확장 프로그램을 설치합니다.

- 프로젝트 디렉토리를 열고 "컨테이너에서 다시 열기"를 클릭합니다.

- npm run dev 또는 sim-start를 실행하여 서비스를 시작합니다.

주요 기능

Sim Studio의 핵심은 아래에 설명된 시각적 워크플로 편집기입니다:

워크플로 만들기

- Sim Studio(http://localhost:3000/w/)에 로그인합니다.

- '새 워크플로'를 클릭하여 편집기로 들어갑니다.

- 에이전트 노드를 드래그 앤 드롭하고 LLM(클라우드 또는 로컬 모델)을 선택합니다.

- 도구 노드(예: Slack 또는 데이터베이스)를 추가하고 매개변수를 구성합니다.

- 조건부 논리 노드를 사용하여 분기 논리를 설정합니다.

- 노드를 연결하고 워크플로를 저장하세요.

테스트 워크플로

- '테스트'를 클릭하고 예제 데이터를 입력합니다.

- 출력 및 로그를 보고 노드 실행을 확인합니다.

- 필요에 따라 노드 또는 로직을 조정하고 다시 테스트하세요.

배포 워크플로

- 배포를 클릭하고 API 생성을 선택합니다.

- API 엔드포인트를 가져옵니다(예: http://localhost:3000/api/workflow/).

- API를 테스트합니다:

curl -X POST http://localhost:3000/api/workflow/<id> -d '{"input": "示例数据"}'

워크플로 디버깅

- 에디터에서 '로그'를 확인하여 노드 입력 및 출력을 확인하세요.

- 버전 관리를 사용하여 워크플로 스냅샷을 저장하여 쉽게 롤백할 수 있습니다.

주요 기능 작동

- 로컬 모델 지원 Ollama를 통해 로컬 모델을 실행하는 것은 개인정보 보호에 민감한 시나리오에 적합합니다. 구성 후 에이전트 노드에서 모델을 선택하고 성능을 테스트하세요.

- 도구 통합 Slack을 예로 들어 도구 노드에 API 토큰을 입력하고 메시지 대상을 설정한 후 메시지 전송 기능을 테스트해 보세요.

- 개발 컨테이너 빠른 반복을 위한 자동 환경 구성과 함께 VS 코드를 통한 컨테이너화된 개발.

주의

- 도커를 설치하는 경우 포트 3000이 사용되지 않는지 확인해야 합니다.

- 로컬 모델에는 높은 하드웨어 구성이 필요합니다(16GB RAM 권장, GPU 옵션).

- 프로덕션 환경은 RESEND_API_KEY 및 HTTPS를 사용하여 구성해야 합니다.

- 정기적으로 코드를 업데이트하세요:

git pull origin main docker compose up -d --build

기술 스택

Sim Studio는 최신 기술 스택을 사용하여 성능과 개발 효율성을 보장합니다:

- 무화과 패턴 : Next.js(앱 라우터)

- 포괄적인 데이터베이스 : PostgreSQL + Drizzle ORM

- 인증 : 더 나은 인증

- 인터페이스 : Shadcn, Tailwind CSS

- 상태 관리 : Zustand

- 프로세스 편집기 : ReactFlow

- (컴퓨터) 파일 : 후마독스

애플리케이션 시나리오

- 자동화된 고객 서비스

전자상거래 플랫폼에 적합한 멀티 에이전트 워크플로우를 설계하고, 데이터베이스와 Slack을 통합하고, 고객 질문에 대한 응답을 자동화하고, 인간 고객 서비스 담당자에게 알림을 보내세요. - 데이터 분석

데이터베이스에서 데이터를 추출하고, LLM을 호출하여 보고서를 생성하고, 재무 분석에 적합한 API로 배포하는 워크플로우를 구축하세요. - 교육 도구

대화형 학습 에이전트를 만들고, 로컬 모델을 결합하여 질문에 답하고, 온라인 교육을 위한 시험 문제 생성 도구를 통합합니다.

QA

- Sim Studio는 Windows를 지원하나요?

Windows도 지원되지만 일관된 환경을 보장하기 위해 Docker Desktop 또는 Node.js가 필요합니다. - 기존 올라마 인스턴스에 연결하려면 어떻게 하나요?

docker-compose.yml을 수정하고, host.docker.internal 매핑을 추가하고, OLLAMA_HOST를 설정합니다. - 로컬 모델에는 어떤 하드웨어가 필요하나요?

16GB RAM 권장, 성능 향상을 위한 GPU, 저사양 기기에서는 느리게 실행될 수 있습니다. - 코드 기여는 어떻게 하나요?

https://github.com/simstudioai/sim/blob/main/.github/CONTRIBUTING.md 을 참조하세요.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...