일반 소개

실리콘클라우드는 우수한 오픈소스 기반 모델을 기반으로 비용 효율적인 GenAI 서비스를 제공합니다.

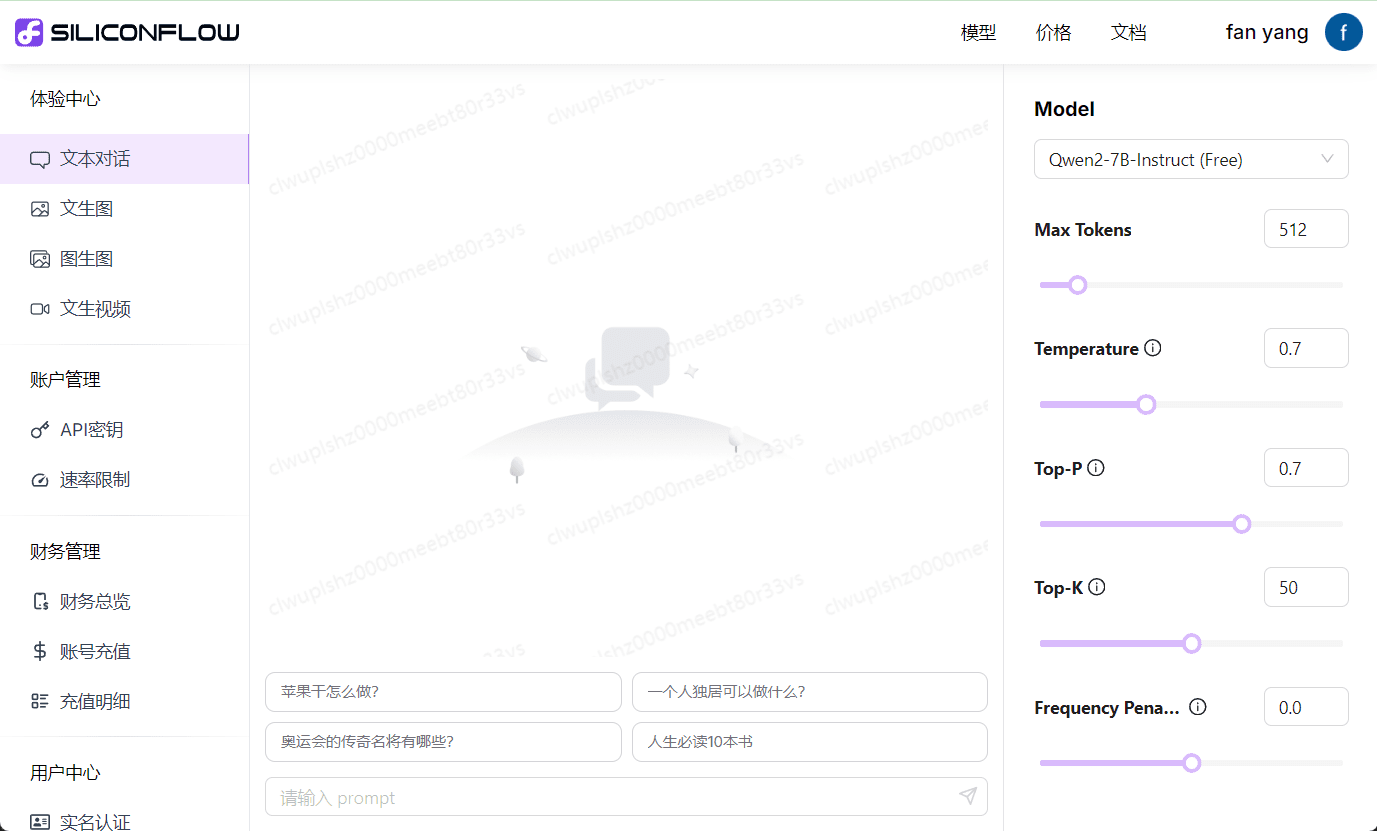

대부분의 빅 모델 클라우드 서비스 플랫폼이 자체 빅 모델 API만 제공하는 것과 달리 SiliconCloud는 Qwen, DeepSeek, GLM, Yi, Mistral, LLaMA 3, SDXL, InstantID 등 다양한 오픈 소스 빅 언어 모델과 이미지 생성 모델을 보유하고 있어 사용자가 다양한 애플리케이션 시나리오에 적합한 모델 간에 자유롭게 전환할 수 있습니다. 사용자는 다양한 애플리케이션 시나리오에 적합한 모델을 자유롭게 전환할 수 있습니다.

또한, 실리콘클라우드는 즉시 사용 가능한 대규모 모델 추론 가속화 서비스를 제공하여 GenAI 애플리케이션에 보다 효율적인 사용자 경험을 제공합니다.

개발자를 위해 SiliconCloud는 최고의 오픈 소스 모델에 원클릭으로 액세스할 수 있는 기능을 제공합니다. 이를 통해 개발자는 애플리케이션 개발 속도와 경험을 개선하는 동시에 애플리케이션 개발의 시행착오 비용을 크게 줄일 수 있습니다.

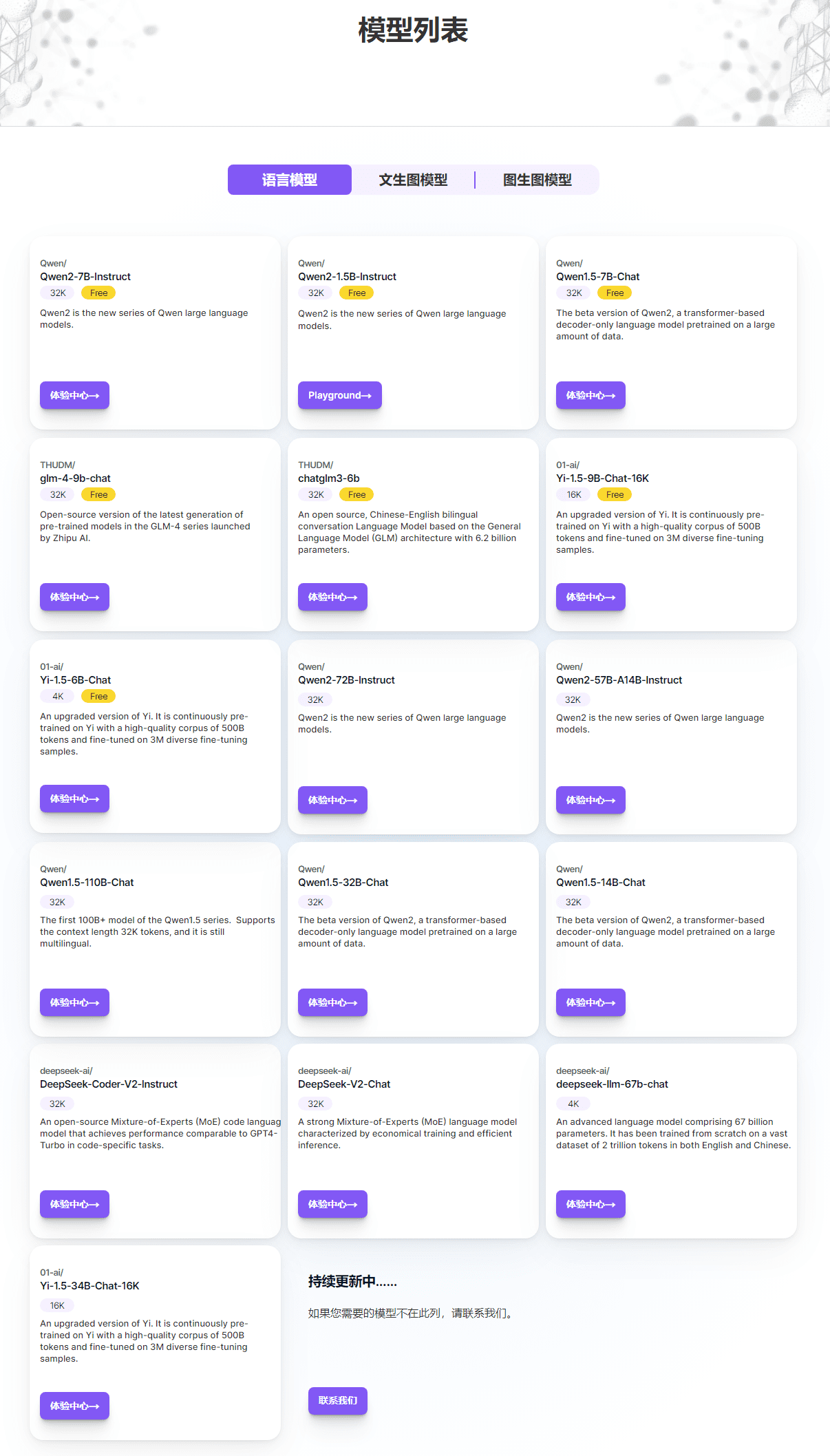

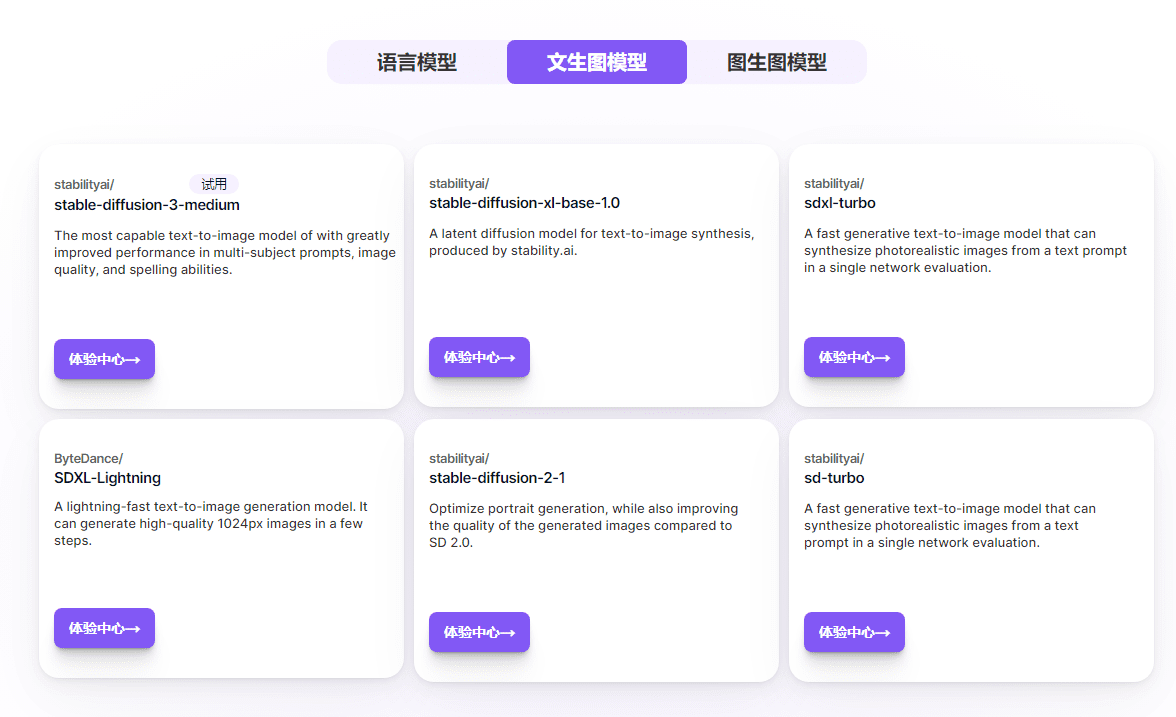

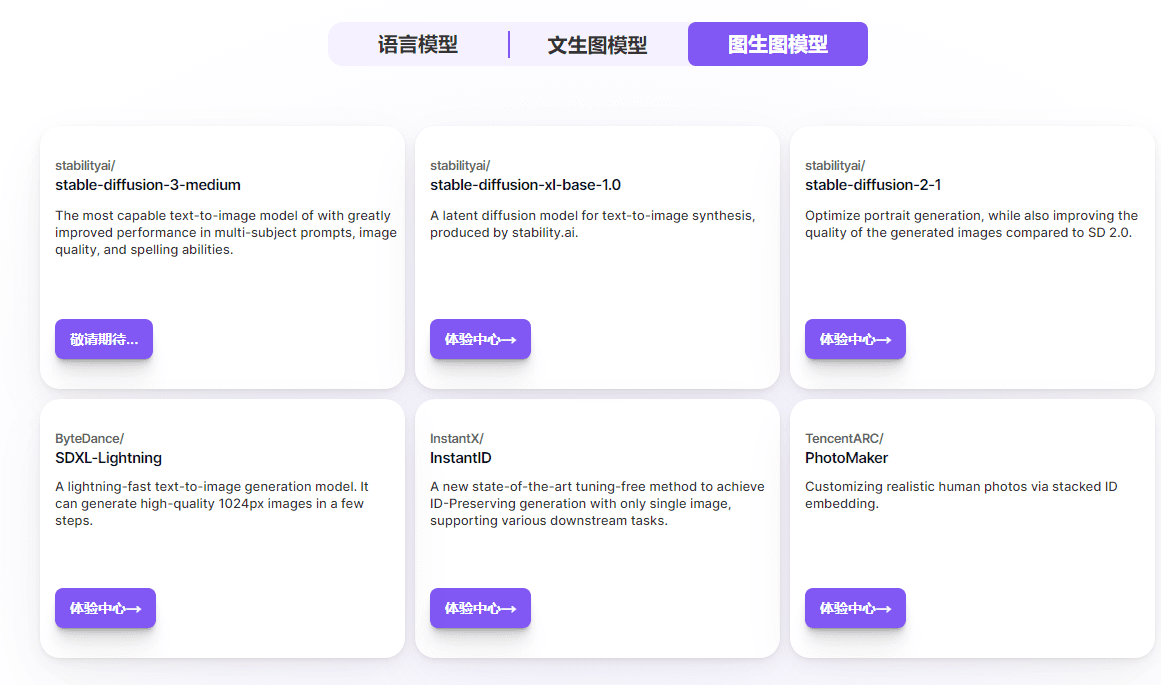

실리콘클라우드 모델 페이지에서 현재 지원되는 언어 모델, 텍스트-그래프 모델, 그래프-그래프 모델을 확인하고 '체험 센터'를 클릭하여 실제로 모델을 사용해 테스트할 수 있습니다.

모델 목록

무료 모델 목록

| Qwen/Qwen2-7B-Instruct | 32K |

|---|---|

| Qwen/Qwen2-1.5B-Instruct | 32K |

| Qwen/Qwen1.5-7B-Chat | 32K |

| THUDM/GLM-4-9B-채팅 | 32K |

| THUDM/chatglm3-6b | 32K |

| 01-ai/Yi-1.5-9B-Chat-16K | 16K |

| 01-ai/Yi-1.5-6B-Chat | 4K |

| 구글/gemma-2-9b-it | 8K |

| internlm/internlm2_5-7b-chat | 32K |

| 메타-라마/메타-라마-3-8B-인스트럭트 | 8K |

| 메타-라마/메타-라마-3.1-8B-인스트럭트 | 8K |

| 미스트랄라이/Mistral-7B-Instruct-v0.2 | 32K |

실리콘클라우드 API 사용

기본 URL: https://api.siliconflow.cn/v1

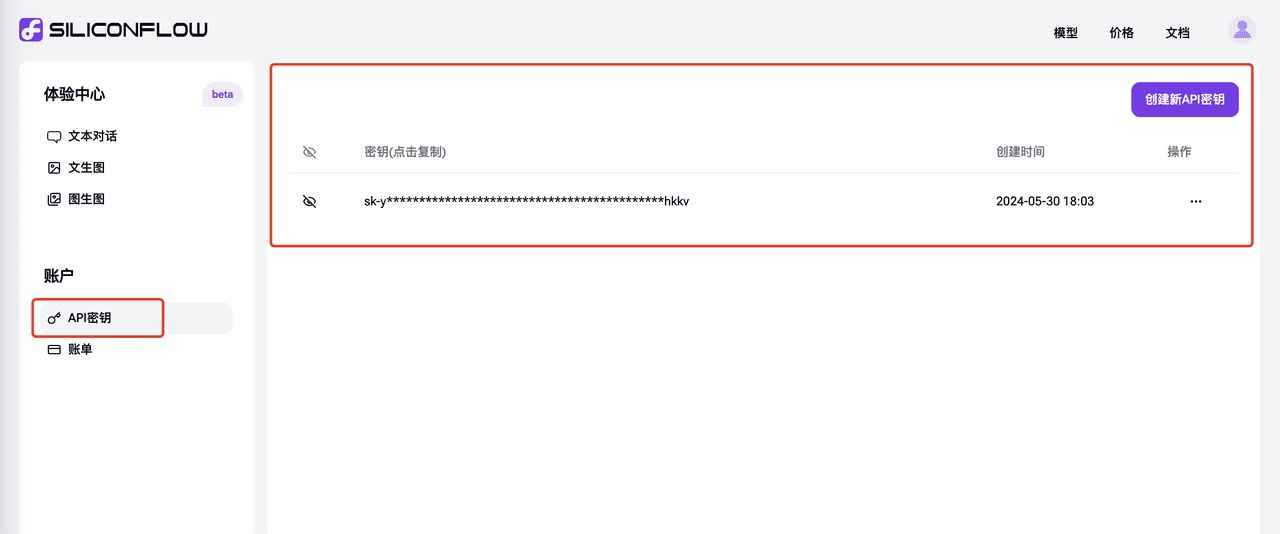

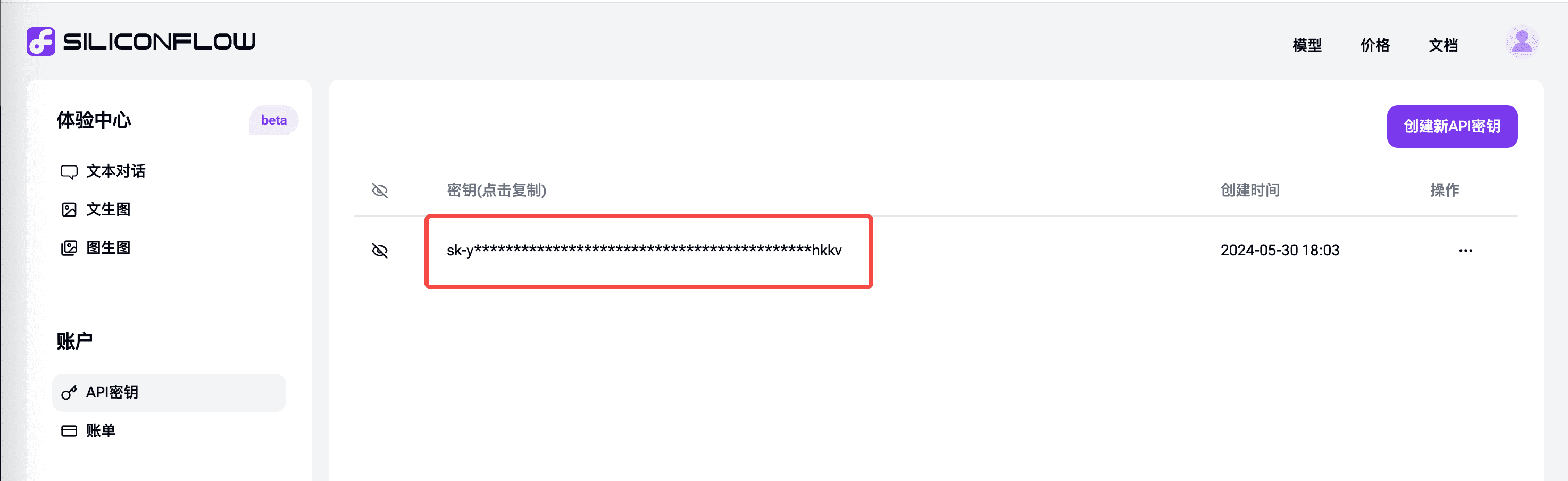

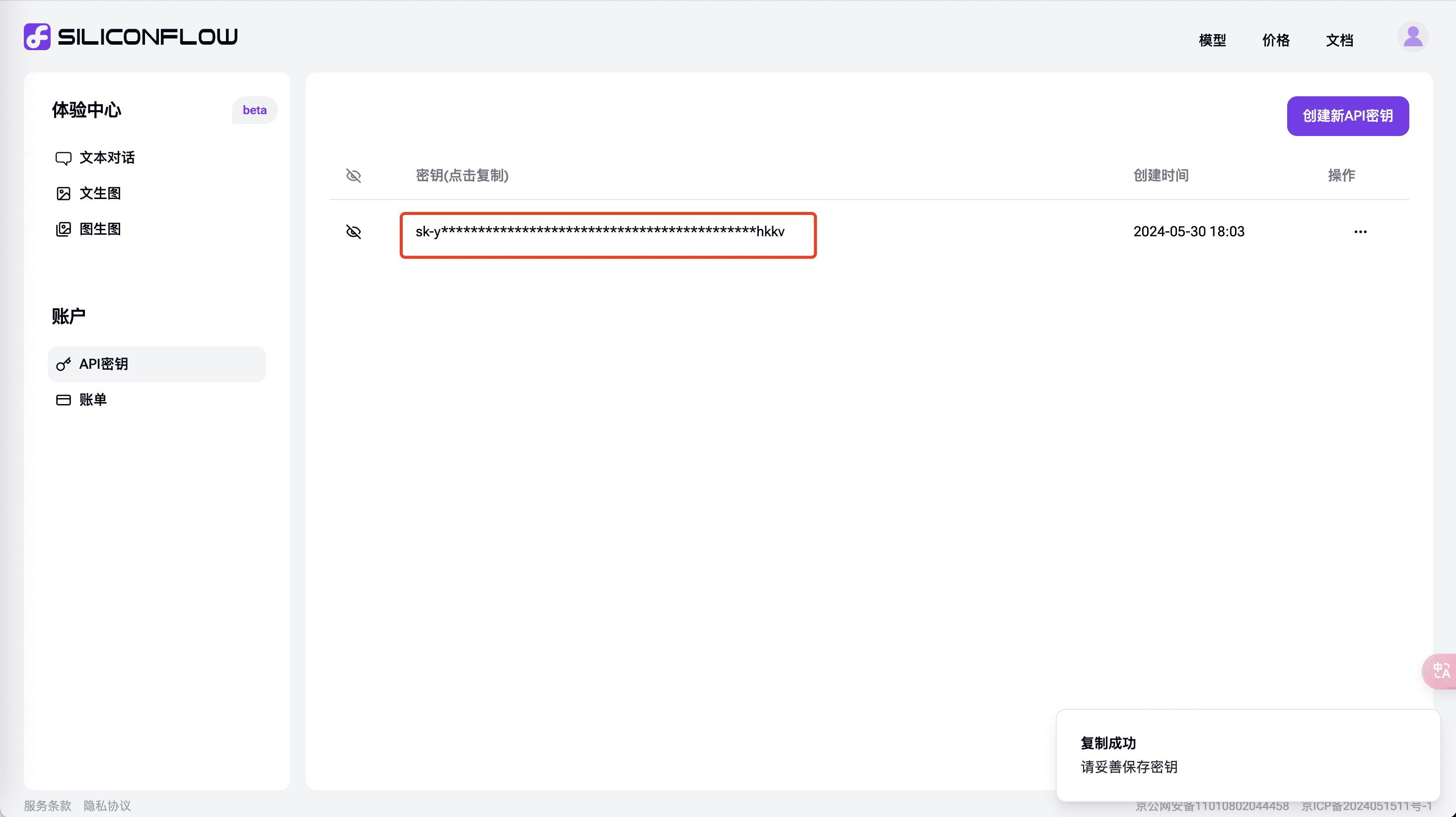

API 키 생성

"API 키" 탭에서 새 API 키 만들기를 클릭하고 복사를 클릭하여 API 시나리오에서 사용합니다.

몰입형 번역에서 SiliconCloud API 사용

실리콘클라우드의 API 기능을 사용하여 몰입형 번역에서 빠른 다국어 번역을 달성하세요.

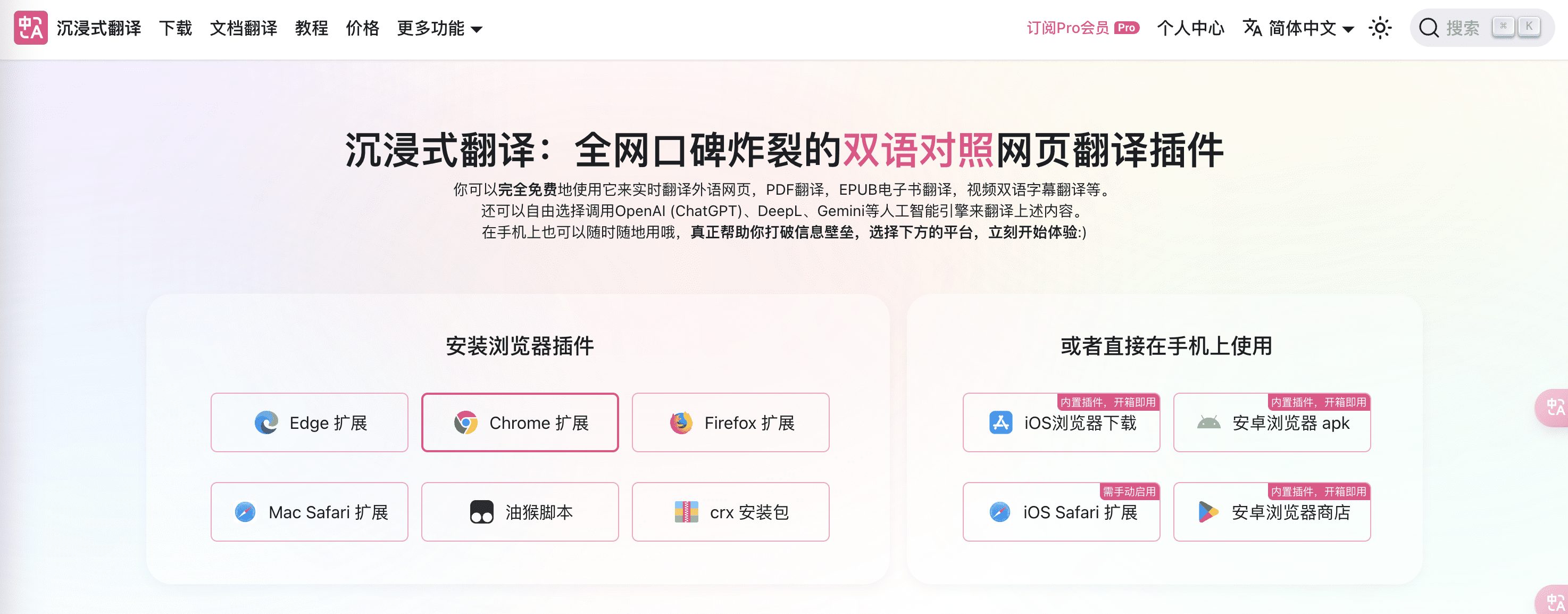

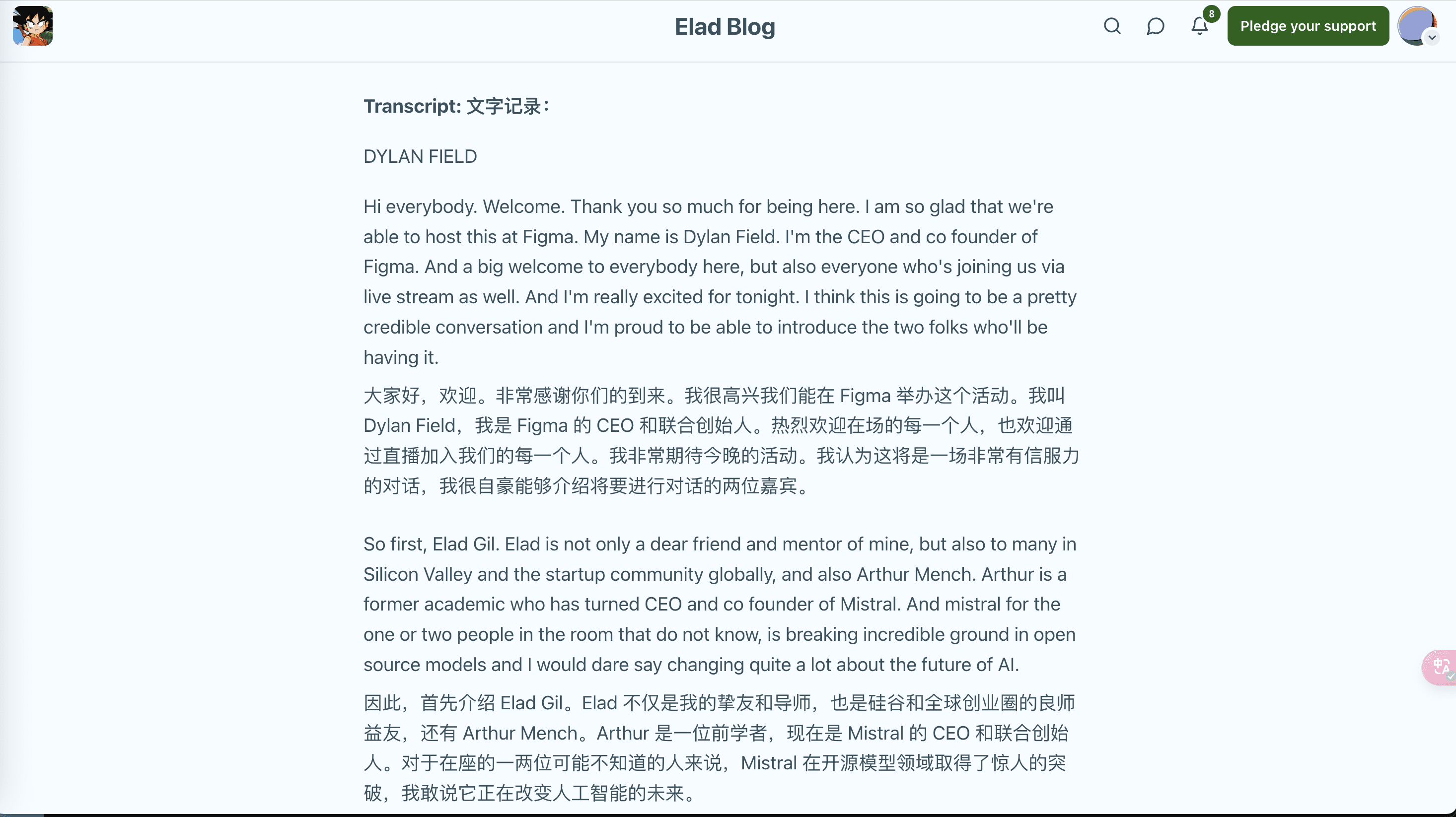

온라인에서 폭발적인 평판을 얻고 있는 이중 언어 웹페이지 번역 플러그인인 몰입 번역은 빅 언어 모델의 다국어 이해 기능을 결합하여 웹페이지 읽기, PDF 번역, EPUB 전자책 번역, 동영상 이중 언어 자막 번역 및 기타 시나리오에 적용할 수 있는 외국어 콘텐츠를 실시간으로 번역하며 다양한 브라우저 플러그인 및 앱의 사용을 지원합니다. 2023년 출시 이후 호평을 받고 있는 이 AI 이중 언어 웹페이지 번역 확장 프로그램은 100만 명 이상의 사용자가 언어의 장벽을 넘어 자유롭게 글로벌 지혜를 이끌어내는 데 도움을 주었습니다.

실리콘플로우의 실리콘클라우드는 최근 GLM4, 큐웬2, 딥시크 V2, 이 등 일련의 대형 모델을 최초로 제공하고 있으며, 그 모델들은 매우 빠릅니다. 이 두 가지를 결합하여 몰입형 번역 시나리오의 기능을 향상시킬 수 있는 방법은 무엇일까요?

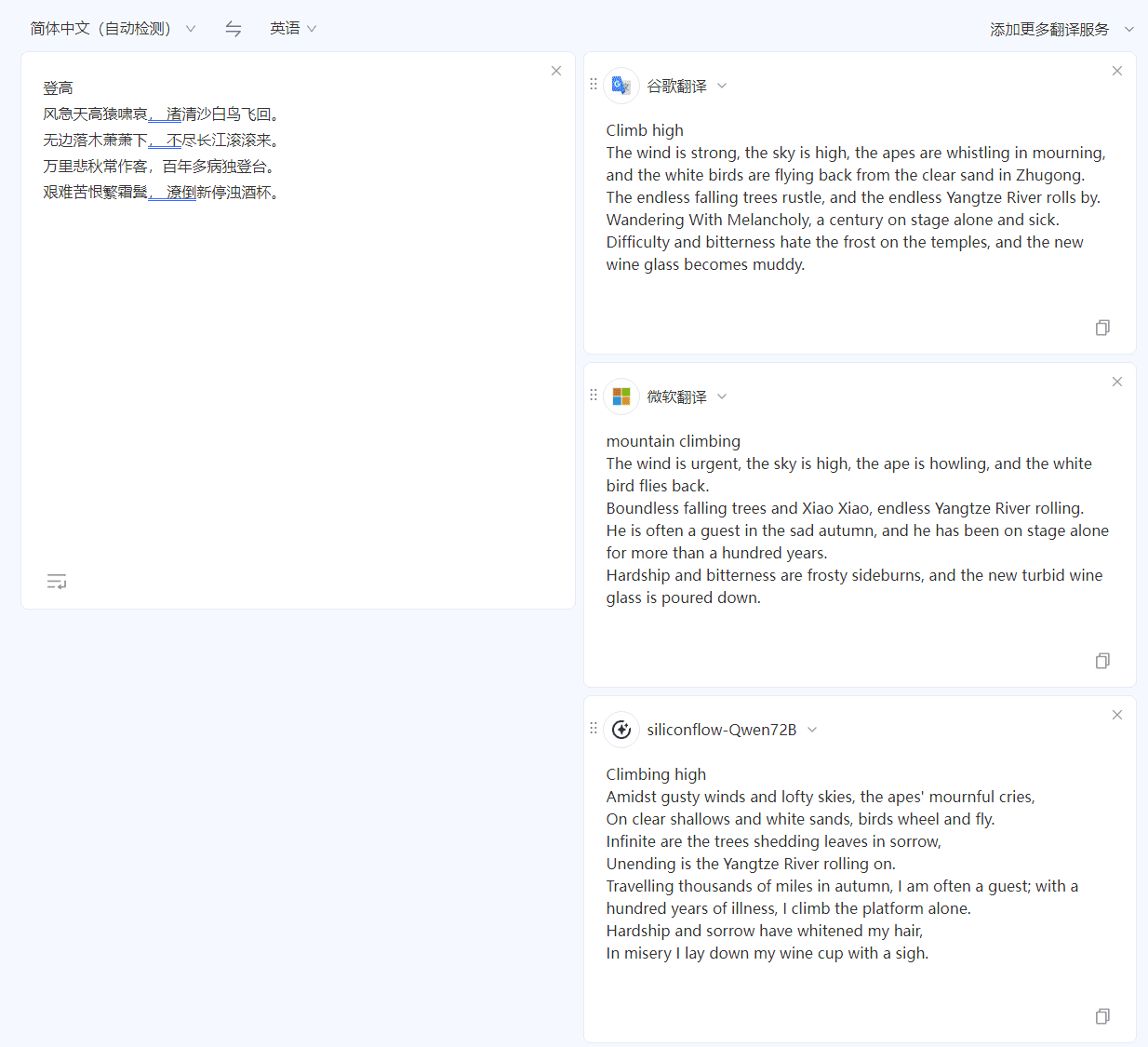

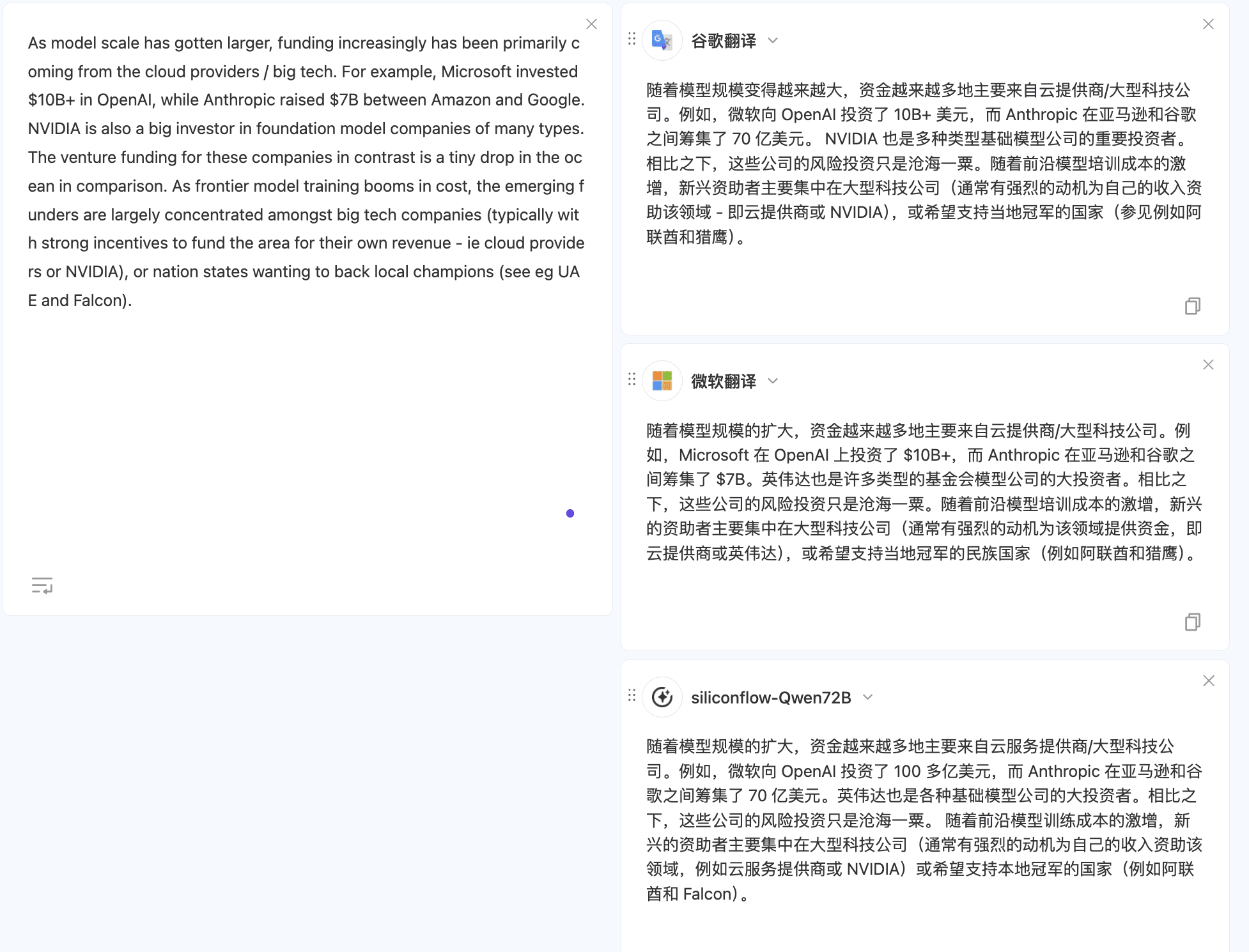

먼저 치료의 효능을 살펴보세요.

익숙한 중국어-영어 번역을 예로 들어 보겠습니다. '중국어에서 영어로' 테스트에 두 푸의 고전 '승천'을 사용한 결과, 구글 번역과 마이크로소프트 번역에 비해 실리콘 모빌리티에서 제공하는 QWen 72B 모델은 중국어를 더 사실적으로 이해하고 번역도 원문의 스타일에 더 가깝습니다.

실리콘 모빌리티에서 제공하는 모델은 동일한 텍스트를 영어에서 중국어로 번역할 때도 더 나은 결과를 제공하며 번역이 더 부드럽습니다.

다른 시나리오를 시도하려면 다음을 사용하면 됩니다.번역 문서 다중 모델 비교 실리콘클라우드 관련 모델의 구성은 "구성 절차" 섹션에 자세히 설명되어 있습니다.

구성 절차: 기본 구성

- 몰입형 번역 웹사이트에서 "브라우저 플러그인 설치"를 선택하고 지침을 따릅니다. 해당 플러그인을 이미 설치한 경우 이 단계를 건너뛰세요.

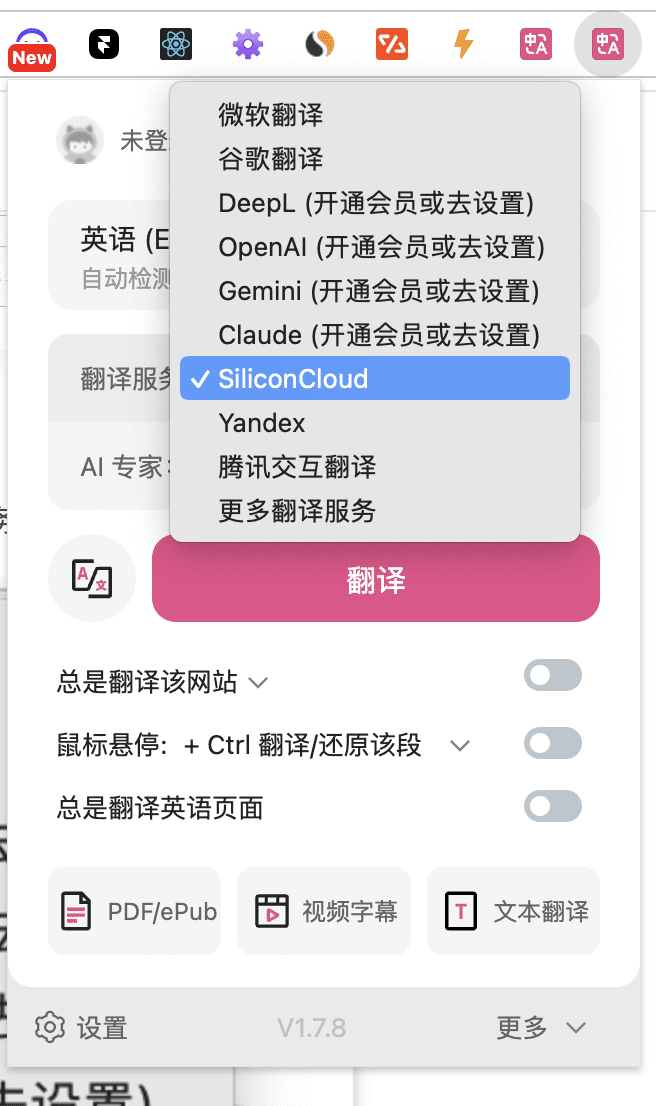

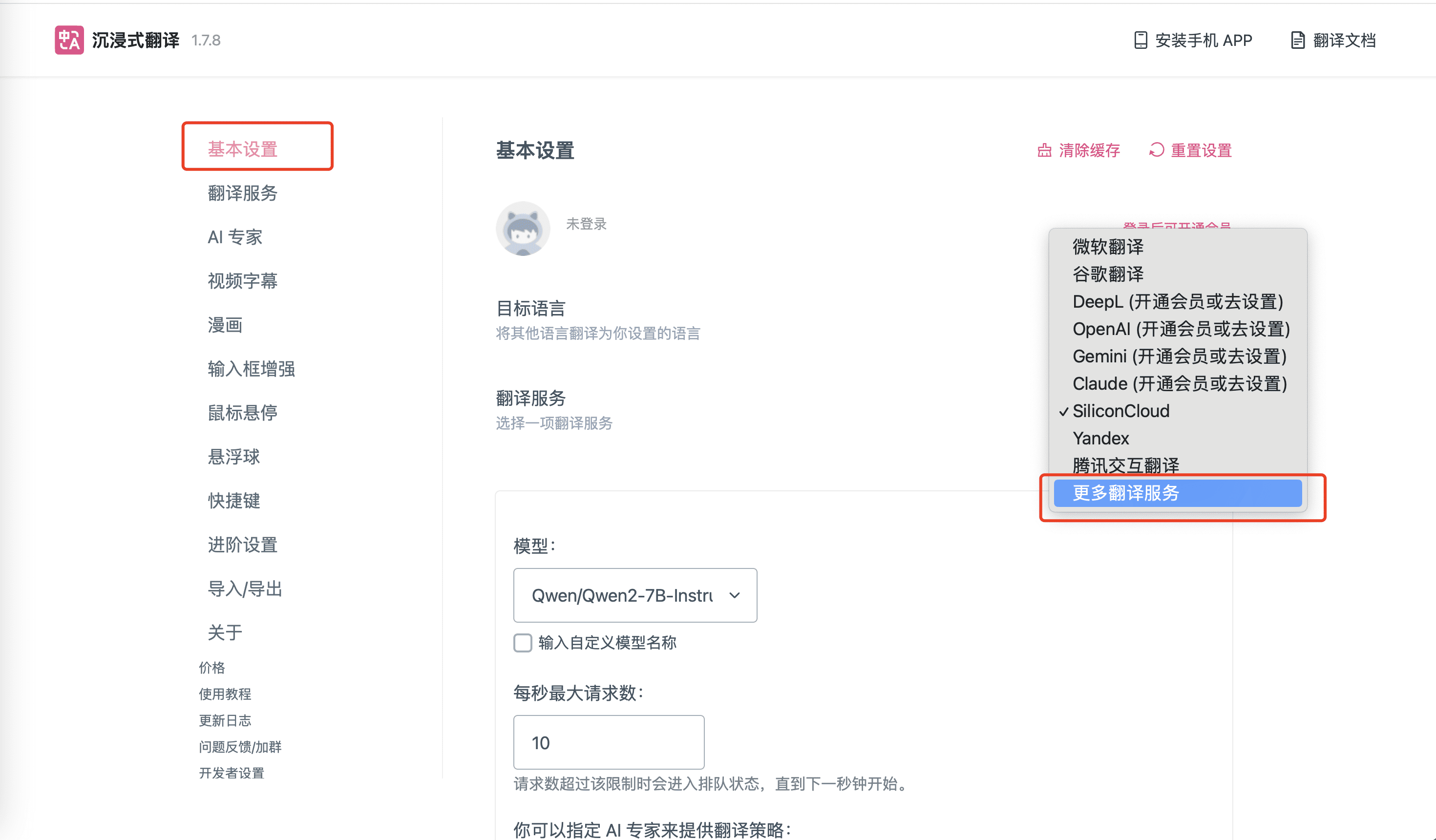

- 몰입형 번역 아이콘에서 '번역 서비스'를 '실리콘클라우드'로 설정하면 실리콘클라우드의 번역 서비스를 사용할 수 있습니다.

이상으로 기본 설정이 완료되었습니다.

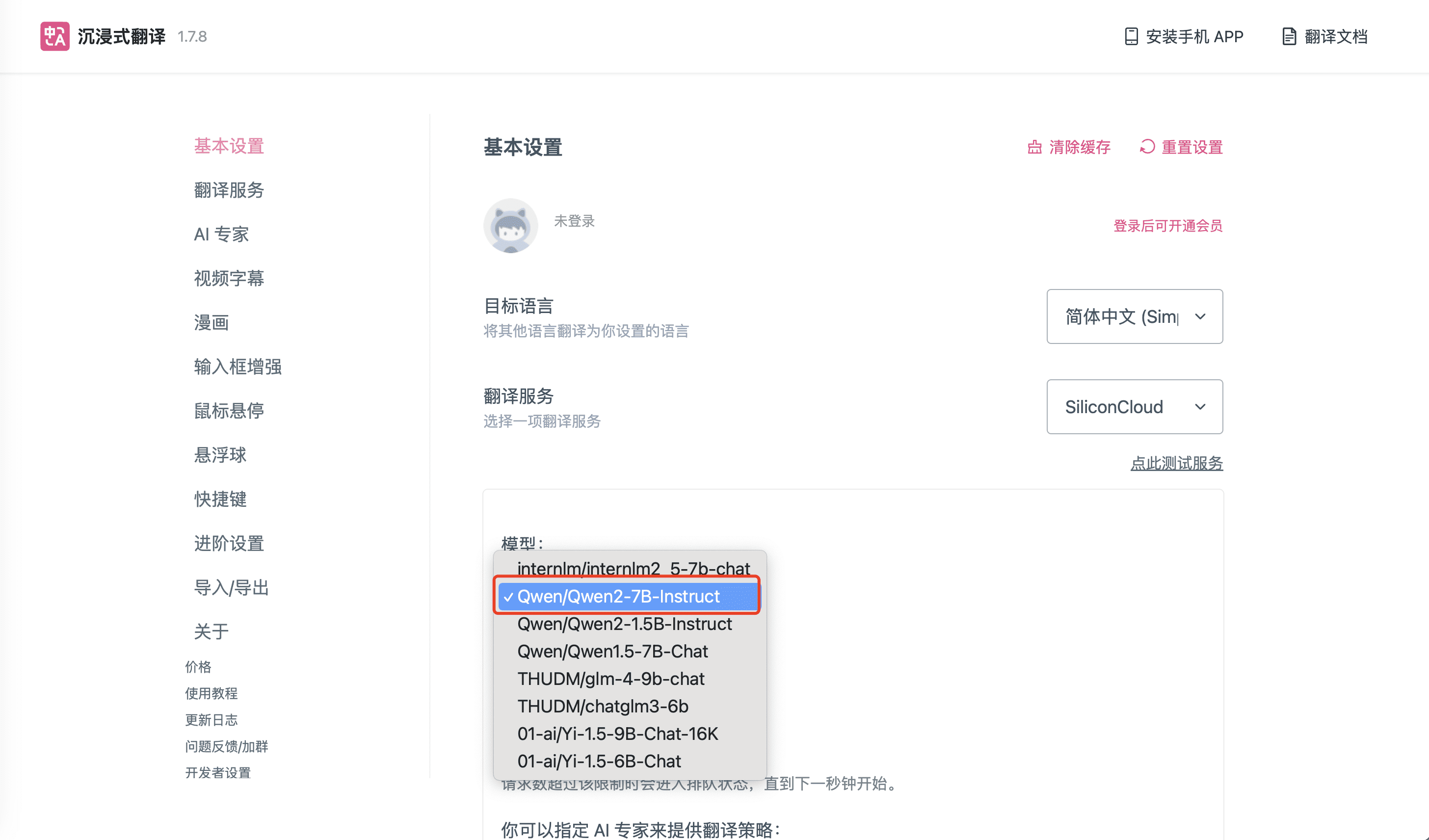

기본 설정 외에 실리콘클라우드의 다른 무료 모델을 선택하세요:

- 위 설정의 기본 모델은 실리콘클라우드의 "Qwen/Qwen2-7B-Instruct"이며, 다른 실리콘클라우드 모델로 전환해야 하는 경우 위 아이콘의 "설정"을 클릭합니다. 다른 실리콘클라우드 모델로 전환해야 하는 경우, 위 아이콘의 "설정"을 클릭하여 실리콘클라우드 관련 설정을 진행합니다.

기본 설정 이외의 다른 실리콘클라우드 크기 모델을 선택합니다:

- 위의 8개 모델 이외의 다른 SiliconCloud 모델을 사용해야 하는 경우 아래 그림과 같이 몰입형 번역 확장 아이콘을 클릭하고 해당 '설정' 옵션을 찾아 '번역 서비스 추가'를 선택합니다.

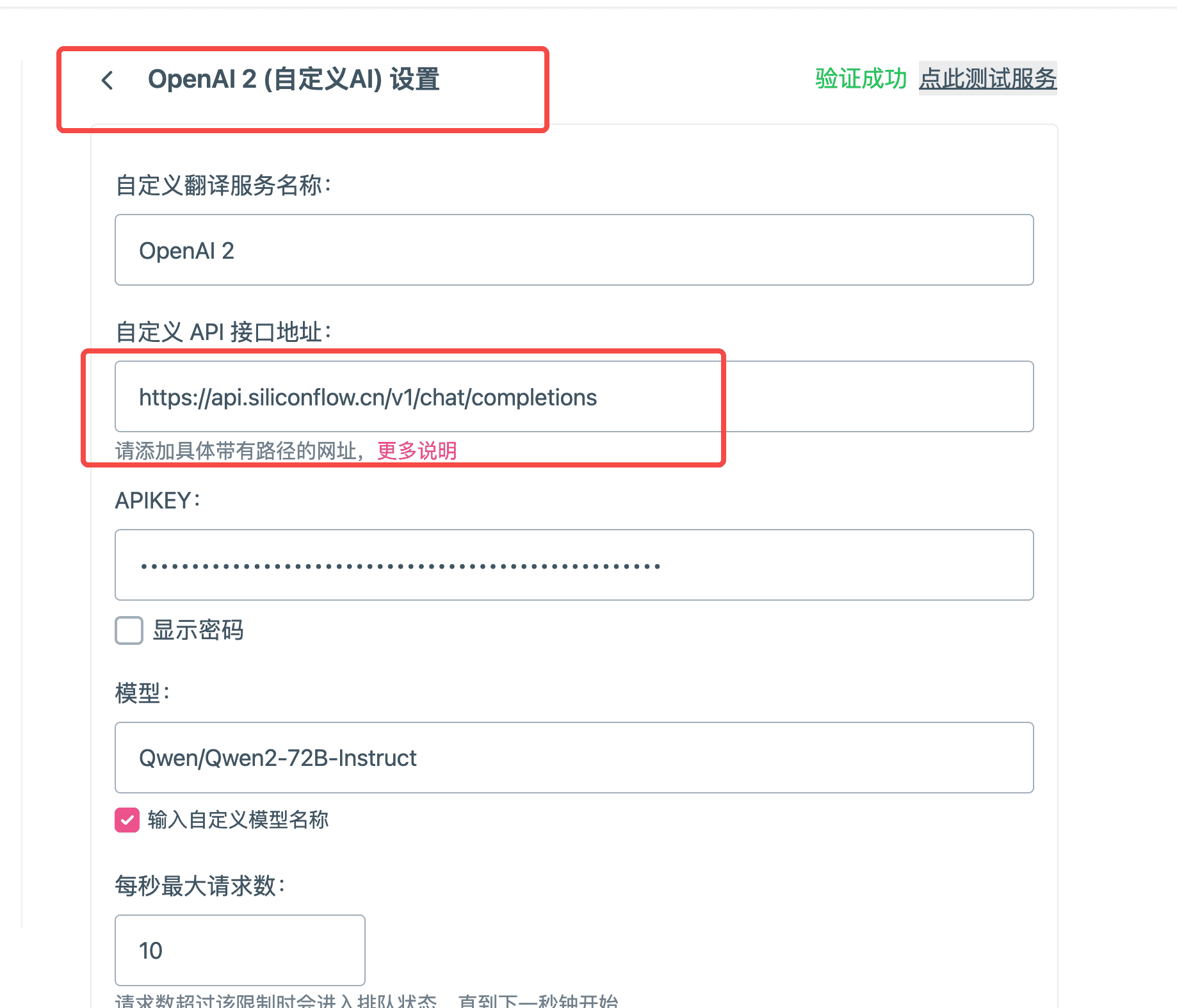

- 실리콘클라우드 모델에 대한 정보를 추가하세요!

- 사용자 지정 번역 서비스 이름: 실제 상황에 따라 이름을 입력하세요. 여기서는 "Qwen/Qwen2-72B-Instruct"를 입력합니다.

- 사용자 지정 API 인터페이스 주소:

APIKEY: FromAPI 키 에서 복사를 클릭합니다.

- 모델 이름: 실리콘클라우드의 모델 이름이며, 여기서는 "Qwen/Qwen2-72B-Instruct"를 사용할 수 있습니다.플랫폼 모델 목록현재 지원되는 모든 모델의 이름을 가져옵니다.

- 오른쪽 상단 모서리에 있는 테스트를 클릭하여 테스트가 성공했는지 확인합니다.

- 이제 관련 모델 구성 항목을 완료했으므로 SiliconCloud에서 제공하는 대규모 언어 모델을 사용하여 몰입형 번역기 플러그인에서 번역을 제공할 수 있습니다.

dedify에서 SiliconCloud API 사용

활용 diffy 실리콘클라우드 모델에 내장된 API는

디파이 워크플로우를 자주 사용하는 입장에서 실리콘클라우드는 GLM4 , Qwen2, DeepSeek V2, Yi 등 최신 모델을 처음으로 제공하며, 도킹이 매우 빠릅니다!

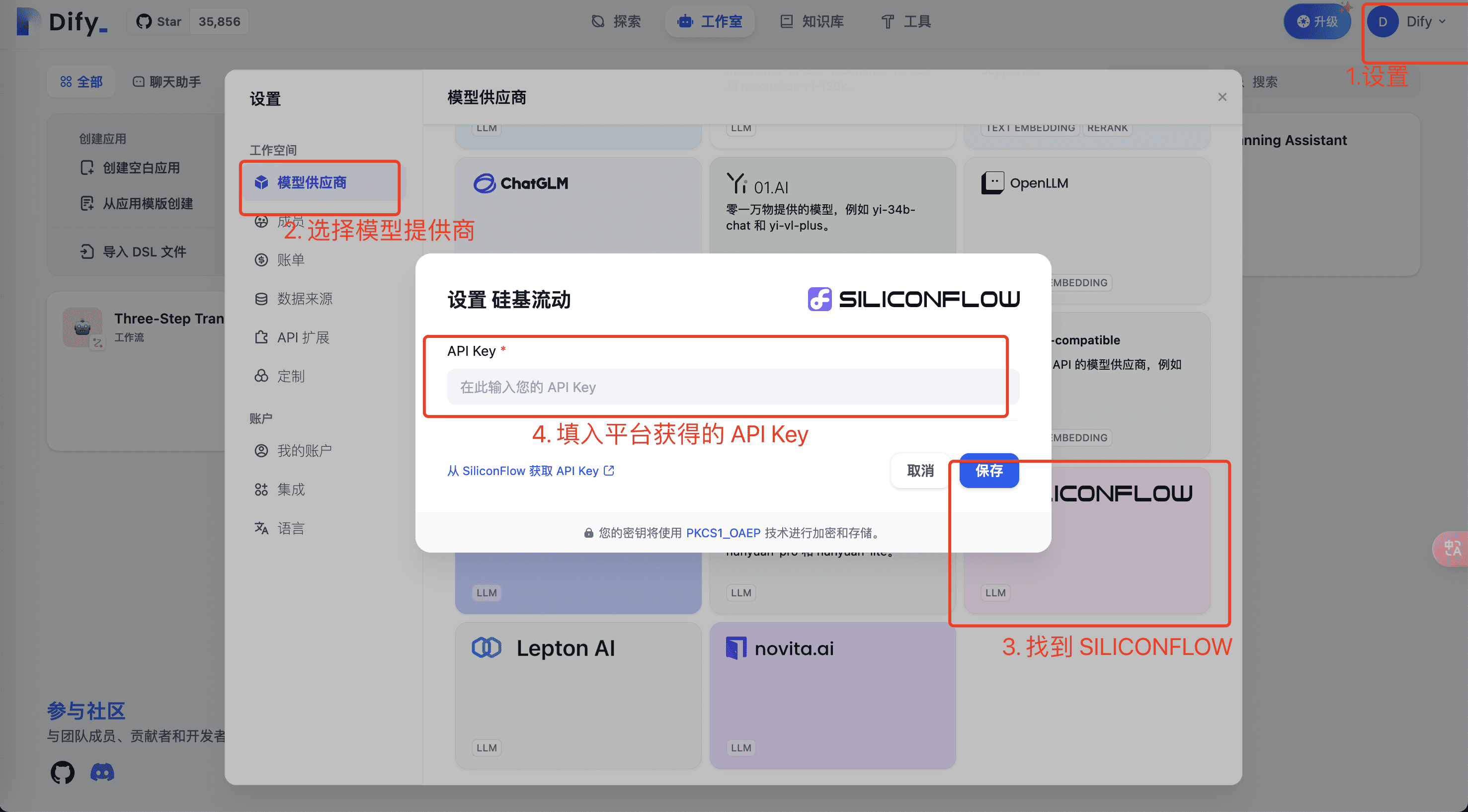

- 설정에서 실리콘클라우드 플랫폼 계정의 모델과 API 키를 설정하여 대형 모델을 설정합니다.

- SiliconCloud 플랫폼의 관련 모델 및 API 키 정보를 입력하고 저장을 클릭하여 확인합니다. 사용실리콘클라우드 API키현재 사용자의 API 키를 가져와 위의 환경에 복사합니다.

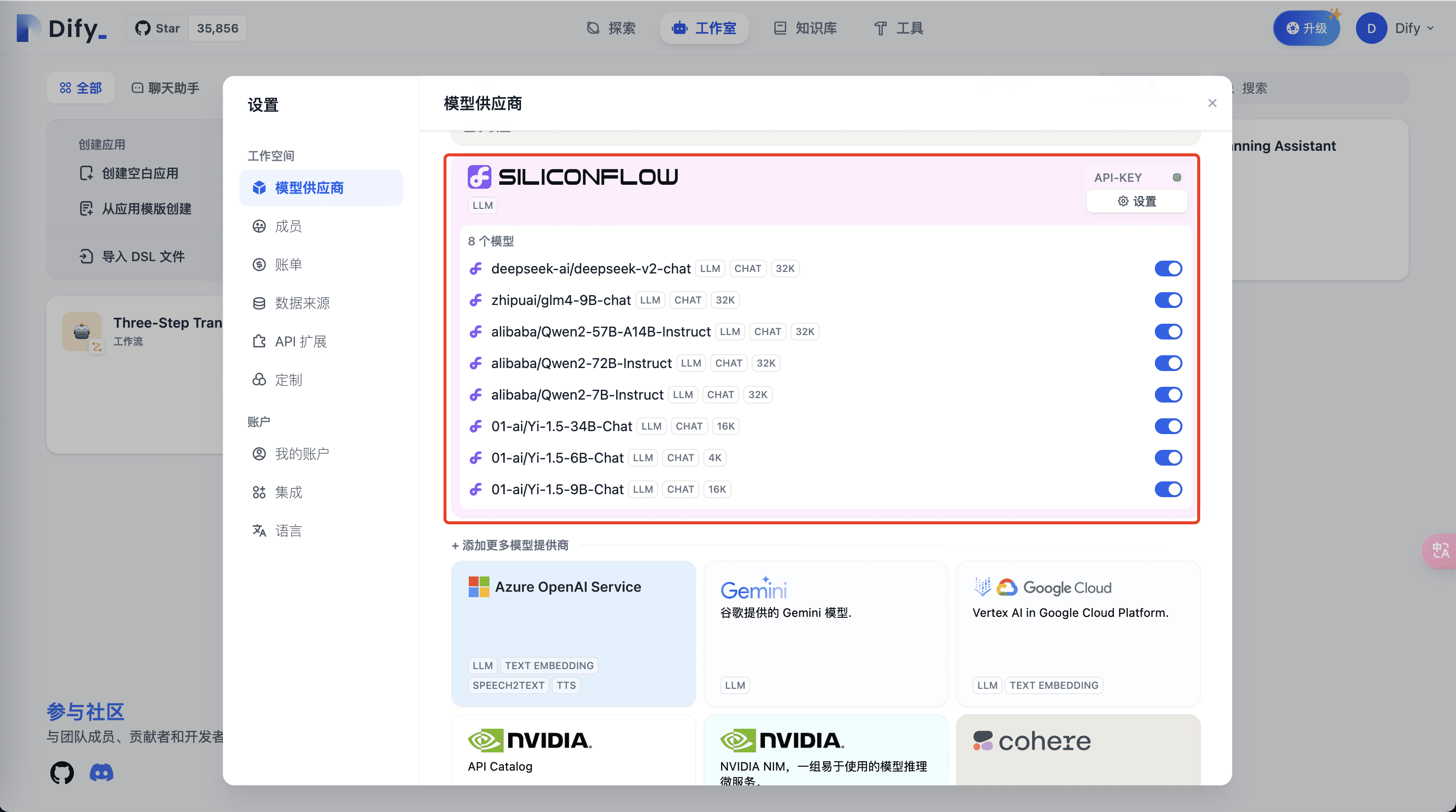

- 다음으로 모델 공급자의 상단 영역에서 실리콘플로우 관련 모델을 볼 수 있습니다.

- 애플리케이션에서 실리콘클라우드 통신사 모델 사용

이 단계를 마치면 Dify 개발 애플리케이션에서 SiliconFlow가 제공하는 풍부하고 빠른 LLM 모델을 사용할 준비가 된 것입니다.

현재 디파이 소스 코드에 없는 실리콘클라우드 모델

현재 실리콘클라우드에는 새로운 모델이 계속 도입되고 있으며, 양측의 반복적인 리듬으로 인해 일부 모델은 처음에 Dify에 표시되지 않을 수 있으며, 여기서는 다음 프로세스에 따라 설정합니다.

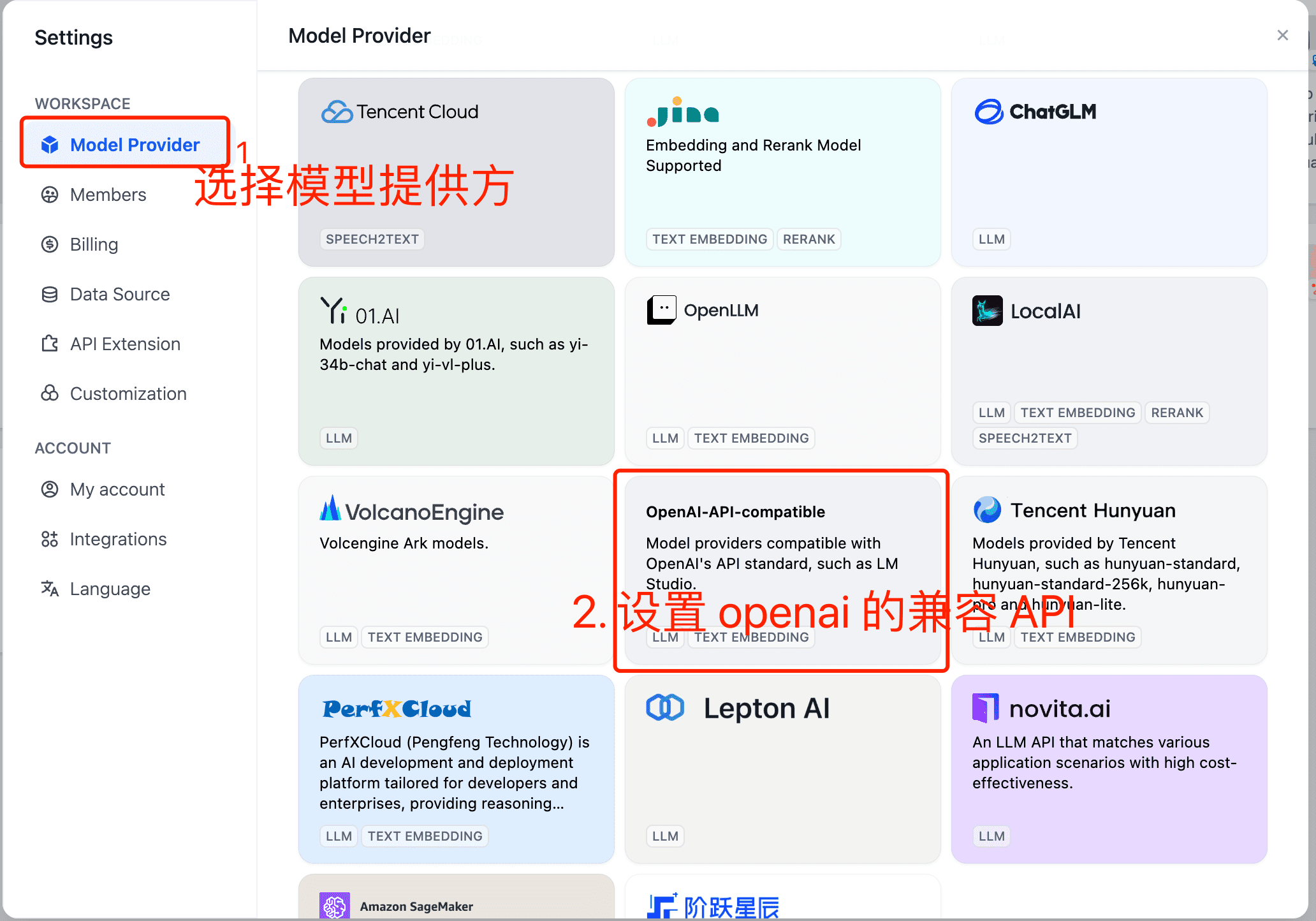

- 디파이 설정을 열어 설정합니다.

- 설정에서 모델 공급자를 선택하고 'openai 호환 API'를 설정합니다.

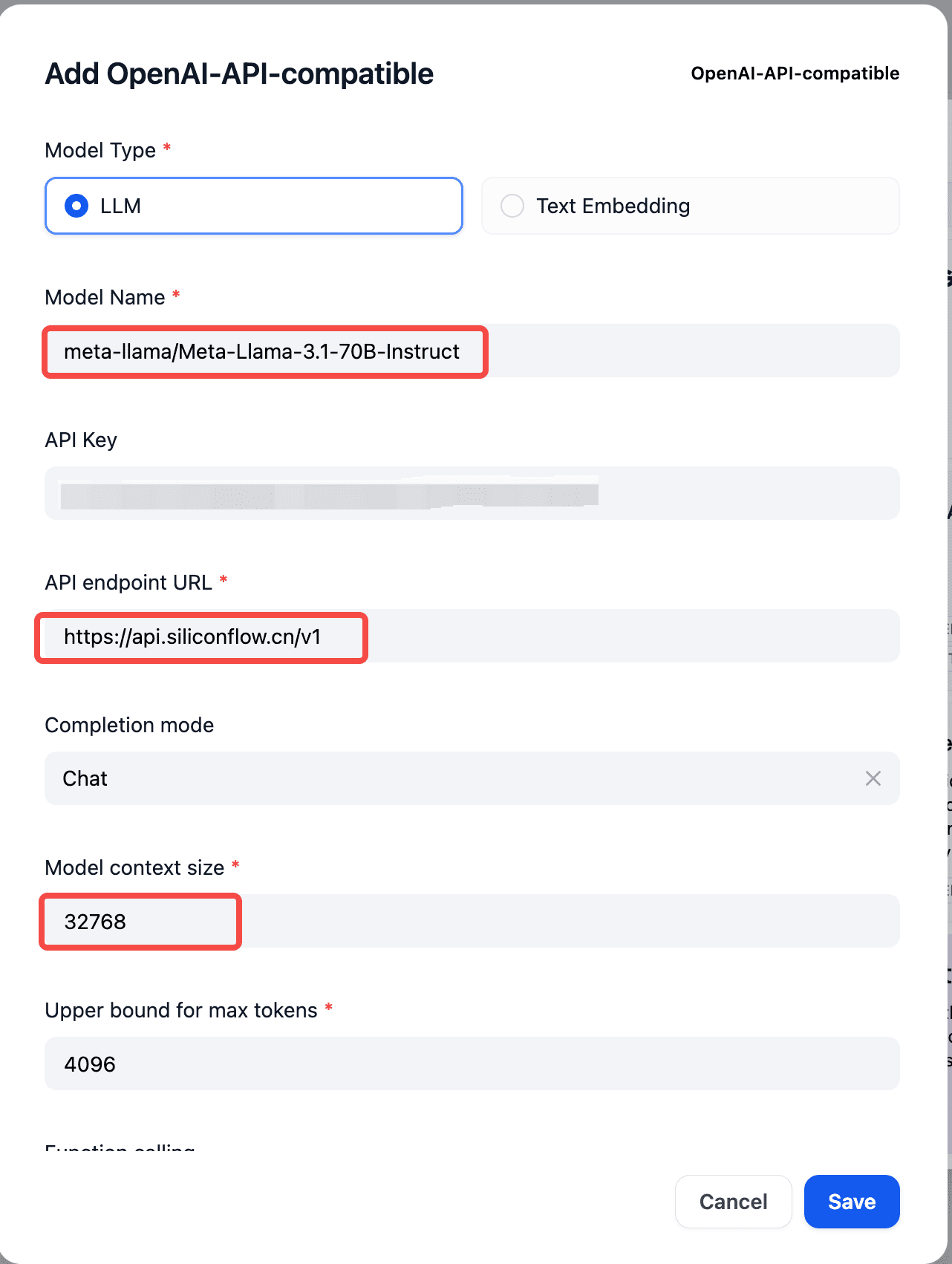

- 실리콘클라우드에 해당하는 모델명, API 키, API 엔드포인트 API를 설정합니다.

모델명: 에서https://docs.siliconflow.cn/reference/chat-completions-1 문서를 살펴보세요.

API 키: fromhttps://cloud.siliconflow.cn/account/ak 해외 모델을 사용하는 경우 다음 사항을 준수하시기 바랍니다.https://docs.siliconflow.cn/docs/use-international-outstanding-models 실명 인증에 대한 문서화 규칙입니다.

API 엔드포인트 URL:https://api.siliconflow.cn/v1

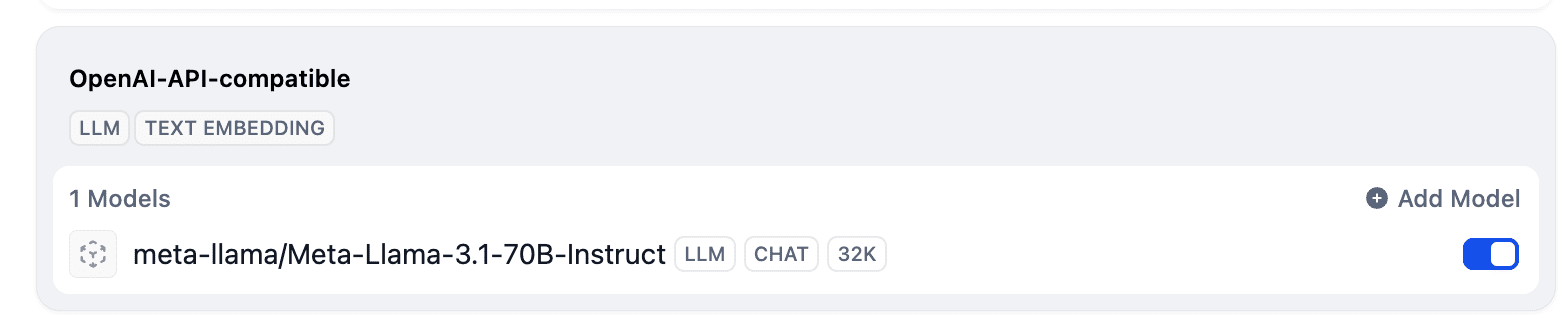

- 설정이 완료되면 모델 목록에서 위에 추가된 모델을 확인할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...