무료 GPU 성능으로 딥시크-R1 오픈 소스 모델을 온라인으로 배포하기

텐센트 클라우드 클라우드 스튜디오와 딥시크 딥시크-R1 덕분입니다.

AI와 빅 모델 기술이 빠르게 발전함에 따라 점점 더 많은 개발자와 연구자들이 이러한 첨단 기술을 더 잘 이해하고 적용하기 위해 빅 모델을 직접 경험하고 미세 조정하기를 원합니다. 하지만 GPU 연산에 드는 높은 비용은 종종 모든 사람의 탐험을 방해하는 병목 현상이 되기도 합니다. 다행히도 Tencent Cloud Studio는 무료 GPU 연산 리소스를 제공하며, DeepSeek에서 도입한 DeepSeek-R1 빅 모델과 결합하면 클라우드에서 이러한 강력한 모델을 한 푼도 들이지 않고도 쉽게 배포하고 실행할 수 있습니다.

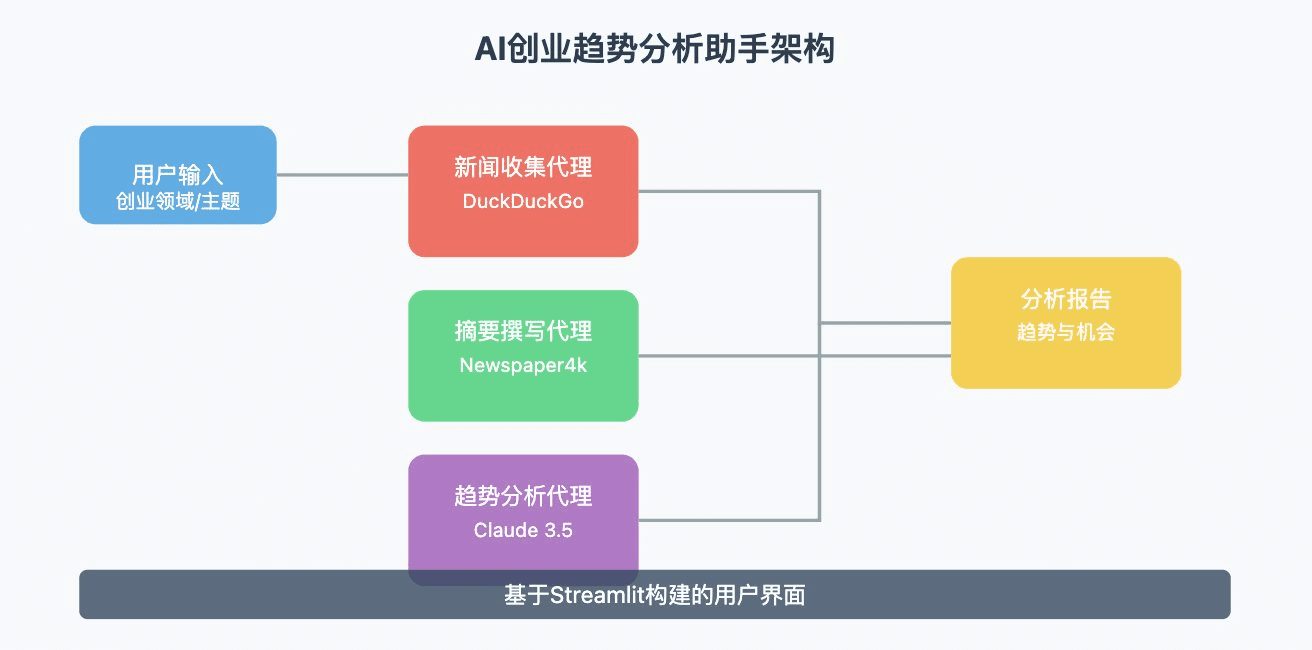

이 문서에서는 텐센트 클라우드 사용 방법을 자세히 설명합니다. 클라우드 스튜디오 의 무료 GPU 리소스를 배포하고 DeepSeek-R1 매크로 모델과 상호 작용할 수 있습니다. 클라우드 스튜디오 사용부터 시작하여 Ollama의 설치 및 구성을 단계별로 진행하며, 배포하는 방법을 보여드리겠습니다. DeepSeek-R1 를 클릭하고 대화하면 완전한 무료 DeepSeek-R1 + 세트가 제공됩니다. 루 코드 무료 프로그래밍 포트폴리오 프로그램.

1. 클라우드 스튜디오

1.1 Cloud Studio 소개

텐센트 클라우드 클라우드 스튜디오는 개발자가 보다 효율적으로 코딩, 디버깅, 배포할 수 있도록 풍부한 개발 도구와 리소스를 제공하는 클라우드 기반 통합 개발 환경(IDE)입니다. 최근 Cloud Studio는 무료 GPU 컴퓨팅 리소스를 출시했는데, 사용자는 16G 비디오 메모리, 32G RAM, 8코어 CPU로 구성된 GPU 서버를 매달 10,000분 동안 무료로 사용할 수 있습니다. 이는 고성능 컴퓨팅 리소스가 필요한 개발자에게 큰 혜택이 될 것입니다. (사용 후 컴퓨터를 닫고 다음 미세 조정을 한 다음 열면 환경이 자동으로 저장되며 한 달에 10,000 분을 사용할 수 없음을 잊지 마십시오.)

1.2 등록 및 로그인

클라우드 스튜디오를 사용하려면 먼저 텐센트 클라우드 계정을 등록해야 합니다. 등록이 완료되면 Cloud Studio에 로그인하면 선택할 수 있는 다양한 개발 템플릿을 제공하는 깔끔한 사용자 인터페이스가 표시됩니다. 이러한 템플릿은 기본 Python 개발부터 복잡한 대규모 모델 배포에 이르기까지 다양한 시나리오를 다룹니다. 반드시 Pro 버전을 사용하세요.

1.3 올라마 템플릿 선택하기

배포하는 것이 목표이므로 DeepSeek-R1 대형 모델을 선택할 수 있습니다. Ollama Ollama는 대규모 모델을 관리하고 실행하는 도구로, 모델을 다운로드, 설치 및 실행하는 과정을 간소화합니다. Ollama 템플릿을 선택하면 Cloud Studio가 자동으로 Ollama 환경을 구성하므로 수동으로 설치할 필요가 없습니다.

부팅을 기다렸다가 Enter를 클릭합니다(Ollama는 이미 환경에 배포되어 있으므로 설치 명령을 직접 실행하면 됩니다).

2. 올라마

2.1 올라마 소개

올라마는 다양한 대규모 모델을 관리하고 실행하는 데 특화된 오픈 소스 도구입니다. 다양한 모델 형식을 지원하고 모델 종속성을 자동으로 처리할 수 있어 모델 배포 및 실행이 매우 간단하며, Ollama의 공식 웹사이트는 풍부한 모델 리소스를 제공하며, 사용자는 필요에 따라 적합한 모델을 선택하여 다운로드하고 실행할 수 있습니다.

2.2 모델 매개변수 및 선택

올라마의 공식 웹사이트에서는 각 모델의 하단에 7B, 13B, 70B 등과 같이 각 모델의 매개변수 수가 표시되어 있습니다. 여기서 "B"는 10억을 의미합니다. 여기서 "B"는 10억을 나타내며 모델의 매개변수 수를 나타냅니다. 매개변수 수가 많을수록 모델의 복잡성과 기능이 높아지지만 컴퓨팅 리소스도 더 많이 소모됩니다.

텐센트 클라우드 스튜디오에서 제공하는 무료 GPU 리소스(16G 비디오 메모리, 32G RAM, 8코어 CPU)의 경우 배포를 위해 8B 또는 13B 모델을 선택할 수 있습니다. 하드웨어 구성이 더 높은 경우 더 큰 매개 변수가 있는 모델을 사용해 더 나은 결과를 얻을 수도 있습니다.

2.3 올라마 설치하기

다른 환경에서 Ollama를 사용하는 경우 다음 명령어로 설치할 수 있으며, Cloud Studio에서 Ollama 템플릿을 선택하면 시스템이 자동으로 설치합니다:

curl -fsSL https://ollama.com/install.sh | sh설치가 완료되면 다음 명령을 사용하여 Ollama가 성공적으로 설치되었는지 확인할 수 있습니다:

ollama --version다음 단계는 Ollama가 DeepSeek-R1을 배포하는 것입니다 ...

3. DeepSeek-R1 무료 배포

3.1 DeepSeek-R1 소개

DeepSeek-R1은 다양한 자연어 처리 작업, 특히 텍스트 생성, 대화 시스템, 질의응답 분야에서 우수한 성능을 발휘하는 딥씨크의 고성능 대형 모델로, 딥씨크-R1의 파라미터 수는 8B에서 70B까지 다양하여 사용자가 하드웨어 구성에 따라 적합한 모델을 선택할 수 있습니다.

3.2 다운로드 및 배포

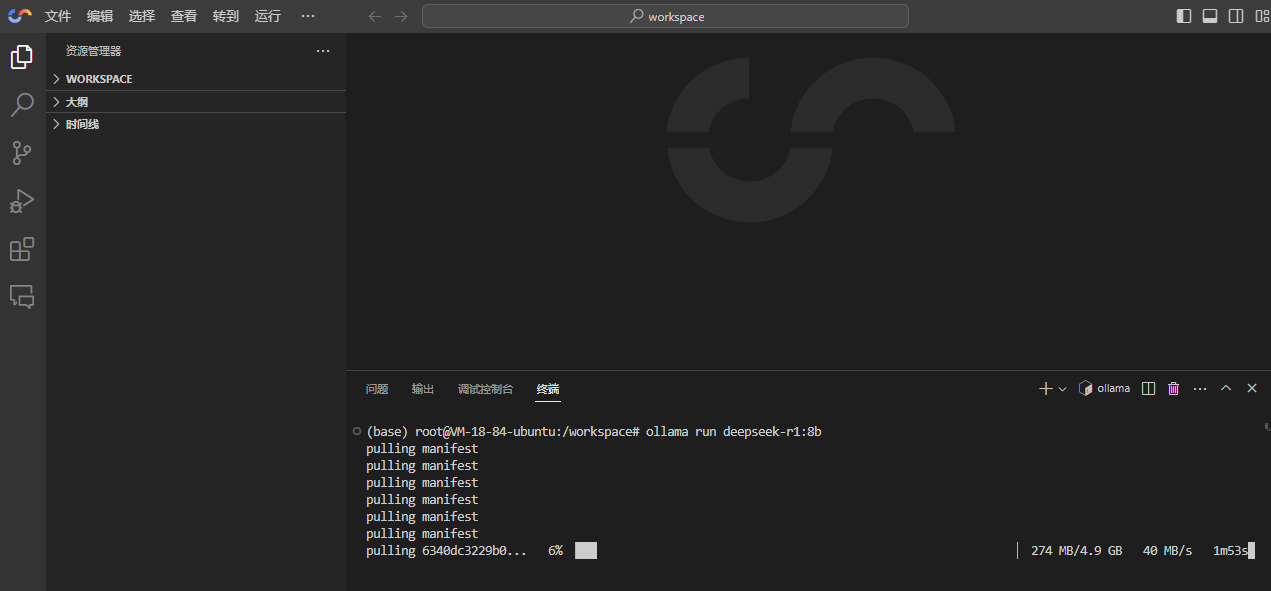

Cloud Studio는 이미 Ollama를 자동으로 설치하므로 DeepSeek-R1을 배포하는 것은 매우 간단합니다. 다음 명령을 실행하기만 하면 됩니다:

ollama run deepseek-r1:8b

DeepSeek-R1에 사용 가능한 모든 모델은 여기에서 확인하실 수 있습니다: https://ollama.com/library/deepseek-r1 , 추천! ollama run deepseek-r1:14b (이것은 증류된 Qwen 모델입니다.)

3.3 모델 실행

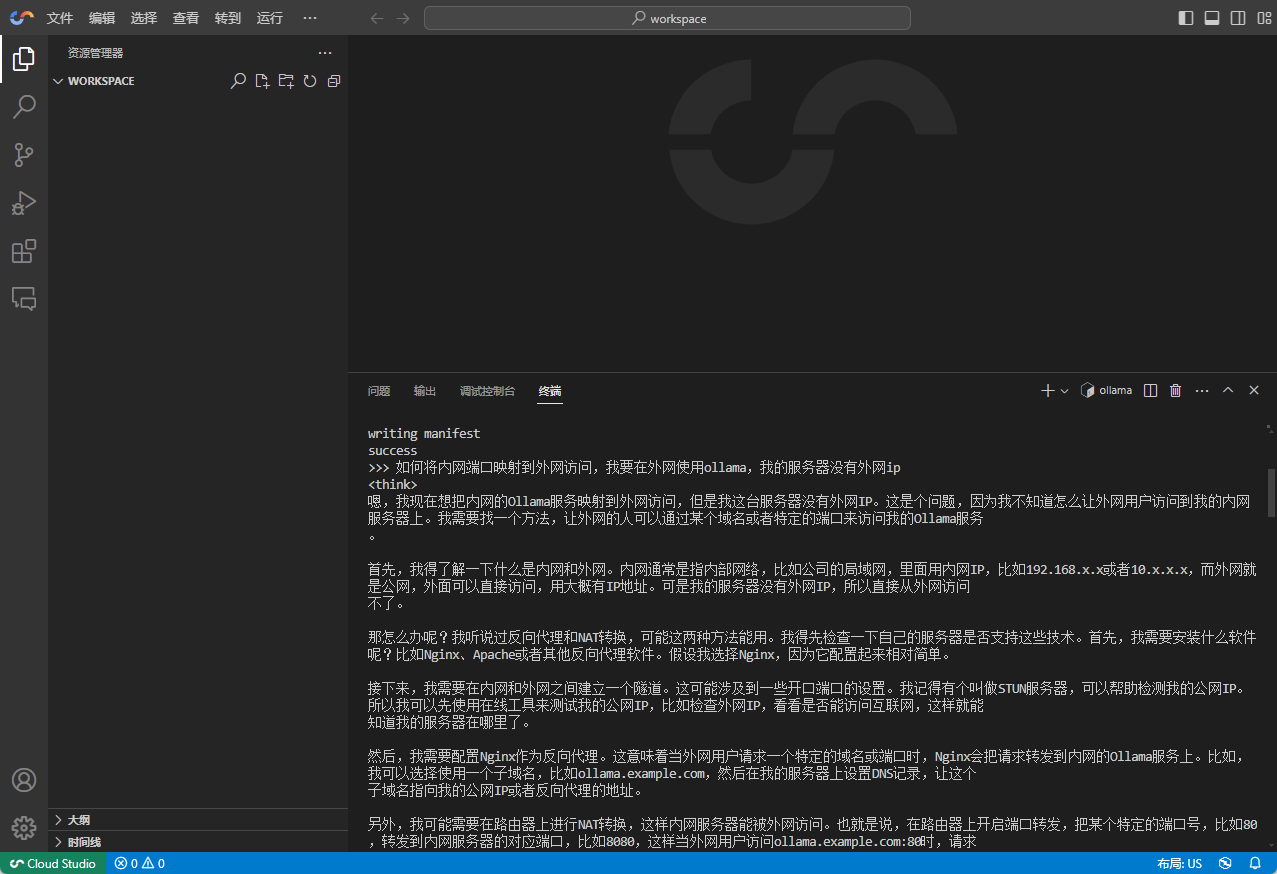

모델 다운로드가 완료될 때까지 기다리면 Ollama가 자동으로 DeepSeek-R1을 실행하고 대화형 모드로 들어갑니다. 이 때 단말기에 질문이나 명령을 직접 입력하여 DeepSeek-R1과 대화할 수 있습니다.

4. DeepSeek-R1과 채팅 시작하기

4.1 기본 대화

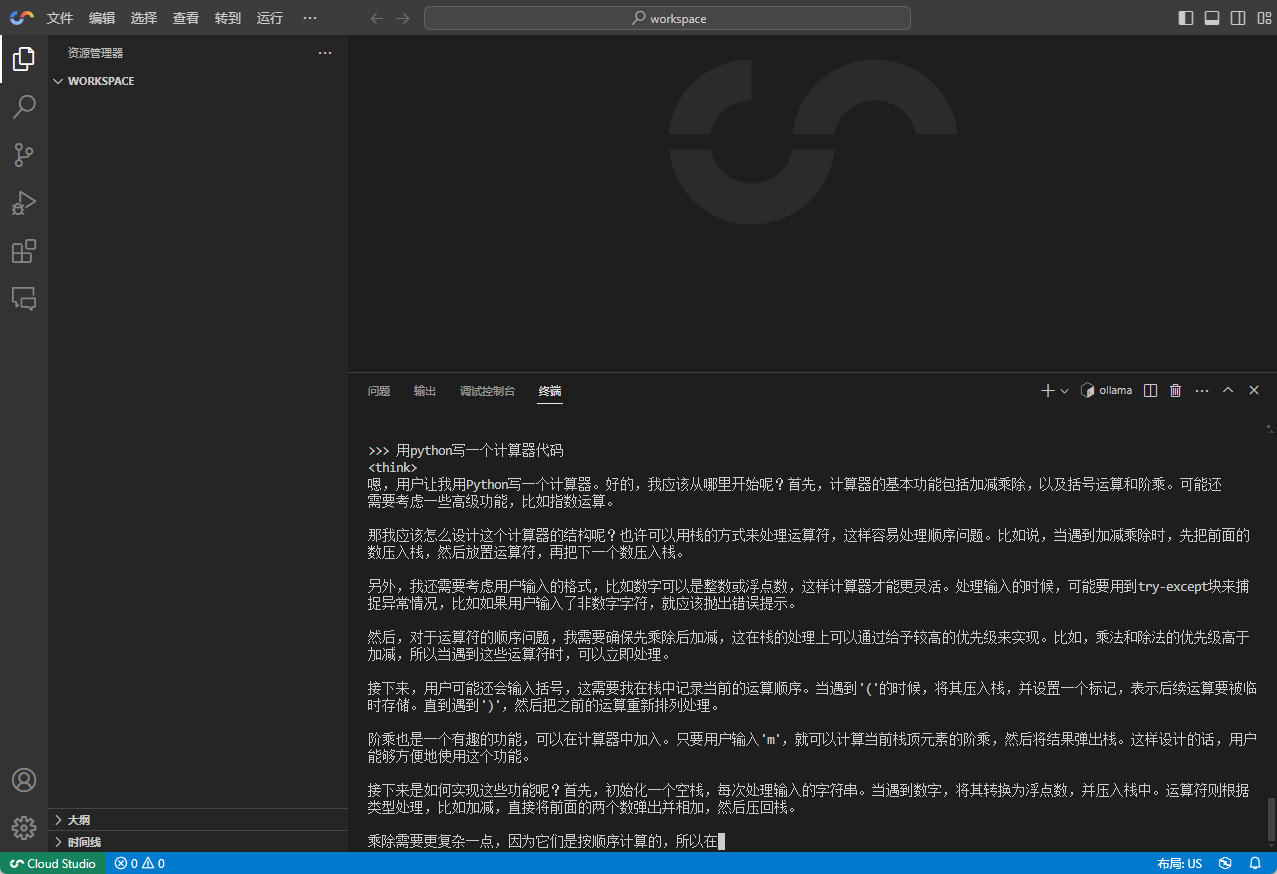

DeepSeek-R1과의 대화는 매우 간단합니다. 터미널에 질문이나 지시를 입력하기만 하면 모델이 즉시 답변을 생성합니다.

4.2 복잡한 작업

- 예를 들어, DeepSeek-R1을 사용한 코드 생성

4.3 모델 미세 조정

DeepSeek-R1의 성능이 만족스럽지 않거나 특정 작업에서 모델이 더 나은 성능을 발휘하기를 원하는 경우 모델을 미세 조정할 수 있습니다. 미세 조정 과정에는 일반적으로 일부 도메인별 데이터 세트를 준비하고 이러한 데이터 세트를 사용하여 모델을 재학습하는 과정이 포함되며, Ollama는 사용자가 모델 미세 조정을 수행할 수 있도록 간단한 인터페이스를 제공합니다.

4.4 AI 프로그래밍 도구에서 사용

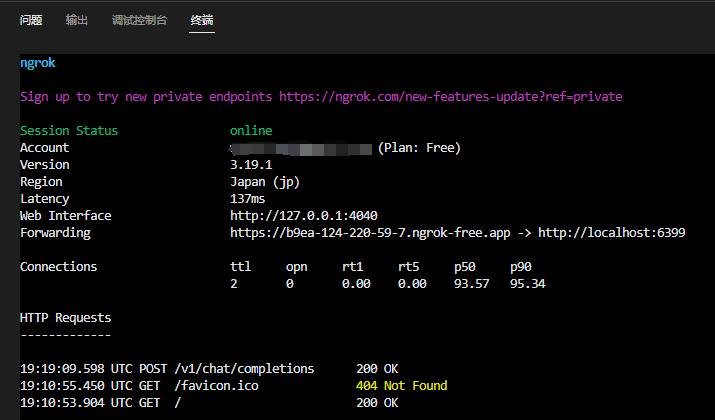

터미널에서 서비스를 사용하는 것은 확실히 주된 시나리오가 아니며, 다른 채팅 도구나 AI 프로그래밍 도구에서 서비스를 사용해야만 실용적으로 사용할 수 있습니다. Cloud Studio는 외부 액세스 주소를 제공하지 않습니다. 이 경우 ngrok/Cpolar가 좋은 솔루션입니다.

자세한 설명이 아닌 아이디어만 제공하세요: 첫 번째 단계는 인트라넷 Ollama 포트를 쿼리하고, 두 번째 단계는 ngrok을 설치하고, 세 번째 단계는 Ollama 포트를 ngrok에 매핑하고, 서비스를 시작하면 다음 주소를 얻습니다:

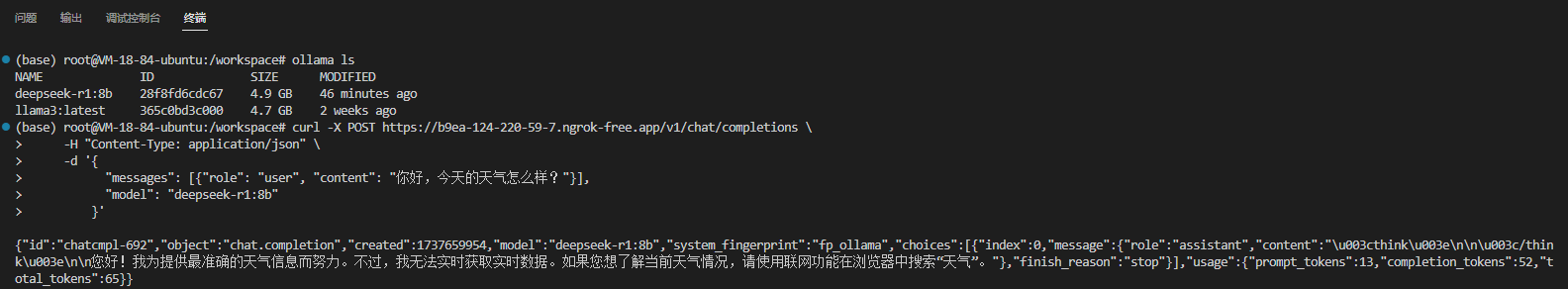

참고: 귀하의 ollama serve 서비스는 이미 6399 포트에서 실행할 경우 다음 명령을 사용하여 Ngrok을 시작하고 포트를 엑스트라넷에 매핑할 수 있습니다:ngrok http 6399

엑스트라넷이 작동하는지 확인: (전체 주소 연결)

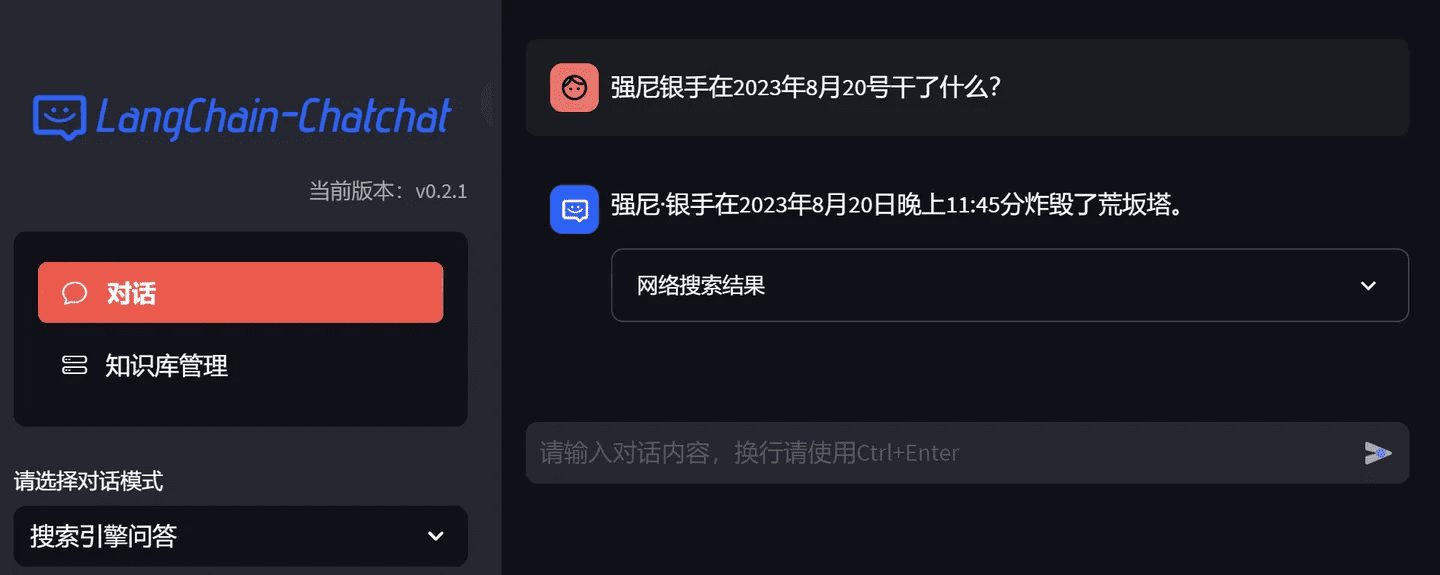

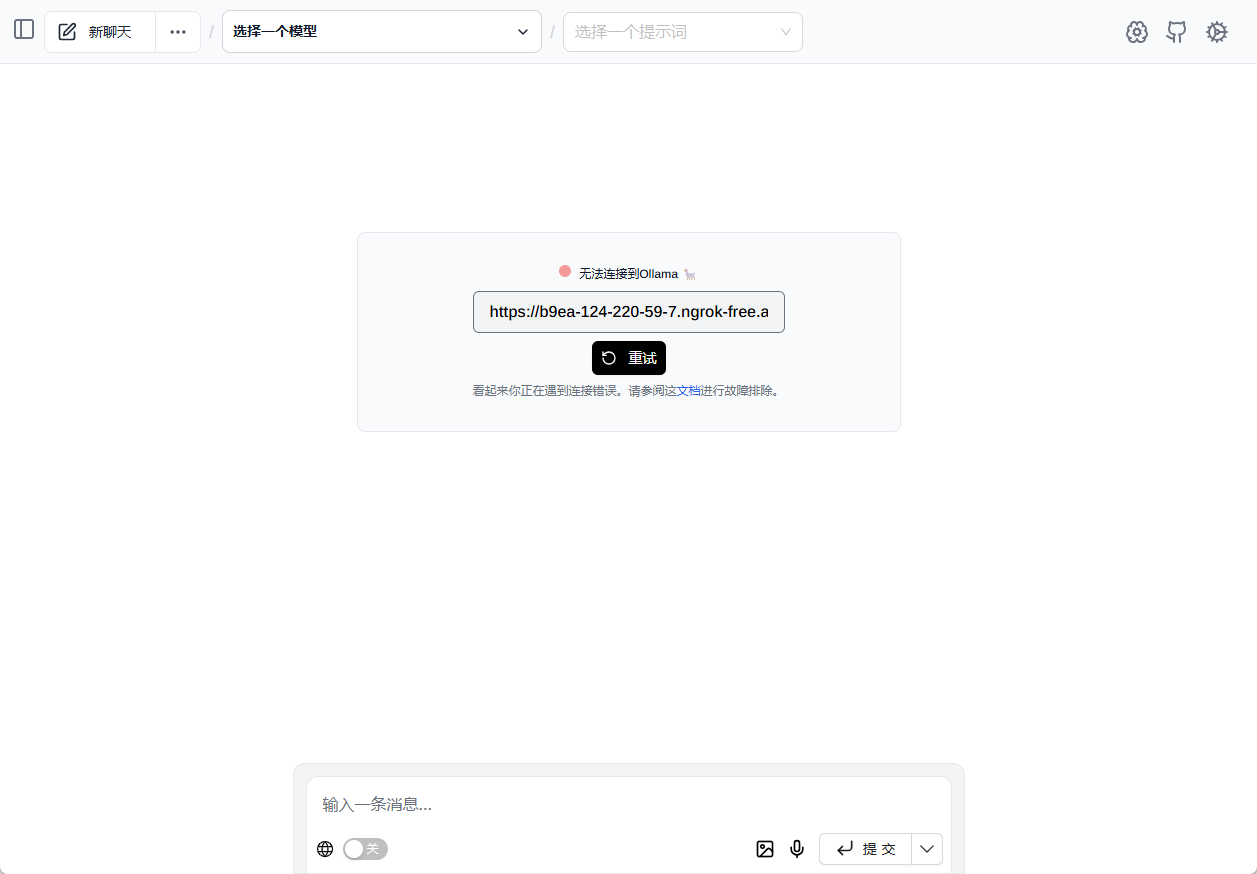

올라마 관련 기능을 경험하려면 기본 브라우저 플러그인을 사용하는 것이 좋습니다. 페이지 지원 (https://xxx.ngrok-free.app/ 을 직접 입력하면 모든 올라마 모델이 자동으로 로드됩니다)

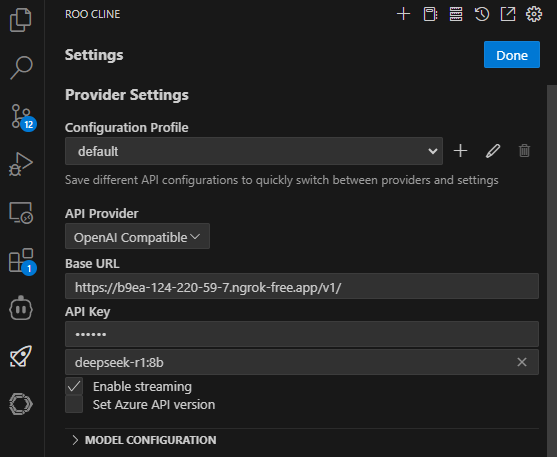

존재 루 코드(루 클라인) 클라이언트에서 API 구성: (Roo Code는 훌륭한 AI 프로그래밍 플러그인입니다.)

원본 URL에 v1이 추가되고 API KEY가 추가되는 것을 확인합니다.

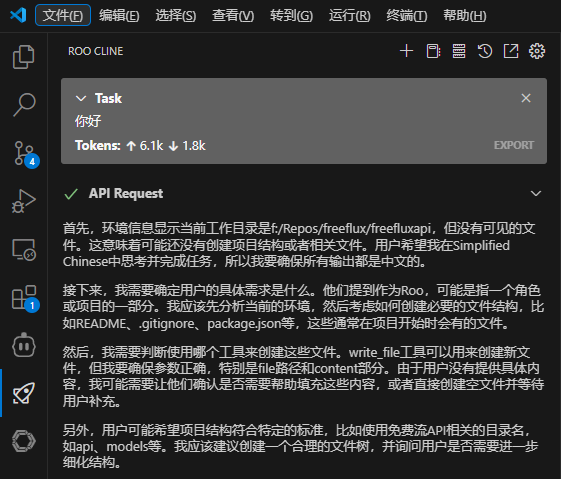

대화를 저장하고 테스트합니다:

5. 요약

텐센트 클라우드 스튜디오의 무료 GPU 리소스를 Ollama 및 DeepSeek-R1과 결합하면 높은 하드웨어 비용에 대한 걱정 없이 클라우드에서 대규모 모델을 쉽게 배포하고 실행할 수 있습니다. 간단한 대화를 하든 복잡한 작업을 하든, DeepSeek-R1은 강력한 지원을 제공합니다. 이 글이 DeepSeek-R1을 원활하게 배포하고 빅 모델 탐색 여정을 시작하는 데 도움이 되기를 바랍니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...