일반 소개

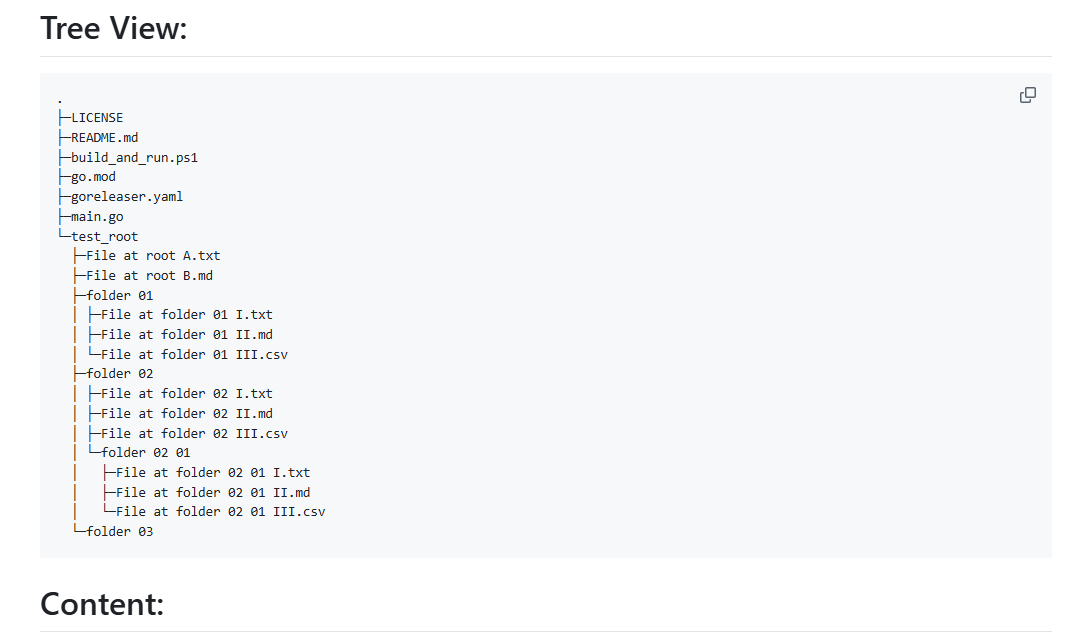

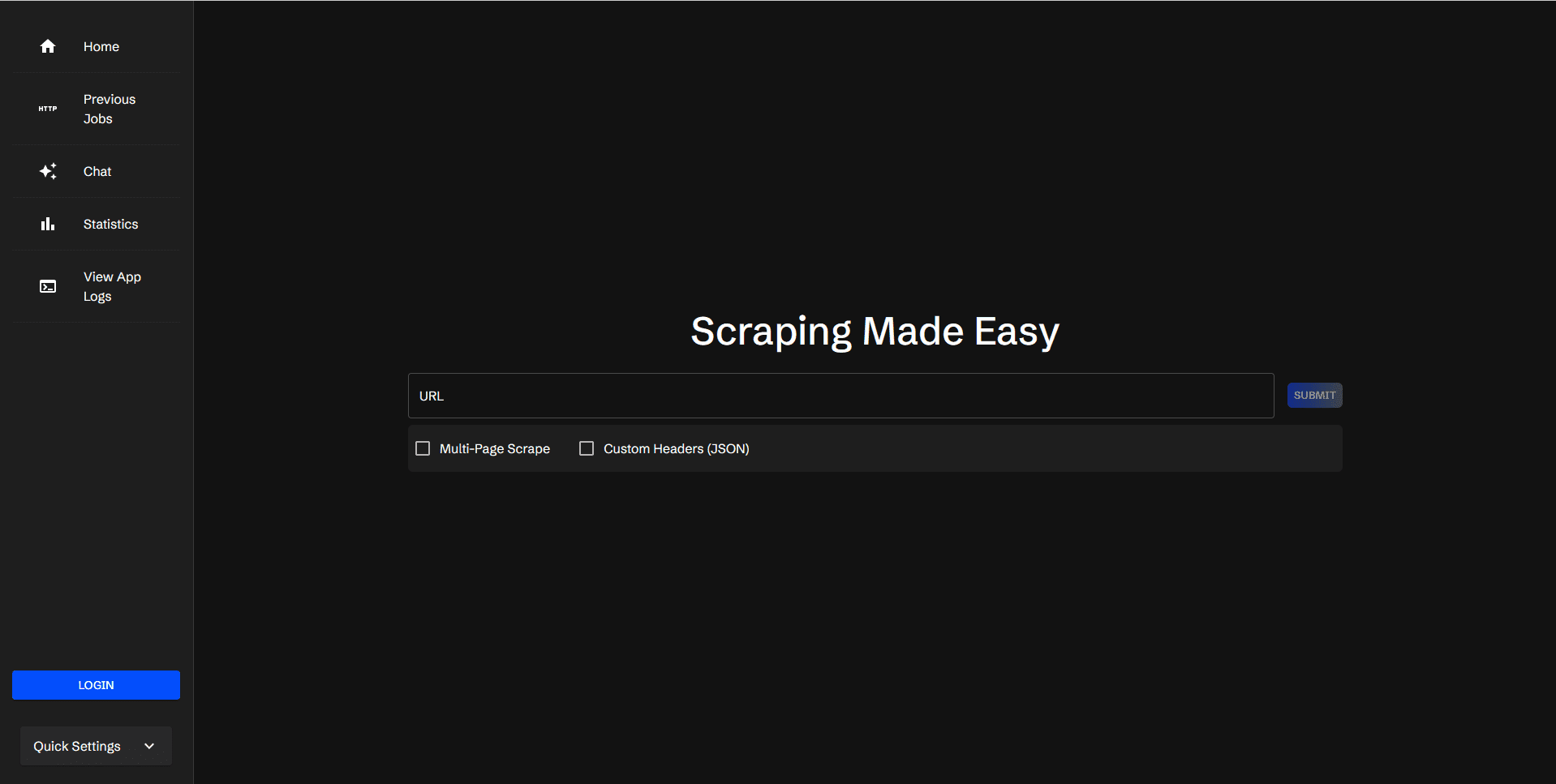

스크래퍼는 웹 데이터를 스크래핑할 XPath 요소를 지정할 수 있는 자체 호스팅 웹 데이터 스크래핑 도구입니다. 사용자가 URL과 해당 크롤링 요소를 제출하면 그 결과가 표로 표시되어 엑셀 파일로 다운로드할 수 있으며, 스크래퍼는 크롤링 작업 관리를 위한 사용자 로그인을 지원하고 로그 보기 및 통계 기능을 제공합니다.

기능 목록

- 웹 크롤링을 위한 URL 제출 및 큐 큐잉

- XPath로 크롤링 요소 추가 및 관리하기

- 동일한 도메인 이름으로 모든 페이지 크롤링하기

- 요청을 전송하기 위해 사용자 지정 JSON 헤더 추가

- 캡처한 데이터의 결과 표시

- 결과가 포함된 CSV 파일 다운로드

- 캡처 작업 다시 실행

- 대기 중인 작업의 상태 보기

- 북마크 지정 및 북마크된 작업 보기

- 사용자 로그인/등록을 통한 작업 정리

- 애플리케이션 로그 보기

- 작업 통계 보기

- 대화 컨텍스트에 크롤링 결과를 포함할 수 있도록 지원하는 AI 통합

도움말 사용

설치 프로세스

- 복제 창고:

git clone https://github.com/jaypyles/scraperr.git - 환경 변수 및 태그 설정: 환경 변수 및 태그의

docker-compose.yml파일을 사용하여 환경 변수와 레이블을 설정할 수 있습니다:scraperr: labels: - "traefik.enable=true" - "traefik.http.routers.scraperr.rule=Host(`localhost`)" - "traefik.http.routers.scraperr.entrypoints=web" scraperr_api: environment: - LOG_LEVEL=INFO - MONGODB_URI=mongodb://root:example@webscrape-mongo:27017 - SECRET_KEY=your_secret_key - ALGORITHM=HS256 - ACCESS_TOKEN_EXPIRE_MINUTES=600 - 서비스를 시작합니다:

docker-compose up -d

사용 프로세스

- 크롤링을 위한 URL 제출::

- 스크래퍼에 로그인한 후 스크래핑 작업 페이지로 이동합니다.

- 크롤링할 URL과 해당 XPath 요소를 입력합니다.

- 작업을 제출하면 시스템이 자동으로 대기열에 추가하고 캡처를 시작합니다.

- 크롤링 요소 관리::

- 크롤링 작업 페이지에서 XPath 요소를 추가, 편집 또는 삭제할 수 있습니다.

- 동일한 도메인 아래의 모든 페이지 크롤링을 지원합니다.

- 크롤링 결과 보기::

- 캡처가 완료되면 결과가 표에 표시됩니다.

- 사용자는 결과가 포함된 CSV 파일을 다운로드하거나 작업을 다시 실행하도록 선택할 수 있습니다.

- 작업 관리::

- 사용자는 대기 중인 작업의 상태를 확인하고, 북마크에 추가하고, 북마크에 추가한 작업을 볼 수 있습니다.

- 실행 중인 작업에 대한 통계를 표시하는 작업 통계 보기를 제공합니다.

- 로그 보기::

- 애플리케이션 로그 페이지에서 사용자는 캡처 작업에 대한 자세한 정보를 확인할 수 있는 시스템 로그를 볼 수 있습니다.

- AI 통합::

- 대화 컨텍스트에 캡처 결과 통합 지원, 현재 다음을 지원합니다. Ollama 및 OpenAI.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 게시물

댓글 없음...