일반 소개

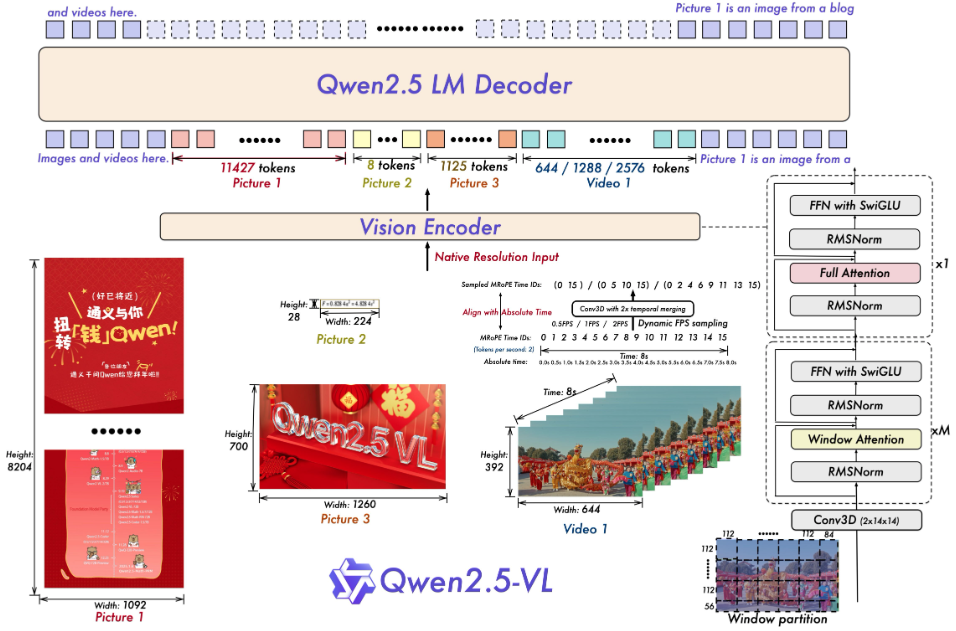

Qwen2.5-VL은 알리바바 클라우드의 Qwen 팀이 개발한 오픈 소스 멀티모달 빅 모델입니다. 텍스트, 이미지, 동영상, 문서를 동시에 처리할 수 있으며, Qwen2.5 언어 모델을 기반으로 구축된 Qwen2-VL의 업그레이드 버전입니다. 공식적으로는 문서 구문 분석, 동영상 이해 및 지능형 에이전트 기능이 크게 향상되었으며, 개인용 컴퓨터부터 서버까지 다양한 요구를 충족하기 위해 3B, 7B, 32B 및 72B의 네 가지 매개변수 규모를 지원합니다. 이 프로젝트는 Apache 2.0 라이선스에 따라 GitHub에서 호스팅되며 무료 오픈 소스입니다. qwen2.5-VL은 여러 테스트에서 우수한 성능을 보였으며 일부 메트릭은 비공개 소스 모델보다 뛰어난 성능을 보여 개발자가 문서 추출기, 비디오 분석기 또는 장치 작동 지원과 같은 지능형 도구를 구축하는 데 적합합니다.

기능 목록

- 자연스러운 장면과 여러 언어를 지원하여 이미지의 개체, 텍스트 및 레이아웃을 인식합니다.

- 매우 긴 동영상(1시간 이상)을 이해하고 두 번째 이벤트 클립을 찾습니다.

- 복잡한 문서를 구문 분석하고 손으로 쓴 텍스트, 표, 차트, 화학 공식을 추출합니다.

- 시각적 및 텍스트 명령을 통해 컴퓨터나 휴대폰을 제어하여 지능형 에이전트 작업을 수행하세요.

- 좌표나 속성 정보와 같은 구조화된 데이터를 JSON 형식으로 출력합니다.

- 동적 해상도 및 프레임 속도 조정을 지원하여 동영상 처리 효율을 최적화합니다.

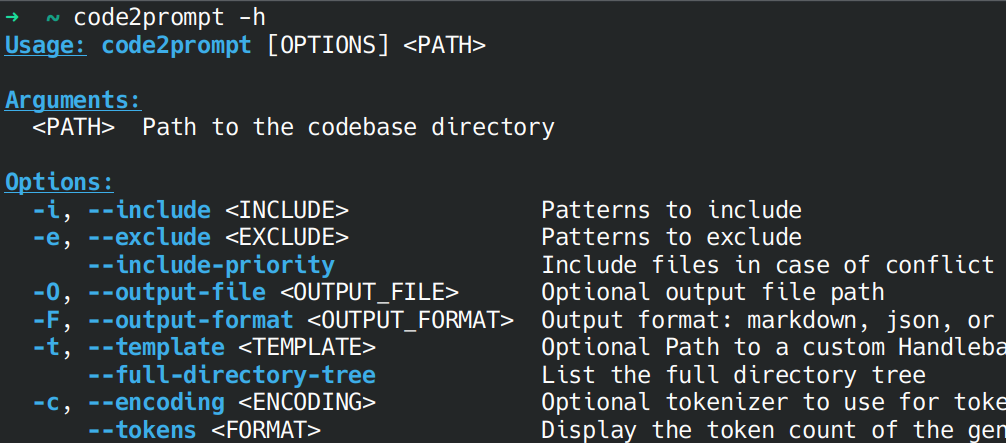

도움말 사용

설치 프로세스

로컬에서 Qwen2.5-VL을 실행하려면 소프트웨어 환경을 준비해야 합니다. 자세한 단계는 다음과 같습니다:

- 기본 환경 점검

Python 3.8 이상 및 Git이 필요합니다. 다음 명령을 입력하여 터미널을 확인합니다:

python --version

git --version

설치되어 있지 않은 경우 Python 및 Git 웹사이트에서 다운로드할 수 있습니다.

- 코드 다운로드

터미널에서 다음 명령을 실행하여 GitHub 리포지토리를 복제합니다:

git clone https://github.com/QwenLM/Qwen2.5-VL.git

cd Qwen2.5-VL

- 종속성 설치

이 프로젝트에는 다음 명령을 실행하여 설치하는 특정 Python 라이브러리가 필요합니다:

pip install git+https://github.com/huggingface/transformers@f3f6c86582611976e72be054675e2bf0abb5f775

pip install accelerate

pip install qwen-vl-utils[decord]

pip install 'vllm>0.7.2'

GPU가 있는 경우 CUDA를 지원하는 PyTorch를 설치하세요:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu124

참고:decord 빠른 동영상 로딩을 위해 Linux 이외의 사용자는 다음에서 동영상을 다운로드할 수 있습니다. 디코드 깃허브 소스 코드 설치.

- 프라이밍 모델

모델(예: 버전 7B)을 다운로드하여 실행합니다:

vllm serve Qwen/Qwen2.5-VL-7B-Instruct --port 8000 --host 0.0.0.0 --dtype bfloat16

허깅 페이스에서 모델이 자동으로 다운로드되고 로컬 서비스가 시작됩니다.

주요 기능 사용 방법

설치 후 코드 또는 웹 인터페이스에서 Qwen2.5-VL을 작동할 수 있습니다.

이미지 인식

모델이 그림을 설명해 주길 원하시나요? 새 image_test.py를 클릭하고 다음 코드를 입력합니다:

from transformers import Qwen2VLForConditionalGeneration, AutoProcessor

from qwen_vl_utils import process_vision_info

from PIL import Image

model = Qwen2VLForConditionalGeneration.from_pretrained("Qwen/Qwen2.5-VL-7B-Instruct", torch_dtype="auto", device_map="auto")

processor = AutoProcessor.from_pretrained("Qwen/Qwen2.5-VL-7B-Instruct")

messages = [{"role": "user", "content": [{"type": "image", "image": "图片路径或URL"}, {"type": "text", "text": "描述这张图片"}]}]

text = processor.apply_chat_template(messages, tokenize=False)

inputs = processor(text=[text], images=[Image.open("图片路径或URL")], padding=True, return_tensors="pt").to("cuda")

generated_ids = model.generate(**inputs, max_new_tokens=128)

output = processor.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(output)

모델을 실행하면 "이 사진은 창턱에 앉아 있는 고양이를 보여줍니다."와 같은 설명이 출력됩니다.

비디오 이해력

비디오 분석을 위해 로컬 파일을 준비해야 합니다(예 video.mp4). 다음 코드를 사용합니다:

messages = [{"role": "user", "content": [{"type": "video", "video": "video.mp4"}, {"type": "text", "text": "总结视频内容"}]}]

text = processor.apply_chat_template(messages, tokenize=False)

inputs = processor(text=[text], videos=[processor.process_video("video.mp4")], padding=True, return_tensors="pt").to("cuda")

generated_ids = model.generate(**inputs, max_new_tokens=128)

output = processor.batch_decode(generated_ids, skip_special_tokens=True)[0]

print(output)

"참가자들이 피자를 만드는 요리 대회를 보여주는 동영상입니다."와 같이 출력할 수 있습니다.

문서 해상도

PDF 또는 이미지를 업로드하고, 이미지 인식과 유사한 코드를 사용하고, 프롬프트를 "테이블 데이터 추출"로 변경하면 모델이 다음과 같은 구조화된 결과를 반환합니다:

[{"列1": "值1", "列2": "值2"}]

지능형 에이전트

디바이스를 제어하고 싶으신가요? 사용 cookbooks/computer_use.ipynb 예시. 실행 후 "메모장을 열고 'Hello'를 입력"하면 모델이 작업을 시뮬레이션하고 결과를 반환합니다.

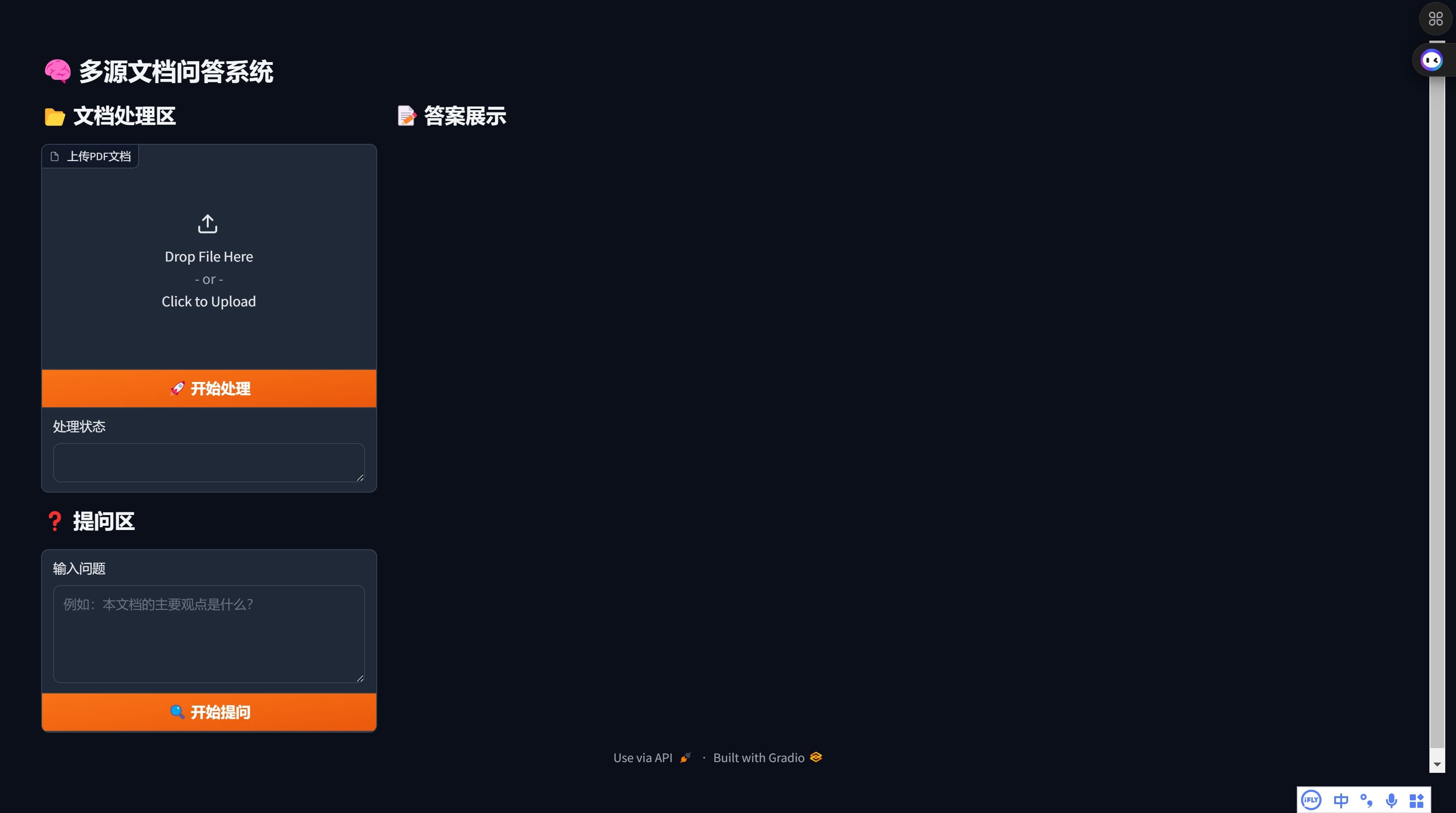

웹 인터페이스 사용

움직여야 합니다. web_demo_mm.py 웹 인터페이스를 시작합니다:

python web_demo_mm.py

브라우저 액세스 http://127.0.0.1:7860파일을 업로드할지 명령을 입력할지 잘 모르겠다면 모델이 직접 처리합니다.

성능 최적화

- 플래시 주의 2가속 추론, 설치 후 사용:

pip install -U flash-attn --no-build-isolation python web_demo_mm.py --flash-attn2 - 해상도 조정: 설정

min_pixels노래로 응답max_pixels256~1280 범위와 같은 이미지 크기를 제어하여 속도와 메모리의 균형을 맞출 수 있습니다.

애플리케이션 시나리오

- 학술 연구

학생이 논문 이미지를 업로드하면 모델이 수식과 데이터를 추출하고 분석을 생성합니다. - 비디오 클립

제작자가 긴 동영상을 입력하면 모델이 주요 클립을 추출하여 요약을 생성합니다. - 엔터프라이즈 문서 관리

직원이 계약서 스캔본을 업로드하면 모델이 해당 조항을 추출하여 양식을 출력합니다. - 지능형 어시스턴트

사용자는 사진과 음성 명령을 사용하여 휴대폰에서 비행 정보를 조회할 수 있는 모델을 불러옵니다.

QA

- 어떤 언어가 지원되나요?

중국어, 영어 및 다국어(예: 프랑스어, 독일어)를 지원하고 다국어 텍스트 및 손글씨 콘텐츠를 인식합니다. - 하드웨어 요구 사항은 무엇인가요?

3B 모델은 8GB, 7B는 16GB의 비디오 메모리가 필요하며, 32B 및 72B는 24GB 이상의 비디오 메모리가 있는 전문가용 장치를 권장합니다. - 초장편 동영상은 어떻게 처리하나요?

모델은 동적 프레임 속도로 샘플링되며 몇 시간 분량의 동영상을 이해하고 세컨드 레벨 이벤트를 정확히 파악할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...