원본: The고밀도 X 검색: 어떤 검색 세분성을 사용해야 할까요?그리고

참고: 이 방법은 오픈아이 시리즈, 클로드 시리즈, 믹스트랄, 이, 퀀 등과 같은 소수의 모델에 적합합니다.

초록

오픈 도메인 자연어 처리(NLP) 작업에서 고밀도 검색은 관련 문맥 또는 세계 지식을 획득하는 데 중요한 방법이 되었습니다. 추론 시 코퍼스를 검색하기 위해 학습된 고밀도 검색기를 사용할 때 종종 간과되는 설계 선택은 검색 단위, 즉 문서, 단락 또는 문장과 같이 코퍼스가 색인되는 세분성입니다. 검색 단위의 선택은 검색 성능뿐만 아니라 다운스트림 작업의 성능에도 상당한 영향을 미치는 것으로 나타났습니다. 문단이나 문장을 사용하는 기존의 접근 방식과 달리, 집중적인 검색을 위해 새로운 검색 단위인 명제를 도입했습니다. 명제는 텍스트의 원자적 표현으로 정의되며, 각 명제는 고유한 사실을 캡슐화하여 간결하고 독립적인 자연어 형식으로 표시됩니다. 다양한 검색 세분성을 경험적으로 비교합니다. 그 결과, 명제 기반 검색이 밀도 높은 검색에서 기존의 단락 또는 문장 기반 접근 방식보다 훨씬 뛰어난 성능을 발휘하는 것으로 나타났습니다. 또한, 명제별 검색은 검색된 텍스트에 질문과 관련된 정보가 보다 간결하게 포함되어 긴 입력 토큰의 필요성을 줄이고 관련 없는 정보의 포함을 최소화하기 때문에 다운스트림 질문-답변(QA) 작업의 성능을 향상시킵니다.

1 소개

고밀도 검색기는 지식 집약적인 작업을 위해 외부 정보 소스에 액세스하는 데 사용되는 기술 클래스입니다. 학습된 고밀도 검색기를 사용하여 말뭉치에서 검색하려면 먼저 검색 단위, 즉 추론에서 검색된 말뭉치를 세분화하고 색인하는 세분성을 결정해야 합니다. 실제로 문서, 고정 길이의 단락 또는 문장 등 검색 단위의 선택은 일반적으로 고밀도 검색 모델이 인스턴스화되거나 학습된 방식에 따라 미리 결정됩니다.

이 백서에서는 고밀도 검색 추론에서 간과되어 온 연구 질문, 즉 검색된 코퍼스를 어느 정도의 검색 세분성으로 분류하고 색인화해야 할까요? 추론할 때 적절한 검색 세분성을 선택하는 것이 검색과 다운스트림 작업 모두에서 고밀도 검색기의 성능을 향상시키는 간단하지만 효과적인 전략이 될 수 있음을 발견했습니다.

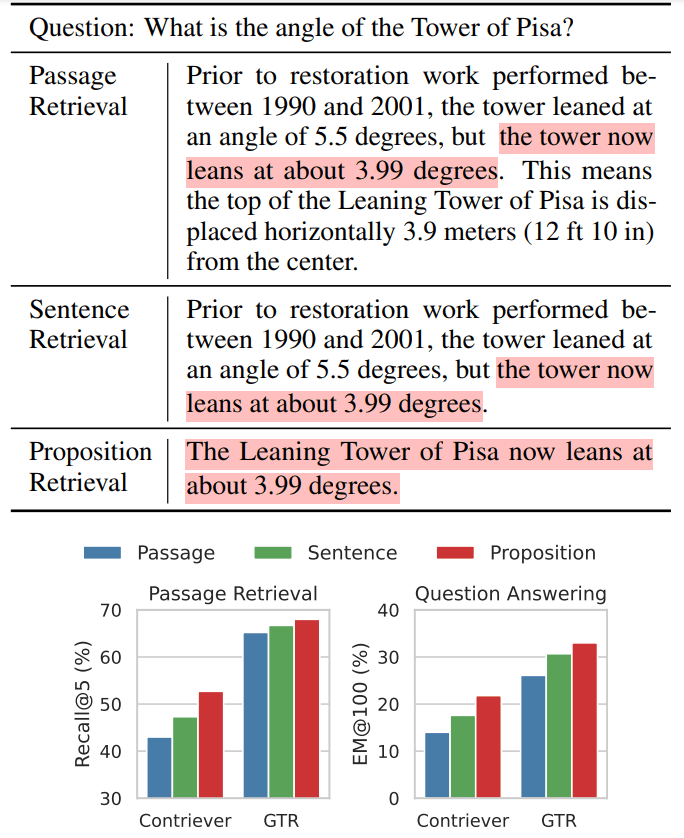

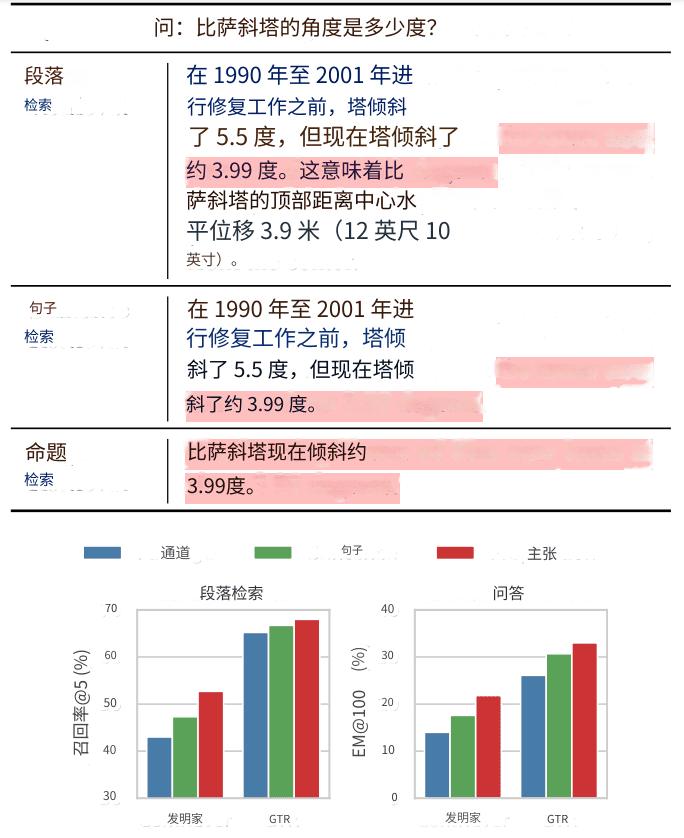

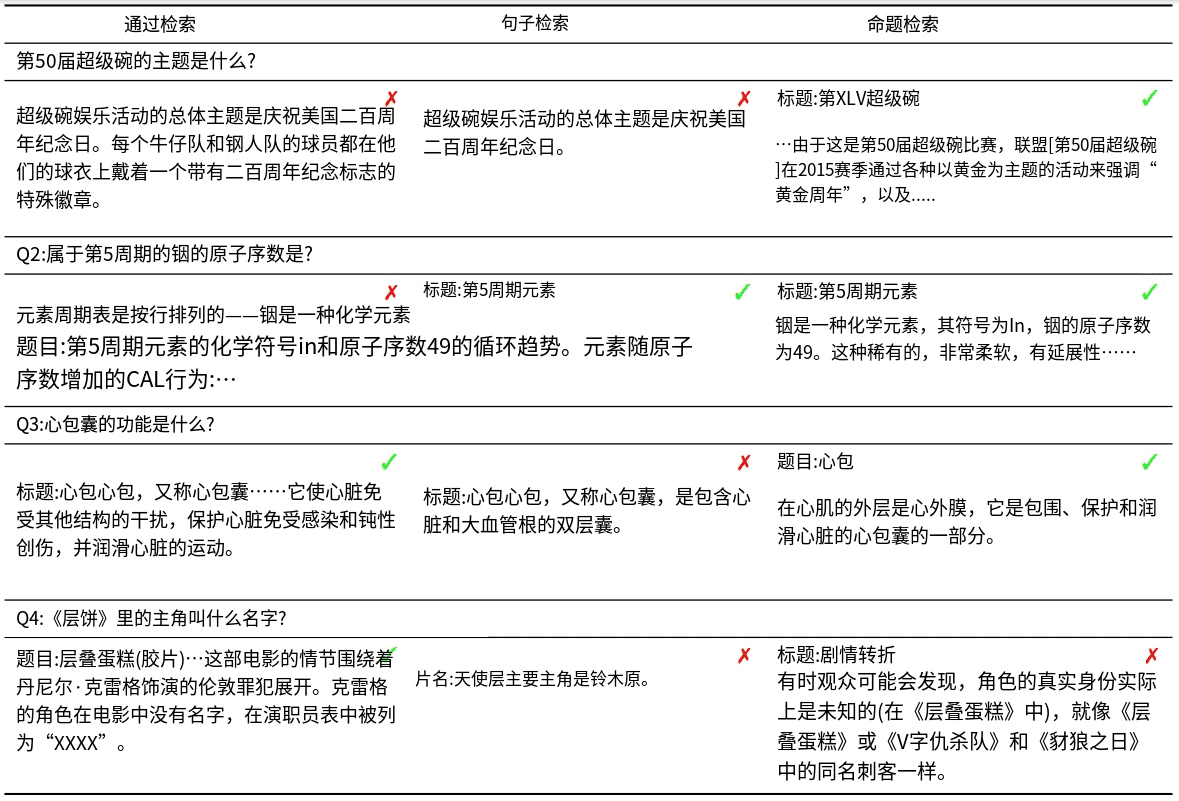

오픈 도메인 QA(질문 및 답변)의 예를 통해 이러한 직관을 설명합니다(표 1).

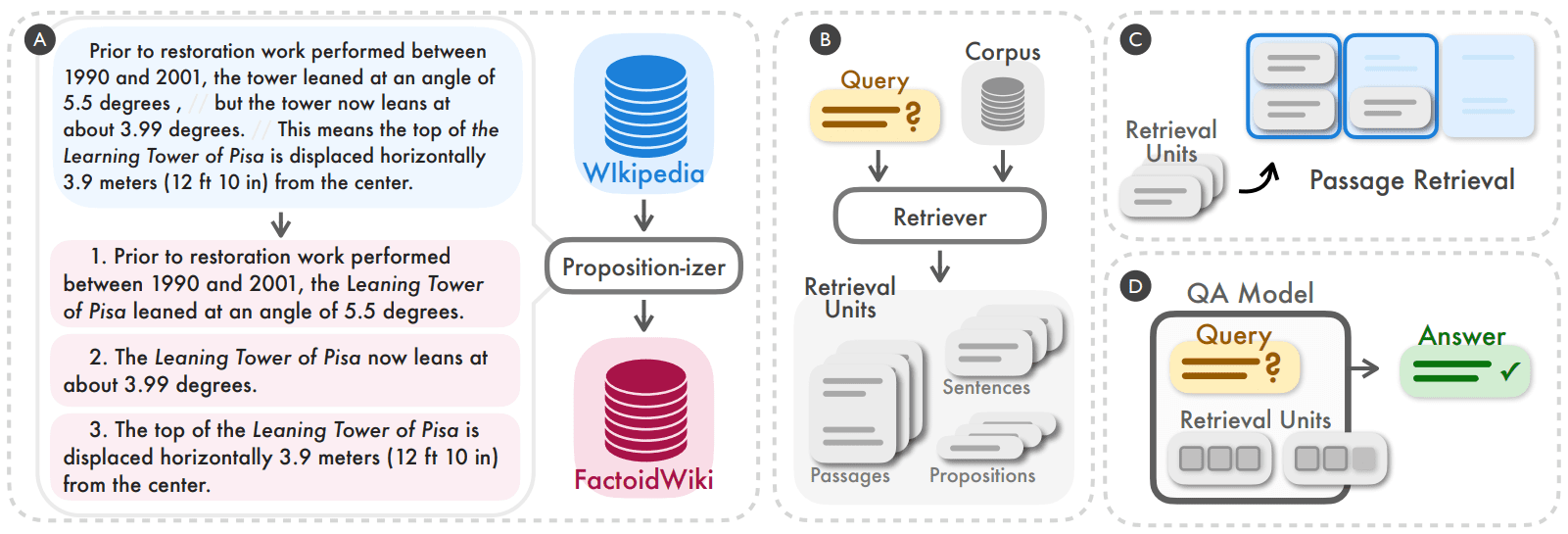

표 1 그림 1: 집중 검색을 사용할 때 Wikipedia 텍스트에 대한 세 가지 검색 세분화의 예시

상단: 밀도 검색 방법을 사용할 때 Wikipedia 텍스트를 세 가지 검색 단위로 나눌 수 있음을 보여줍니다.

결론: 문단 검색 작업과 다운스트림 오픈 도메인 질의응답(QA) 작업 모두에서 명제(명제)를 통한 검색이 가장 우수한 검색 성능을 보인 것으로 나타났습니다. 예를 들어, Contriever(Izacard 외, 2022) 또는 GTR(Ni 외, 2022)이 백본 검색기로 사용되었습니다. 강조 표시된 섹션은 질문에 대한 답변이 포함된 섹션을 나타냅니다.

이 예는 동일한 모델이 세 가지 세분화 수준에서 텍스트를 검색하는 것을 보여줍니다. 이론적으로는 더 거친 세분성을 나타내는 구절이 질문에 더 관련성 높은 정보를 제공할 수 있습니다. 그러나 문단에는 종종 검색기와 하위 작업의 언어 모델(예: 표 1의 예에서 복구 기간 및 수평 이동)의 주의를 분산시킬 수 있는 추가 세부 정보가 포함되어 있습니다. 반면에 문장 수준 색인화는 보다 세분화된 접근 방식을 제공하지만 이 문제를 완전히 해결하지는 못합니다. 왜냐하면 문장은 여전히 복잡하고 복합적일 수 있으며, 일반적으로 쿼리-문서 관련성을 판단하는 데 필요한 문맥 정보가 부족하여 독립적이지 않기 때문입니다.

기존 검색 단위(예: 단락 또는 문장)의 이러한 단점을 해결하기 위해 집중적인 검색을 위한 새로운 검색 단위로 명제를 사용할 것을 제안합니다. 명제는 텍스트의 원자적 표현으로 정의되며, 각 표현은 고유한 사실을 캡슐화하여 간결하고 독립적인 자연어 형식으로 표시됩니다. 표 1에 명제의 예가 나와 있습니다. 이 명제는 피사의 사탑의 현재 기울기 각도에 대한 정보를 독립적인 방식으로 설명하며 질문의 질의에 정확히 응답합니다. 섹션 2에서 더 자세한 정의와 설명을 제공합니다.

고밀도 리트리버 추론을 위한 검색 단위로 명제를 사용하는 것의 효과를 검증하기 위해 먼저 모든 문서를 명제로 분할하는 영어 위키백과 덤프를 처리하고 색인화했습니다. 그 다음 5가지 오픈 도메인 QA 데이터 세트에서 실험을 수행하여 위키백과를 문단, 문장 및 우리가 제안한 명제별로 색인화할 때 6가지 듀얼 인코더 리트리버의 성능을 경험적으로 비교했습니다. 문단, 문장, 명제별로 색인되었을 때 6개의 듀얼 인코더 리트리버의 성능을 비교했습니다. 검색 성능과 다운스트림 QA 작업에 미치는 영향을 모두 조사하는 두 가지 방식으로 평가했습니다. 특히, 섹션 5에서 설명한 대로 일반화 측면에서 명제 기반 검색이 문장 및 단락 기반 접근 방식보다 뛰어난 성능을 보인다는 사실을 발견했습니다. 이는 명제가 간결하고 콘텐츠가 풍부한 문맥으로 작용하여 밀도가 높은 검색자가 적절한 문맥을 유지하면서 정확한 정보에 액세스할 수 있게 해준다는 것을 시사합니다. 구문 기반 검색의 평균 리콜 @20에서의 개선은 비지도 밀도 검색의 경우 +10.1, 지도 검색의 경우 +2.2입니다. 또한 섹션 VI에서 설명한 대로 명제 기반 검색을 사용할 때 다운스트림 QA 성능에서 분명한 이점이 있는 것으로 관찰되었습니다. 언어 모델에서 입력 토큰의 길이가 일반적으로 제한되어 있다는 점을 감안할 때, 명제는 본질적으로 더 높은 밀도의 질문 관련 정보를 제공합니다.

우리 백서의 주요 기여는 다음과 같습니다:

- 집중적인 검색 성능을 개선하기 위해 검색된 말뭉치를 색인할 때 명제를 검색 단위로 사용할 것을 제안합니다.

- 각 페이지가 100단어 단락, 문장, 명제 등 여러 세부 단위로 나뉘어져 있는 영어 위키백과 덤프를 처리한 FACTOIDWIKI를 소개합니다.

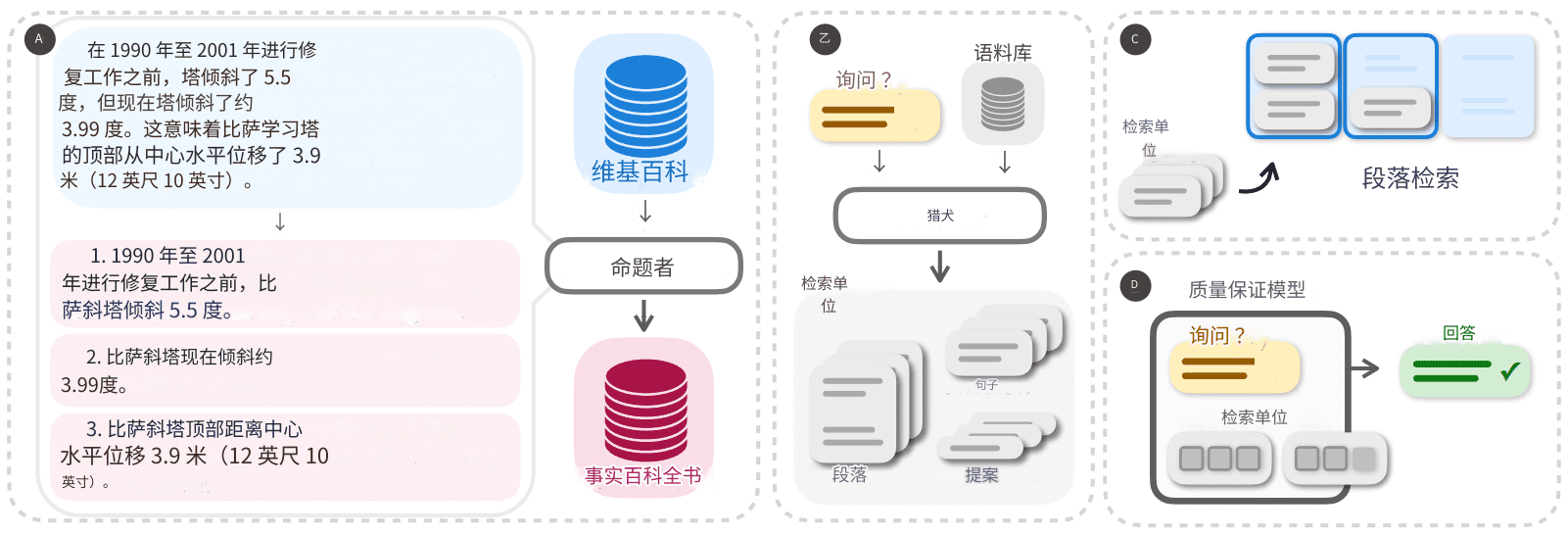

그림 2: 검색 코퍼스를 명제 수준에서 분할하고 색인을 생성하는 것이 추론할 때 고밀도 검색기의 일반화 성능을 향상시키는 간단하고 효과적인 전략이 될 수 있다는 사실을 발견했습니다(A, B). 100단어 단락, 문장 또는 명제 수준에서 작업할 때 검색 및 다운스트림 오픈 도메인 질의응답(QA) 작업에서 고밀도 검색기의 성능을 경험적으로 비교합니다(C, D).

2 검색 단위로서의 구문

이 연구의 목표는 검색 코퍼스의 세분성이 고밀도 검색 모델의 성능에 어떤 영향을 미치는지 경험적으로 이해하는 것입니다. 100단어 단락이나 문장과 같이 일반적으로 사용되는 검색 단위 외에도, 검색 단위의 대안으로 명제를 사용할 것을 제안합니다. 여기서 명제는 텍스트에서 의미의 원자적 표현을 나타내며 다음 세 가지 원칙에 의해 정의됩니다.

- 각 명제는 텍스트의 고유한 의미 조각에 해당해야 하며, 모든 명제의 조합은 전체 텍스트의 의미를 나타냅니다.

- 명제는 최소한이어야 합니다. 즉, 별도의 명제로 더 이상 분할할 수 없습니다.

- 명제는 문맥에 맞고 독립적으로 구성되어야 합니다. 명제는 그 의미를 설명하기 위해 텍스트에서 필요한 모든 문맥(예: 공동 참조)을 포함해야 합니다.

명제를 검색 단위로 사용하는 것은 명제 수준에서 텍스트의 의미를 표현하고 평가하는 데 성공한 일련의 최근 작업에서 영감을 얻었습니다. 그림 2의 왼쪽 예시를 통해 명제의 개념과 문단을 명제 집합으로 분할하는 방법을 설명합니다. 이 문단에는 복원 전 각도, 현재 각도 및 수평 변위라는 피사의 사탑에 대한 고유한 사실에 해당하는 세 가지 명제가 각각 포함되어 있습니다. 각 명제 안에는 구절에서 필요한 문맥이 포함되어 있어 명제의 의미를 원문과 독립적으로 해석할 수 있습니다(예: 첫 번째 명제에서 탑에 대한 언급은 피사의 사탑이라는 정식 명칭으로 파싱됩니다). 우리는 각 명제가 맥락화된 원자적 사실을 정확하게 설명할 것으로 기대하기 때문에 명제가 정보 검색 문제의 검색 단위로 적합할 것이라는 직관을 가지고 있습니다.

3 팩트오이드위키: 위키피디아의 명제 수준 색인 및 검색

100단어 단락, 문장, 명제를 Wikipedia에서 검색 단위로 사용하는 것을 경험적으로 비교했습니다. Wikipedia는 지식 집약적인 NLP 작업에서 일반적으로 사용되는 검색 소스입니다. 다양한 세부 수준에서 공정한 비교를 허용하기 위해 Bohnet 외(2021)에서 사용한 대로 2022-10-13 영어 위키백과 덤프를 처리했습니다. 각 문서 텍스트를 100단어 단락, 문장, 명제의 세 가지 세부 단위로 나누었습니다. 우리는 동일한 세분성을부록 A에는 단락 및 문장 수준 분할 코퍼스에 대한 자세한 정보가 포함되어 있습니다.

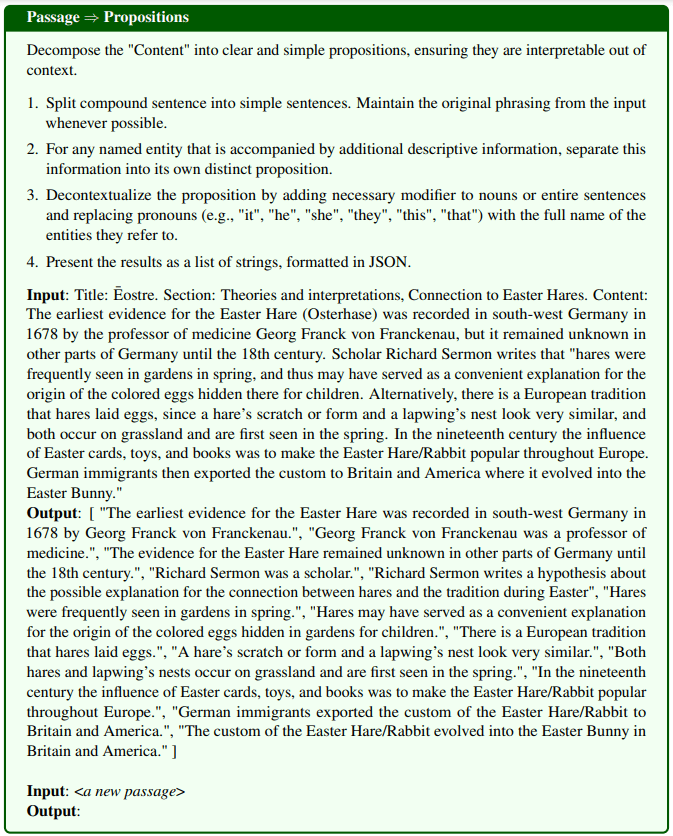

의역된 구절은 명제입니다:위키백과 페이지를 명제로 나누기 위해, 우리는 명제 생성기라고 부르는 텍스트 생성 모델을 미세 조정했습니다. 명제 생성기는 단락을 입력으로 받아 단락 내의 명제 목록을 생성합니다. Chen 등(2023b)의 접근 방식에 따라 2단계 증류 프로세스를 사용하여 명제 생성기를 훈련합니다. 먼저, 명제 정의와 하나의 데모 예시가 포함된 지시 큐 GPT-4를 사용합니다. 그림 8에 프롬프트에 대한 자세한 내용이 나와 있습니다. 42,000개의 구절 집합으로 시작하여 GPT-4를 사용하여 구절과 명제 쌍의 시드 집합을 생성합니다. 그런 다음 시드 세트를 사용하여 FlanT5 대형 모델을 미세 조정합니다.

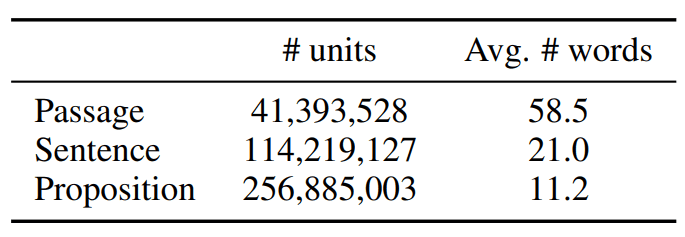

처리된 코퍼스를 팩트오이드위키라고 하며, 팩트오이드위키의 통계는 표 1에 나와 있습니다.

표 1: 2021년 10월 13일 영어 위키백과 데이터 덤프의 텍스트 단위 통계 데이터

4 실험 설정

세 가지 검색 단위 선택이 미치는 영향을 평가하기 위해 FACTOIDWIKI의 5가지 오픈 도메인 QA 데이터 세트에 대해 실험을 진행했습니다. 각 데이터 세트에 대해 고밀도 검색기가 다양한 세분성으로 색인된 위키백과를 사용할 때 문단 검색 및 다운스트림 QA 성능을 평가했습니다.

4.1 오픈 도메인 QA 데이터 세트

위키백과를 검색 소스로 사용하는 5가지 오픈 도메인 QA 데이터셋, 즉 자연스러운 질문(NQ)(Kwiatkowski 외., 2019), 퀴즈QA(TQA)(Joshi 외., 2017), 웹 질문( WebQ)(Berant 외., 2013), SQuAD(Rajpurkar 외., 2016) 및 엔티티 질문(EQ)(Sciavolino 외., 2021).

4.2 고밀도 검색 모델

다음 6가지 지도 또는 비지도 밀도 검색기 모델의 성능을 비교합니다. 여기서 지도 모델은 훈련 기간 동안 훈련된 모델을 의미하며

쿼리-단락 쌍을 감독 모델로 수동으로 레이블을 지정하거나 그 반대로 레이블을 지정할 수 있습니다.

- SimCSE 는 위키피디아에서 무작위로 선택된 라벨이 없는 문장으로 학습된 BERT 기반 인코더입니다.

- 컨트리뷰터 는 BERT 기반 인코더로 인스턴스화된 비지도 검색기이며, Contriever는 레이블이 없는 Wikipedia와 웹 크롤링 데이터의 문서 쌍으로 구성된 대비 쌍을 비교하여 학습합니다.

- DPR 는 평가에 사용된 네 가지 데이터 세트(NQ, TQA, WebQ, SQuAD)를 포함하여 5개의 오픈 도메인 QA 데이터 세트에서 미세 조정된 두 개의 인코더 BERT 기반 모델입니다.

- ANCE DPR과 동일한 설정이 사용되었으며 모델은 하드 네거티브 기반 훈련 방법인 ANCE(근사 최인접 네거티브 콘트라스트 추정)로 훈련되었습니다.

- TAS-B 는 교사 모델에서 교차 주의 훈련을 통해 추출한 두 개의 인코더 BERT 기반 모델로, MS MARCO에서 미세 조정되었습니다.

- GTR 는 레이블이 없는 온라인 포럼 QA 데이터 쌍에 대해 사전 학습되고 MS MARCO 및 Natural Question에서 미세 조정된 T5 기반 인코더입니다.

4.3 문단 검색 평가

우리는 단락, 문장 또는 명제 수준에서 말뭉치를 색인할 때 단락 수준에서 검색 성능을 평가합니다. 문장 및 명제 수준 검색의 경우, 문단의 점수는 쿼리와 문단의 모든 문장 또는 명제 간의 최대 유사도 점수를 기반으로 하는 Lee 등(2021b)이 소개한 설정을 따릅니다. 실제로는 먼저 약간 더 많은 텍스트 단위를 검색하고 각 단위를 소스 단락에 매핑한 다음 상위 k개의 고유한 단락을 반환합니다. 검색된 첫 k개의 구절에서 정답을 찾은 질문의 비율로 정의되는 recall @k를 평가 지표로 사용합니다.

4.4 다운스트림 QA 평가

다양한 검색 단위 사용이 다운스트림 오픈 도메인 QA 작업에 미치는 영향을 이해하기 위해 검색 후 읽기 설정에서 검색 모델 사용을 평가합니다. 검색 후 읽기 설정에서 검색 모델은 먼저 주어진 쿼리에 대해 k개의 텍스트 단위를 검색합니다. 그런 다음 검색된 k개의 텍스트 단위를 쿼리와 함께 리더 모델에 입력으로 사용하여 최종 답변에 도달합니다. 일반적으로 k의 선택은 입력 토큰의 수에 따라 확장되는 리더 모델의 최대 입력 길이 제약 조건 또는 계산 예산에 의해 제한됩니다.

따라서 검색된 단어의 최대 수를 l = 100 또는 500으로 제한하는 평가 설정, 즉 단락, 문장 또는 명제 수준 검색에서 처음 l 개의 단어만 리더 모델에 입력하는 평가 설정을 따릅니다. 예측된 답변이 실제 답변과 정확히 일치하는(EM) 질문의 비율을 평가합니다. 이 지표를 EM@l이라고 하며, 평가를 위해 리더 모델로는 T5 크기의 대형 UnifiedQA-v2를 사용합니다.

5 결과: 단락 검색

이 섹션에서는 검색 작업의 성능을 보고하고 논의합니다. 그 결과, 어떤 모델도 명제 수준 데이터로 훈련되지 않았지만, 모든 검색 모델은 말뭉치가 명제 수준에서 색인될 때 단락 또는 문장 기반 검색과 비슷하거나 더 우수한 성능을 보였습니다.

5.1 문단 검색 성능

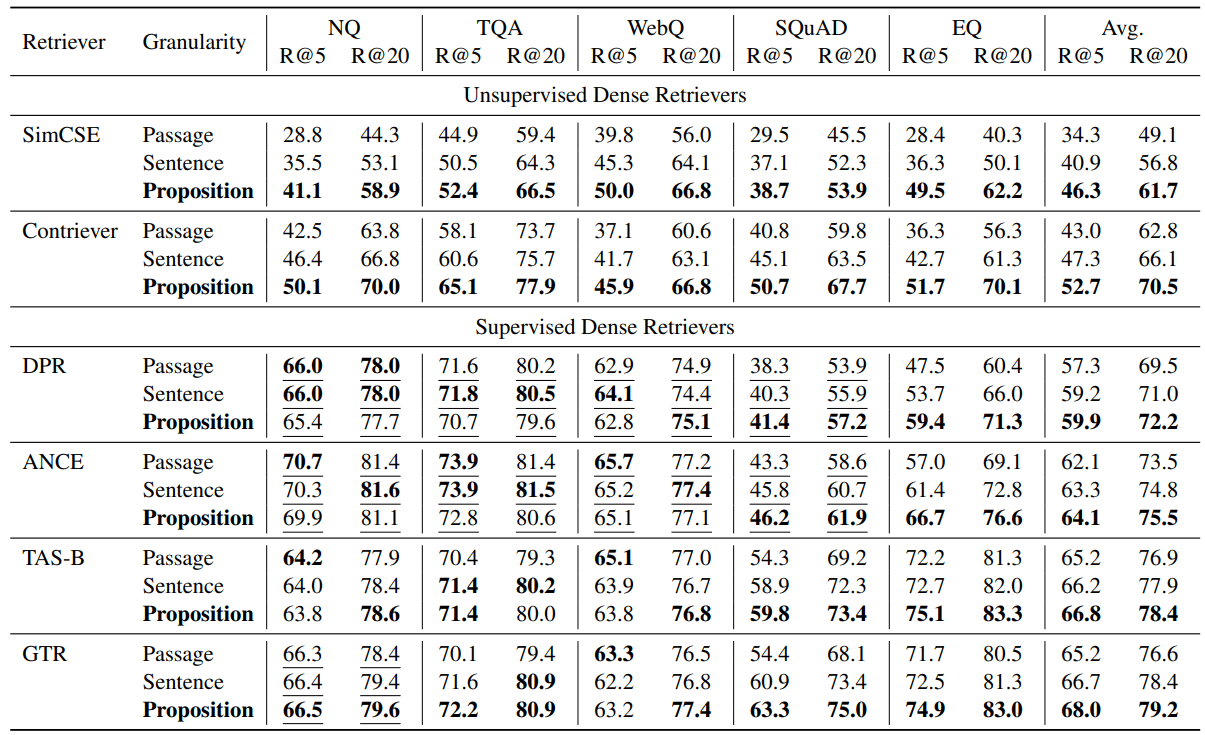

평가 결과는 표 2에 나와 있습니다. 비지도 검색기와 지도 검색기 모두에서 대부분의 작업에서 명제 기반 검색이 문장 또는 단락 기반 검색보다 성능이 뛰어난 것으로 나타났습니다.

테스트한 모든 집중 검색기에서, 명제 기반 검색은 5개의 데이터 세트에서 평균적으로 문장 및 단락 기반 검색보다 일관되게 더 나은 성능을 보였습니다. 비지도 검색기, 즉 SimCSE와 Contriever의 경우, 5개 데이터 세트에서 평균 Recall@5가 +12.0과 +9.3으로 개선되었습니다(상대적 개선은 35.01 TP3T와 22.51 TP3T입니다).

감독된 검색기의 경우, 명제 수준 검색이 여전히 평균적인 우위를 보이지만 개선 폭은 더 작습니다. 이는 이러한 검색기가 쿼리-문단 쌍에 대해 훈련되었기 때문이라는 가설을 세우고 있습니다. 예를 들어, NQ, TQA, WebQ, SQuAD에 대해 학습된 DPR과 ANCE의 경우, 제안 기반 및 문장 기반 검색은 SQuAD를 제외한 세 데이터 세트 모두에서 문단 기반 검색보다 약간 떨어지는 것으로 관찰되었습니다. 표 2에서 볼 수 있듯이, NQ, TQA 및 WebQ에서 세 가지 검색 세부 수준에서 모든 지도 검색기의 성능은 비슷합니다.

그러나 리트리버 모델이 학습 중에 보지 못했던 데이터 세트에서는 명제 기반 검색이 분명한 이점을 가지고 있는 것을 관찰했습니다. 예를 들어, SQuAD 또는 EntityQuestions에서는 명제 기반 검색이 다른 두 가지 세분성보다 훨씬 뛰어난 성능을 보이는 것을 관찰할 수 있었습니다. 17-25%에 대한 Recall@5는 상대적으로 약한 검색기인 DPR과 ANCE에 대한 EntityQuestions에서 상대적으로 개선된 것을 볼 수 있습니다. 또한, SQuAD의 명제 기반 검색에 대한 Recall@5는 TAS-B와 GTR에서 10-16%의 상대적 개선으로 가장 크게 향상되었습니다.

표 2: 사전 훈련된 고밀도 리트리버가 검색 말뭉치에서 세 가지 다른 세분성으로 작업할 때 5가지 오픈 도메인 Q&A 데이터 세트에 대한 문단 검색 성능(@k = 5, 20). 밑줄은 대상 데이터 세트의 훈련 세분화가 고밀도 리트리버의 훈련 데이터에 포함되어 있음을 나타냅니다.

5.2 명제 기반 검색 ⇒ 더 나은 교차 작업 일반화

연구 결과에 따르면 명제 기반 검색의 이점은 교차 작업 일반화 환경에서 가장 분명하게 드러납니다. 우리는 명제 기반 검색이 SQuAD와 EntityQuestions의 교차 작업 일반화에서 더 많은 성능 향상을 가져오는 것을 관찰했습니다.

개선의 원인을 더 잘 이해하기 위해 EntityQuestions에 대한 추가 분석을 수행했습니다. 엔티티 쿼션에는 롱테일 엔티티 속성을 대상으로 하는 질문이 있으므로, 질문에서 대상 엔티티의 인기도, 즉 엔티티가 Wikipedia에 얼마나 자주 나타나는지에 따라 검색 성능이 어떻게 영향을 받는지 세 가지 세부 수준에서 조사했습니다. 다음 방법을 사용하여 각 엔티티의 인기도를 추정합니다. 엔티티의 표면 형태가 주어지면 BM25를 사용하여 Wikipedia에서 처음 1,000개의 관련 구절을 검색합니다. 엔티티가 처음 1000개의 문단에서 나타나는 횟수를 인기도를 추정하는 데 사용합니다. EntityQuestion의 20,000개의 테스트 쿼리 중 약 25%의 대상 엔티티의 인기도 값이 3보다 작습니다.

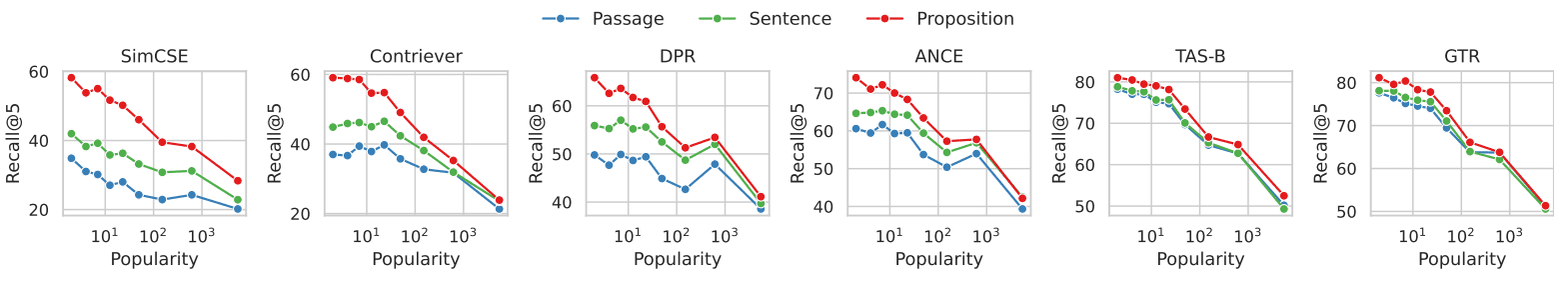

그림 3은 문단 검색의 성능과 각 문제에서 대상 엔티티의 인기도 사이의 관계를 보여줍니다. 6개의 밀도 검색기 모두에서, 덜 일반적인 엔티티를 대상으로 하는 문제에서 명제 기반 검색이 문단 기반 검색보다 더 큰 이점을 보이는 것을 관찰할 수 있습니다. 엔티티의 인기가 높아질수록 성능 격차는 감소합니다. 조사 결과에 따르면 명제 기반 검색의 성능 향상은 주로 롱테일 정보를 대상으로 하는 쿼리에 기인하는 것으로 나타났습니다. 이는 명제 기반 검색이 고밀도 검색기의 교차 작업 일반화 성능을 향상시킨다는 우리의 관찰을 반영합니다.

그림 3: 문서 검색 회수율과 EntityQuestions 데이터 세트에서 각 질문의 대상 엔터티 인기도 비교

EntityQuestions 데이터 세트에서 각 질문의 인기도(즉, 값이 작을수록 해당 엔티티가 덜 일반적이며 그 반대도 마찬가지)는 BM25가 검색한 처음 1,000개의 구절에서 엔티티의 발생 빈도로 추정했습니다.

덜 일반적인 엔티티를 포함하는 쿼리의 경우, 명제별 검색이 엔티티별 검색에 비해 더 큰 이점을 보이는 것을 관찰할 수 있습니다.

6 결과: 오픈 필드 QA

이 섹션에서는 검색 세분성 선택이 다운스트림 오픈 도메인 QA 작업에 어떤 영향을 미치는지 살펴봅니다. 리더 QA 모델에 입력되는 검색 토큰의 수가 l = 100 또는 500 단어로 제한되는 검색 후 읽기 설정에서 명제 기반 검색이 다운스트림 QA 성능에 미치는 강력한 영향을 보여 줍니다. 검색 단위로 명제를 사용할 때 평균 EM@l 메트릭의 QA 성능이 검색기 전반에서 더 높은 것으로 관찰되었습니다.

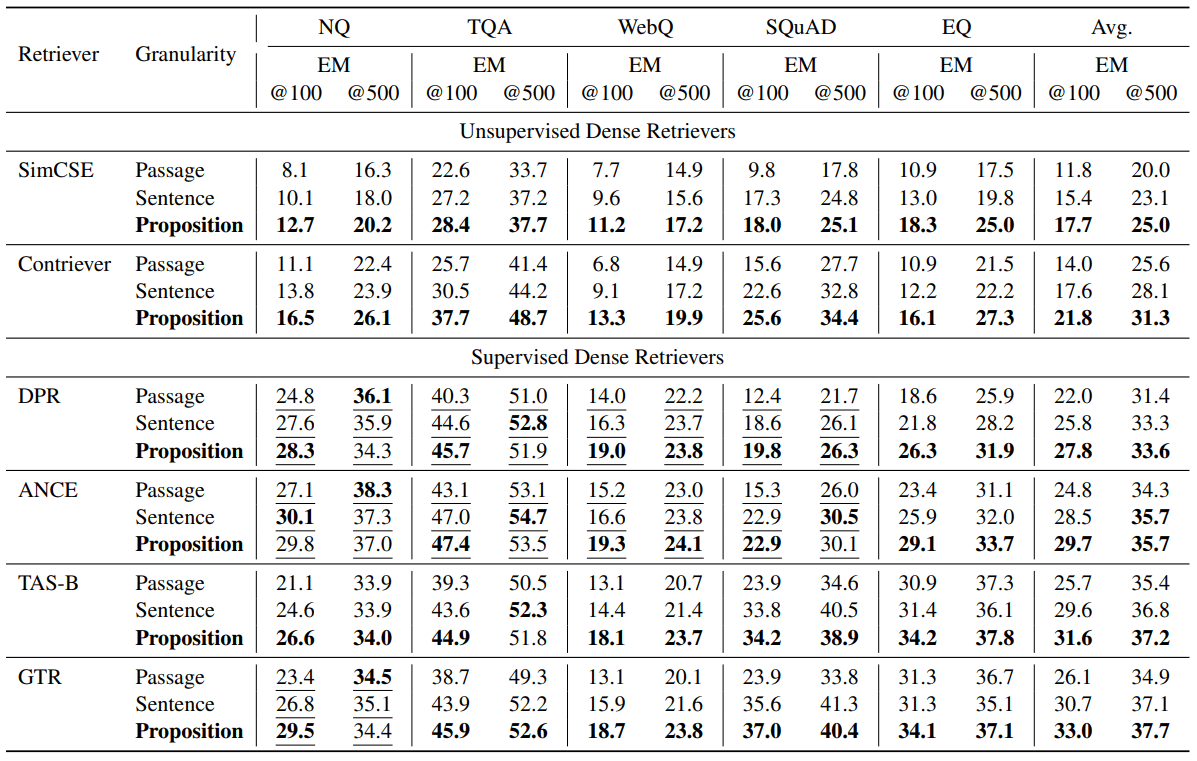

6.1 QA 성능

표 3은 평가 결과를 보여줍니다. 여러 검색기에 걸쳐, 명제를 검색 단위로 사용할 때 평균 EM@l 메트릭에서 더 높은 QA 성능이 관찰되었습니다. 비지도 리서처인 SimCSE와 Contriever는 EM@100 점수가 각각 +5.9점, +7.8점 향상되었습니다(50%와 55%의 상대적 개선). 감독형 리트리버인 DPR, ANCE, TAS-B, GTR은 EM@100에서 각각 +5.8, +4.9, +5.9, +6.9점 향상되었습니다(26%, 19%, 22%, 26%의 경우 상대적 향상). 문단 검색 평가 관찰 결과와 마찬가지로, 특히 리트리버가 대상 데이터 세트에 대해 학습되지 않은 경우, 명제 기반 검색이 다운스트림 QA 성능 측면에서 더 유리한 것으로 나타났습니다. 다른 경우에는 명제 기반 검색이 여전히 유리하지만 평균 마진이 더 작습니다.

표 3: 리더 퀴즈 모델에 전달되는 검색된 단어 수가 l = 100 또는 500으로 제한된 검색 후 읽기 설정에서의 오픈 도메인 퀴즈 성능(EM = 정확히 일치). 리더 모델로는 UnifiedQA V2(Khashabi et al., 2022)를 사용했습니다. 연결된 상위 검색된 텍스트 단위에서 처음 l개의 단어가 리더 모델에 입력으로 전달되었습니다. 밑줄은 대상 데이터 세트의 훈련 세분화가 고밀도 리트리버의 훈련 데이터에 포함되었음을 나타냅니다. 대부분의 경우 더 작은 검색 단위를 사용할수록 Q&A 성능이 향상되는 것을 확인할 수 있습니다.

6.2 명제 ⇒ 질문 관련 정보의 밀도 증가

직관적으로 문장이나 단락보다 명제가 검색 단위로 더 유리한 점은 검색된 명제가 쿼리와 관련된 정보의 밀도가 더 높다는 것입니다. 더 세분화된 검색 단위를 사용하면 쿼리에 대한 정답이 밀도가 높은 검색자의 상위 검색어에 표시될 가능성이 더 높습니다.

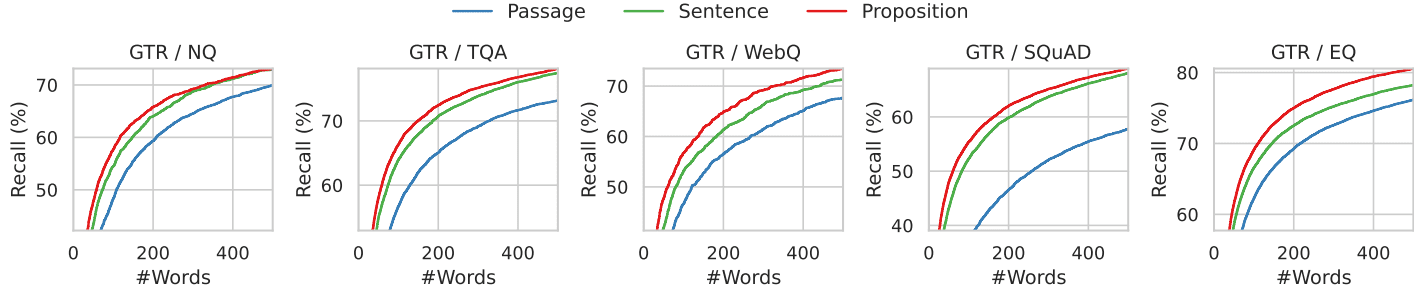

그림 4에 표시된 분석을 통해 이 현상을 설명합니다. 여기서는 검색된 첫 번째 단어에서 정답의 위치를 살펴봅니다. 구체적으로, 세 가지 다른 세분성으로 색인된 Wikipedia를 사용할 때 GTR 리트리버가 검색한 처음 l개의 단어에서 정답의 리콜을 계산합니다.

그림 4와 7의 결과는 5개의 데이터 세트 모두에 대해 0에서 500까지의 범위에서 결과를 보여줍니다. 검색 단어의 예산이 고정된 경우, 명제 검색은 약 10개 명제, 5개 문장 또는 2개 단락에 해당하는 처음 100~200개 단어 범위에서 문장 및 단락 검색 방법보다 높은 성공률을 보였습니다. 단어 수가 더 증가하면 검색된 텍스트에 질문과 관련된 모든 정보가 포함되어 있기 때문에 세 가지 세부 단위의 검색 성공률은 수렴합니다.

그림 4: 검색된 텍스트가 GTR 검색기의 첫 번째 k 단어로 제한되었을 때 골드 표준 답변의 회상률. 더 세분화된 검색은 모든 단어 수 범위에서 더 높은 회상률을 보입니다.

6.3 오류 사례 연구

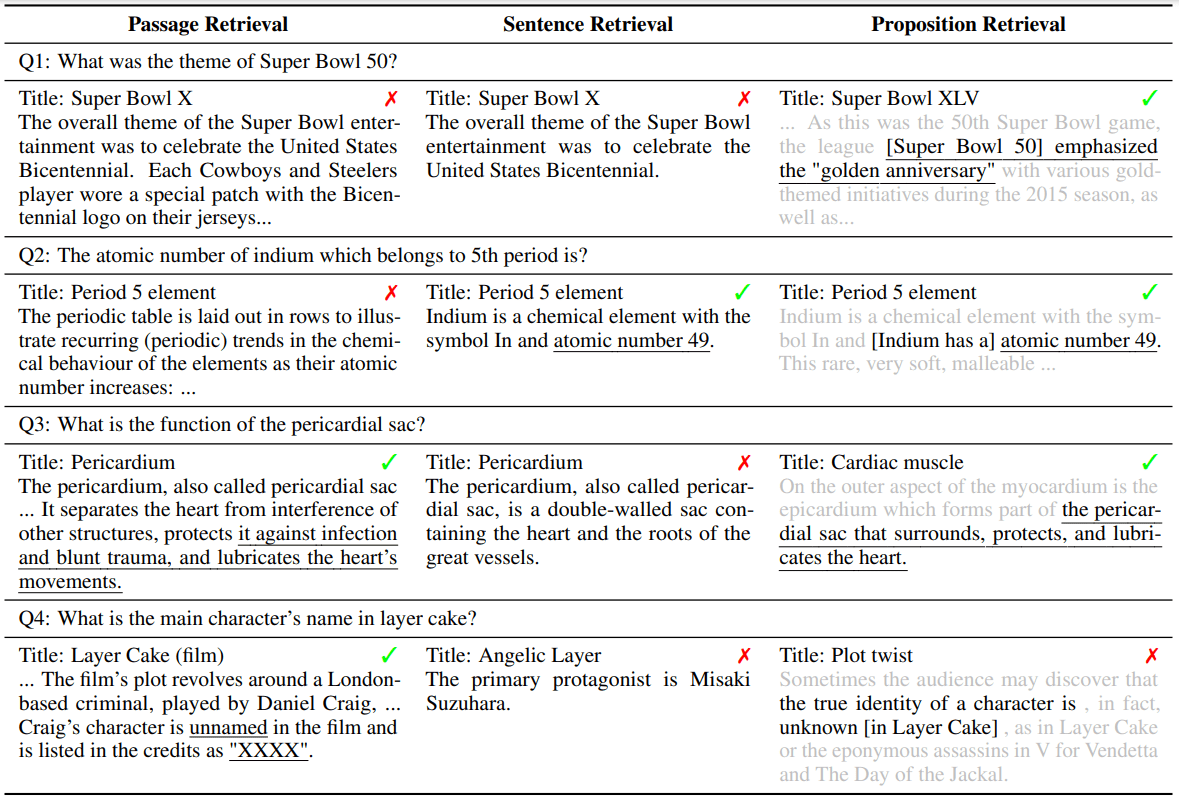

각 검색 세부 수준에서 오류의 원인을 이해하기 위해 표 4에서 네 가지 일반적인 오류 사례를 제시하고 논의합니다. 각 예에는 세 가지 세부 수준에서 GTR 검색기가 검색한 문제와 그에 해당하는 상위 1번째 텍스트 단위가 나와 있습니다.

채널 수준 검색에서 개체 또는 참조의 모호성은 밀도가 높은 검색자에게 문제를 야기하며, 이는 (Min et al., 2020)의 연구 결과를 반영합니다. 예를 들어, 예제 Q1에서 질문은 "슈퍼볼 50"을 요청하지만 검색된 문서와 문장은 "슈퍼볼 5"를 가리킵니다. 예제 Q2에서는 단락 검색이 올바른 "원자 번호"를 참조하는 섹션을 식별하지 못했습니다. 대신 검색된 첫 번째 문서가 질문과 관련이 없는 다른 문맥에서 "원자 번호"를 언급했습니다. 문장 단위 검색도 예제 Q1에서와 같이 단락 단위 검색과 비슷한 문제가 발생할 수 있으며, 문장 검색의 또 다른 문제는 문맥이 부족하다는 것입니다. 예제 Q3에서는 검색된 문서에서 올바른 문장이 심낭을 지칭하는 'it'을 사용하기 때문에 문장 기반 검색이 실패합니다.

명제 기반 검색은 각 검색 단위가 명제에 필요한 컨텍스트와 함께 하나의 사실만 포함하도록 함으로써 위의 문제를 해결합니다. 그러나 명제 기반 검색은 장거리 텍스트 분석과 관련된 멀티 홉 추론이라는 문제에 직면합니다. 예제 Q4에서 검색된 구절은 각각 배우의 이름과 그들이 맡은 역할을 설명합니다. 질문과 답변이 모두 포함된 명제는 없습니다.

표 4: 각 검색 세부 수준에서 검색된 첫 번째 순위의 텍스트 단위가 정답을 제공하지 못하는 경우를 보여주는 사례 예시입니다. 밑줄 친 텍스트가 정답입니다. 회색 텍스트는 명제의 문맥이지만 설명 목적으로만 사용되며 검색기와 다운스트림 Q&A 모델에는 제공되지 않습니다.

7 관련 작업

고밀도 검색기에 대한 최근의 작업은 일반적으로 이중 인코더 아키텍처를 사용합니다. 이중 인코더를 사용하면 각 쿼리와 문서는 저차원 특징 벡터로 개별적으로 인코딩되며, 이들 간의 상관관계는 내장된 벡터 간의 비모수적 유사도 함수를 통해 측정됩니다. 유사도 함수의 표현력이 제한적이기 때문에 이중 인코더 모델은 일반적으로 새로운 작업, 특히 훈련 데이터가 부족한 경우 일반화 능력이 떨어집니다. 이러한 이유로 이전 연구에서는 데이터 증강, 지속적인 사전 훈련, 작업 인식 훈련, 하이브리드 스파스-밀도 검색 또는 하이브리드 전략 검색과 같은 기술을 사용하여 고밀도 검색기의 교차 작업 일반화 성능을 향상시켰습니다.

우리의 작업은 부분적으로 다중 벡터 검색의 반향에 의해 동기를 부여받았습니다. 예를 들어, 검색 모델이 모델 대표성을 높이고 검색 세분성을 개선하기 위해 후보 검색 단위를 여러 벡터로 인코딩하는 방법을 학습하는 ColBERT, DensePhrase(Lee et al., 2021a,b), ME-BERT, MVR과 같은 다중 벡터 검색에 대한 반향입니다. 저희의 연구는 밀도 검색 모델이나 그 매개변수를 업데이트하지 않는 설정에 초점을 맞추고 있습니다. 검색 코퍼스를 더 세분화된 명제로 분할하는 것이 추론 중에 듀얼 인코더 고밀도 리트리버의 일반화 능력을 향상시키는 간단하고 직교적인 전략이 될 수 있음을 보여줍니다.

명제를 텍스트 표현 단위로 사용하는 아이디어는 자동 다이제스트 평가의 피라미드 접근법(Nenkova and Passonneau, 2004)으로 거슬러 올라갈 수 있는데, 여기서 모델은 각 명제를 통해 생성된 다이제스트를 평가합니다. 텍스트에서 명제를 추출하는 것은 NLP의 오랜 과제였으며, 초기에는 개방형 정보 추출, 의미론적 역할 라벨링과 같은 명제의 구조화된 표현에 중점을 두었습니다. 최근의 연구에서는 힌트가 적은 대규모 언어 모델을 사용하거나 작은 모델을 미세 조정하여 자연어 형태의 명제를 성공적으로 추출했습니다.

검색 후 읽기, 더 넓게는 검색 강화 세대는 최근 오픈 도메인 Q&A의 인기 있는 패러다임이 되었습니다. 초기 작업에서는 다운스트림 독자에게 최대 100개의 검색된 구절을 제공했지만, 최근의 대규모 언어 모델을 사용할 때는 제한된 컨텍스트 창 길이와 긴 컨텍스트를 처리할 수 없기 때문에 허용되는 컨텍스트의 양이 크게 줄어듭니다(예: 처음 10개). 최근 검색된 문서를 필터링하거나 압축하여 리더 컨텍스트의 품질을 개선하려는 노력이 시도되고 있습니다. 저희의 연구는 문맥 길이를 줄일 뿐만 아니라 더 높은 정보 밀도를 제공하는 새로운 검색 단위인 명제를 활용하여 이 문제를 효과적으로 해결합니다.

8 결론

우리는 추론 중 고밀도 검색의 성능을 개선하기 위해 말뭉치를 색인하는 검색 단위로 명제를 사용할 것을 제안합니다. 6개의 서로 다른 집중 검색기를 사용해 5개의 오픈 도메인 QA 데이터세트에 대한 실험을 통해, 고정된 검색 단어 예산으로 문단 검색 정확도와 다운스트림 QA 성능 모두에서 명제 기반 검색이 단락 또는 문장 기반 검색보다 우수하다는 사실을 발견했습니다. 6백만 페이지의 텍스트가 2억 5천만 개의 명제로 분할된 영어 위키백과 덤프의 색인화된 버전인 FACTOIDWIKI를 소개합니다. 팩트오이드위키와 이 논문의 연구 결과가 향후 정보 검색에 관한 연구에 도움이 되기를 바랍니다.

제한 사항

검색 말뭉치 세분성에 대한 현재 연구에는 다음과 같은 한계가 있습니다. (1) 검색 말뭉치 - 대부분의 오픈 도메인 QA 데이터 세트가 Wikipedia를 검색 말뭉치로 사용하기 때문에 본 연구는 검색 말뭉치로서 Wikipedia에만 초점을 맞춥니다. (2) 평가한 고밀도 검색기의 유형 - 이 백서의 현재 버전에서는 6개의 인기 있는 고밀도 검색기만 평가하며, 대부분은 이중 인코더 또는 이중 인코더 아키텍처를 따릅니다. 향후 버전에서는 더 다양한 고밀도 검색기에 대한 결과를 포함하고 논의할 예정입니다. (3) 언어 - 현재 연구는 영어 위키백과에 국한되어 있습니다. 다른 언어에 대한 탐색은 향후 작업으로 남겨둡니다.

말뭉치 검색 처리

이 연구에 사용된 영어 위키백과 덤프는 보넷 등이 2022년에 발표한 것으로, 차트, 표, 목록을 제거하도록 필터링되고 단락 형식으로 정리되어 있어 사용하기로 선택했습니다. 덤프 날짜는 2021년 10월 13일로 거슬러 올라갑니다. 이 연구를 위해 Wikipedia를 100단어 문단 블록, 문장, 명제의 세 가지 검색 단위로 세분화했습니다. 저희는 문단을 100단어 문단 블록으로 분할하는 욕심 많은 방법을 사용했습니다. 각 문단 블록에 완전한 문장이 포함되도록 하기 위해 문장의 끝 부분만 분할했습니다. 문단을 처리하면서 문장을 하나씩 추가합니다. 다음 문장을 포함하면 문단 블록이 100단어를 초과하게 되면 해당 문장부터 새 문단 블록을 시작합니다. 그러나 마지막 문단 블록이 50단어 미만이면 너무 작은 조각을 피하기 위해 이전 문단 블록과 병합합니다. 또한 널리 사용되는 Python SpaCy en_core_web_lg 모델을 사용하여 각 단락을 문장으로 분할합니다. 또한, 프로포지타이저 모델은 각 단락을 명제로 분해합니다. 총 600만 페이지를 4,139만 개의 단락, 1,142만 개의 문장, 2억 5,700만 개의 명제로 분해했습니다. 평균적으로 한 문단에는 6.3개의 명제가, 한 문장에는 2.3개의 명제가 포함되어 있습니다.

B 교육 제안자

그림 8과 같이 GPT-4를 사용하여 주어진 구절에서 프롬프트를 통해 명제 목록을 생성했습니다. 필터링 후 총 42,857개의 쌍을 사용하여 Flan-T5-Large 모델을 미세 조정했습니다. 모델 이름을 프로포지타이저라고 지었습니다. 배치 크기 64, 학습률 1e-4, 가중치 감쇠 1e-4의 AdamW 최적화기를 사용하여 3주기로 훈련했습니다. 서로 다른 모델에서 생성된 제안의 성능을 비교하기 위해 개발 세트와 평가 지표를 설정했습니다. 개발 세트에는 훈련 세트와 동일한 방법을 사용하여 GPT-4에서 수집한 1000쌍의 샘플이 추가로 포함되어 있습니다. 두 명제 세트의 F1 점수로 예측된 명제의 품질을 평가합니다. BertScore의 두 마커 세트의 F1 점수에서 영감을 받아 두 명제 세트에 대한 F1 점수를 설계합니다. P = {p1, ... , pn}은 라벨링된 명제 집합을 나타내고, ˆP = {ˆp1, ... , ˆpm}은 예측된 명제 집합을 나타냅니다. 두 명제 사이의 유사성을 표현하기 위해 sim(pi, ˆpj)를 사용합니다. 이론적으로는 모든 텍스트 유사성 메트릭을 사용할 수 있습니다. 우리는 메트릭이 명제 간의 의미적 차이를 반영하기를 원하기 때문에 BertScore를 sim 함수로 사용하기로 선택했습니다. 정의합니다:

Recall = 1 / |P| ∑(ˆP에서 ˆpj의 경우 최대(sim(pi, ˆpj))) Precision = 1 / |ˆP| ∑(pi의 경우 최대(sim(pi, ˆpj))) F1 = 2 * Precision * Recall / (Precision +) Recall)

다음은 F1 점수에 대한 그래픽 설명입니다. 재현율은 라벨링된 집합에서 생성된 집합의 명제와 유사한 명제의 비율을 나타내고, 정확도는 라벨링된 집합에서 생성된 집합의 명제와 유사한 명제의 비율을 나타내며, F1은 재현율과 정확도의 조정된 평균입니다. F1은 두 세트가 동일한 경우 1이고 두 명제가 의미적으로 다른 경우 0입니다.

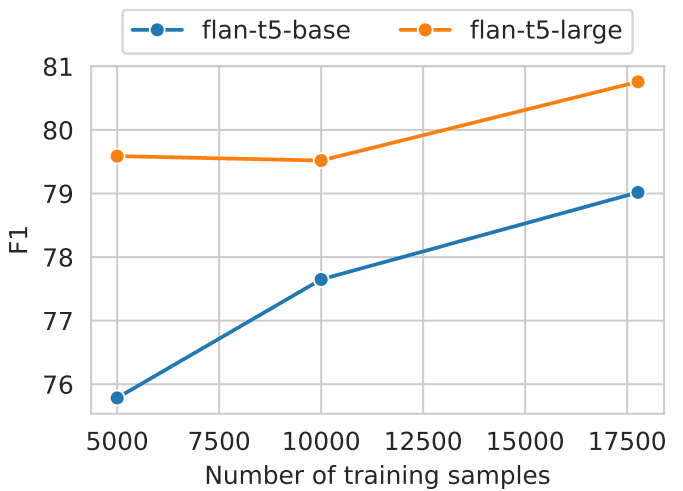

서로 다른 양의 데이터를 사용하여 학습된 기본 모델과 대형 Flan-T5 모델을 비교 분석했습니다(그림 5 참조). 연구 결과에 따르면 대량의 학습 데이터와 결합된 대형 모델이 더 나은 결과를 생성하는 것으로 나타났습니다. 명제 분석기는 F1 값 0.822를 달성했습니다. 생성된 명제를 수동으로 검토한 결과, 만족스러운 것으로 나타났습니다.

그림 5: 다양한 크기와 학습 데이터 수의 모델에 대한 명제 수준 분해 성능.

C 오프라인 색인

검색된 단위는 pyserini 및 faiss 패키지를 사용하여 임베딩으로 인코딩했습니다. 배치 크기를 64로 하여 100만 개 단위로 그룹화한 여러 개의 GPU를 사용하여 각 텍스트 단위를 인코딩했습니다. 임베딩을 전처리한 후 내부 곱(faiss.IndexFlatIP)으로 정확한 검색을 사용하여 모든 실험을 수행했으며, FACTOIDWIKI의 순수 인덱스는 약 768GB 크기입니다. 메모리 부담을 줄이기 위해 임베딩은 8개의 슬라이스로 분할됩니다. 각 슬라이스는 모든 결과를 집계하기 전에 대략적인 가장 가까운 이웃 검색을 수행합니다. 명제 수는 구절 수의 6배에 달하지만 효율적인 인덱싱 기법을 사용하면 총 벡터 수 대비 서브선형 검색 시간을 줄일 수 있습니다. 또한 GPU 병렬 처리와 분산 인덱싱을 활용하면 온라인 검색 시간을 크게 줄일 수 있습니다. 따라서 적절한 구현을 통해 명제 검색을 실용적이고 효율적인 옵션으로 만들 수 있습니다.

D 리트리버 모델

모델 구현을 위해 트랜스포머와 문장 트랜스포머 패키지를 사용했습니다. HuggingFace에 게시된 다음 체크포인트를 사용했습니다: SimCSE(princeton-nlp/unsup-simcse-bert-base-uncased), Contriever(facebook/contriever), DPR(facebook/dpr-. ctx_encoder-multiset-base, facebook/dpr-question_encoder-multiset-base), ANCE(castorini/ance-dpr-context-multi, castorini/ance-dpr-. question-multi,), TAS-B(문장-변환기/msmarco-distilbert-base-tas-b) 및 GTR(문장-변환기/gtr-t5-base).

E 추가 결과

5.2절에서는 문장 기반 검색에 비해 명제 기반 검색의 장점, 특히 엔티티의 개체 수가 감소하는 EQ에서 그 장점을 보여 드리겠습니다. 우리는 Sciavolino 등(2021)에서 사용된 엔티티에 대한 하이퍼링크 수를 사용하는 대신 BM25에서 검색된 처음 1000개 단락의 발생 횟수를 보급률의 프록시로 사용합니다. 그 결과, 성능 대 인기도 그래프(그림 6)의 추세는 우리의 결과와 Sciavolino 외(2021)의 결과 사이에 몇 가지 차이점을 보여줍니다. 예를 들어, 일부 엔티티는 모호합니다(예: 1992, TV 시리즈). 이 경우 엔티티의 표면 형태의 발생 횟수가 많습니다. 동시에 퍼지 엔티티와 관련된 질문은 대답하기 어렵기 때문에 회상률이 낮습니다. 6.2절에서는 문맥 길이의 함수로서 검색된 텍스트에서 답변의 회상률에 대해 설명합니다. 또한 그림 7에 표시된 것처럼 6개의 고밀도 검색기의 성능 추세를 보여줍니다. 그 결과, 문장이나 단락에 비해 명제에 대한 기억력이 일관되게 더 우수하다는 것을 알 수 있습니다. 이러한 결과는 문장이나 단락에 비해 명제에 질문과 관련된 단위의 밀도가 더 높다는 결론으로 이어집니다.

그림 8: GPT-4를 사용하여 문서에서 제안서를 생성하기 위한 힌트.

'콘텐츠'를 명확하고 간단한 명제로 분해하여 해석이 가능한지 확인합니다.

컨텍스트에 따라 다릅니다.

1. 복합 문장을 간단한 문장으로 분리합니다. 입력한 원래 문구를 유지합니다.

를 사용하세요.

2. 추가 설명 정보가 수반되는 명명된 엔티티의 경우 이 부분을 구분합니다.

정보를 고유한 명제로 전환합니다.

3. 명사 또는 문장 전체에 필요한 수식어를 추가하여 명제를 문맥에서 벗어나게 합니다.

대명사(예: "그것", "그", "그녀", "그들", "이것", "저것")를 전체 이름으로 대체합니다.

엔티티를 참조합니다.

4. 결과를 JSON 형식의 문자열 목록으로 표시합니다.입력. 제목: 에오스트레. 섹션: 이론과 해석, 부활절 토끼와의 연결. 내용: ¯

부활절 토끼(오스터하세)에 대한 최초의 증거는 독일 남서부에서 기록되었습니다.

1678 년 의학 교수 게오르그 프랑크 폰 프랑크 나우에 의해 알려지지 않았지만

18세기까지 독일의 다른 지역에서 사용되었습니다. 학자 리처드 설교는 "산토끼는

봄철 정원에서 자주 볼 수 있으므로 편리한 설명으로 작용했을 수 있습니다.

또는 '첫 번째 유럽 계란'의 한 형태인 '첫 번째 유럽 계란'과 '두 번째 유럽 계란'의 한 형태인 '두 번째 유럽 계란'이라는 유럽 전통이 있습니다.

토끼의 상처나 형태와 랩윙의 둥지가 매우 유사하기 때문에 토끼가 알을 낳았다고 생각합니다.

둘 다 초원에서 발생하며 봄에 처음 나타납니다. 19 세기에는 다음과 같은 영향이있었습니다.

부활절 카드, 장난감, 책 등을 통해 유럽 전역에서 부활절 토끼/토끼를 인기 있는 캐릭터로 만들었습니다.

독일 이민자들은 이 관습을 영국과 미국으로 수출하여

부활절 토끼."

출력. ["부활절 토끼에 대한 최초의 증거는 남서부 독일에서 기록되었습니다.

1678 년 게오르그 프랑크 폰 프랑케 나우.", "게오르그 프랑크 폰 프랑케 나우는 교수였습니다.

의학.", "부활절 토끼에 대한 증거는 독일의 다른 지역에서는 알려지지 않았습니다.

18세기까지.", "리처드 설교는 학자였다.", "리처드 설교는 가설을 씁니다.

부활절 기간 동안 토끼와 전통의 연관성에 대한 가능한 설명에 대해 설명합니다."

"산토끼는 봄에 정원에서 자주 보였습니다.", "산토끼는 편리한 역할을했을 수 있습니다.

아이들을 위해 정원에 숨겨진 색 계란의 기원에 대한 설명.", "어린이를위한 정원에 숨겨진 색 계란의 기원에 대한 설명이 있습니다.

토끼가 알을 낳는 유럽의 전통.", "토끼의 상처 나 형태와 랩 윙의 둥지가 매우 좋아 보입니다.

비슷하다.", "산토끼와 랩윙의 둥지는 모두 초원에서 발생하며 봄에 처음 보입니다.", "산토끼와 랩윙의 둥지는 모두 초원에서 발생하며 봄에 처음 보입니다.", "산토끼와 랩윙의 둥지는 모두 초원에서 발생하며 봄에 처음 보입니다.".

"19세기에는 부활절 카드, 장난감, 책 등의 영향으로 부활절을

토끼 / 토끼는 유럽 전역에서 인기가 있습니다.", "독일 이민자들은 관습을 수출했습니다.

부활절 토끼 / 토끼가 영국과 미국으로.", "부활절 토끼 / 토끼의 관습은 다음과 같이 진화했습니다.

영국과 미국의 부활절 토끼"]입력. <a new passage>

출력.

'콘텐츠'를 명확하고 단순한 아이디어로 분류하여 원래의 맥락에서 벗어났을 때 의미가 있는지 확인합니다.

1. 복합 문장을 간단한 문장으로 나누고 가능하면 원래의 형태를 유지합니다.

2. 추가 설명 정보가 있는 특정 엔티티의 경우 이 정보는 별도의 어설션으로 분리됩니다.

3. 명사 또는 문장 전체에 필요한 수식어를 추가하거나 대명사(예: "it", "he", "she", "they", "this", "that")를 참조하는 주체의 전체 이름으로 대체하여 문맥에서 벗어난 주장을 하는 행위입니다.

4. 결과를 문자열 목록으로 표시하고 JSON 형식을 사용합니다.입력:제목: 부활절 토끼에 대한 이론과 설명, 부활절 토끼에 대한 링크. 내용: 부활절 토끼(오스터하세)에 대한 최초의 증거는 1678년 독일 남서부의 게오르크 프랑크 폰 프랑케나우에 의해 기록되었지만 18세기까지 독일의 다른 지역에서는 알려지지 않았습니다. 학자 리하르트 설교는 "산토끼는 봄에 정원에서 자주 볼 수 있었기 때문에 아이들이 정원에서 발견한 색깔 달걀의 기원에 대한 편리한 설명으로 사용되었을 수 있다"고 말합니다. 또한 유럽에서는 산토끼가 알을 낳는 모양이 밀새의 둥지와 비슷하고 초원에서 발견되며 봄에 처음 발견되기 때문에 산토끼가 알을 낳는다는 전통이 있습니다. 19세기에는 부활절 카드, 장난감, 책 등의 영향으로 이스터 버니가 유럽 전역에서 인기를 얻게 되었습니다. 그 후 독일 이민자들에 의해 영국과 미국으로 퍼져나간 이 관습은 현재 우리가 알고 있는 이스터 버니로 발전했습니다."

출력:["부활절 토끼와 관련된 최초의 증거는 1678년 독일 남서부의 게오르크 프랑크 폰 프랑크나우가 발견한 것입니다." , "게오르그 프랑크 폰 프랑케나우는 의학 교수였습니다." , "18세기가 되어서야 독일의 다른 지역 사람들이 부활절 토끼의 증거에 대해 배우기 시작했습니다." , "리처드 설교는 학자였다." , "리처드 설교는 토끼와 부활절의 전통적인 연관성에 대한 가능한 설명에 대한 가설을 제시했습니다.", "토끼는 봄철 정원에서 종종 볼 수 있습니다.". , "토끼는 아이들이 정원에서 색색의 달걀을 찾는 이유에 대한 간단한 설명일 수 있습니다." 등의 의견을 제시했습니다. , "유럽에서는 토끼가 알을 낳는다는 전통적인 견해가 있습니다." , "토끼의 긁힌 자국이나 형태는 초원에서 발견되고 봄에 처음 발견되는 밀새의 둥지와 매우 유사합니다." , "토끼의 알은 봄에 처음 발견됩니다." , "19세기에 부활절 토끼는 부활절 카드, 장난감, 책 등의 인기로 인해 유럽에서 널리 알려지게 되었습니다." , "독일 이민자들이 이스터 버니의 풍습을 영국과 미국으로 가져왔다." , "영국과 미국에서 이스터 버니의 관습은 점차 우리가 알고 있는 이스터 버니로 발전했습니다." ]입력: <新的段落>

출력:

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...