일반 소개

파스크레이프는 개발자 폴 로벨로가 GitHub에서 출시한 Python 기반 오픈 소스 웹 크롤러로, 사용자가 웹 페이지에서 데이터를 지능적으로 추출할 수 있도록 설계되었습니다. 두 가지 강력한 브라우저 자동화 기술인 셀레늄과 플레이라이트를 통합하고 이를 AI 처리 기능과 결합하여 단순한 정적 페이지부터 복잡한 동적 웹사이트까지 데이터 크롤링을 지원합니다. 가격, 제목 또는 기타 구조화된 정보를 추출하든, 파스크레이프는 필드를 지정하여 작업을 빠르게 완료하고 결과를 마크다운, JSON 또는 CSV로 출력합니다. 웹에서 정보 수집을 자동화하려는 개발자, 데이터 분석가 또는 사용자를 위한 프로젝트로, 설치가 간편하고 유연한 기능으로 오픈 소스 커뮤니티에서 인기가 높습니다.

기능 목록

- 지능형 데이터 추출OpenAI 또는 Anthropic과 같은 AI 모델을 통해 웹 콘텐츠를 분석하여 사용자가 지정한 필드를 정확하게 추출합니다.

- 듀얼 크롤러 지원이 웹사이트는 다양한 웹사이트 아키텍처에 적용할 수 있는 셀레늄과 플레이위트 기술을 모두 지원합니다.

- 다양한 출력 형식캡처 결과를 마크다운, JSON, CSV 또는 Excel로 내보낼 수 있어 후속 처리가 용이합니다.

- 사용자 지정 필드 캡처제목, 설명, 가격 등 추출할 필드를 지정하여 개인화된 요구 사항을 충족할 수 있습니다.

- 병렬 캡처멀티 스레드 크롤링을 지원하여 대규모 데이터 수집의 효율성을 개선합니다.

- 대기 메커니즘동적 콘텐츠 크롤링의 성공을 보장하기 위해 다양한 페이지 로딩 대기 방법(예: 일시 중지, 선택기 대기)을 제공하세요.

- AI 모델 선택다양한 작업에 유연하게 적응할 수 있도록 여러 AI 제공업체(예: OpenAI, Anthropic, XAI)를 지원합니다.

- 캐시 최적화힌트 캐싱 기능이 내장되어 있어 반복 요청으로 인한 비용을 줄이고 효율성을 개선합니다.

도움말 사용

설치 프로세스

par_scrape를 사용하려면 먼저 다음 설치 단계를 완료하여 환경이 잘 준비되었는지 확인해야 합니다. 다음은 자세한 설치 가이드입니다:

1. 환경 준비

- Python 버전명령을 사용하여 시스템에 Python 3.11 이상이 설치되어 있는지 확인합니다.

python --version확인. - Git 도구GitHub에서 코드를 복제하는 데 사용되며, 설치되어 있지 않은 경우 다음을 통해 액세스할 수 있습니다.

sudo apt install git(Linux) 또는 공식 웹사이트에서 다운로드하여 설치하세요. - UV 도구설치 명령은 UV를 사용하여 종속성을 관리하는 것이 좋습니다:

- Linux/Mac:

curl -LsSf https://astral.sh/uv/install.sh | sh - Windows:

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

- Linux/Mac:

2. 프로젝트 복제

터미널에 다음 명령을 입력하여 로컬에 par_scrape 프로젝트를 복제합니다:

git clone https://github.com/paulrobello/par_scrape.git

cd par_scrape

3. 종속성 설치

UV를 사용하여 프로젝트 종속성을 설치합니다:

uv sync

또는 PyPI에서 직접 설치하세요:

uv tool install par_scrape

# 或使用 pipx

pipx install par_scrape

4. Playwright 설치(선택 사항)

크롤러로 Playwright를 선택하는 경우 브라우저를 추가로 설치 및 구성해야 합니다:

uv tool install playwright

playwright install chromium

5. API 키 구성

par_scrape는 여러 AI 공급자를 지원하므로 환경 변수에서 해당 키를 구성해야 합니다. 편집 ~/.par_scrape.env 파일에 다음을 추가합니다(필요에 따라 선택):

OPENAI_API_KEY=your_openai_key

ANTHROPIC_API_KEY=your_anthropic_key

XAI_API_KEY=your_xai_key

또는 명령을 실행하기 전에 환경 변수를 설정하세요:

export OPENAI_API_KEY=your_openai_key

사용법

설치가 완료되면 명령줄에서 par_scrape를 실행할 수 있으며, 자세한 절차는 다음과 같습니다:

기본 사용 예

OpenAI 가격 페이지에서 제목, 설명 및 가격을 추출하고 싶다고 가정해 보겠습니다:

par_scrape --url "https://openai.com/api/pricing/" -f "Title" -f "Description" -f "Price" --model gpt-4o-mini --display-output md

--url대상 웹 페이지의 주소입니다.-f: 여러 번 사용할 수 있는 추출 필드를 지정합니다.--model: AI 모델(예: gpt-4o-mini)을 선택합니다.--display-output출력 형식(md, json, csv 등).

주요 기능 작동

- 크롤러 도구 전환

기본적으로 Playwright가 사용되지만 셀레늄을 사용하려면 매개 변수를 추가할 수 있습니다:par_scrape --url "https://example.com" -f "Title" --scraper selenium - 병렬 캡처

효율성을 높이기 위해 최대 병렬 요청 수를 설정하세요:par_scrape --url "https://example.com" -f "Data" --scrape-max-parallel 5 - 동적 페이지 대기

동적으로 로드되는 콘텐츠의 경우 대기 유형과 선택기를 설정할 수 있습니다:par_scrape --url "https://example.com" -f "Content" --wait-type selector --wait-selector ".dynamic-content"지원되는 대기 유형은 다음과 같습니다.

none및pause및sleep및idle및selector노래로 응답text. - 사용자 지정 출력 경로

결과를 지정된 폴더에 저장합니다:par_scrape --url "https://example.com" -f "Title" --output-folder ./my_data

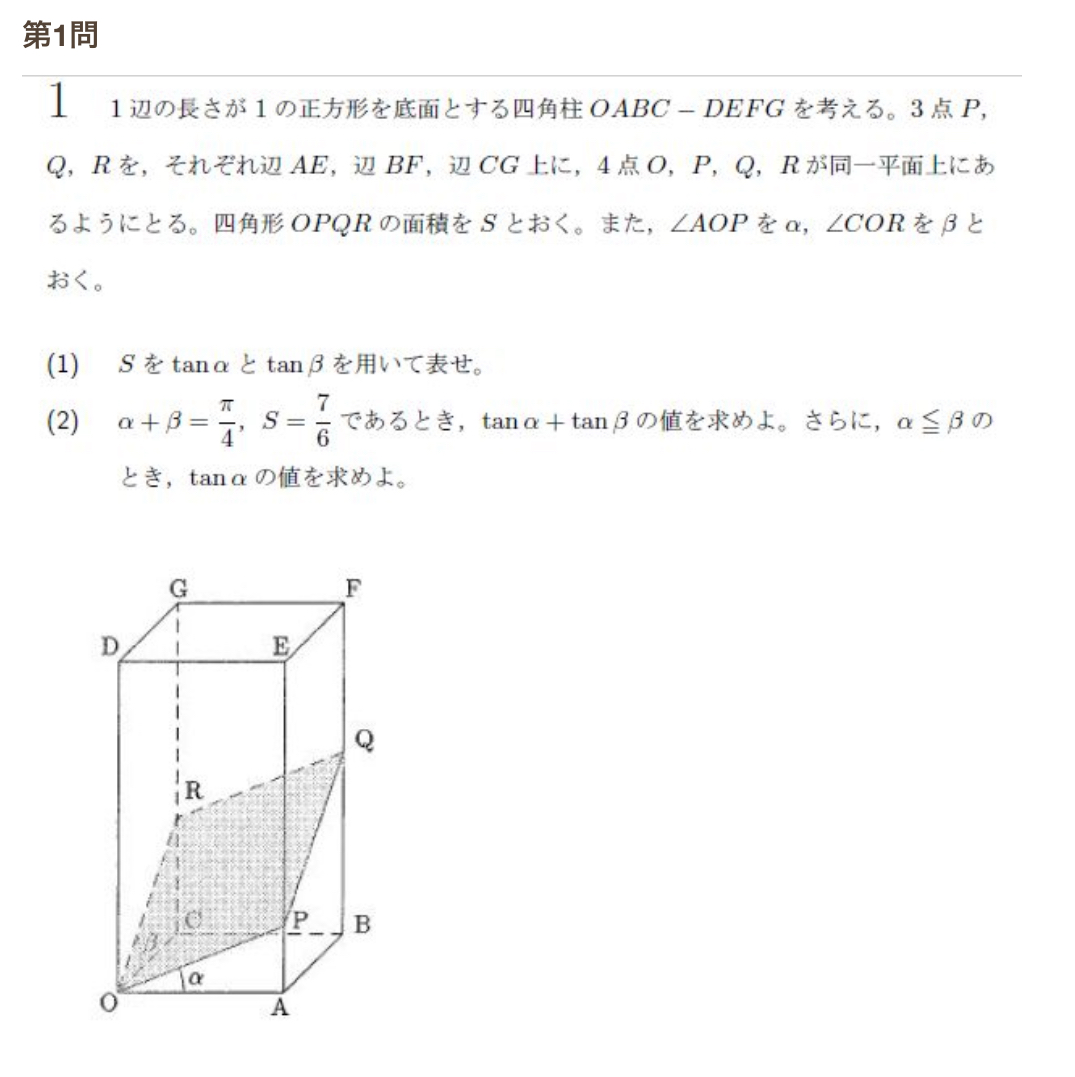

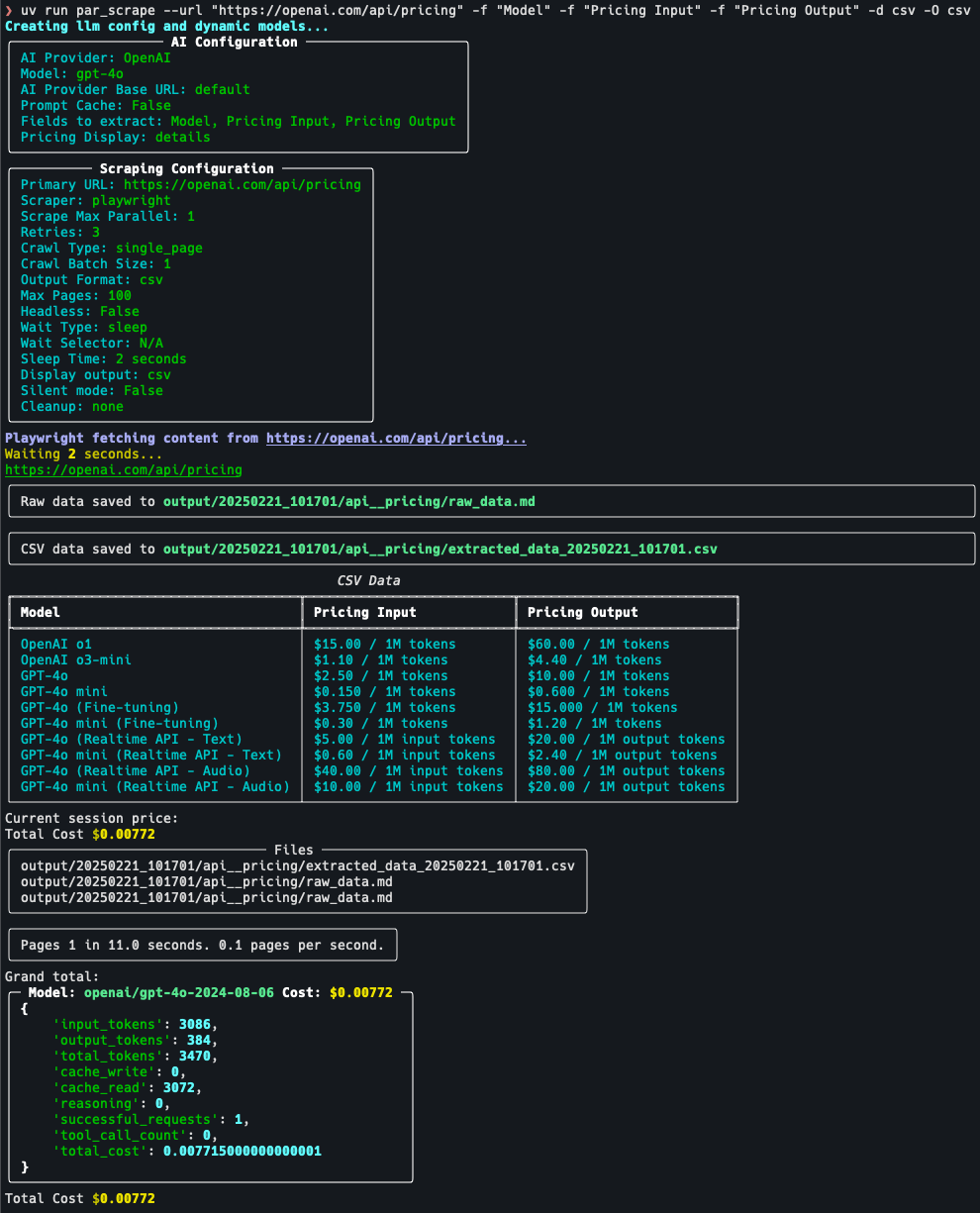

운영 프로세스 세부 정보

크롤링 가격 페이지를 예로 들어 보겠습니다:

- 목표 설정https://openai.com/api/pricing/ 으로 이동하여 "모델", "가격 입력" 및 " 가격 산출"을 추출해야 합니다.

- 명령 실행::

par_scrape --url "https://openai.com/api/pricing/" -f "Model" -f "Pricing Input" -f "Pricing Output" --model gpt-4o-mini --display-output json - 결과 보기명령이 실행된 후 터미널은 데이터를 JSON 형식으로 표시하거나 기본 출력 파일에 저장합니다.

- 조정 매개변수데이터가 불완전한 경우 다음을 추가해 보세요.

--retries 5(재시도 횟수) 또는 조정--sleep-time 5(대기 시간).

주의

- API 키키가 유효한지 확인합니다. 그렇지 않으면 AI 추출 기능을 사용할 수 없습니다.

- 웹사이트 제한 사항일부 사이트에는 크롤링 방지 메커니즘이 있을 수 있으며, 이러한 사이트에서는

--headless(헤드리스 모드)로 전환하거나 캡처 빈도를 조정할 수 있습니다. - 캐시 사용량: 동일한 페이지를 여러 번 크롤링하는 경우 다음을 활성화할 수 있습니다.

--prompt-cache비용 절감.

위의 단계를 통해 사용자는 par_scrape를 빠르게 시작하고 웹 페이지 데이터 추출 작업을 쉽게 완료할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...