오로란 무엇인가요?

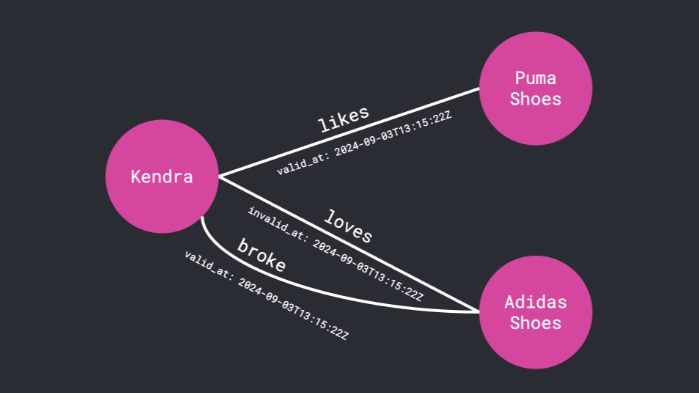

Ouro는 바이트 점프 시드 팀이 개발한 새로운 유형의 루프 언어 모델(LLM)로, 파라미터 공유 루프 계산 구조를 통해 사전 학습 단계에서 추론 기능을 직접 구축하는 것이 핵심 혁신입니다. 이 모델은 24개의 레이어를 기본 블록으로 채택하고 4개의 루프를 통해 96개의 레이어와 동등한 계산 깊이를 달성하면서도 14억 개의 파라미터 규모를 유지하여 소규모 모델의 추론 효율을 크게 향상시켰습니다. 실험 결과, Ouro 1.4B는 BBH 추론 벤치마크에서 71.02점을 기록해 4B 파라미터 모델의 성능에 근접했으며, 2.6B 버전은 Math500 수학 문제에서 90.85점을 기록해 8B 모델을 능가하는 것으로 나타났습니다. 이 모델의 독특한 설계에는 동적 계산 메커니즘(간단한 작업의 경우 더 적은 주기, 복잡한 작업의 경우 더 많은 주기)과 엔트로피 정규화 훈련 전략이 포함되어 있어 모델이 사고의 깊이를 적응적으로 조정할 수 있게 해줍니다.

Ouro의 특징

- 아키텍처 혁신Ouro 모델은 추후 미세 조정에만 의존하지 않고 잠재 공간에서 반복적으로 계산하여 사전 훈련 단계에 직접 추론 기능을 구축합니다. 이 아키텍처는 순방향 전파 중에 여러 번 반복되는, 즉 여러 개의 '루프 단계'로 이루어진 N개의 공유 가중치 레이어로 구성된 '레이어 스택'으로 구성되어 있어 '동적'이 가능합니다. 이를 통해 "동적 계산"이 가능하며 모델의 계산 규모를 "매개변수 수"에서 "계산 깊이"로 분리할 수 있습니다.

- 교육 전략Ouro 모델은 새로운 2단계 적응형 계산 훈련 전략을 사용합니다. 첫 번째 단계는 출구 단계에서 균일한 사전 엔트로피 정규화 목표를 사용하여 모델이 모든 계산 깊이를 편향 없이 탐색하도록 장려하고, 두 번째 단계는 집중적인 적응형 게이팅 훈련 단계로, 계산 비용과 성능 향상을 절충하기 위해 출구 게이팅을 명시적으로 최적화합니다.

- 매개변수 효율성1.4B 및 2.6B 모델은 모든 유형의 벤치마크에서 훨씬 더 큰 SOTA LLM(각각 최대 4B 및 12B 파라미터)의 성능과 일관되게 일치하거나 심지어 초과하여 2~3배의 파라미터 효율성 향상을 달성합니다.

- 추론 능력Ouro 모델의 성능 우위는 지식 용량의 증가가 아니라 지식 조작 능력, 즉 여러 단계로 추론하고 사실을 결합하는 능력이 훨씬 뛰어나다는 데서 비롯됩니다. Ouro 모델의 장점은 GSM8K 및 MATH500과 같은 어려운 수학적 추론 작업에서 특히 분명하게 드러납니다.

- 보안 및 충실도기준 모델에 비해 Ouro의 유해 콘텐츠 생성률은 더 낮으며 루프 단계 수가 증가할수록 감소합니다. 추론 과정이 인과 관계에 더 충실하며, 중간 단계가 최종 답변과 더 밀접하게 관련되어 있는 것으로 나타났습니다.

Ouro의 핵심 강점

- 강력한 추론Ouro는 다단계 추론과 논리적 추론에 탁월하며, 특히 어려운 수학적 추론 과제에서 논리적 추론과 계산을 정확하게 수행할 수 있습니다.

- 뛰어난 파라메트릭 효율성Ouro는 반복적인 아키텍처와 훈련 전략을 통해 파라메트릭 효율성을 크게 향상시킵니다. 더 작은 모델은 여러 벤치마크에서 대형 모델과 비슷하거나 더 나은 성능을 보여줍니다.

- 보안 및 충실도Ouro는 유해한 콘텐츠 생성률이 낮고 안전한 텍스트 콘텐츠를 생성합니다. 추론 과정은 인과 관계에 더 충실하며, 중간 단계가 최종 답변과 밀접하게 연결되어 있습니다.

- 오픈 소스 및 확장성Ouro 모델은 오픈 소스이며, 연구자와 개발자의 추가 연구 및 애플리케이션 개발을 용이하게 하기 위해 14억 및 26억 파라미터 스케일로 제공됩니다.

- 효과적인 교육 전략Ouro는 추론 프로세스를 최적화하고 모델 성능을 개선하기 위해 다양한 계산 깊이를 효율적으로 탐색하는 2단계 적응형 계산 훈련 전략을 사용합니다.

- 다국어 지원Ouro는 여러 언어를 지원하며 기계 번역 및 다국어 Q&A와 같은 다국어 작업을 처리할 수 있으며 다양한 애플리케이션에 사용할 수 있습니다.

Ouro의 공식 웹사이트는 무엇인가요?

- 프로젝트 웹사이트:: https://ouro-llm.github.io/

- 허깅페이스 모델 라이브러리:: https://huggingface.co/collections/ByteDance/ouro

- arXiv 기술 논문:: https://arxiv.org/pdf/2510.25741

Ouro의 대상

- 자연어 처리(NLP) 연구원Ouro 모델의 혁신적인 아키텍처와 교육 전략은 연구자들에게 새로운 연구 방향과 실험 플랫폼을 제공하여 자연어 처리 분야의 기술 발전을 촉진하는 데 도움을 줍니다.

- 인공 지능 개발자Ouro의 오픈 소스 특성과 유연성은 개발자가 지능형 고객 서비스, 콘텐츠 생성 도구 등과 같은 다양한 언어 모델링 애플리케이션을 구축하는 데 이상적입니다.

- 교육자 및 학생수학적 추론과 논리적 추론에 강점을 가진 Ouro는 지능형 튜터링 시스템, 자동화된 문제 해결 도구 및 학생들이 복잡한 개념을 더 잘 배우고 이해하는 데 도움이 되는 기타 도구를 개발하는 교육 분야에서 강력한 도구로 활용되고 있습니다.

- 콘텐츠 크리에이터Ouro는 창의적인 글쓰기, 카피 작성 및 스토리텔링을 지원하여 콘텐츠 제작자가 생산성을 높이고 영감을 얻을 수 있도록 도와줍니다.

- 기업 및 조직Ouro는 내부 지식 관리, 고객 서비스 및 콘텐츠 감사 시나리오에 사용되어 운영 효율성과 사용자 경험을 개선할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...