일반 소개

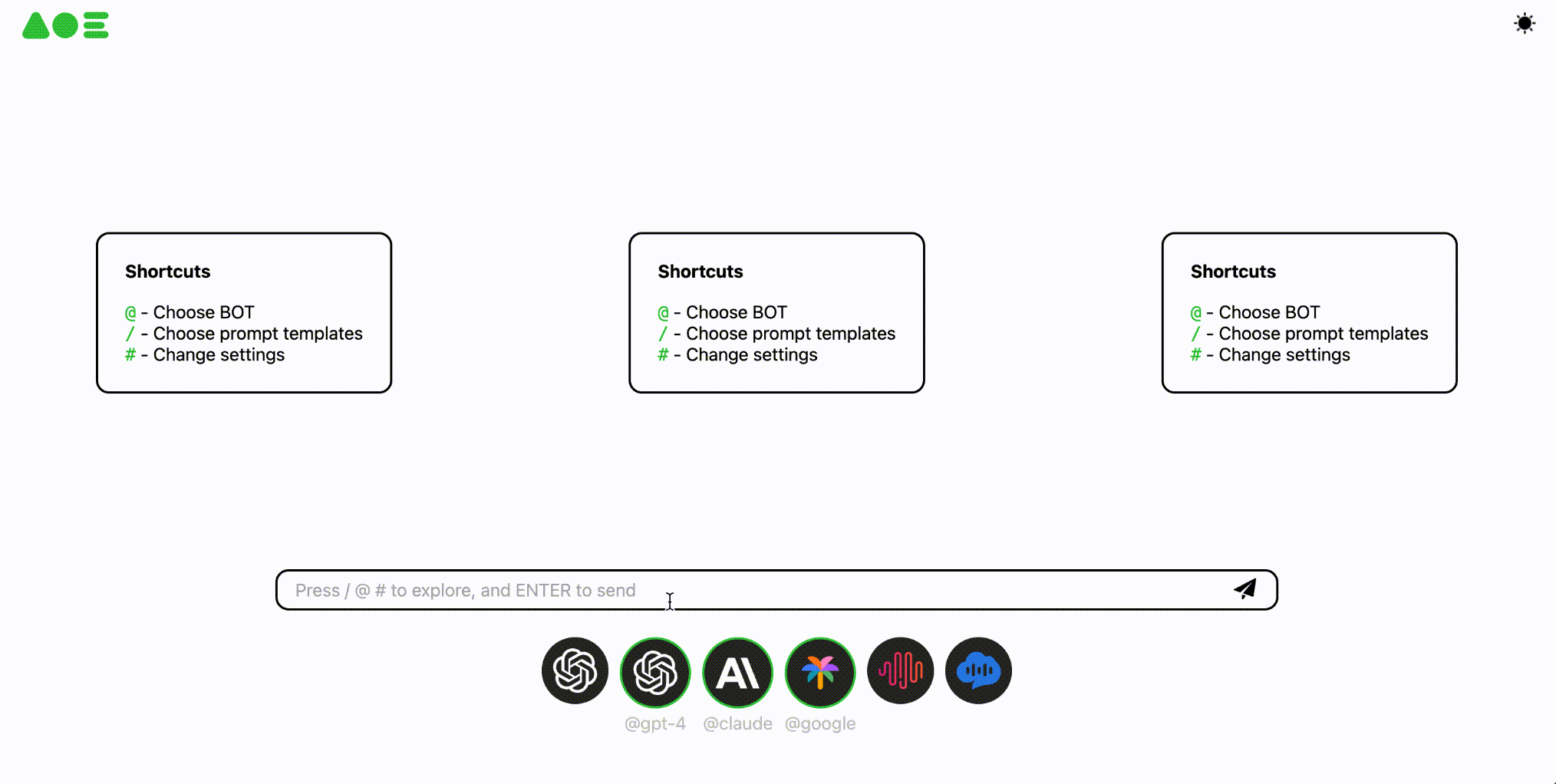

OpenAOE는 오픈 소스 대규모 모델 그룹 채팅 프레임워크로, 현재 시장에 여러 모델에 병렬로 대응하는 채팅 프레임워크가 부족하다는 문제를 해결하기 위한 것입니다. OpenAOE를 사용하면 사용자는 여러 LLM(대규모 언어 모델)과 동시에 대화하고 병렬 출력을 얻을 수 있습니다. 이 프레임워크는 GPT-4, 구글 팜, 미니맥스, 클로드 등과 같은 여러 상용 및 오픈 소스 LLM API에 대한 액세스를 지원하며, 사용자가 다른 LLM API에 대한 액세스를 사용자 지정할 수 있습니다.OpenAOE는 다양한 사용자의 요구를 충족하는 백엔드 API와 웹 UI를 제공하며, LLM 연구자, 평가자, 엔지니어링 개발자 및 비전문가에게 적합합니다.

기능 목록

- 다중 모델 병렬 응답병렬 출력을 얻기 위해 동시에 여러 개의 대규모 언어 모델과의 대화를 지원합니다.

- 상용 및 오픈 소스 모델 액세스GPT-4, 구글 팜, 미니맥스, 클로드 및 기타 상용 및 오픈 소스 대규모 언어 모델 API에 대한 액세스를 지원합니다.

- 사용자 지정 모델 액세스다른 빅 모델 API에 대한 사용자 정의 액세스를 허용합니다.

- 백엔드 API 및 웹-UI다양한 사용자의 요구를 충족하기 위해 백엔드 API 및 웹-UI를 제공합니다.

- 다양한 작동 모드pip, 도커 및 소스를 통한 OpenAOE 실행 지원.

도움말 사용

설치 프로세스

pip를 통한 설치

- Python 버전이 3.9 이상인지 확인합니다.

- 다음 명령을 실행하여 OpenAOE를 설치합니다:

pip install -U openaoe

- 구성 파일을 사용하여 OpenAOE를 시작합니다:

openaoe -f /path/to/your/config-template.yaml

도커를 통한 설치

- OpenAOE 도커 이미지를 가져옵니다:

docker pull opensealion/openaoe:latest

를 클릭하거나 도커 이미지를 빌드하세요:

git clone https://github.com/internlm/OpenAOE

cd OpenAOE

docker build . -f docker/Dockerfile -t opensealion/openaoe:latest

- 도커 컨테이너를 시작합니다:

docker run -p 10099:10099 -v /path/to/your/config-template.yaml:/app/config.yaml --name OpenAOE opensealion/openaoe:latest

사용 가이드라인

- 구성 파일OpenAOE를 시작하기 전에 구성 파일을 준비해야 합니다.

config-template.yaml이 파일은 백엔드 및 프론트엔드 설정을 제어하는 데 사용됩니다. - 액세스 모델 API구성 파일에서 사용자는 GPT-4, 구글 팜, 미니막스, 클로드 등 액세스해야 하는 모델 API를 구성할 수 있습니다. 사용자는 다른 대규모 모델 API에 대한 액세스 권한을 사용자 지정할 수도 있습니다.

- 서비스 시작설치 과정을 거쳐 OpenAOE 서비스를 시작한 후, 사용자는 제공된 웹-UI를 통해 운영하거나 백엔드 API를 통해 통합할 수 있습니다.

- 병렬 대화웹-UI에서 사용자가 프롬프트 단어를 입력하면 OpenAOE가 여러 개의 대규모 언어 모델에 동시에 요청을 전송하고 병렬 응답을 반환합니다.

- 결과 분석분석 및 평가를 위해 다양한 모델의 응답 결과를 비교할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...