o3가 개인적인 인사이트를 공유하고자 합니다. 테스트 시간 정보 스케일링 법칙 생각보다 훨씬 빠르게 진행되고 있습니다. 하지만 사실 그 길은 조금 복잡하다고 말하고 싶습니다. OpenAI가 AGI를 추구하는 과정에서 커브볼을 치는 방식이기 때문입니다.

집중 학습 및 지름길 사고

왜 그럴까요? 두 가지 예를 통해 그 이유를 살펴보겠습니다.

첫 번째 예는 강화 학습에서 나온 것입니다. 강화 학습에서는 할인 계수가 중요한 역할을 하는데, 이는 의사 결정 단계가 진행될수록 획득하는 보상이 점차 감소한다는 것을 의미합니다. 따라서 강화 학습의 목표는 일반적으로 가능한 한 가장 짧은 시간에 가능한 한 적은 단계로 보상을 극대화하는 것입니다. 이 전략의 핵심은 '지름길', 즉 가능한 한 빨리 보상을 얻는 데 중점을 둡니다.

두 번째 예는 대규모 모델을 미세 조정하는 과정입니다. 미세 조정되지 않은 사전 학습된 모델은 명확한 방향이나 제어 기능이 없는 경우가 많습니다. 모델에 "중국의 수도는 어디인가요?"라고 물으면 처음에는 "좋은 질문이네요."라고 대답한 다음, 다른 방향으로 나아갔다가 마침내 "베이징"이라는 답을 내놓을 수 있습니다. 그러나 미세 조정된 모델에게 같은 질문을 하면 "베이징"이라는 간단하고 명확한 대답이 나옵니다.

이 미세 조정된 모델은 항상 최소한의 에너지 소비와 최단 경로를 위해 노력하는 인간의 진화 과정과 유사하게 최적화 전략을 통해 지름길을 찾는 방법을 보여줍니다.

왜 추론인가요?

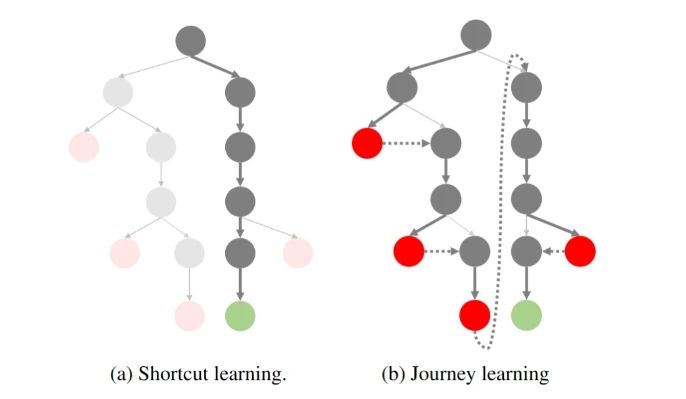

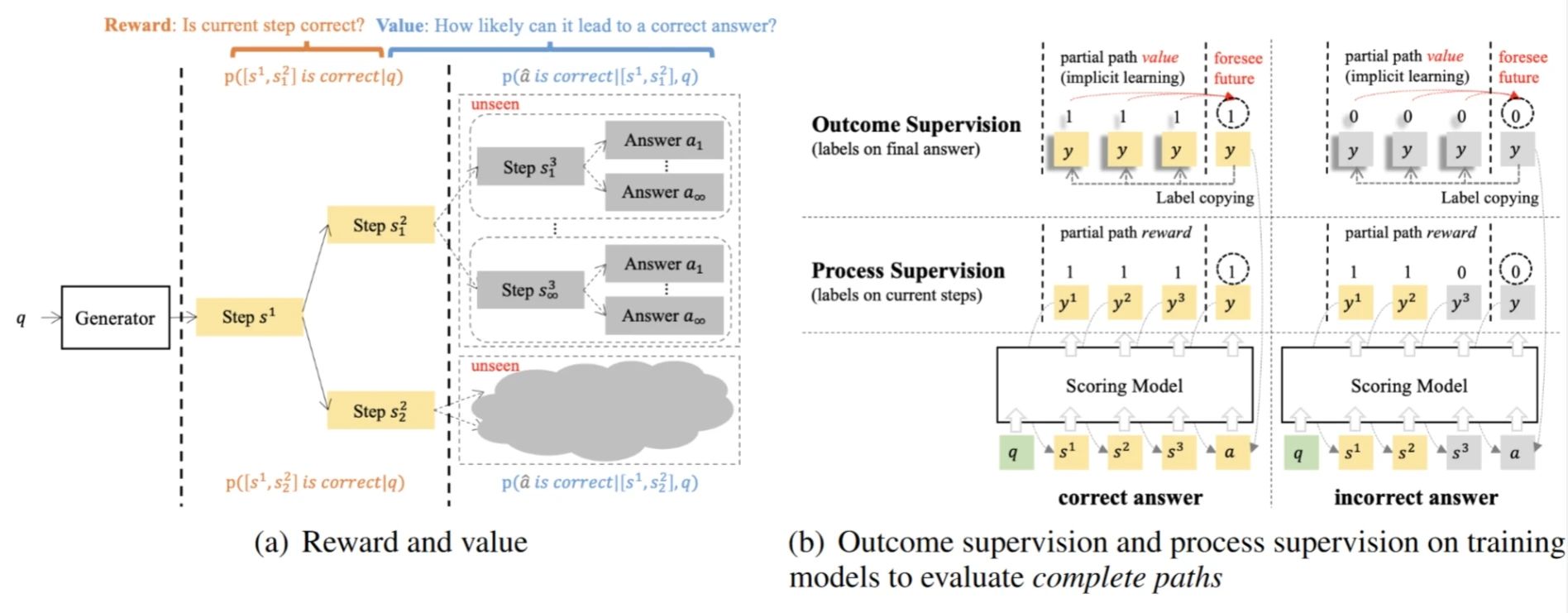

추론 샘플링 프로세스를 트리로 시각화하면 다음과 같습니다:

O1 복제 여정: 1부

왼쪽은 과거에 우리가 추구했던 지름길 학습, 즉 올바른 결과를 얻기 위해 최소한의 단계를 거치는 학습입니다. 오른쪽은 OpenAI o1으로 대표되는 '반성적, 회고적' 패러다임입니다.

우리는 o1이 검색을 수행할 때 모델이 지속적으로 반영하고 역추적하며 이 과정에서 종종 추가 오버헤드가 수반된다는 것을 알고 있습니다. 문제는 모델이 실제로 정답을 반복해서 제공할 수 있다면 누가 복잡한 검색에 시간과 비용을 투자하고 싶어할까요? OpenAI는 바보가 아니며 지름길이 더 낫다는 것을 우리 모두 알고 있습니다!

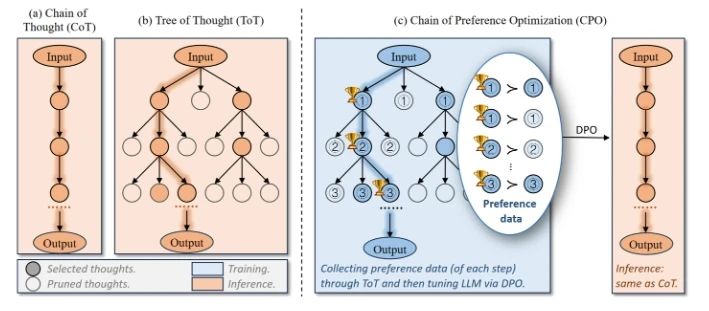

문제가 어려울수록 아이디어의 잠재적 트리가 넓어지고 각 단계에서 더 많은 검색 공간이 생기며 지름길로 정답을 찾을 가능성이 줄어듭니다. 그렇다면 어떻게 해야 할까요? 직관적으로 생각할 수 있는 방법은 가지치기를 하는 것입니다! 끝점에 도달할 가능성이 낮은 트리 노드를 미리 잘라내어 검색 공간을 압축하여 트리를 다시 좁은 공간으로 만드는 것입니다. 예를 들어, 이것이 현재 많은 노력들이 시도하고 있는 방법입니다:

CPO(선호도 최적화 체인)

선호도 최적화 연쇄는 사고 트리에서 선호도 데이터를 자연스럽게 구성한 다음 DPO를 사용하여 모델이 종점에 도달할 트리 노드를 선택할 확률이 높아지도록 최적화하는 것입니다.

결과 감독 가치 모델(OVM)

결과 감독 가치 모델은 추론을 MDP 프로세스로 모델링하는 것으로, 현재 단계(가치)에서 정답에 도달할 확률을 사용하여 전략 최적화를 안내합니다.

OpenAI가 기존의 지름길에서 벗어난 이유는 무엇일까요?

다시 o1으로 돌아가서, 기존의 지름길 아이디어를 깨고 트리 검색이라는 '우회'를 택한 이유는 무엇인가요?

과거에는 (익스플로잇) 모델의 기본 기능을 활용하는 경향이 있었다면, 기존 GPT-4 모델은 대부분의 대화 및 단순 추론 요구를 충족할 수 있다고 가정할 수 있습니다. 그리고 이러한 작업은 잘 샘플링하고, 선호도를 평가하고, 반복적으로 최적화할 수 있습니다.

그러나 이러한 관점은 단기간에 보상을 제공하기 어려운 수학적 추론(AIME, 프론티어 수학), 코드 생성(SWE-Bench, CodeForce) 등과 같은 더 복잡한 작업의 필요성을 무시합니다. -보상이 매우 드물고 최종적으로 정답에 도달했을 때만 보상이 명확해집니다.

따라서 기존의 지름길 학습은 더 이상 이런 유형의 복잡한 작업을 처리하는 데 적합하지 않습니다. 올바른 경로를 샘플링할 수도 없는데 어떻게 모델이 올바른 경로를 선택할 확률을 최적화할 수 있다고 말할 수 있을까요?

이 논문 제목의 '몬테카를로 아이디어'로 돌아가서, 강화 학습에 대한 몬테카를로 접근법의 핵심은 정책을 여러 번 샘플링하여 정책의 가치를 추정하고 이를 통해 모델을 최적화하는 데 있다는 것을 알 수 있습니다. 그러나 이 접근 방식에는 샘플링된 정책이 최적의 경로를 샘플링할 수 없는 경우 모델 최적화는 항상 로컬 최적화로 끝나는 자연스러운 한계가 있습니다. 이것이 바로 MC 학습에서 보다 탐색적인 전략을 선택하는 이유입니다.

그래서 OpenAI는 기존의 지름길 사고방식에서 벗어나 강화 탐색(탐색)으로 강화 학습의 척도를 바꾸기로 결정했습니다.

o1 혁신: 탐색에서 최적화까지

이러한 맥락에서 OpenAI는 o1 패러다임을 제안했습니다. 이러한 변화를 통해 모델은 복잡한 작업에 직면했을 때 점진적으로 희박한 보상을 받을 수 있습니다! 그리고 이러한 보상을 통해 전략을 지속적으로 최적화할 수 있습니다. 이러한 탐색 과정은 번거롭고 비효율적으로 보일 수 있지만, 모델을 더욱 최적화할 수 있는 토대를 마련합니다.

그렇다면 O1은 어디에서 왔을까요? 최근 o1을 복제하는 작업도 많이 등장했는데, 그 이유는 무엇인가요? 탐색에 사용되는 행동 정책이 온-정책 접근 방식인 경우, 현재 모델(예: GPT-4o)로 샘플링하고 있는데, 이는 여전히 너무 비효율적입니다.

그래서 만장일치로 오프-폴리시 방식을 선택했습니다:

OpenAI는 긴 CoT 데이터에 주석을 달기 위해 박사 과정 학생을 고용하는 데 많은 돈을 쓰고 있는데, 돈이 없다고요? 돈이 없다면 어떻게 해야 할까요? 그렇다면 인간과 기계가 협업하여 데이터에 주석을 달고(수동으로 o1을 증류), 주석자에 대한 요구 사항을 줄일 수 있습니다. 주석자를 찾을 돈도 없나요? 그렇다면 R1 / QwQ를 증류하거나 다른 방법(Critique, PRM 등)을 생각해야 합니다. 또한 o1을 적극적으로 재생산하는 대형 제조업체와 연구소에 탐구의 궁극적인 목표는 여전히 최적화라는 점을 잊지 말라고 말하고 싶습니다!

插一句题外话,虽然大家都在骂 o1 隐藏了真正的思维链,只展示 Summary 的捷径版本。殊不知这个 Summary 才是优化策略的关键数据!但 OpenAI 并不害怕其他人蒸馏这些 Summary,因为蒸馏这些数据还有一个前提——基础模型的能力足够强大,不然步子迈太大还容易闪了腰。

并且 OpenAI 还将探索的成本转嫁给了用户。虽然在初期花很多钱来标注探索型数据,但现在有了 o1 后,用户使用的过程中又无形地为他标注了更多数据。OpenAI 再次实现了伟大的数据飞轮!

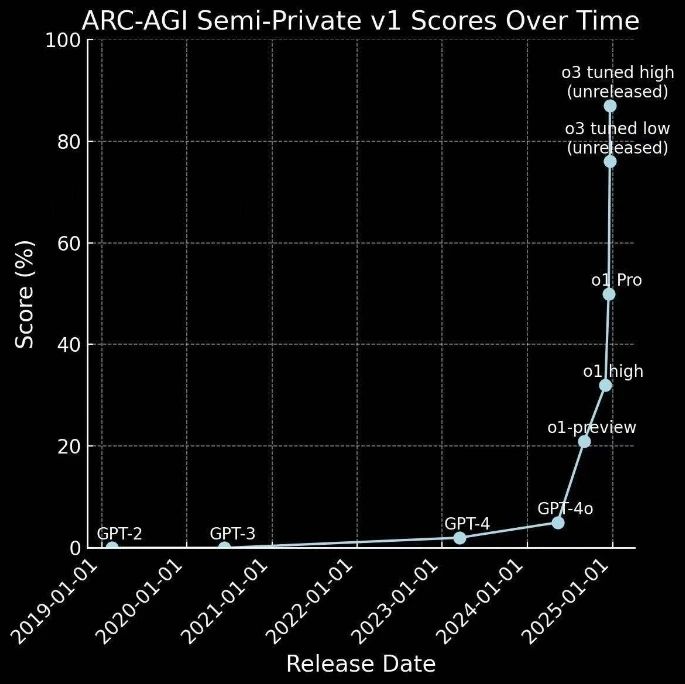

O1에서 O3로의 빠른 진화

몇 달 전에 출시된 O1에 이어 O3가 출시되었습니다.

사실 이는 이전의 추측을 뒤집는 것으로, GPT-4가 0에서 1로, 즉 단순한 과제에서 보상을 획득하는 단계로 발전하는 것을 의미한다면, o1은 복잡한 과제를 탐색하고 희귀 보상을 획득함으로써 1에서 10으로 도약하는 것을 의미합니다. 보상을 획득하여 더 많은 전략 최적화를 위한 전례 없는 양의 고품질 데이터를 제공합니다.

따라서 예상보다 빠르게 진행되었습니다:

이는 탐사 전략의 성공적인 적용일 뿐만 아니라 AI 기술을 통한 AGI를 향한 중요한 단계이기도 합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...