일반 소개

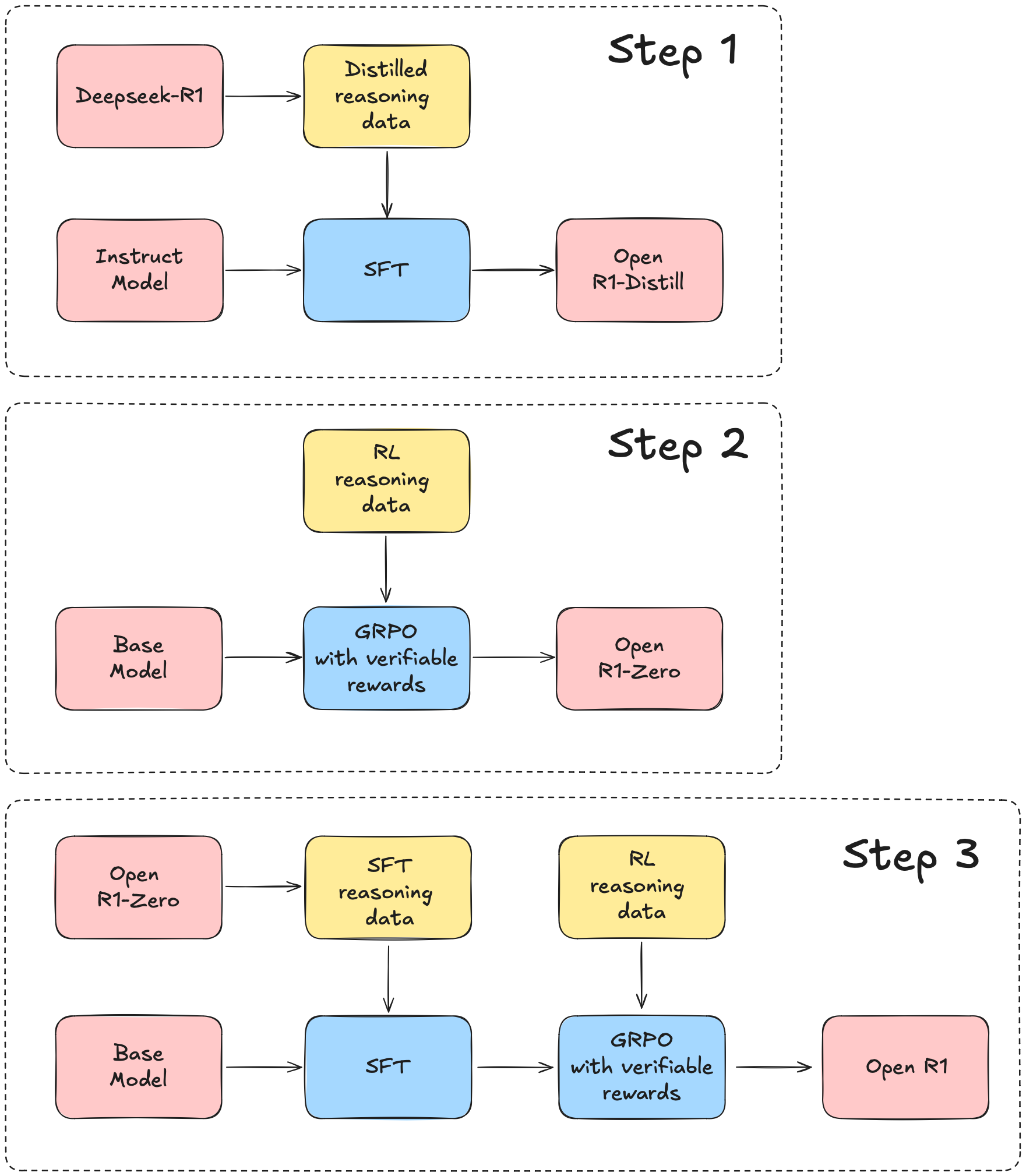

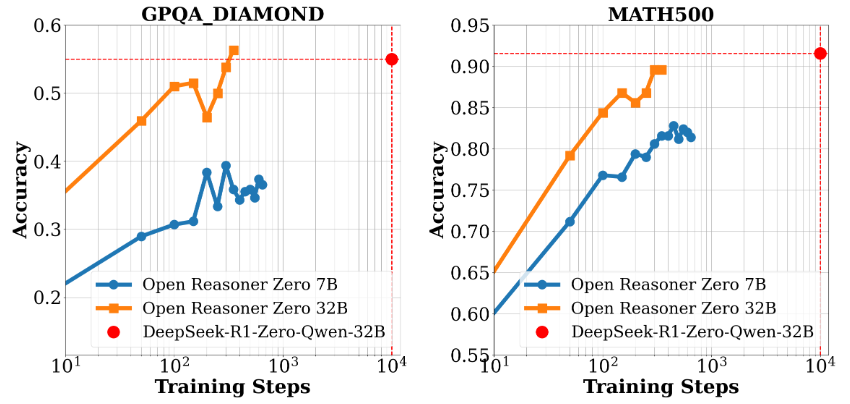

Open-Reasoner-Zero는 강화 학습(RL) 연구에 초점을 맞춘 오픈 소스 프로젝트로, GitHub의 Open-Reasoner-Zero 팀에서 개발했습니다. 이 프로젝트는 효율적이고 확장 가능하며 사용하기 쉬운 훈련 프레임워크를 제공함으로써 인공지능(AI) 분야의 연구 프로세스, 특히 일반 인공지능(AGI)을 향한 탐구를 가속화하는 것을 목표로 합니다. 이 프로젝트는 Qwen2.5 모델(7B 및 32B 파라미터 버전)을 기반으로 하며 OpenRLHF, vLLM, DeepSpeed 및 Ray와 같은 기술을 결합하여 완전한 소스 코드, 학습 데이터 및 모델 가중치를 제공합니다. DeepSeek-R1-Zero의 1/30도 안 되는 훈련 단계로 비슷한 수준의 성능을 달성하여 리소스 활용의 효율성을 입증한 것으로 유명합니다. 이 프로젝트는 MIT 라이선스에 따라 사용자가 무료로 사용 및 수정할 수 있어 연구자와 개발자가 협업하기에 이상적입니다.

기능 목록

- 효율적인 집중 학습 교육단일 컨트롤러에서 트레이닝 및 생성을 지원하여 GPU 활용도를 극대화합니다.

- 전체 오픈 소스 리소스이 모델은 57,000개의 고품질 학습 데이터, 소스 코드, 매개변수 설정, 모델 가중치를 제공하는 간단하고 사용하기 쉬운 툴입니다.

- 고성능 모델 지원Qwen2.5-7B 및 Qwen2.5-32B 기반, 뛰어난 추론 성능을 제공합니다.

- 유연한 연구 프레임워크모듈식 디자인으로 연구자가 실험을 쉽게 조정하고 확장할 수 있습니다.

- 도커 지원교육 환경의 복제 가능성을 보장하기 위해 도커파일을 제공합니다.

- 성능 평가 도구GPQA 다이아몬드에 대한 성능 비교와 같은 벤치마킹 데이터 및 평가 결과 프레젠테이션이 포함되어 있습니다.

도움말 사용

설치 프로세스

Open-Reasoner-Zero를 사용하려면 일정 수준의 기술 지식이 필요합니다. 다음은 Linux 또는 유닉스 계열 시스템에서 실행하는 데 적합한 자세한 설치 및 운영 가이드입니다.

환경 준비

- 기본 종속성 설치::

- 시스템에 Git, Python 3.8+ 및 NVIDIA GPU 드라이버(CUDA 지원 필요)가 설치되어 있는지 확인합니다.

- 교육 환경을 빠르게 배포하려면 Docker(권장 버전 20.10 이상)를 설치하세요.

sudo apt update sudo apt install git python3-pip docker.io

- 프로젝트 저장소 복제::

- 터미널에서 다음 명령을 실행하여 프로젝트를 로컬로 다운로드합니다:

git clone https://github.com/Open-Reasoner-Zero/Open-Reasoner-Zero.git cd Open-Reasoner-Zero - Docker로 환경 구성하기::

- 이 프로젝트는 교육 환경 구축을 용이하게 하기 위해 도커파일을 제공합니다.

- 프로젝트 루트 디렉토리에서 실행합니다:

docker build -t open-reasoner-zero -f docker/Dockerfile .- 빌드가 완료되면 컨테이너를 시작합니다:

docker run -it --gpus all open-reasoner-zero bash- 이렇게 하면 필요한 종속성이 사전 설치되어 GPU를 지원하는 컨테이너 환경으로 들어갑니다.

- 종속성 수동 설치(선택 사항)::

- Docker를 사용하지 않는 경우 종속성을 수동으로 설치할 수 있습니다:

pip install -r requirements.txt- 특정 버전에 대해서는 프로젝트 설명서를 참조하여 OpenRLHF, vLLM, DeepSpeed 및 Ray가 설치되어 있는지 확인하세요.

기능 작동 흐름

1. 교육 모델

- 학습 데이터 준비::

- 이 프로젝트에는 57,000개의 고품질 교육 데이터가 포함되어 있습니다.

data폴더로 이동합니다. - 사용자 지정 데이터가 필요한 경우 문서 지침에 따라 형식을 정리하고 바꾸세요.

- 이 프로젝트에는 57,000개의 고품질 교육 데이터가 포함되어 있습니다.

- 프라이밍 교육::

- 컨테이너 또는 로컬 환경에서 다음 명령을 실행합니다:

python train.py --model Qwen2.5-7B --data-path ./data- 매개변수 설명:

--model모델을 선택합니다(예: Qwen2.5-7B 또는 Qwen2.5-32B).--data-path: 학습 데이터 경로를 지정합니다.

- 교육 로그는 마스터 노드 터미널에 표시되어 진행 상황을 쉽게 모니터링할 수 있습니다.

2. 성능 평가

- 벤치마크 테스트 실행::

- 제공된 평가 스크립트를 사용하여 모델 성능을 비교합니다:

python evaluate.py --model Qwen2.5-32B --benchmark gpqa_diamond- 출력에는 GPQA 다이아몬드와 같은 벤치마크에서 모델의 정확도가 표시됩니다.

- 평가 보고서 보기::

- 이 프로젝트에는 성능 및 교육 시간 스케일링을 보여주는 차트(예: 그림 1 및 그림 2)가 포함되어 있습니다.

docs폴더에서 찾을 수 있습니다.

- 이 프로젝트에는 성능 및 교육 시간 스케일링을 보여주는 차트(예: 그림 1 및 그림 2)가 포함되어 있습니다.

3. 수정 및 확장

- 조정 매개변수::

- 컴파일러

config.yaml파일에서 학습 속도, 배치 크기 등과 같은 하이퍼파라미터를 수정합니다.

learning_rate: 0.0001 batch_size: 16 - 컴파일러

- 새로운 기능 추가::

- 이 프로젝트는 모듈식 디자인으로 다음과 같이 구성될 수 있습니다.

src폴더에 새 모듈을 추가합니다. 예를 들어 새 데이터 전처리 스크립트를 추가합니다:

# custom_preprocess.py def preprocess_data(input_file): # 自定义逻辑 pass - 이 프로젝트는 모듈식 디자인으로 다음과 같이 구성될 수 있습니다.

취급 시 주의사항

- 하드웨어 요구 사항Qwen2.5-32B 교육을 지원하려면 최소 24GB의 비디오 메모리가 있는 GPU(예: NVIDIA A100)가 권장됩니다.

- 로그 모니터링교육 중에는 단말기를 켜두고 언제든지 로그를 확인하여 문제를 해결하세요.

- 커뮤니티 지원질문은 GitHub 이슈를 통해 제출하거나 hanqer@stepfun.com 으로 팀에 문의할 수 있습니다.

실제 사례

Qwen2.5-7B를 기반으로 모델을 학습시키고 싶다고 가정해 보겠습니다:

- Docker 컨테이너를 입력합니다.

- 움직여야 합니다.

python train.py --model Qwen2.5-7B --data-path ./data. - 하드웨어에 따라 몇 시간 기다렸다가 완료되면 실행합니다.

python evaluate.py --model Qwen2.5-7B --benchmark gpqa_diamond. - 결과물을 확인하여 성능 향상을 확인합니다.

이러한 단계를 통해 사용자는 실험을 재현하거나 새로운 기능을 개발하는 등 Open-Reasoner-Zero를 빠르게 시작하고 효율적으로 작업할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...