일반 소개

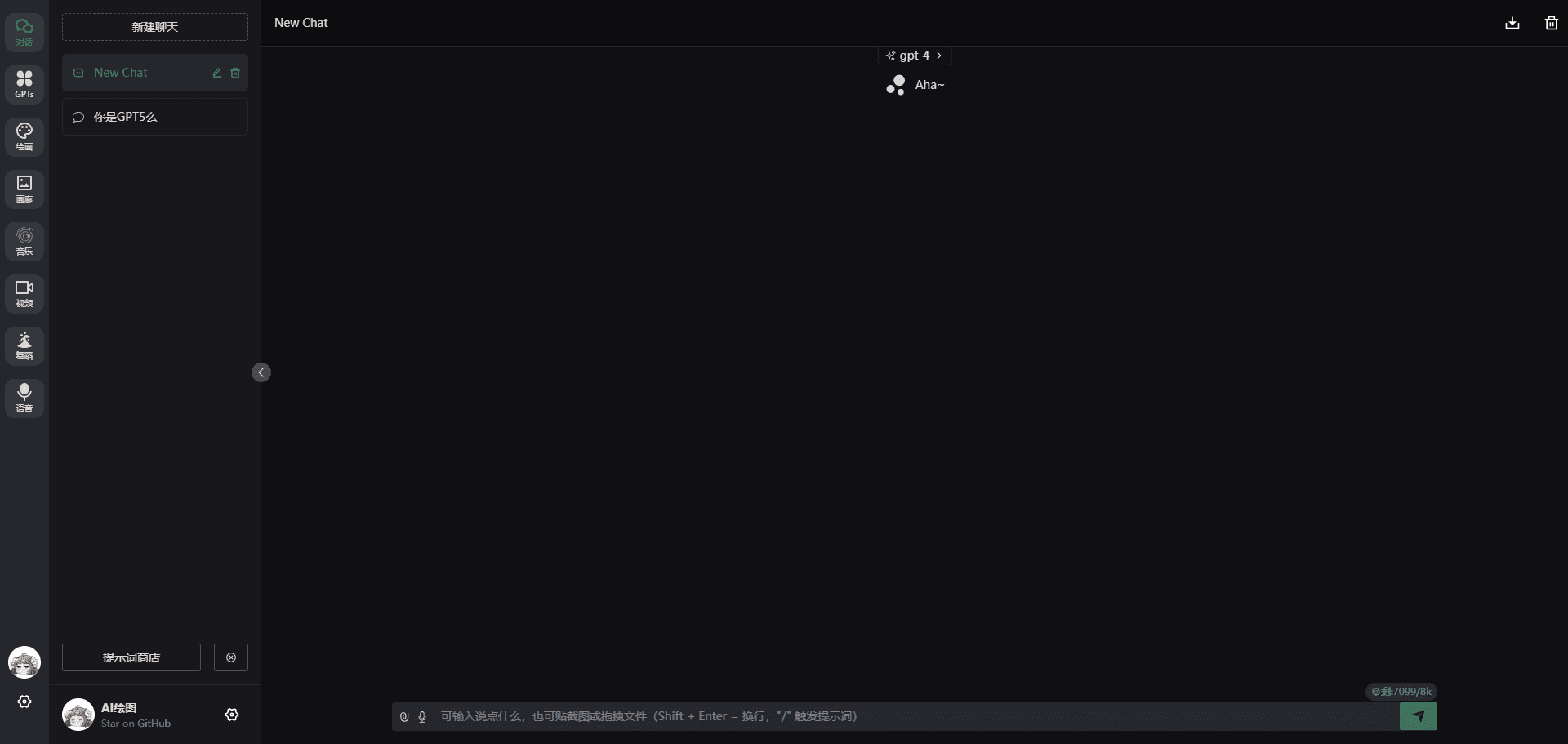

Open-LLM-VTuber는 사용자가 음성과 텍스트를 통해 LLM(대규모 언어 모델)과 상호 작용할 수 있는 오픈 소스 프로젝트로, Live2D 기술을 통합하여 역동적인 가상 캐릭터를 표현합니다. Windows, macOS 및 Linux를 지원하며 완전히 오프라인으로 실행되며 웹 및 데스크톱 클라이언트 모드가 모두 있습니다. 사용자는 가상의 여자친구, 애완동물 또는 데스크톱 비서로 사용할 수 있으며 외모, 성격, 목소리를 커스터마이징하여 개인화된 AI 동반자를 만들 수 있습니다. 이 프로젝트는 비공개 소스 AI 가상 앵커 '뉴로 사마'의 복제본으로 시작되었으며, 여러 언어 모델, 음성 인식, 텍스트 음성 변환, 시각적 인식을 지원하는 풍부한 기능의 플랫폼으로 발전했습니다. 현재 버전은 v1.0.0으로 리팩토링되어 활발히 개발 중이며, 앞으로 더 많은 기능이 추가될 예정입니다.

기능 목록

- 음성 상호작용핸즈프리 음성 대화를 지원하므로 사용자는 언제든지 AI를 중단하여 원활한 커뮤니케이션을 할 수 있습니다.

- Live2D 애니메이션대화 내용에 따라 표정과 동작을 생성하는 동적 아바타가 내장되어 있습니다.

- 크로스 플랫폼 지원윈도우, 맥OS, 리눅스와 호환되며, 엔비디아/비엔비디아 GPU 및 CPU 작동을 지원합니다.

- 오프라인 작업모든 기능을 네트워크 없이 실행하여 개인 정보 보호 및 보안을 보장할 수 있습니다.

- 데스크톱 애완동물 모드투명 배경, 글로벌 상단 및 마우스 침투가 지원되며 캐릭터를 화면의 원하는 위치로 드래그할 수 있습니다.

- 시각적 인식카메라 또는 화면 콘텐츠 인식을 통한 AI와의 비디오 상호 작용.

- 다중 모델 지원Ollama, OpenAI, Claude, Mistral 등 다양한 LLM과 호환되며, 셰르파-온넥스, 위스퍼 등 기타 음성 모듈과도 호환됩니다.

- 캐릭터 커스터마이징Live2D 모델을 임포트하여 캐릭터와 음성을 조정할 수 있습니다.

- 햅틱 피드백문자를 클릭하거나 드래그하여 대화형 응답을 트리거합니다.

- 채팅 기록 보관과거 대화 전환 및 대화형 콘텐츠 유지 지원.

도움말 사용

설치 프로세스

Open-LLM-VTuber는 로컬에 배포해야 하며, 자세한 단계는 다음과 같습니다:

1. 전제 조건

- 소프트웨어권장 NVIDIA GPU가 탑재된 Windows, macOS 또는 Linux 컴퓨터 지원(GPU 없이도 실행 가능).

- 하드웨어Git, Python 3.10+ 및 uv(권장 패키지 관리 도구)를 설치합니다.

- 망상초기 배포 시 종속성을 다운로드하려면 인터넷 연결이 필요하므로 중국 사용자는 프록시 가속을 사용하는 것이 좋습니다.

2. 코드 다운로드

- 터미널을 통해 프로젝트를 복제합니다:

git clone https://github.com/Open-LLM-VTuber/Open-LLM-VTuber --recursive cd Open-LLM-VTuber

- 또는 GitHub 릴리스에서 최신 ZIP 파일을 다운로드하여 압축을 해제하세요.

- 참고: 사용하지 않는 경우

--recursive실행에 필요git submodule update --init프런트엔드 서브모듈을 받습니다.

3. 종속성 설치

- UV를 설치합니다:

- Windows(PowerShell):

irm https://astral.sh/uv/install.ps1 | iex - macOS/Linux:

curl -LsSf https://astral.sh/uv/install.sh | sh

- Windows(PowerShell):

- 프로젝트 디렉토리에서 실행합니다:

uv syncFastAPI, onnxruntime 및 기타 종속성을 자동으로 설치합니다.

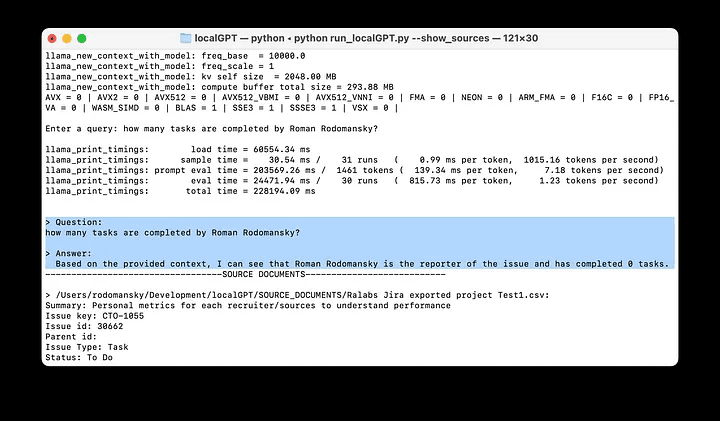

4. 구성 환경

- 첫 번째 실행은 구성 파일을 생성합니다:

uv run run_server.py - 생성된

conf.yaml를 클릭하고 다음을 구성합니다:- LLM: 모델 선택(예 Ollama (llama3 또는 OpenAI API의 경우 키를 입력해야 합니다).

- ASR음성 인식 모듈(예: 셰르파-onnx).

- TTS텍스트 음성 변환 모듈(예: Edge TTS).

- 예시:

llm: provider: ollama model: llama3 asr: provider: sherpa-onnx tts: provider: edge-tts

5. 서비스 활성화

- 실행 중입니다:

uv run run_server.py - 인터뷰

http://localhost:8000웹 버전을 사용하거나 데스크톱 클라이언트를 다운로드하여 실행하세요.

6. 데스크톱 클라이언트(선택 사항)

- GitHub 릴리스에서 다운로드

open-llm-vtuber-electron(Windows의 경우 .exe, macOS의 경우 .dmg). - 데스크톱 펫 모드를 경험하려면 클라이언트를 실행하고 백엔드 서비스가 실행 중인지 확인하세요.

7. 업데이트 및 제거

- 업데이트v1.0.0 이후

uv run update.py업데이트, 이전 버전은 최신 문서로 다시 배포해야 합니다. - 제거프로젝트 폴더 삭제, 확인

MODELSCOPE_CACHE어쩌면HF_HOME모델 파일, UV와 같은 도구를 제거합니다.

기능 작동 흐름

음성 상호작용

- 음성 사용웹 페이지 또는 클라이언트에서 '마이크' 아이콘을 클릭합니다.

- 대화직접 말하면 AI가 실시간으로 응답하고, '인터럽트' 버튼을 누르면 AI를 중단할 수 있습니다.

- 최적화: in

conf.yaml인식과 발음을 개선하기 위해 ASR 및 TTS 모듈을 조정하세요.

캐릭터 커스터마이징

- 모델 가져오기.moc3 파일을 폴더의

frontend/live2d_models카탈로그. - 성격 조정사설:: 사설

conf.yaml(명목식 형태로 사용됨)prompt'부드러운 언니'처럼. - 사운드 사용자 지정고유한 음성을 생성하기 위해 GPTSoVITS와 같은 도구를 사용하여 샘플을 녹음합니다.

데스크톱 애완동물 모드

- 개방형 모드클라이언트에서 "데스크톱 애완동물"을 선택하고 "투명 배경" 및 "상단"을 선택합니다.

- 움직이는 이미지: 화면의 원하는 위치로 드래그합니다.

- 상호 작용캐릭터를 탭하면 햅틱 피드백을 트리거하고 내면의 독백이나 표정 변화를 볼 수 있습니다.

시각적 인식

- 카메라 활성화'영상 채팅'을 클릭하여 액세스를 승인합니다.

- 화면 인식AI가 화면 콘텐츠를 분석하도록 '화면 감지'를 선택합니다.

- 일반적인 예"화면에 뭐가 보여?"라고 물으면 AI가 이미지를 설명해 줍니다.

주의

- 브라우저(소프트웨어)Chrome을 권장하며, 다른 브라우저는 Live2D 디스플레이에 영향을 줄 수 있습니다.

- 공연GPU 가속은 올바르게 구성된 드라이버가 필요하며 CPU에서 느리게 실행될 수 있습니다.

- 라이선스내장된 Live2D 샘플 모델은 별도의 라이선스가 적용되며, 상업적 사용은 Live2D에 문의하시기 바랍니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 게시물

댓글 없음...