올라마 설치 및 사용 튜토리얼

이전에는 다음과 같은 많은 이슈가 있었습니다. Ollama 설치 및 배포 튜토리얼의 정보가 다소 흩어져 있기 때문에 이번에는 로컬 컴퓨터에서 Ollama를 사용하는 방법에 대한 완전한 원스텝 튜토리얼을 준비했습니다. 이 튜토리얼은 초보자가 Ollama 사용의 함정을 피하기 위한 것이며, 숙련된 사용자라면 공식 Ollama 문서를 읽어보시길 권장합니다. 그런 다음 Ollama 설치 및 사용에 대한 단계별 가이드를 제공하겠습니다.

대형 모델의 로컬 설치에 Ollama를 선택해야 하는 이유

많은 초보자들은 저처럼 온라인에서 대규모 모델을 배포하는 데 더 나은 성능의 다른 도구가 있다는 사실을 이해하지 못합니다:Ollama와 유사한 LLM 프레임워크 인벤토리화: 로컬에 배포된 대규모 모델을 위한 다양한 옵션 마지막에 올라마를 설치하는 것을 추천하는 이유는 무엇인가요?

우선, 물론 개인용 컴퓨터에 설치하는 것은 쉽지만 가장 중요한 점 중 하나는 독립 실행 형 배포를위한 모델의 성능이 매개 변수에 더 잘 최적화되어 있고 설치시 오류가 발생하지 않는다는 것입니다. 예를 들어, 동일한 구성 컴퓨터 설치 QwQ-32B Ollama를 사용하여 더 원활하게 사용하려면 "더 강력"으로 변경하세요. llama.cpp 멈출 수 있으며 출력 답변도 정확하지 않을 수 있습니다. 여기에는 여러 가지 이유가 있으며 명확하게 설명할 수 없으므로 설명하지 않겠으며, Ollama는 하단에 llama.cpp가 포함되어 있고 최적화가 더 잘되어 있기 때문에 llama.cpp보다 더 안정적으로 실행된다는 것만 알아두세요.

Ollama는 어떤 종류의 대용량 모델 파일을 실행할 수 있나요?

Ollama는 추론 엔진이 다른 다음 두 가지 형식의 모델 파일을 지원합니다:

- GGUF 형식통해

llama.cpp추론. - 세이프센서 형식통해

vllm추론.

즉,

- GGUF 형식의 모델을 사용하는 경우, Ollama는

llama.cpp효율적인 CPU/GPU 추론을 수행합니다. - 세이프센서 형식의 모델을 사용하는 경우 Ollama는

vllmGPU 외에도 고성능 추론을 위해 GPU를 사용하는 경우가 많습니다.

물론 설치하는 대부분의 파일은 GGUF 형식이라는 점만 알아두면 됩니다. GGUF를 강조하는 이유는 무엇인가요?

GGUF 지원 정량적(예: Q4, Q6_K)다음과 같은 기능을 제공합니다.매우 낮은 그래픽 및 메모리 사용량으로 우수한 추론 성능 유지세이프티센서는 일반적으로 풀 FP16/FP32 모델이지만, 크기가 훨씬 크고 리소스를 더 많이 차지합니다. 여기에서 자세히 알아보세요:모델 정량화란 무엇인가: FP32, FP16, INT8, INT4 데이터 유형 설명.

Ollama 최소 구성 요구 사항

운영 체제: Linux: Ubuntu 18.04 이상, macOS: macOS 11 Big Sur 이상

RAM: 3B 모델을 실행하는 경우 8GB, 7B 모델을 실행하는 경우 16GB, 13B 모델을 실행하는 경우 32GB

디스크 공간: 올라마와 기본 모델 설치를 위한 12GB, 사용 중인 모델에 따라 모델 데이터 저장을 위한 추가 공간이 필요하며, C 드라이브에 6G의 공간을 확보하는 것이 좋습니다.

CPU: 코어가 4개 이상인 최신 CPU를 사용하는 것이 좋으며, 13B 모델을 실행하려면 코어가 8개 이상인 CPU를 사용하는 것이 좋습니다.

GPU(선택 사항): 올라마를 실행하는 데 GPU가 필요하지는 않지만, 특히 더 큰 모델을 실행할 때 성능을 향상시킬 수 있습니다. GPU가 있는 경우 이를 사용하여 사용자 지정 모델의 학습을 가속화할 수 있습니다.

올라마 설치

이동: https://ollama.com/download

컴퓨터 환경에 따라 선택하기 만하면 설치가 매우 간단하며 여기서주의해야 할 것은 네트워크 환경으로 인해 제대로 설치되지 않을 수 있다는 것입니다.

macOS 설치: https://ollama.com/download/Ollama-darwin.zip

Windows 설치: https://ollama.com/download/OllamaSetup.exe

Linux 설치:curl -fsSL https://ollama.com/install.sh | sh

도커 이미지: (공식 웹사이트에서 직접 배우세요)

CPU 또는 Nvidia GPU:docker pull ollama/ollama

AMD GPU:docker pull ollama/ollama:rocm

설치가 완료되면 바탕화면 오른쪽 하단에 올라마 아이콘이 표시되며, 아이콘에 녹색 경고가 표시되면 업그레이드가 필요하다는 뜻입니다.

올라마 설정

Ollama는 설치가 매우 쉽지만 대부분의 설정은 신규 이민자에게 매우 비우호적 인 "환경 변수"를 변경해야하므로 참조해야하는 사람들을 위해 모든 변수를 나열합니다 (기억할 필요가 없음):

| 매개변수 | 라벨링 및 구성 |

|---|---|

| OLLAMA_MODELS | 모델 파일이 저장된 디렉터리를 나타내며, 기본 디렉터리는 다음과 같습니다.현재 사용자 디렉터리가정(사무실) C:\Users%username%.ollama\modelsWindows 시스템 C 드라이브에 저장하지 않는 것이 좋습니다.디스크는 다른 디스크에 배치할 수 있습니다(예 E:\ollama\models) |

| OLLAMA_HOST | 는 올라마 서비스가 수신 대기하는 네트워크 주소이며, 기본값은127.0.0.1 다른 컴퓨터(예: LAN에 있는 다른 컴퓨터)에서 Ollama에 액세스할 수 있도록 허용하려면 다음과 같이 하세요.권장 설정괜찮아 0.0.0.0 |

| OLLAMA_PORT | 올라마 서비스가 수신 대기하는 기본 포트를 나타내며, 기본값은 다음과 같습니다.11434 포트 충돌이 있는 경우 다른 포트로 설정을 수정할 수 있습니다(예8080등) |

| OLLAMA_ORIGINS | 쉼표로 구분된 목록을 사용하여 HTTP 클라이언트 요청의 출처를 표시합니다. 로컬 사용이 제한되지 않는 경우 별표로 설정할 수 있습니다. * |

| 올라마_유지_알리브 | 대형 모델이 메모리에 로드된 후의 생존 시간을 나타내며, 기본값은 다음과 같습니다.5m5분이 걸립니다. (예: 일반 숫자 300은 300초, 0은 요청에 대한 응답이 처리되는 즉시 모델이 제거됨을 의미하며 음수는 살아남았음을 의미함). 설정하는 것이 좋습니다. 24h 이 모델은 24시간 동안 메모리에 남아 있어 액세스 속도가 빨라집니다. |

| 올라마_넘버_병렬 | 처리된 동시 요청 수를 나타내며, 기본값은1 (즉, 요청의 단일 동시 연속 처리) 실제 요구 사항에 맞게 조정된 권장 사항 |

| 올라마_최대_대기열 | 요청 대기열 길이를 나타내며 기본값은 다음과 같습니다.512 실제 필요에 맞게 조정하는 것이 좋으며, 대기열 길이를 초과하는 요청은 삭제됩니다. |

| OLLAMA_DEBUG | 는 디버그 로그의 출력을 나타내며, 애플리케이션 개발 단계에서 다음과 같이 설정할 수 있습니다.1 (즉, 문제 해결을 위한 자세한 로그 정보 출력) |

| 올라마_최대_로드된_모델 | 메모리에 동시에 로드되는 최대 모델 수를 나타내며, 기본값은 다음과 같습니다.1 (즉, 하나의 모델만 메모리에 저장할 수 있습니다.) |

1. 대용량 모델 파일의 다운로드 디렉터리 수정하기

Windows 시스템에서 Ollama가 다운로드한 모델 파일은 기본적으로 사용자 폴더 아래의 특정 디렉터리에 저장됩니다. 구체적으로, 기본 경로는 일반적으로C:\Users\<用户名>\.ollama\models. 여기.<用户名>는 현재 Windows 시스템 로그인 사용자 이름을 나타냅니다.

예를 들어 시스템 로그인 사용자 이름이yangfan로 설정한 경우 모델 파일의 기본 저장 경로는 다음과 같습니다.C:\Users\yangfan\.ollama\models\manifests\registry.ollama.ai. 이 디렉토리에서 사용자는 Ollama를 통해 다운로드한 모든 모델 파일을 찾을 수 있습니다.

참고: 일반적으로 최신 시스템 설치 경로는 다음과 같습니다:C:\Users\<用户名>\AppData\Local\Programs\Ollama

대용량 모델 다운로드는 쉽게 몇 기가바이트가 될 수 있으며, C 드라이브 공간이 작은 경우 가장 먼저 해야 할 일은 대용량 모델 파일의 다운로드 디렉터리를 수정하는 것입니다.

1. 환경 변수의 진입점 찾기

가장 쉬운 방법: Win+R을 눌러 실행 창을 열고 다음을 입력합니다. sysdm.cpl이 옵션을 사용하려면 들어가서 시스템 속성을 열고 고급 탭을 선택한 다음 환경 변수를 클릭합니다.

기타 방법:

1. 시작->설정->정보->고급 시스템 설정->시스템 속성->환경 변수로 이동합니다.

2. 이 컴퓨터 -> 오른쪽 클릭 -> 속성 -> 고급 시스템 설정 -> 환경 변수를 선택합니다.

3. 시작->제어판->시스템 및 보안->시스템->고급 시스템 설정->시스템 속성->환경 변수를 클릭합니다.

4. 바탕화면 하단의 검색 상자->입력->환경 변수

들어가면 다음 화면이 표시됩니다:

2. 환경 변수 수정

시스템 변수에서 OLLAMA_MODELS라는 변수 이름을 찾고, 없는 경우 새로 만들기를 클릭합니다.

OLLAMA_MODELS가 이미 있는 경우 이를 선택하고 마우스 왼쪽 버튼을 두 번 클릭하거나 선택 후 '편집'을 클릭합니다.

변수 값은 새 디렉터리로 변경되며, 여기서는 디스크 공간이 더 많은 드라이브 C에서 드라이브 E로 변경했습니다.

저장 후에는 컴퓨터를 새로 시작하여 다시 사용하는 것이 더 안전한 결과를 얻을 수 있습니다.

2. 기본 액세스 주소와 포트를 수정합니다.

브라우저에 URL을 입력하세요: http://127.0.0.1:11434/ , 실행 중임을 나타내는 다음 메시지가 표시되며, 여기에 수정해야 할 몇 가지 보안 위험이 여전히 환경 변수에 있습니다.

1.OLLAMA_HOST 수정하기

그렇지 않은 경우 새로 추가하고, 0.0.0.0 엑스트라넷 액세스 허용인 경우 127.0.0.1로 변경합니다.

2.OLLAMA_PORT 수정

없는 경우 추가하고 11434를 다음과 같은 포트로 변경합니다.:11331(포트 수정 범위는 1에서 65535까지) 포트 충돌을 피하기 위해 1000부터 시작합니다. 영어 ":"가 사용된다는 점에 유의하세요.

컴퓨터를 재부팅하여 Ollama의 보안에 대한 권장 사항을 읽어보세요:Ollama에 불을 지른 DeepSeek, 로컬 배포는 안전한가요? "훔친" 산술에 주의하세요!

대형 모델 설치

URL로 이동: https://ollama.com/search

모델 선택, 모델 크기 선택, 복사 명령

명령줄 도구에 액세스

명령을 붙여넣으면 자동으로 설치됩니다.

여기에서 다운로드 중이므로 속도가 느리다면 더 쾌적한 인터넷 환경으로 전환해 보세요!

올라마에서 제공하지 않는 대형 모델을 다운로드하고 싶다면 확실히 그렇게 할 수 있습니다. 대부분은 huggingface의 GGUF 파일이며, 저는 특별히 정량화 된 버전의 DeepSeek-R1 32B는 설치 데모를 위한 예제로 사용됩니다.

1. 허깅페이스 정량적 버전 관리 모델 기본 명령 형식 설치하기

다음 설치 명령 형식을 기억하세요.

ollama run hf.co/{username}:{reponame}

2. 정량적 버전 선택

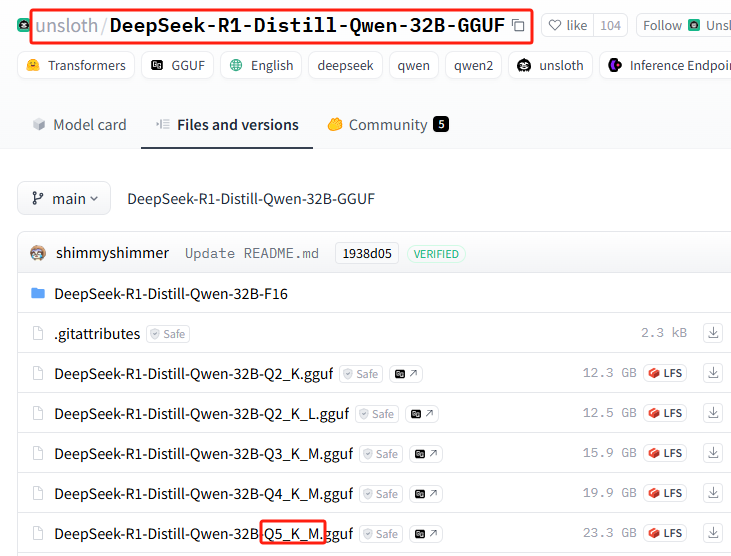

모든 정량적 버전 목록: https://huggingface.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF/tree/main

이 설치는 다음을 사용합니다: Q5_K_M

3. 스플라이스 설치 명령

{사용자 이름}=unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF

{reponame}=Q5_K_M

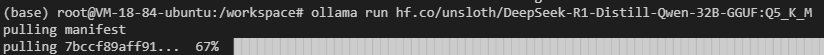

전체 설치 명령을 얻으려면 함께 연결하세요:ollama run hf.co/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

4. Ollama에서 설치를 수행합니다.

설치 명령을 실행합니다.

네트워크 오류가 발생할 수 있으므로 설치 명령을 몇 번 더 반복하고...

여전히 작동하지 않나요? 다음 명령을 사용해 보세요.hf.co/섹션을 다음과 같이 수정합니다.https://hf-mirror.com/(국내 미러 주소로 전환)를 실행하면 전체 설치 명령의 최종 패치 작업은 다음과 같습니다:

ollama run https://hf-mirror.com/unsloth/DeepSeek-R1-Distill-Qwen-32B-GGUF:Q5_K_M

이 섹션에 대한 전체 튜토리얼을 확인할 수 있습니다:로컬 GPU가 없는 프라이빗 배포 DeepSeek-R1 32B

올라마 기본 명령

| 명령 | 설명 |

|---|---|

ollama serve | 올라마 출시 |

ollama create | 모델 파일에서 모델 만들기 |

ollama show | 모델 정보 표시 |

ollama run | 운영 모델 |

ollama stop | 실행 중인 모델 중지하기 |

ollama pull | 레지스트리에서 모델 가져오기 |

ollama push | 모델을 레지스트리에 푸시하기 |

ollama list | 모든 모델 목록 |

ollama ps | 실행 중인 모델 나열 |

ollama cp | 복제 모델 |

ollama rm | 모델 삭제 |

ollama help | 모든 명령에 대한 도움말 정보 표시 |

| 상징 | 설명 |

|---|---|

-h, --help | Ollama에 대한 도움말 정보 표시 |

-v, --version | 버전 정보 표시 |

여러 줄에 걸쳐 명령을 입력할 때는 """ 라인 피드를 수행합니다.

활용 """ 줄 바꿈 종료.

올라마 모델 추론 서비스를 종료하려면 다음을 사용할 수 있습니다. /bye.

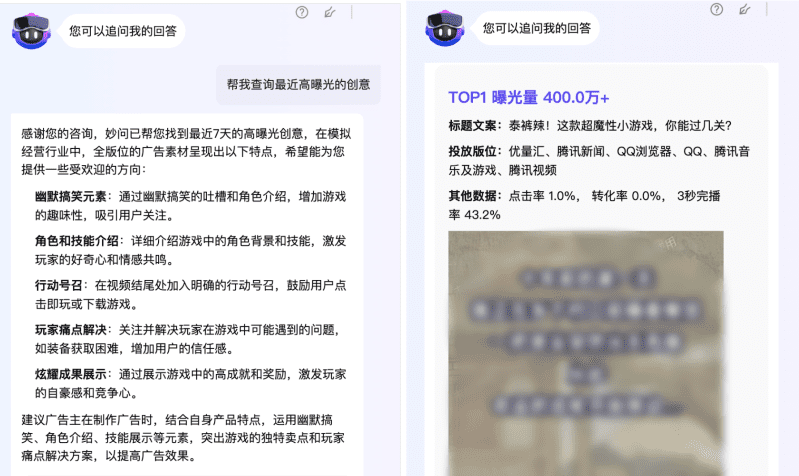

기본 AI 대화 도구에서 올라마 사용하기

대부분의 주요 네이티브 AI 대화 도구는 이미 기본적으로 올라마에 맞게 조정되어 있으며 별도의 설정이 필요하지 않습니다. 예를 들면 다음과 같습니다. 페이지 지원 OpenwebUI.

하지만 일부 로컬 AI 대화 도구는 사용자가 직접 API 주소를 입력해야 합니다.http://127.0.0.1:11434/(포트가 수정된 경우 참고)

일부 웹 기반 AI 대화 도구는 다음과 같은 구성을 확실히 지원합니다. 다음 채팅 :

로컬 컴퓨터에서 실행 중인 올라마를 외부에 완전히 노출하여 사용하려면 초보자의 사용 범위를 벗어나는 cpolar 또는 ngrok을 직접 배우세요.

이 기사는 매우 길어 보이며 실제로 4 가지 매우 간단한 지식 포인트 내에서 기본적으로 Ollama의 향후 사용을 기본적으로 방해받지 않고 다시 검토하겠습니다:

1. 환경 변수 설정

2. 대형 모델을 설치하는 두 가지 방법

3. 기본 모델 실행 및 삭제 명령을 기억합니다.

4. 다른 클라이언트에서 사용

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...

![[转]从零拆解一款火爆的浏览器自动化智能体,4步学会设计自主决策Agent](https://aisharenet.com/wp-content/uploads/2025/01/e0a98a1365d61a3.png)