Ollama 설치 및 구성 - Windows 시스템

개요

이 섹션에서는 Windows 시스템에서 이 작업을 수행하는 방법에 대해 알아봅니다. Ollama 설치 및 구성은 다음 섹션으로 나뉩니다.

- 공식 웹사이트를 방문하여 직접 다운로드를 완료하세요.

- 환경 변수 구성

- 올라마 실행

- 성공적인 설치 확인 🎉

I. 공식 웹사이트를 방문하여 직접 다운로드를 완료합니다.

- 공식 홈페이지 방문하기

올라마 다운로드: https://ollama.com/download

올라마 공식 홈페이지: https://ollama.com

올라마 공식 GitHub 소스 코드 리포지토리: https://github.com/ollama/ollama/

- 브라우저가 OllamaSetup.exe 파일을 다운로드 할 때까지 기다렸다가 완료되면 파일을 두 번 클릭하면 다음 팝업 창이 나타나면 클릭하십시오.

Install다운로드가 완료될 때까지 기다리세요.

- 설치가 완료되면 Ollama가 이미 기본적으로 실행 중인 것을 확인할 수 있습니다. 하단 탐색 모음에서 Ollama 로고를 찾아 마우스 오른쪽 버튼으로 클릭하면 됩니다.

Quit Ollama올라마 종료 또는 보기logs.

II. 환경 변수 구성

Ollama다른 소프트웨어처럼 컴퓨터에서 클릭 한 번으로 Ollama를 설치할 수 있지만, 실제 필요에 따라 시스템 환경 변수를 구성하는 것이 좋습니다. 다음은 Ollama의 환경 변수를 구성하는 방법입니다.

| 매개변수 | 라벨링 및 구성 |

|---|---|

| OLLAMA_MODELS | 모델 파일이 저장된 디렉터리를 나타내며, 기본 디렉터리는 다음과 같습니다.현재 사용자 디렉터리가정(사무실)C:\Users%username%.ollama\modelsWindows 시스템 C 드라이브에 저장하지 않는 것이 좋습니다. 디스크는 다른 디스크에 배치할 수 있습니다(예 E:\ollama\models) |

| OLLAMA_HOST | 는 올라마 서비스가 수신 대기하는 네트워크 주소이며, 기본값은127.0.0.1 다른 컴퓨터(예: LAN에 있는 다른 컴퓨터)에서 Ollama에 액세스할 수 있도록 허용하려면 다음과 같이 하세요.권장 설정괜찮아 0.0.0.0 |

| OLLAMA_PORT | 올라마 서비스가 수신 대기하는 기본 포트를 나타내며, 기본값은 다음과 같습니다.11434 포트 충돌이 있는 경우 다른 포트로 설정을 수정할 수 있습니다(예8080등) |

| OLLAMA_ORIGINS | HTTP 클라이언트의 요청 소스를 나타내며, 로컬 사용이 제한되지 않는 경우 쉼표 반을 사용하여 목록을 구분하고 별표로 설정할 수 있습니다. * |

| 올라마_유지_알리브 | 대형 모델이 메모리에 로드된 후의 생존 시간을 나타내며, 기본값은 다음과 같습니다.5m즉, 5분(예: 일반 숫자 300은 300초, 0은 요청에 대한 응답이 처리되는 즉시 모델이 제거됨을 의미하며 음수는 모델이 항상 살아있음을 의미)으로 설정하는 것이 좋습니다. 24h 이 모델은 24시간 동안 메모리에 남아 있어 액세스 속도가 빨라집니다. |

| 올라마_넘버_병렬 | 처리된 동시 요청 수를 나타내며, 기본값은1(즉, 요청의 단일 동시 연속 처리) 실제 요구 사항에 맞게 조정된 권장 사항 |

| 올라마_최대_대기열 | 요청 대기열 길이를 나타내며 기본값은 다음과 같습니다.512실제 필요에 맞게 조정하는 것이 좋으며, 대기열 길이를 초과하는 요청은 삭제됩니다. |

| OLLAMA_DEBUG | 는 디버그 로그의 출력을 나타내며, 애플리케이션 개발 단계에서 다음과 같이 설정할 수 있습니다.1(즉, 문제 해결을 위한 자세한 로그 정보 출력) |

| 올라마_최대_로드된_모델 | 메모리에 동시에 로드되는 최대 모델 수를 나타내며, 기본값은 다음과 같습니다.1(즉, 하나의 모델만 메모리에 저장할 수 있습니다.) |

초보자의 경우 다음을 구성하는 것이 좋습니다. OLLAMA_MODELS 를 클릭하여 모델 저장 위치를 변경합니다. 기본적으로 Ollama 모델은 C 드라이브의 사용자 디렉터리에 저장됩니다. .ollama/models 폴더는 C 드라이브의 공간을 차지합니다. 다른 파티션으로 변경하면 저장 공간을 더 효율적으로 관리할 수 있습니다.

1단계: 시스템 환경 변수를 설정하기 위한 진입점을 찾습니다.

방법 1: 시작->설정->정보->고급 시스템 설정->시스템 속성->환경 변수.

방법 2: 이 컴퓨터 -> 마우스 오른쪽 버튼 클릭 -> 속성 -> 고급 시스템 설정 -> 환경 변수.

방법 3: 시작->제어판->시스템 및 보안->시스템->고급 시스템 설정->시스템 속성->환경 변수.

방법 4: Win+R을 눌러 실행 창을 열고 다음을 입력합니다. sysdm.cpl이 옵션을 사용하려면 들어가서 시스템 속성을 열고 고급 탭을 선택한 다음 환경 변수를 클릭합니다.

2단계: 설정 OLLAMA_MODELS 환경 변수(모델 저장 위치 변경)

- " 환경 변수 " 창 " 시스템 변수(S) " 영역(또는 필요에 따라 "사용자 변수(U)" 영역)을 클릭하고 " 신규 (W)... " 버튼을 클릭합니다.

- " 변수 이름(N) " 입력 상자에 입력합니다:

OLLAMA_MODELS(대소문자 모두 대문자로 표기하는 것이 좋습니다). - " 가변 값(V) ' 입력 상자에 설정하려는 모델 저장 경로를 입력합니다. 예를 들어, 모델을 E 드라이브에 저장하려는 경우

ollama\models폴더에서 "변수 값(V)"을 입력할 수 있습니다:E:\ollama\models(실제 상황에 따라 디스크 문자 및 폴더 경로를 수정하세요).- 주의: 경로를 입력해야 합니다. 이미 존재하는 폴더 또는 만들려는 폴더의 상위 디렉터리가 존재합니다. . Ollama는 처음 실행할 때 자동으로 생성될 수 있습니다.

models폴더를 생성하는 것이 좋지만ollama폴더에 경로가 올바른지 확인합니다. - 예시: E-드라이브에 모델을 저장하려면 다음과 같이 하세요.

ollama\models폴더에 있는 '변수 값(V)'에 입력할 수 있습니다:E:\ollama\models

- 주의: 경로를 입력해야 합니다. 이미 존재하는 폴더 또는 만들려는 폴더의 상위 디렉터리가 존재합니다. . Ollama는 처음 실행할 때 자동으로 생성될 수 있습니다.

- " 정의 " 버튼, 닫기 " 새로운 시스템 변수 "(또는 "새 사용자 변수") 창을 클릭합니다.

주의: 설정 방법을 모르는 경우

OLLAMA_MODELS환경 변수에 대한 자세한 내용은 다음 예제를 참조하세요.

(선택 사항) 설정 OLLAMA_HOST 환경 변수를 변경합니다(수신 주소를 변경하려면).

랜에 있는 다른 기기에서 올라마 서비스에 액세스할 수 있도록 해야 하는 경우, 다음과 같이 구성할 수 있습니다. OLLAMA_HOST 환경 변수.

- 또한 " 환경 변수 " 창 " 시스템 변수(S) " 영역(또는 "사용자 변수(U)" 영역)을 클릭하고 " 신규 (W)... " 버튼을 클릭합니다.

- " 변수 이름(N) " 입력 상자에 입력합니다:

OLLAMA_HOST - " 가변 값(V) " 입력 상자에 다음을 입력합니다.

0.0.0.0:11434(또는 지정하려는 포트 번호, 기본 포트는 11434)를 입력합니다.0.0.0.0LAN 액세스를 허용하기 위해 모든 네트워크 인터페이스를 수신 중임을 나타냅니다.11434는 Ollama 기본 포트입니다.- 예시:

0.0.0.0:11434

- " 정의 " 버튼, 닫기 " 새로운 시스템 변수 "(또는 "새 사용자 변수") 창을 클릭합니다.

3단계: 환경 변수를 적용하려면 Ollama 또는 PowerShell을 다시 시작합니다.

환경 변수가 설정되면 다음을 수행해야 합니다. 올라마 서비스 다시 시작하기 또는 명령 프롬프트(CMD) 또는 PowerShell 창을 다시 시작합니다. 를 입력해야 새 환경 변수가 적용됩니다.

- 올라마 서비스를 다시 시작합니다. 실행하는 경우

ollama serve이전Ctrl + C중지 후 다시 실행ollama serve. - 명령 프롬프트/파워셸을 다시 시작합니다. 열려 있는 모든 창을 닫고 새 창을 다시 엽니다.

4단계: 환경 변수가 적용되었는지 확인하기

- 다시 열기 명령 프롬프트(CMD) 또는 PowerShell .

- 검증(이론)

OLLAMA_MODELS: 다음 명령을 입력하고 입력합니다:

echo %OLLAMA_MODELS%

출력:

E:\ollama\models(설정한 경우E:\ollama\models)

III. 달리기 올라마

- 명령줄 문 시작

ollama serve

Windows 시스템에 Ollama를 설치하면 다음과 같은 오류가 발생합니다. 기본 부팅 (수학.) 속Ollama 서비스 기본값은 http://127.0.0.1:11434

Error: listen tcp 127.0.0.1:11434: bind: Only one usage of each socket address (protocol/network address/port) is normally permitted.

- 솔루션:

- (컴퓨터) 바로 가기 키

Win+X작업 관리자를 열고启动다음은 Ollama를 비활성화하는 방법의 예입니다.코스올라마의 임무는 올해 중반에 종료되었습니다.

- 재사용

ollama serve올라마를 엽니다.

- 성공적인 시작을 확인합니다:

- (컴퓨터) 바로 가기 키

Win+R입력cmd를 클릭하고 명령줄 터미널을 엽니다. - 가져오기

netstat -aon|findstr 11434포트 11434를 사용하는 프로세스를 확인합니다.

netstat -aon|findstr 11434

출력:

TCP 127.0.0.1:11434 0.0.0.0:0 LISTENING 17556포트 11434가 17556 프로세스에 의해 점유되고 있음을 보여줍니다.

- 실행 중인 프로세스를 보면 올라마가 시작되었음을 알 수 있습니다.

tasklist|findstr "17556"

출력은 다음과 같습니다:

ollama.exe 17556 Console 1 31,856 K

IV. 성공적인 설치 확인 🎉

- 터미널 입력:

ollama -h

출력은 다음과 같습니다: 설치가 성공했음을 의미합니다🎉.

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

- Ollama의 터미널 사용.

라이브러리(ollama.com) 다음은 올라마 모델 라이브러리입니다. 원하는 모델을 검색하여 바로 실행하세요!

ollama run llama3

다운로드 속도는 대역폭에 따라 다르며 바로 사용할 수 있습니다.

control + D채팅 종료

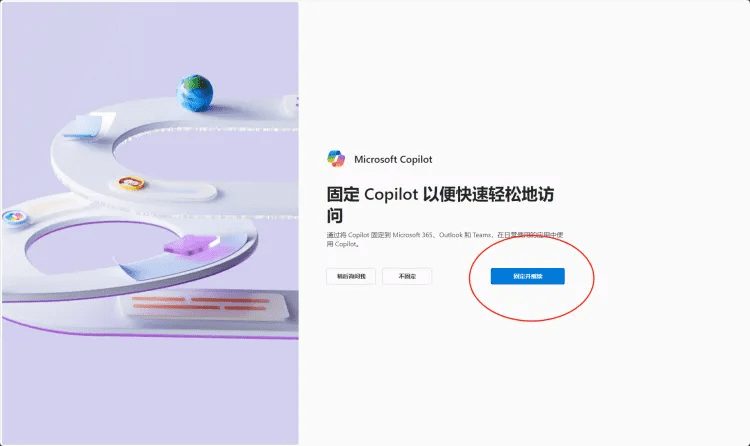

다섯째, 부팅을 취소하는 방법

(2024-08-19 기준) 현재 올라마는 Windows에서 기본적으로 부팅되며, 부팅할 필요가 없는 경우 아래 단계에 따라 부팅을 취소할 수 있습니다.

작업 관리자를 열고 启动应用찾기 ollama.exe 마우스 오른쪽 버튼 클릭 禁用 준비 완료.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...