일반 소개

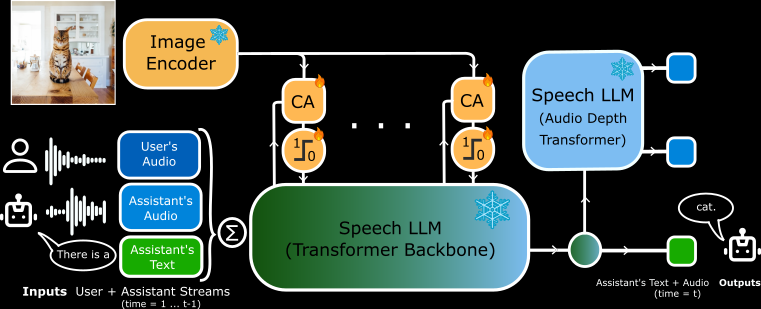

모시비스는 규타이 연구소에서 개발하여 깃허브에서 호스팅하는 오픈 소스 프로젝트입니다. 약 2억 6천만 개의 새로운 적응 파라미터와 고정된 PaliGemma2 시각 인코더(4억 개의 파라미터)가 포함된 Moshi 음성-텍스트 모델(7B 파라미터)을 기반으로 모델이 음성을 사용하여 사용자와 실시간으로 이미지 콘텐츠를 논의할 수 있으며, MoshiVis의 핵심 기능은 짧은 지연 시간, 자연스러운 대화 및 이미지 이해 기능입니다. PyTorch, Rust 및 MLX 백엔드를 지원하며, 사용자는 코드와 모델 가중치를 무료로 다운로드하여 로컬 디바이스에서 실행할 수 있습니다. 이 프로젝트는 개발자와 연구원을 대상으로 하며, AI 상호작용을 탐색하거나 새로운 애플리케이션을 개발하는 데 적합합니다.

기능 목록

- 실시간 음성 입력 및 출력을 지원하여 사용자가 말한 후 모델이 빠르게 응답합니다.

- 이미지의 내용을 분석하고 음성 또는 텍스트로 그림의 세부 사항을 설명하는 기능.

- 파이토치, 러스트, MLX 백엔드는 다양한 하드웨어에 사용할 수 있습니다.

- 소스 코드와 모델 가중치를 공개하여 사용자가 자유롭게 수정할 수 있습니다.

- 실시간 대화 시나리오를 위한 짧은 지연 시간 설계.

- 메모리와 성능을 최적화하기 위해 양자화 형식(예: 4비트, 8비트)을 지원합니다.

- 시각 및 음성 정보를 융합하는 교차 주의 메커니즘이 내장되어 있습니다.

도움말 사용

모시비스를 설치 및 사용하려면 약간의 기술력이 필요합니다. 자세한 공식 지침이 제공되며, 다음은 설치 및 작동에 대한 전체 가이드입니다.

설치 프로세스

모시비스는 세 가지 백엔드 실행을 지원하므로 사용자는 자신의 디바이스에 적합한 버전을 선택할 수 있습니다. 최소 요구 사항에는 Python 3.10 이상과 충분한 RAM(PyTorch 버전에는 24GB GPU가 권장되며, Mac에는 MLX 버전이 적합함)이 포함됩니다.

PyTorch 백엔드 설치

- 종속성을 설치합니다:

pip install -U moshi

- 모델 가중치를 다운로드하고 서비스를 시작합니다:

cd kyuteye_pt

python -m moshi.server --hf-repo kyutai/moshika-vis-pytorch-bf16 --port 8088

- 인터뷰

https://localhost:8088를 클릭하고 웹 인터페이스로 들어갑니다. - 원격으로 실행하는 경우 SSH를 사용하여 포트를 전달해야 합니다:

ssh -L 8088:localhost:8088 user@remote

Rust 백엔드 설치

- Rust 툴체인 설치(

rustup(액세스). - GPU 지원(Mac의 경우 Metal, NVIDIA의 경우 CUDA)을 구성합니다.

- 서비스를 실행합니다:

cd kyuteye_rs

cargo run --features metal --bin moshi-backend -r -- --config configs/config-moshika-vis.json standalone --vis

- "독립형 작업자 듣기"가 표시되면 다음을 방문하세요.

https://localhost:8088. - 정량화된 버전(옵션):

cargo run --features metal --bin moshi-backend -r -- --config configs/config-moshika-vis-q8.json standalone --vis

MLX 백엔드 설치(Mac 권장)

- MLX 종속성을 설치합니다:

pip install -U moshi_mlx

- 시작 서비스(여러 양자화 형식 지원)

cd kyuteye_mlx

python -m moshi_mlx.server # 默认 BF16

python -m moshi_mlx.server -q 4 # 4 位量化

python -m moshi_mlx.server -q 8 # 8 位量化

- 인터뷰

http://localhost:8008웹 인터페이스를 사용합니다.

프런트엔드 설치

- 사전 빌드된 클라이언트를 다운로드하세요:

pip install fire rich huggingface_hub

python scripts/get_static_client.py

- SSL 인증서(HTTPS용)를 생성합니다:

openssl req -x509 -nodes -days 365 -newkey rsa:2048 -keyout key.pem -out cert.pem

- 백엔드는 기본적으로 웹 인터페이스를 제공하며 추가 작업이 필요하지 않습니다.

주요 기능

실시간 음성(RTV) 대화

- 이동서비스를 시작한 후 웹 인터페이스(

https://localhost:8088어쩌면http://localhost:8008). 마이크 아이콘을 클릭하여 대화를 시작합니다. - 일반적인 예"안녕하세요"라고 말하면 모델이 여성 목소리(모시카)로 "안녕하세요, 무엇을 도와드릴까요?"라고 응답합니다. .

- 포인트마이크 권한이 켜져 있는지 확인하기 위한 밀리초 수준의 낮은 지연 시간.

- 적응Rust 버전은 명령줄 인터페이스를 지원합니다:

cd kyuteye_rs

cargo run --bin moshi-cli -r -- tui --host localhost

그래픽 이해

- 이동웹 인터페이스에서 이미지를 업로드하거나 명령줄로 경로를 지정합니다:

python -m moshi_mlx.server -q 8 --image path/to/image.jpg

- rig사진을 업로드하고 "이게 뭐야?"라고 말하세요. 모델이 "흰 구름이 있는 파란 하늘 사진입니다"와 같이 음성으로 설명해 줍니다.

- 특성화팔리젬마2 인코더를 기반으로 물체, 색상, 장면을 인식합니다.

모델 사용자 지정

- 이동: 허깅 페이스에서 다른 가중치를 다운로드합니다(예

kyutai/moshika-vis-mlx-bf16)를 클릭하고 구성 파일에서 경로를 바꿉니다. - rig수정 : 수정

configs/moshika-vis.yaml어쩌면config-moshika-vis.json를 클릭하고 서비스를 다시 시작합니다. - 사용음성 스타일을 조정하거나 성능을 최적화합니다.

전체 운영 절차

- 백엔드 선택사용 중인 기기에 따라 PyTorch(GPU), Rust(크로스 플랫폼) 또는 MLX(Mac)를 선택하세요.

- 설치 환경위의 명령에 따라 종속성과 모델을 설치합니다.

- 서비스 시작: 백엔드를 실행하고 서비스가 준비될 때까지 기다립니다.

- 연결 인터페이스브라우저로 지정된 포트에 액세스합니다.

- 음성 테스트간단한 문장을 말하고 응답을 확인합니다.

- 테스트 이미지사진을 업로드하고 음성으로 질문하세요.

- 최적화 설정양자화 매개변수 조정(

-q 4어쩌면-q 8) 또는 포트 번호입니다.

주의

- HTTPS에는 SSL 인증서가 필요하며, 그렇지 않으면 브라우저에서 마이크 액세스를 제한할 수 있습니다.

- 파이토치에서는 정량화가 지원되지 않으며 고성능 GPU가 필요합니다.

- Rust 버전은 컴파일하는 데 시간이 걸리므로 처음 실행할 때는 조금만 기다려주세요.

- MLX 버전은 M3 맥북 프로에서 안정적으로 테스트되었으며, 맥 사용자에게 권장됩니다.

애플리케이션 시나리오

- 교육 지원

학생들이 교과서 이미지를 업로드하면 모시비스가 "이것은 세포 구조의 다이어그램으로 핵과 미토콘드리아를 보여줍니다."와 같이 오디오를 사용하여 내용을 설명합니다. - 접근성 지원

시각 장애가 있는 사용자들은 "우유와 빵이 가득한 슈퍼마켓 진열대"라고 설명하는 모델 사진을 매일 업로드했습니다. - 개발 실험

개발자는 이를 사용하여 이미지 상호작용을 위해 스마트 기기에 통합된 음성 비서를 구축할 수 있습니다.

QA

- 모시비스는 오프라인 사용을 지원하나요?

예. 설치가 완료되면 인터넷 연결 없이도 모든 기능이 로컬에서 실행됩니다. - 보이스는 여러 언어를 지원하나요?

현재는 주로 영어 대화와 설명을 지원하며, 다른 언어의 기능은 제한적입니다. - 저가의 컴퓨터도 작동하나요?

MLX 버전은 일반 Mac에서 실행되며 PyTorch 버전은 24GB의 GPU 메모리가 필요합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...