일반 소개

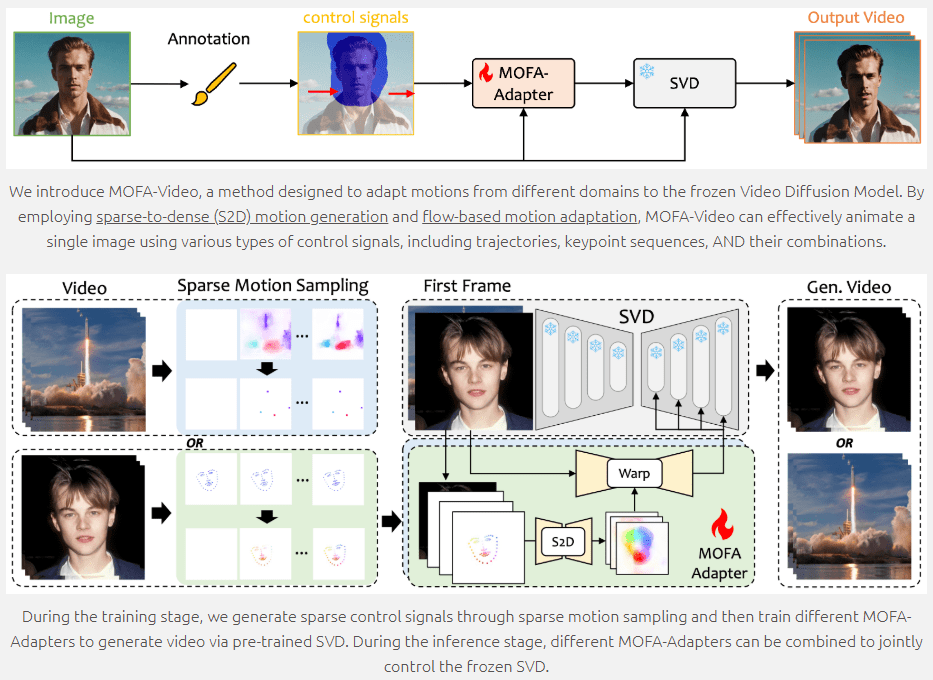

MOFA-Video는 제너레이티브 모션 필드 적응 기술을 사용하여 정적인 이미지를 동적인 비디오로 변환하는 최첨단 이미지 애니메이션 생성 툴입니다. 도쿄대학교 및 텐센트 AI 연구소와 협력하여 개발되어 ECCV 2024에서 발표될 예정인 MOFA-Video는 궤적, 키포인트 시퀀스 및 이들의 조합을 포함한 다양한 제어 신호를 지원하여 고품질 이미지 애니메이션을 구현할 수 있습니다. 사용자는 GitHub 저장소를 통해 코드 및 관련 리소스에 액세스하여 쉽게 시작할 수 있습니다.

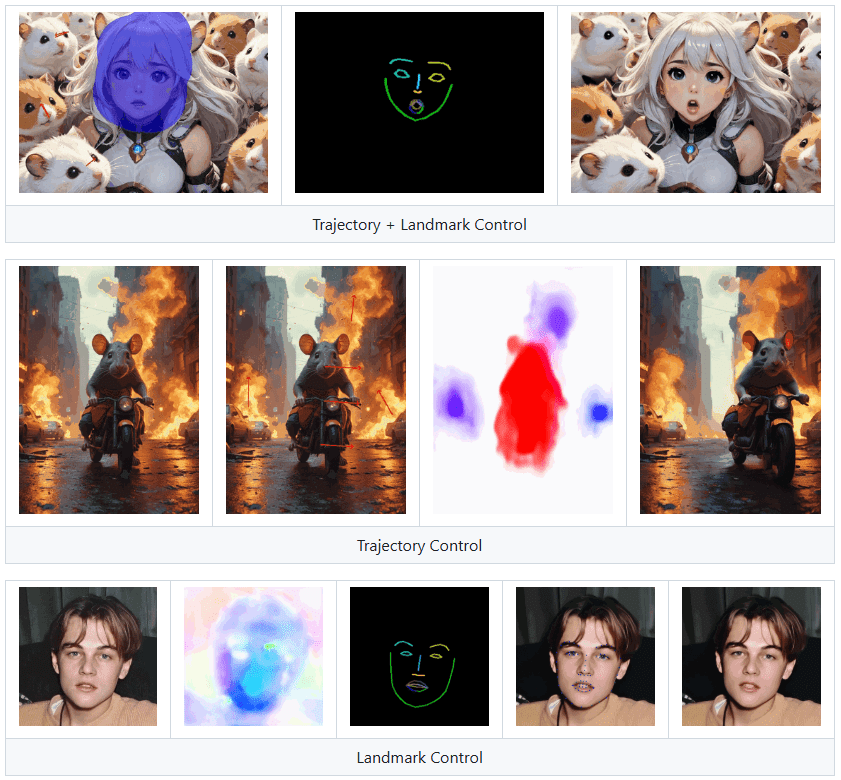

랜드마크 컨트롤은 이미지 속 사람이 말을 하게 만들 수는 있지만 디지털 인물의 복제본으로 사용하기에는 적합하지 않습니다.

기능 목록

- 이미지 애니메이션 생성: 정지 이미지를 움직이는 동영상으로 변환합니다.

- 다중 제어 신호: 궤적, 키 포인트 시퀀스 및 이들의 조합 지원

- 모션 필드 적응: 희소 모션에서 고밀도 모션 생성을 통한 애니메이션 및 흐름 기반 모션 적응

- 훈련 및 추론 스크립트: 훈련 및 추론을 위한 완전한 코드 제공

- 그라디오 데모: 온라인 데모 및 체크포인트 다운로드

- 오픈 소스: 코드와 리소스를 GitHub에서 공개적으로 사용 가능하게 만들기

도움말 사용

환경 설정

- 클론 창고

git clone https://github.com/MyNiuuu/MOFA-Video.git

cd ./MOFA-Video

- Conda 환경 만들기 및 활성화

conda create -n mofa python==3.10

conda activate mofa

- 종속성 설치

pip install -r requirements.txt

pip install opencv-python-headless

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

- 체크포인트 다운로드 HuggingFace 리포지토리에서 체크포인트를 다운로드하여

./MOFA-Video-Hybrid/models/cmp/experiments/semiauto_annot/resnet50_vip+mpii_liteflow/checkpoints카탈로그.

Gradio 데모

- 오디오를 사용하여 얼굴 애니메이션 구동하기

cd ./MOFA-Video-Hybrid

python run_gradio_audio_driven.py

- 레퍼런스 동영상으로 얼굴 애니메이션 구동하기

cd ./MOFA-Video-Hybrid

python run_gradio_video_driven.py

라디오 인터페이스에 지침이 표시되므로 인터페이스의 지침에 따라 추론 작업을 수행하세요.

교육 및 추론

MOFA-Video는 필요에 따라 사용자 지정할 수 있는 완전한 교육 및 추론 스크립트를 제공합니다. 자세한 지침은 GitHub 리포지토리에 있는 README 파일을 참조하세요.

주요 기능

- 이미지 애니메이션 생성: 정적 이미지를 업로드하고 제어 신호(궤적, 키 포인트 시퀀스 또는 이들의 조합)를 선택한 다음 생성 버튼을 클릭하여 동적 동영상을 생성합니다.

- 다중 제어 신호: 사용자는 다양한 제어 신호 조합을 선택하여 더욱 풍부한 애니메이션 효과를 얻을 수 있습니다.

- 모션 필드 적응: 드문드문한 모션 생성 및 흐름 기반 모션 적응 기술을 통해 부드럽고 자연스러운 애니메이션 효과를 보장합니다.

MOFA-Video는 사용자가 이미지 애니메이션을 생성하고 필요에 따라 교육을 맞춤 설정하고 고품질 이미지 애니메이션 효과를 쉽게 얻을 수 있도록 다양한 기능과 자세한 지침을 제공합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...