모델 컨텍스트 제공자 CLI: 모든 대형 모델에서 MCP 서비스를 사용하기 위한 명령줄 도구로, Claude에 의존하지 않습니다.

일반 소개

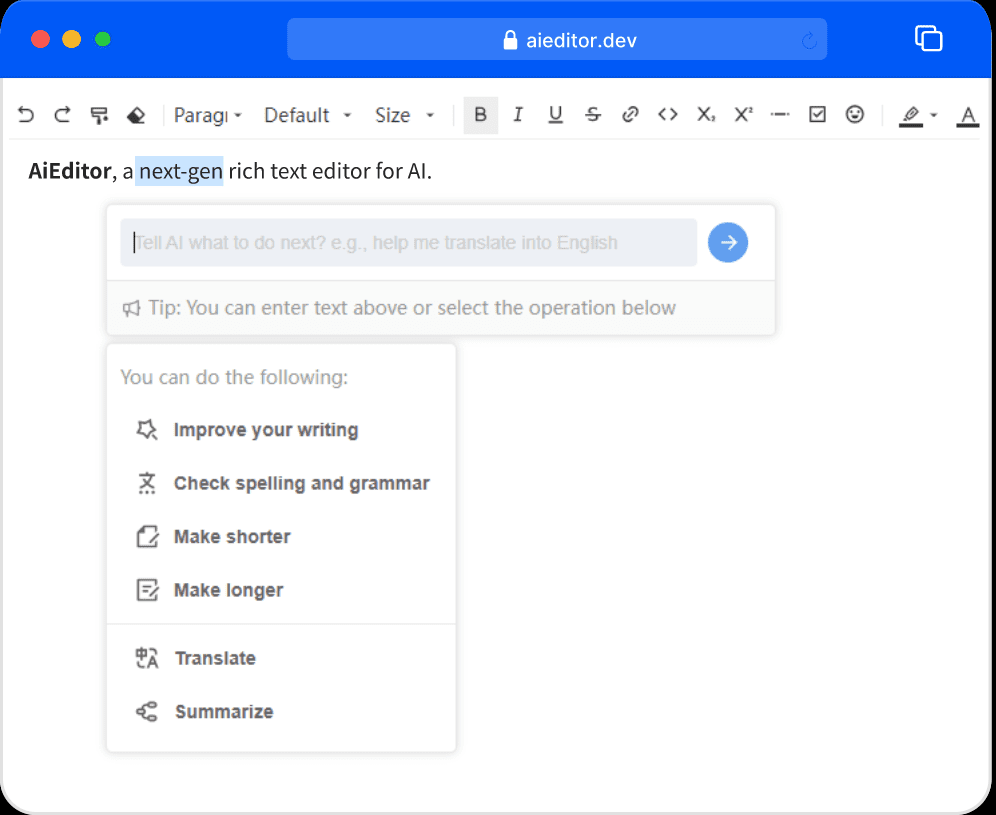

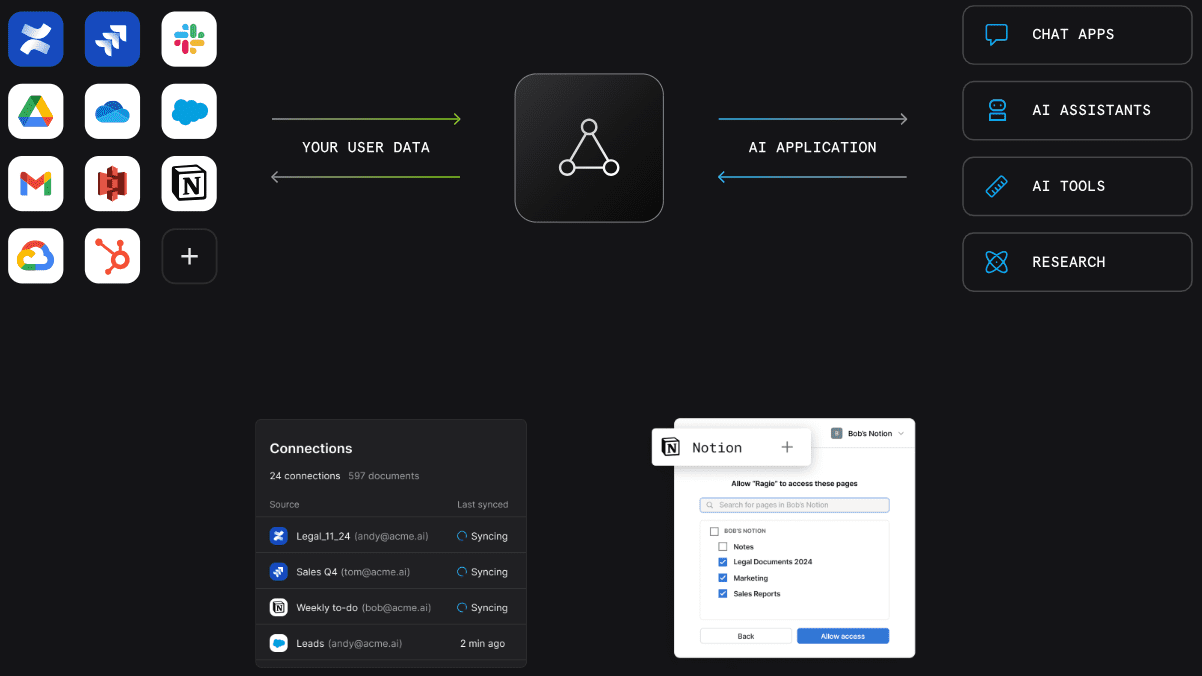

모델 컨텍스트 공급자 CLI(mcp-cli)는 모델 컨텍스트 공급자 서버와 상호 작용하기 위한 프로토콜 수준의 명령줄 도구입니다. 이 도구를 사용하면 명령을 보내고, 데이터를 쿼리하고, 서버에서 제공하는 다양한 리소스와 상호 작용할 수 있습니다. mcp-cli는 기본 모델인 gpt-4o-mini와 qwen2.5-coder를 포함하여 OpenAI 및 Ollama를 비롯한 여러 공급자와 모델을 지원합니다. 이 도구를 사용하려면 Python 3.8 이상과 적절한 종속성이 필요합니다. GitHub 리포지토리를 복제하고 필요한 종속 요소를 설치하여 도구를 사용할 수 있습니다.

기능 목록

- 모델 컨텍스트 프로비저닝 서버와의 프로토콜 수준 통신 지원

- 탐색할 수 있는 동적 도구 및 리소스

- 여러 제공업체 및 모델 지원(OpenAI 및 Ollama)

- 사용자가 동적으로 명령을 실행할 수 있는 대화형 모드를 제공합니다.

- 지원되는 명령: 핑, 목록 도구, 목록 리소스, 목록 프롬프트, 채팅, 지우기, 도움말, 종료/종료

- 지원되는 명령줄 매개변수: --server, --config-file, --provider, --model

도움말 사용

설치 프로세스

- 복제 창고:

git clone https://github.com/chrishayuk/mcp-cli

cd mcp-cli

- UV를 설치합니다:

pip install uv

- 종속성 동기화:

uv sync --reinstall

사용법

- 클라이언트를 시작하고 SQLite 서버와 상호 작용합니다:

uv run main.py --server sqlite

- 기본 OpenAI 공급자 및 모델을 사용하여 클라이언트를 실행합니다:

uv run main.py --server sqlite

- 특정 구성 및 Ollama 공급자가 클라이언트를 실행합니다:

uv run main.py --server sqlite --provider ollama --model llama3.2

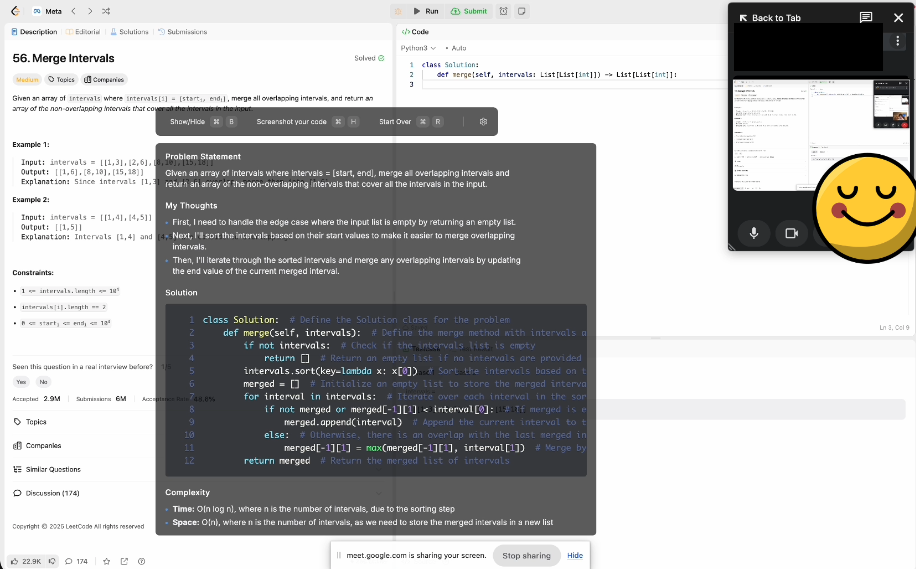

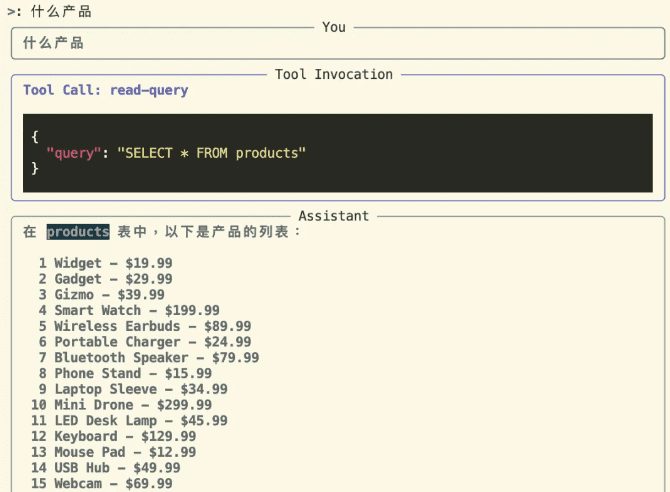

대화형 모드

대화형 모드로 들어가 서버와 상호 작용합니다:

uv run main.py --server sqlite

대화형 모드에서는 도구를 사용하여 서버와 상호 작용할 수 있습니다. 시작 시 지정된 공급자 및 모델은 다음과 같이 표시됩니다:

Entering chat mode using provider 'ollama' and model 'llama3.2'...

지원되는 명령

ping서버가 응답하는지 확인list-tools사용 가능한 도구 표시list-resources사용 가능한 리소스 표시list-prompts사용 가능한 팁 표시chat대화형 채팅 모드로 전환clear단말기 화면 지우기help: 지원되는 명령 목록을 표시합니다.quit/exit클라이언트 종료

OpenAI 공급자 사용

OpenAI 모델을 사용하려면 다음과 같이 설정해야 합니다. OPENAI_API_KEY 환경 변수에서 찾을 수 있습니다. .env 파일에 추가하거나 환경 변수로 설정합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...