일반 소개

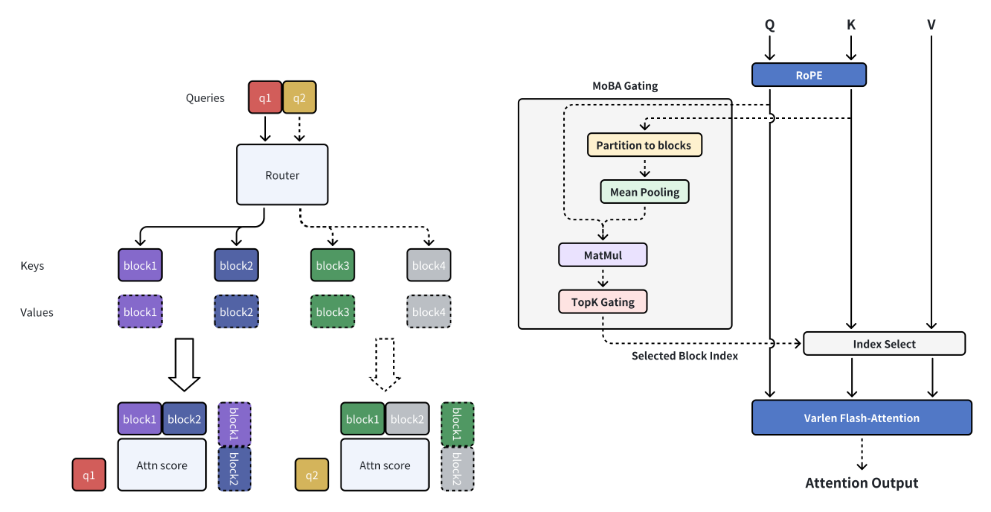

MoBA(혼합 블록 주의)는 MoonshotAI가 개발한 혁신적인 주의 메커니즘으로, 긴 컨텍스트 처리가 필요한 대규모 언어 모델(LLM)을 위해 설계되었으며, 전체 컨텍스트를 여러 블록으로 나누어 효율적인 긴 시퀀스 처리를 달성하고 각 쿼리 토큰은 가장 관련성이 높은 KV 블록에 집중하는 방법을 학습합니다. 고유한 매개변수 없는 탑-k 게이팅 메커니즘은 모델이 가장 유익한 청크에만 집중하도록 보장하여 계산 효율을 크게 향상시키며, MoBA는 전체 주의 모드와 희소 주의 모드 간에 원활하게 전환할 수 있어 성능과 효율성을 모두 보장합니다. 이 기술은 키미가 지원하는 긴 컨텍스트 요청에 성공적으로 적용되어 효율적인 주의 계산의 상당한 발전을 보여주었습니다.

기능 목록

- 드문 관심 차단전체 컨텍스트를 청크로 나누고 각 쿼리 토큰은 가장 관련성이 높은 KV 청크에 집중하는 방법을 학습합니다.

- 매개변수 없는 게이팅 메커니즘각 쿼리 토큰에 대해 가장 관련성이 높은 블록을 선택하는 매개변수 없는 탑-k 게이팅 메커니즘을 도입합니다.

- 완전한 희소 주의 전환집중 모드와 집중 모드 사이를 원활하게 전환할 수 있습니다.

- 효율적인 컴퓨팅긴 컨텍스트 작업의 계산 효율성을 크게 개선합니다.

- 오픈 소스사용 편의성 및 2차 개발을 위해 전체 오픈 소스 코드가 제공됩니다.

도움말 사용

설치 프로세스

- 가상 환경을 만듭니다:

conda create -n moba python=3.10

conda activate moba

- 종속성을 설치합니다:

pip install .

빠른 시작

트랜스포머와 호환되는 MoBA 구현을 제공합니다. 사용자는--attn이 매개변수는 모바와 모바_나이브 사이에서 관심 백엔드를 선택합니다.

python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba

세부 기능 작동 흐름

- 드문 관심 차단긴 컨텍스트를 처리할 때 MoBA는 전체 컨텍스트를 여러 청크로 나누고 각 쿼리 토큰은 가장 관련성이 높은 KV 청크에 집중하도록 학습하여 효율적인 긴 시퀀스 처리를 가능하게 합니다.

- 매개변수 없는 게이팅 메커니즘MoBA는 각 쿼리 토큰에 대해 가장 관련성이 높은 블록을 선택하는 매개변수 없는 탑-k 게이팅 메커니즘을 도입하여 모델이 가장 유익한 블록에만 집중할 수 있도록 합니다.

- 완전한 희소 주의 전환MoBA는 전체 집중에 대한 유연한 대안으로 설계되어 전체 집중 모드와 희소 집중 모드 간에 원활하게 전환할 수 있어 성능과 효율성을 모두 보장합니다.

- 효율적인 컴퓨팅위의 메커니즘을 통해 MoBA는 다양하고 복잡한 추론 작업을 위한 긴 컨텍스트 작업의 계산 효율성을 크게 향상시킵니다.

샘플 코드(컴퓨팅)

다음은 MoBA를 사용하는 샘플 코드입니다:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3.1-8B")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3.1-8B", attn="moba")

inputs = tokenizer("长上下文示例文本", return_tensors="pt")

outputs = model(**inputs)

print(outputs)

한 문장 설명(간략)

MoBA는 긴 컨텍스트 처리가 필요한 대규모 언어 모델을 위해 설계된 혁신적인 블록 주의 메커니즘으로, 계산 효율성을 크게 개선하고 완전한 희소 주의 전환을 지원합니다.

페이지 키워드

긴 컨텍스트 처리, 블록 주의 메커니즘, 대규모 언어 모델, 효율적인 컴퓨팅, MoonshotAI

일반 소개

MoBA(혼합 블록 주의)는 MoonshotAI가 개발한 혁신적인 주의 메커니즘으로, 긴 컨텍스트 처리가 필요한 대규모 언어 모델(LLM)을 위해 설계되었으며, 전체 컨텍스트를 여러 블록으로 나누어 효율적인 긴 시퀀스 처리를 달성하고 각 쿼리 토큰은 가장 관련성이 높은 KV 블록에 집중하는 방법을 학습합니다. 고유한 매개변수 없는 탑-k 게이팅 메커니즘은 모델이 가장 유익한 청크에만 집중하도록 보장하여 계산 효율을 크게 향상시키며, MoBA는 전체 주의 모드와 희소 주의 모드 간에 원활하게 전환할 수 있어 성능과 효율성을 모두 보장합니다. 이 기술은 키미가 지원하는 긴 컨텍스트 요청에 성공적으로 적용되어 효율적인 주의 계산의 상당한 발전을 보여주었습니다.

기능 목록

- 드문 관심 차단전체 컨텍스트를 청크로 나누고 각 쿼리 토큰은 가장 관련성이 높은 KV 청크에 집중하는 방법을 학습합니다.

- 매개변수 없는 게이팅 메커니즘각 쿼리 토큰에 대해 가장 관련성이 높은 블록을 선택하는 매개변수 없는 탑-k 게이팅 메커니즘을 도입합니다.

- 완전한 희소 주의 전환집중 모드와 집중 모드 사이를 원활하게 전환할 수 있습니다.

- 효율적인 컴퓨팅긴 컨텍스트 작업의 계산 효율성을 크게 개선합니다.

- 오픈 소스사용 편의성 및 2차 개발을 위해 전체 오픈 소스 코드가 제공됩니다.

도움말 사용

설치 프로세스

- 가상 환경을 만듭니다:

conda create -n moba python=3.10

conda activate moba

- 종속성을 설치합니다:

pip install .

빠른 시작

트랜스포머와 호환되는 MoBA 구현을 제공합니다. 사용자는--attn이 매개변수는 모바와 모바_나이브 사이에서 관심 백엔드를 선택합니다.

python3 examples/llama.py --model meta-llama/Llama-3.1-8B --attn moba

세부 기능 작동 흐름

- 드문 관심 차단긴 컨텍스트를 처리할 때 MoBA는 전체 컨텍스트를 여러 청크로 나누고 각 쿼리 토큰은 가장 관련성이 높은 KV 청크에 집중하도록 학습하여 효율적인 긴 시퀀스 처리를 가능하게 합니다.

- 매개변수 없는 게이팅 메커니즘MoBA는 각 쿼리 토큰에 대해 가장 관련성이 높은 블록을 선택하는 매개변수 없는 탑-k 게이팅 메커니즘을 도입하여 모델이 가장 유익한 블록에만 집중할 수 있도록 합니다.

- 완전한 희소 주의 전환MoBA는 전체 집중에 대한 유연한 대안으로 설계되어 전체 집중 모드와 희소 집중 모드 간에 원활하게 전환할 수 있어 성능과 효율성을 모두 보장합니다.

- 효율적인 컴퓨팅위의 메커니즘을 통해 MoBA는 다양하고 복잡한 추론 작업을 위한 긴 컨텍스트 작업의 계산 효율성을 크게 향상시킵니다.

샘플 코드(컴퓨팅)

다음은 MoBA를 사용하는 샘플 코드입니다:

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3.1-8B")

model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3.1-8B", attn="moba")

inputs = tokenizer("长上下文示例文本", return_tensors="pt")

outputs = model(**inputs)

print(outputs)© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...