MiniCPM-V 4.5란?

MiniCPM-V 4.5는 이미지와 비디오를 효율적으로 처리할 수 있는 기능을 갖춘 Facade Intelligence의 오픈 소스 8B 파라메트릭 멀티모달 모델로, Qwen3-8B 및 SigLIP2-400M을 기반으로 합니다. 비전에서 토큰 MiniCPM-V 4.5는 다국어 상호 작용을 지원하며 6배의 비디오 프레임 수를 처리할 수 있고 시각적 압축률이 96배로 유사 모델보다 24배 더 높습니다. 이 모델은 높은 브러시 비디오 이해력이 뛰어나 6 배의 비디오 프레임 수를 수신하고 유사한 모델보다 12 ~ 24 배 높은 96 배의 시각적 압축률을 달성합니다.MiniCPM-V 4.5는 다국어 상호 작용을 지원하며 30 개 이상의 언어를 처리 할 수있어 다국어 고객 서비스 및 번역 시나리오에 적합합니다. 문서 처리 기능도 매우 우수하여 복잡한 차트와 티켓을 처리할 수 있으며 필기 OCR 및 다국어 문서 구문 분석을 지원합니다. 이 모델은 장단기 사고로 제어된 하이브리드 추론을 지원하며, 추론의 속도와 깊이는 실제 필요에 따라 유연하게 조정할 수 있습니다.

MiniCPM-V 4.5의 특징

- 효율적인 시각적 처리비주얼 토큰 소비량은 대부분의 모델에 비해 75% 감소합니다. 1.8메가픽셀 이미지를 처리하는 데 640개의 비주얼 토큰만 필요하며, 동일한 비주얼 토큰 오버헤드로 6배의 비디오 프레임 수를 수신하고 96배의 비주얼 압축률을 달성할 수 있어 유사 모델에 비해 12-24배 높습니다.

- 다국어 상호 작용다국어 기능은 30개 이상의 언어를 지원하므로 다국어 고객 서비스, 다국어 번역 및 기타 시나리오에 적용할 수 있습니다.

- 강력한 문서 처리 기술LLaVA-UHD 아키텍처를 기반으로 모든 종횡비에서 최대 1.8메가픽셀의 고해상도 이미지를 처리할 수 있으며, 필기 OCR과 복잡한 양식/문서 파싱에서 매우 뛰어난 성능을 발휘합니다.

- 제어된 추론긴 사고와 짧은 사고로 제어된 혼합 추론을 지원하며, 실제 필요에 따라 추론의 속도와 깊이를 유연하게 조정할 수 있습니다.

- 배포 유연성디바이스 메모리에 따라 선택할 수 있는 int4, GGUF, AWQ 등 다양한 양자화 모델 포맷을 제공하며, llama.cpp, ollama, vLLM, SGLang 등 다양한 배포 방식을 지원합니다.

MiniCPM-V 4.5의 핵심 이점

- 높은 브러시 비디오의 뛰어난 이해도업계 최초의 "하이 브러시" 비디오 이해 능력을 갖춘 멀티모달 모델로, 동일한 비주얼 토큰 오버헤드에서 6배의 비디오 프레임 수를 수신하고 96배의 시각적 압축률을 달성할 수 있으며, 이는 유사 모델보다 12~24배 높은 수치로, 하이 브러시 비디오 이해 능력의 두 가지 목록인 MotionBench와 FavorBench에서 동일한 크기의 SOTA를 달성하고 동일한 크기의 SOTA를 초과합니다. 높은 브러시 비디오 이해 능력의 두 가지 목록인 MotionBench와 FavorBench에서는 동일한 크기의 SOTA에 도달하고 동일한 크기의 SOTA를 초과합니다. Qwen2.5-VL 72B.

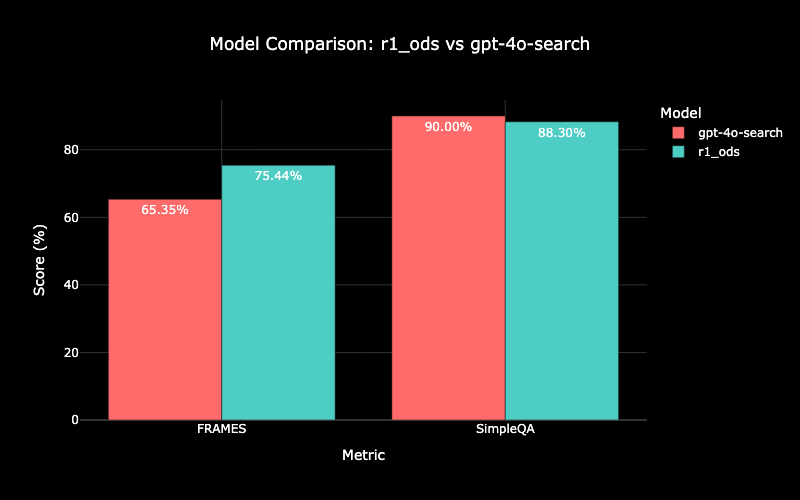

- 뛰어난 이미지 이해 성능OpenCompass와 같은 벤치마크에서 GPT-4o 최신 모델보다 우수한 성능을 발휘하고, 고해상도 이미지를 효율적으로 처리하며, 모든 종횡비의 최대 1.8메가픽셀 이미지를 지원하고, 필기 OCR, 복잡한 양식/문서 파싱에 탁월하며, 30개 이상의 언어를 지원한다는 특징이 있습니다.

- 광범위한 다국어 지원다국어 기능은 30개 이상의 언어를 지원하므로 다국어 고객 서비스, 다국어 번역 및 기타 시나리오에 적용하여 다양한 언어 환경의 상호 작용 요구 사항을 충족할 수 있습니다.

- 제어된 추론 유연성효율성과 정확성을 고려하여 추론의 속도와 깊이를 유연하게 조정해야 하는 실제 요구에 따라 긴 사고, 짧은 사고 제어 혼합 추론을 지원합니다.

- 다양한 배포 방식디바이스 메모리에 따라 선택할 수 있는 int4, GGUF, AWQ 등 다양한 양자화 모델 포맷을 제공하며, llama.cpp, ollama, vLLM, SGLang 등 다양한 배포 방식을 지원해 다양한 디바이스 및 시나리오에서 편리하게 사용할 수 있습니다.

MiniCPM-V 4.5의 공식 웹사이트는 무엇인가요?

- GitHub 리포지토리:: https://github.com/OpenBMB/MiniCPM-V

- 허깅페이스 모델 라이브러리:: https://huggingface.co/openbmb/MiniCPM-V-4_5

- 온라인 경험 데모:: http://101.126.42.235:30910/

MiniCPM-V 4.5는 누가 사용할 수 있나요?

- 개발자이 모델은 오픈 소스이며 다양한 배포 방법을 제공하며, 개발자는 보조 개발, 지능형 고객 서비스, 문서 처리 도구와 같은 복합 애플리케이션의 신속한 구축을 기반으로 할 수 있습니다.

- 연구 작업자오픈 소스 모델로서 연구자들이 연구, 분석 및 개선하고, 멀티모달 기술 개발을 촉진하며, 새로운 애플리케이션 시나리오와 알고리즘 최적화를 탐색할 수 있습니다.

- 비즈니스 사용자기업은 감시 영상 분석, 제품 데모, 고객 서비스 등의 비즈니스 시나리오에 효율적인 이미지 및 비디오 처리 기능을 활용하여 업무 효율성과 사용자 경험을 향상시킬 수 있습니다.

- 모바일 장치 사용자이 모델은 아이폰16프로 맥스와 같은 모바일 디바이스에 빠르게 배포할 수 있으며, 모바일 디바이스에서 실시간 이미지 인식 및 문서 처리와 같은 모바일 애플리케이션을 필요로 하는 사용자에게 적합합니다.

- 다국어 사용자30개 이상의 언어를 지원하므로 다국적 기업, 국제기구 등과 같은 다국어 환경의 사용자에게 적합하며 다양한 언어를 사용하는 사용자의 상호 작용 요구 사항을 충족할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...