Ming-flash-omni 2.0是什么

Ming-flash-omni 2.0是蚂蚁集团开源的全模态大模型(수학.) 속集成了视觉、语音和生成能力的AI模型,在多项基准测试中性能领先。支持同时生成语音、环境音效和音乐,能通过自然语言指令精细控制音色、语调等参数,推理效率达3.1Hz,可实时生成高保真长音频。在视觉方面,模型提升了复杂对象识别能力,图像编辑功能支持光影调整、场景替换等操作。其基于Ling-2.0架构训练,开发者可通过统一框架调用多模态能力,降低应用开发成本。

Ming-flash-omni 2.0的功能特色

- 全场景音频统一生成:可在同一条音轨中同时生成语音、环境音效与音乐,支持自然语言精细控制音色、语速、情绪、方言等参数,推理帧率低至3.1Hz。

- 增强视觉语言理解:引入亿级细粒度数据与难例挖掘策略,提升对复杂对象识别能力,并增强视频时序建模。

- 原生图像生成编辑:首创将生成、编辑、分割融入单一模型,支持光影调整、场景替换、一键修图等,保持画面连贯真实。

- 全模态端到端架构:基于MoE架构统一处理文本、图像、视频、音频,以可复用底座形式开源,降低多模型串联成本。

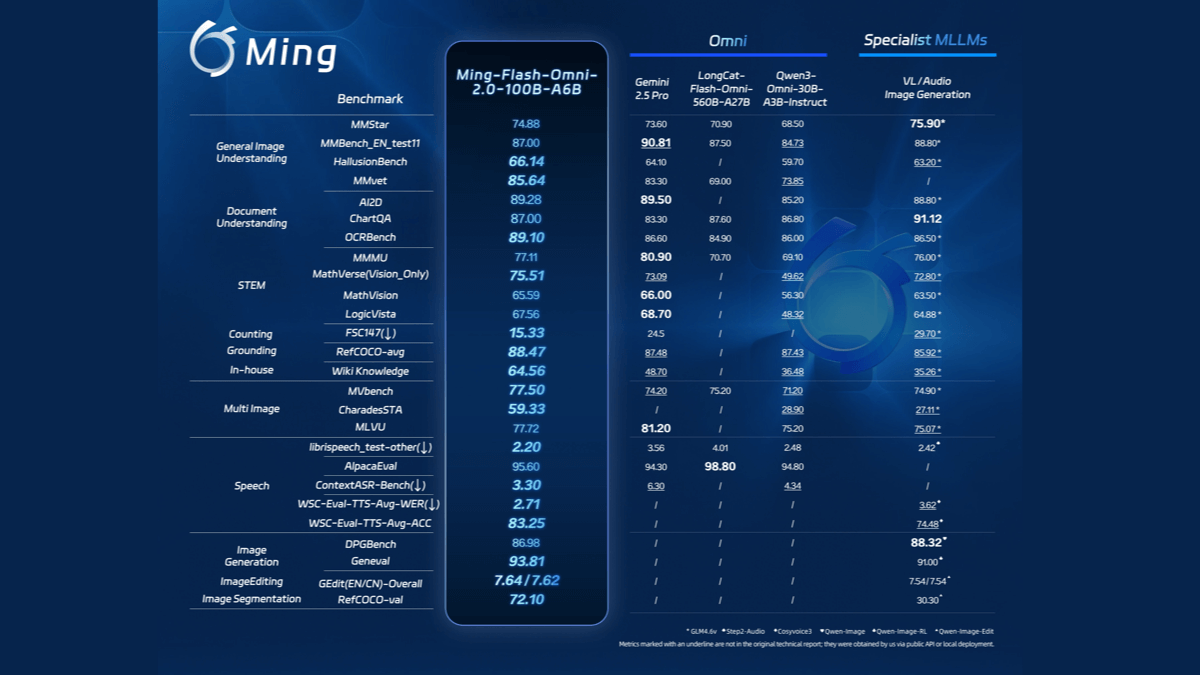

- 性能行业领先:多项基准测试指标超越Gemini 2.5 Pro,成为开源全模态大模型新标杆。

Ming-flash-omni 2.0的核心优势

- 音频生成突破:业界首个在同一条音轨中同时生成语音、环境音效与音乐的模型,支持零样本音色克隆与方言控制,推理帧率低至3.1Hz。

- 视觉理解精准:引入亿级细粒度数据与难例挖掘,显著提升对近缘动植物、工艺细节、稀有文物等复杂对象的识别能力。

- 图像能力统一:首创将生成、编辑、分割融入单一原生模型,支持光影调整、场景替换、一键修图,动态场景保持画面连贯。

- 全模态架构:基于MoE架构端到端统一处理文本、图像、视频、音频,以可复用底座开源,降低开发成本。

- 性能对标顶尖:多项关键指标超越Gemini 2.5 Pro,树立开源全模态大模型性能新标杆。

Ming-flash-omni 2.0官网是什么

- 허깅페이스 모델 라이브러리:https://huggingface.co/inclusionAI/Ming-flash-omni-2.0

Ming-flash-omni 2.0的适用人群

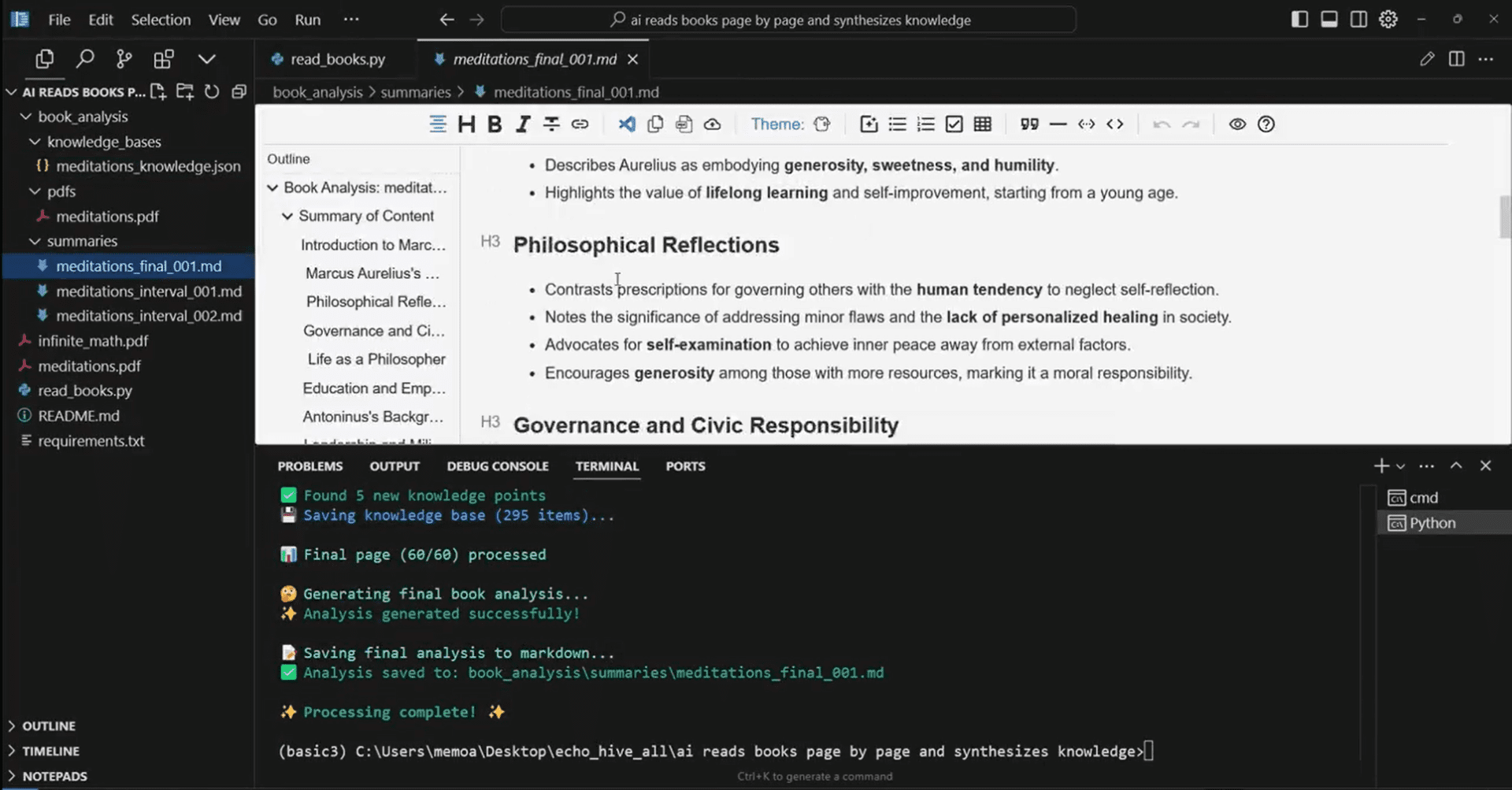

- AI 개발자:可基于开源底座快速构建端到端多模态应用,降低模型串联复杂度与开发成本。

- 콘텐츠 크리에이터:利用统一音频生成与图像编辑能力,高效产出配音、音效、音乐及视觉素材。

- 사운드 및 비디오 실무자:借助低帧率实时生成特性,实现分钟级长音频高保真制作与方言音色定制。

- 视觉识别研究人员:利用细粒度视觉理解能力,开展动植物分类、文物鉴定、工艺分析等专业领域研究。

- 기업 기술팀:以可复用架构集成多模态能力,快速落地智能客服、内容审核、创意营销等业务场景。

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...