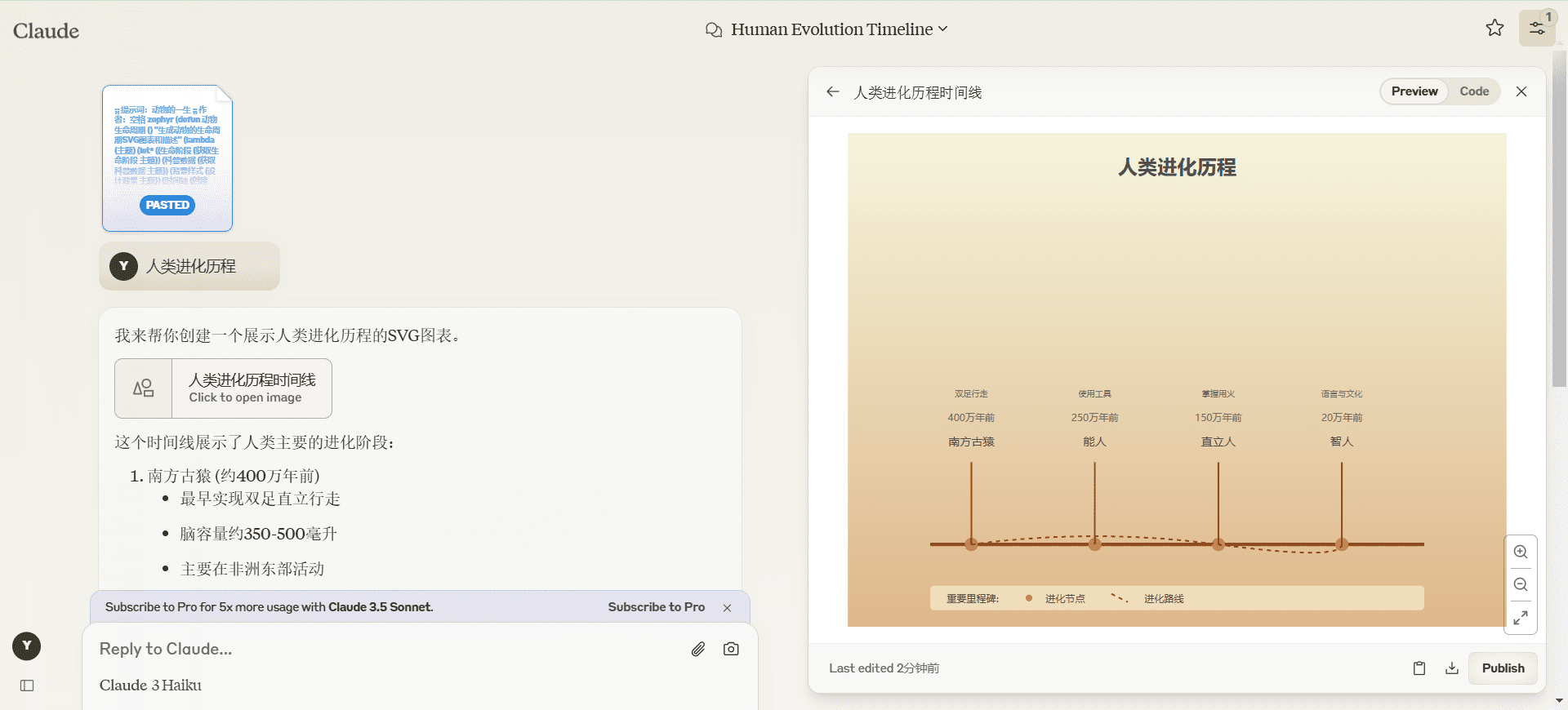

AI 제품 팀과 AI 리더를 위해 설계되었으며, LLM 기반 제품을 평가하는 방법을 소개합니다. 프로그래밍 지식이 없어도 쉽게 학습할 수 있습니다. 이 과정은 다음에서 제공됩니다. 2024년 12월 9일 시작.

학습 내용

LLM 평가의 기본: 평가 방법과 벤치마크부터 LLM에 대한 보호 장치, 맞춤형 LLM 평가 도구를 만드는 방법까지. 이 과정은 AI 품질과 통합 가시성의 핵심 개념을 마스터하고자 하는 AI 제품 관리자 및 AI 리더를 위해 설계되었습니다.

실험 단계부터 생산 모니터링 단계까지 LLM 애플리케이션 수명 주기의 다양한 단계에 대한 평가.

합성 데이터를 사용하여 평가 데이터 세트를 설계하고 다양한 테스트 사례를 생성하는 방법.

LLM 애플리케이션에서 발생할 수 있는 문제: 환각, 즉각적인 주입, 통제 불능 크래킹 등

프로덕션 환경에서 LLM 통합 가시성을 구축하는 방법: 추적성, 평가, 보호 장치.

LLM 평가 방법: LLM 평가 도구, 정규식, 예측 지표.

실제 사례: RAG(검색 증강 생성 시스템), QA 시스템 및 지능형 에이전트를 평가하는 방법.

출시를 기다리는 중...

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...