Marco-o1: 복잡한 문제 해결을 위한 개방형 추론 모델을 탐색하기 위해 미세 조정을 지시하는 Qwen2-7B 기반 OpenAI o1 모델의 오픈 소스 버전입니다.

일반 소개

Marco-o1은 복잡한 현실 세계의 문제를 해결하기 위해 알리바바 국제 디지털 커머스 그룹(AIDC-AI)에서 개발한 개방형 추론 모델입니다. 이 모델은 복잡한 문제 해결 작업을 최적화하기 위해 생각의 사슬(CoT) 미세 조정, 몬테카를로 트리 검색(MCTS) 및 혁신적인 추론 전략을 결합하며, 수학, 물리학, 프로그래밍과 같이 표준적인 답이 있는 분야에 집중할 뿐만 아니라 명확한 기준이 없고 보상을 정량화하기 어려운 영역으로 일반화하기 위해 노력합니다. 이 프로젝트의 목표는 다국어 애플리케이션을 위한 대규모 추론 모델의 잠재력을 탐구하고, 지속적인 최적화와 개선을 통해 모델의 추론 능력과 적용 범위를 향상시키는 것입니다.

기능 목록

- 생각의 사슬 미세 조정(CoT)전체 파라미터로 기본 모델을 미세 조정하고 오픈 소스 CoT 데이터 세트와 자체 연구 합성 데이터를 결합하여 모델의 추론 기능을 향상합니다.

- 몬테카를로 트리 검색(MCTS)모델 결과의 신뢰도를 사용하여 검색을 안내하고, 솔루션 공간을 확장하고 추론 경로를 최적화합니다.

- 추론 실행 전략혁신적인 추론 작업 전략과 반성적 메커니즘을 구현하여 다양한 수준의 세분화된 작업을 탐색하고 모델의 복잡한 문제 해결 능력을 향상시킵니다.

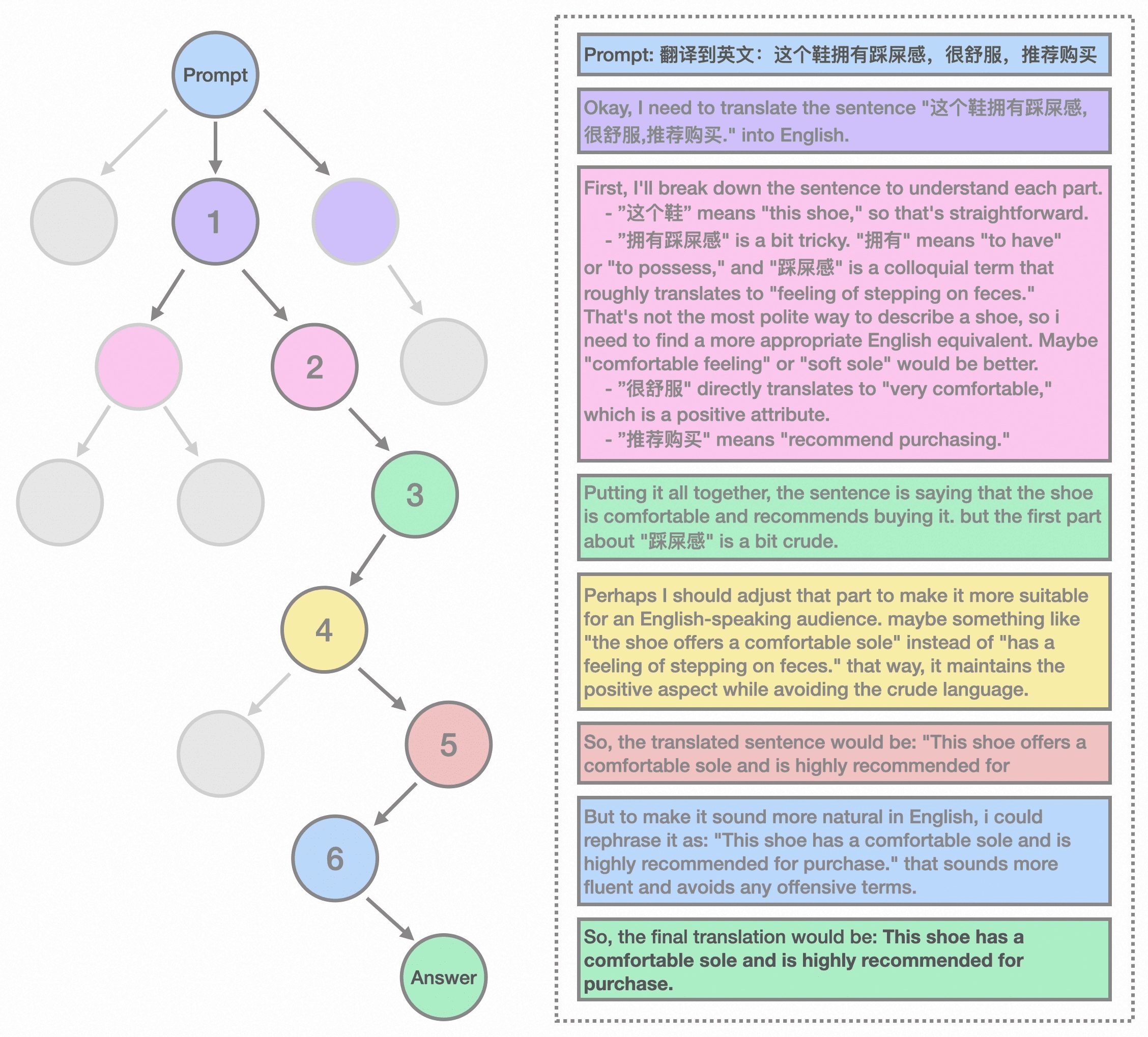

- 다국어 번역 과제대규모 추론 모델을 기계 번역 작업에 처음으로 적용하여 다국어 및 번역 영역에서 추론 시간 확장 법칙을 탐구합니다.

- 보상 모델 교육보다 정확한 보상 신호를 제공하고 트리 검색 결과의 무작위성을 줄이기 위해 결과 보상 모델링(ORM)과 프로세스 보상 모델링(PRM)을 개발합니다.

- 집중 학습 교육강화 학습 기법을 통해 모델의 의사 결정 과정을 최적화하여 문제 해결 능력을 더욱 향상시킵니다.

도움말 사용

설치 프로세스

- GitHub 페이지 방문바로가기Marco-o1 GitHub 페이지.

- 클론 창고명령을 사용합니다.

git clone https://github.com/AIDC-AI/Marco-o1.git리포지토리를 로컬에 복제합니다. - 종속성 설치프로젝트 디렉토리로 이동하여

pip install -r requirements.txt필요한 종속성을 설치합니다.

사용 가이드라인

- 모델 로드파이썬 환경에서는 다음 코드를 사용하여 모델을 로드합니다:

from transformers import AutoModelForCausalLM, AutoTokenizer model_name = "AIDC-AI/Marco-o1" model = AutoModelForCausalLM.from_pretrained(model_name) tokenizer = AutoTokenizer.from_pretrained(model_name) - 추론의 예모델을 사용한 추론, 다음은 간단한 예입니다:

python

input_text = "How many 'r' are in strawberry?"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0], skip_special_tokens=True)) - 다국어 번역Marco-o1은 다국어 번역 작업을 잘 수행하며, 다음은 번역의 예입니다:

python

input_text = "这个鞋拥有踩屎感"

inputs = tokenizer(input_text, return_tensors="pt")

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))

세부 기능 작동 흐름

- 생각의 사슬 미세 조정(CoT)::

- 데이터 준비오픈 소스 CoT 데이터 세트와 자체 연구 합성 데이터를 수집하고 대조합니다.

- 모델링 미세 조정위의 데이터를 사용하여 전체 매개 변수로 기본 모델을 미세 조정하여 추론을 개선합니다.

- 몬테카를로 트리 검색(MCTS)::

- 노드 표현MCTS 프레임워크에서 각 노드는 문제 해결 과정의 추론 상태를 나타냅니다.

- 모션 출력노드의 가능한 작업은 LLM에 의해 생성되며 추론 체인의 잠재적 단계를 나타냅니다.

- 롤백 및 보너스 계산롤백 단계 동안 LLM은 종료 상태까지 추론 프로세스를 계속 진행합니다.

- 부트스트랩 검색보상 점수를 사용하여 유망한 경로를 평가하고 선택하여 보다 신뢰할 수 있는 추론 체인으로 검색을 유도합니다.

- 추론 실행 전략::

- 액션 세분성검색 효율성과 정확성을 높이기 위해 MCTS 프레임워크 내에서 다양한 세부 단위로 작업을 탐색합니다.

- 반사 메커니즘모델에게 자기 성찰을 유도하면 복잡한 문제를 해결하는 능력이 크게 향상됩니다.

- 다국어 번역 과제::

- 미션 애플리케이션대규모 추론 모델을 기계 번역 작업에 적용하여 다국어 및 번역 영역에서 추론 시간 확장 법칙을 탐색합니다.

- 번역 예시속어 표현을 번역할 때 모델의 우수한 성능을 보여줍니다.

- 보상 모델 교육::

- 성과 보상 모델링(ORM)더 정확한 보상 신호를 제공하고 트리 검색 결과의 무작위성을 줄이도록 모델을 훈련합니다.

- 프로세스 보상 모델링(PRM)프로세스 보상 모델링을 통해 모델의 추론 경로를 더욱 최적화합니다.

- 집중 학습 교육::

- 의사 결정 최적화강화 학습 기법을 통해 모델의 의사 결정 과정을 최적화하고 문제 해결 능력을 향상시킵니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...