일반 소개

로컬 딥 리서치는 사용자가 심층 연구를 수행하고 복잡한 문제에 대한 상세한 보고서를 생성할 수 있도록 설계된 오픈 소스 AI 연구 도우미입니다. 로컬 작업을 지원하므로 사용자가 클라우드 서비스에 의존하지 않고도 연구 작업을 완료할 수 있습니다. 이 도구는 로컬 대규모 언어 모델링(LLM)과 학술 데이터베이스, Wikipedia, 웹 콘텐츠 등과 같은 소스를 포괄하는 다양한 검색 기능을 결합합니다. 사용자는 간단한 설치와 구성을 통해 인용이 포함된 종합적인 보고서를 신속하게 생성할 수 있습니다. 이 프로젝트는 개인 정보 보호와 유연성을 강조하며 학술 연구, 기술 탐구 또는 개인 지식 관리에 적합합니다.

기능 목록

- 데이터 프라이버시를 보호하기 위해 로컬 빅 언어 모델을 지원합니다.

- Wikipedia, arXiv, PubMed 등과 같은 적절한 검색 도구를 자동으로 선택합니다.

- 구조화된 섹션과 인용이 포함된 상세한 보고서를 생성하세요.

- 몇 초 만에 간략한 답변을 생성하는 빠른 요약 기능을 제공합니다.

- 포괄적인 분석을 위해 웹 검색과 결합된 로컬 문서 검색을 지원합니다.

- 유연한 운영을 위한 웹 인터페이스와 명령줄 인터페이스를 제공합니다.

- 전 세계 사용자를 위한 다국어 검색을 지원합니다.

도움말 사용

설치 프로세스

로컬 딥 리서치를 사용하려면 Python 환경 및 관련 종속성을 설치해야 합니다. 자세한 설치 단계는 다음과 같습니다:

- 클론 창고

터미널에서 다음 명령을 실행하여 프로젝트를 로컬로 복제합니다:git clone https://github.com/LearningCircuit/local-deep-research.git cd local-deep-research

- 종속성 설치

Python의 패키지 관리 도구를 사용하여 필요한 라이브러리를 설치하세요:pip install -e .브라우저 자동화 기능이 필요한 경우 Playwright를 설치하세요:

playwright install - 로컬 모델 설치(Ollama)

로컬 딥 리서치는 다음과 같은 채택을 지원합니다. Ollama 로컬 대규모 언어 모델을 실행합니다. https://ollama.ai 를 방문하여 Ollama를 다운로드하여 설치한 다음 추천 모델을 가져옵니다:ollama pull gemma3:12b올라마 서비스가 백그라운드에서 실행되고 있는지 확인합니다.

- SearXNG 구성(선택 사항)

최상의 검색 결과를 얻으려면 SearXNG 검색 서비스를 자체 호스팅하는 것이 좋습니다. 다음 명령을 실행하여 SearXNG를 시작합니다:docker pull searxng/searxng docker run -d -p 8080:8080 --name searxng searxng/searxng프로젝트 루트 디렉터리에서

.env파일을 사용하여 SearXNG 주소를 구성합니다:SEARXNG_INSTANCE=http://localhost:8080 SEARXNG_DELAY=2.0 - 스타터 키트

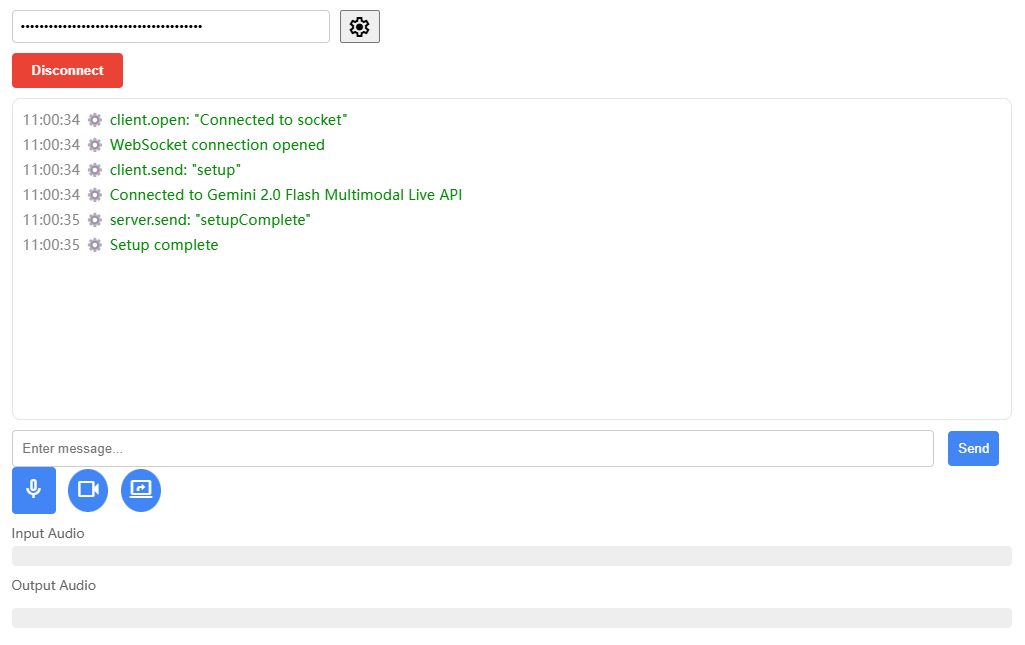

- 웹 인터페이스다음 명령을 실행하여 웹 버전을 시작하려면 http://127.0.0.1:5000 을 방문하세요:

ldr-web - 명령줄 인터페이스: 다음 명령을 실행하여 명령줄 버전을 시작합니다:

ldr

- 웹 인터페이스다음 명령을 실행하여 웹 버전을 시작하려면 http://127.0.0.1:5000 을 방문하세요:

주요 기능의 작동

1. 빠른 요약 생성

빠른 요약 기능은 빠른 답변이 필요한 사용자를 위한 기능입니다. 웹 인터페이스를 열고 "최근 핵융합 에너지의 발전"과 같은 연구 질문을 입력합니다. '빠른 요약' 버튼을 클릭하면 몇 초 안에 주요 정보와 출처가 포함된 간략한 답변이 표시됩니다. 명령줄을 사용하는 경우 실행합니다:

from local_deep_research import quick_summary

results = quick_summary(query="核聚变能源的最新进展", search_tool="auto", iterations=1, questions_per_iteration=2, max_results=30)

print(results["summary"])

결과는 짧은 요약과 참조 링크가 포함된 텍스트로 출력됩니다.

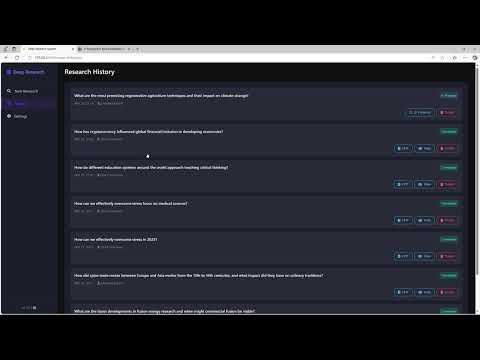

2. 상세 보고서 생성

상세 보고서 기능은 종합적인 분석이 필요한 사용자에게 적합합니다. 웹 인터페이스에 질문을 입력한 후 '보고서 생성' 옵션을 선택합니다. 이 도구는 여러 차례의 검색 및 분석을 수행하고 목차, 장 및 인용이 포함된 마크다운 형식의 보고서를 생성합니다. 보고서 생성 시간은 문제의 복잡성과 검색 라운드 수(기본값은 2회)에 따라 달라집니다. 명령줄 작업 예시:

from local_deep_research import generate_report

report = generate_report(query="核聚变能源的最新进展", search_tool="auto", iterations=2)

print(report)

생성된 보고서는 로컬에 저장되며, 일반적으로 프로젝트 루트 디렉토리의 다음 경로에 저장됩니다. examples 폴더.

3. 로컬 문서 검색

사용자는 검색 증강 생성(RAG) 기능으로 분석할 비공개 문서(예: PDF, TXT)를 지정된 폴더에 업로드할 수 있습니다. 문서 경로를 구성합니다:

DOC_PATH=/path/to/your/documents

웹 인터페이스에서 보고서 소스로 '로컬 문서'를 선택하면 도구가 로컬 문서와 웹 검색을 결합한 보고서를 생성합니다. 명령줄 작업:

results = quick_summary(query="分析我的文档中的AI趋势", report_source="local")

4. 다국어 검색

이 도구는 영어가 아닌 질문에 대한 다국어 검색을 지원합니다. 웹 인터페이스에 중국어 또는 다른 언어로 질문을 입력하면 검색 도구가 자동으로 관련 검색 결과를 표시하도록 조정됩니다. 예를 들어 "양자 컴퓨팅의 최신 혁신"을 입력하면 중국어와 영어 소스를 모두 검색합니다.

구성 매개변수

사용자는 다음을 수정할 수 있습니다. config.py 어쩌면 .env 이 파일은 매개변수를 조정합니다:

search_tool검색 도구 선택(기본값)auto).iterations: 스터디 라운드 수를 설정합니다(기본값은 2개).max_results검색 라운드당 최대 결과 수(기본값 50개).max_filtered_results필터링된 결과 수(기본값 5개).

주의

- 외부 리소스 검색을 위한 안정적인 인터넷 연결을 보장합니다.

- 로컬 모델 성능은 하드웨어에 따라 다르며 GPU 가속을 권장합니다.

- 최신 기능을 위해 Ollama와 프로젝트 코드를 정기적으로 업데이트하세요.

애플리케이션 시나리오

- 학술 연구

학생과 연구자는 로컬 심층 연구를 사용해 학술 논문과 웹 페이지에서 정보를 빠르게 수집하여 인용된 보고서를 생성할 수 있습니다. 예를 들어, '양자 컴퓨팅의 혁신'을 연구할 때 이 도구는 arXiv 및 PubMed에서 최신 논문을 검색하여 구조화된 보고서를 생성합니다. - 기술 탐색

기술 애호가들은 "공급망에서의 블록체인"과 같은 새로운 기술 트렌드를 살펴볼 수 있습니다. 이 도구는 로컬 문서와 웹 검색을 결합하여 종합적인 분석을 제공합니다. - 개인 지식 관리

사용자는 비공개 메모나 문서를 업로드하여 외부 정보로 지식창고를 정리할 수 있습니다. 예를 들어 '2025년 인공지능 개발 예측'에 대한 개인 보고서가 있습니다.

QA

- 로컬 딥 리서치에 네트워킹이 필요한가요?

로컬 모델은 인터넷 연결 없이 실행되지만 검색 기능(예: Wikipedia, arXiv)을 사용하려면 인터넷 연결이 필요합니다. 사용자는 로컬 문서만 사용하도록 선택할 수 있습니다. - 어떤 대형 언어 모델이 지원되나요?

기본적으로 다음과 같은 Ollama 호스팅 모델이 지원됩니다.gemma3:12b. 사용자는 다음을 통해 이 정보에 액세스할 수 있습니다.config.py다음과 같은 다른 모델을 구성합니다. vLLM 또는 LMStudio. - 보고 품질을 어떻게 개선할 수 있나요?

검색 라운드 늘리기(iterations) 및 결과 수(max_results) 또는 더 강력한 모델을 사용하세요. 문제를 명확하게 설명하는 것도 정확도를 높이는 데 도움이 될 수 있습니다. - Windows 시스템이 지원되나요?

예, 이 프로젝트는 구성 프로세스를 간소화하기 위해 Windows 원클릭 인스톨러를 제공합니다. 다운로드하려면 GitHub 리포지토리를 방문하세요.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...