llamafile: 단일 파일을 사용하여 LLM 배포 및 실행, LLM 배포 간소화, LLM에 대한 크로스 플랫폼 지원

일반 소개

llamafile은 대규모 언어 모델(LLM)의 배포 및 운영을 간소화하도록 설계된 Mozilla Builders 프로젝트의 도구입니다. 이 도구는 llama.cpp llamafile은 코스모폴리탄 Libc와 함께 복잡한 LLM 배포 프로세스를 단일 실행 파일로 단순화하여 설치 없이도 다양한 운영 체제에서 로컬로 실행할 수 있도록 지원합니다. 이 도구는 텍스트 대화창을 지원할 뿐만 아니라 이미지 입력도 처리하여 데이터 프라이버시를 보장합니다.

기능 목록

- 단일 파일 작업LLM 모델과 런타임 환경을 단일 실행 파일로 패키지화합니다.

- 플랫폼 간 호환성윈도우, 맥OS, 리눅스, 프리BSD, 오픈BSD, 넷BSD가 지원됩니다.

- 로컬 운영인터넷 연결이 필요하지 않으며 모든 데이터 처리는 개인 정보 보호 및 보안을 위해 로컬에서 이루어집니다.

- 멀티모달 지원텍스트 및 이미지 입력을 지원하여 풍부한 대화형 기능을 제공합니다.

- OpenAI API 호환기존 애플리케이션과 쉽게 통합할 수 있도록 OpenAI API와 호환되는 인터페이스를 제공합니다.

- 고성능최적화된 행렬 곱셈 커널로 CPU와 GPU에서 더 빠르게 작동합니다.

- 오픈 소스 프로젝트오픈 소스 코드, 활발한 커뮤니티 기여, 지속적인 업데이트 및 최적화.

도움말 사용

설치 및 운영

- 라마파일 다운로드액세스 깃허브 페이지 최신 버전의 llamafile을 다운로드하세요.

- 집행 권한 위임(macOS, Linux, BSD 사용자의 경우):

chmod +x path/to/llamafile - 라마파일 실행::

- macOS, Linux, BSD 사용자의 경우:

./path/to/llamafile - Windows 사용자의 경우: 파일 이름을 다음과 같이 변경합니다.

.exe접미사를 추가하고 실행합니다:.\path\to\llamafile.exe

- macOS, Linux, BSD 사용자의 경우:

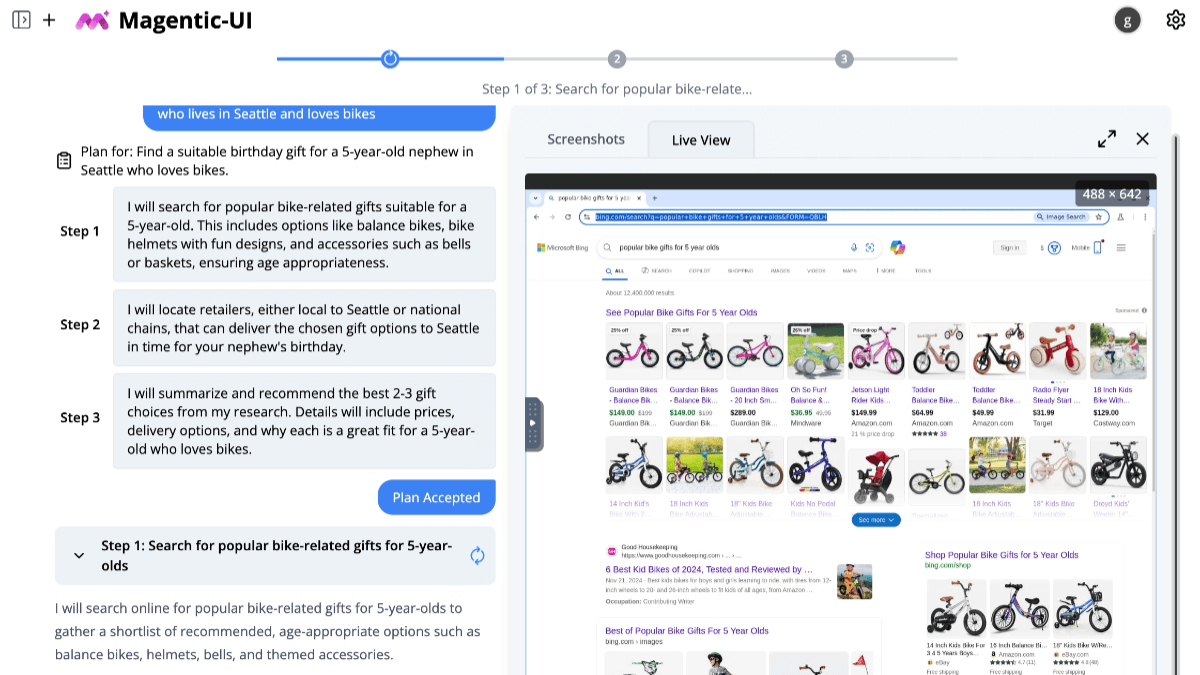

기능 작동

- 웹 인터페이스 시작하기라마파일을 실행하면 브라우저에서 자동으로 채팅 화면이 열립니다(열리지 않는 경우 수동으로 방문하세요).

http://127.0.0.1:8080/). - OpenAI API 인터페이스 사용llamafile은 OpenAI API와 호환되는 인터페이스를 제공하며 일반적인 API 사용 사례를 지원합니다. 다음 명령어로 호출할 수 있습니다:

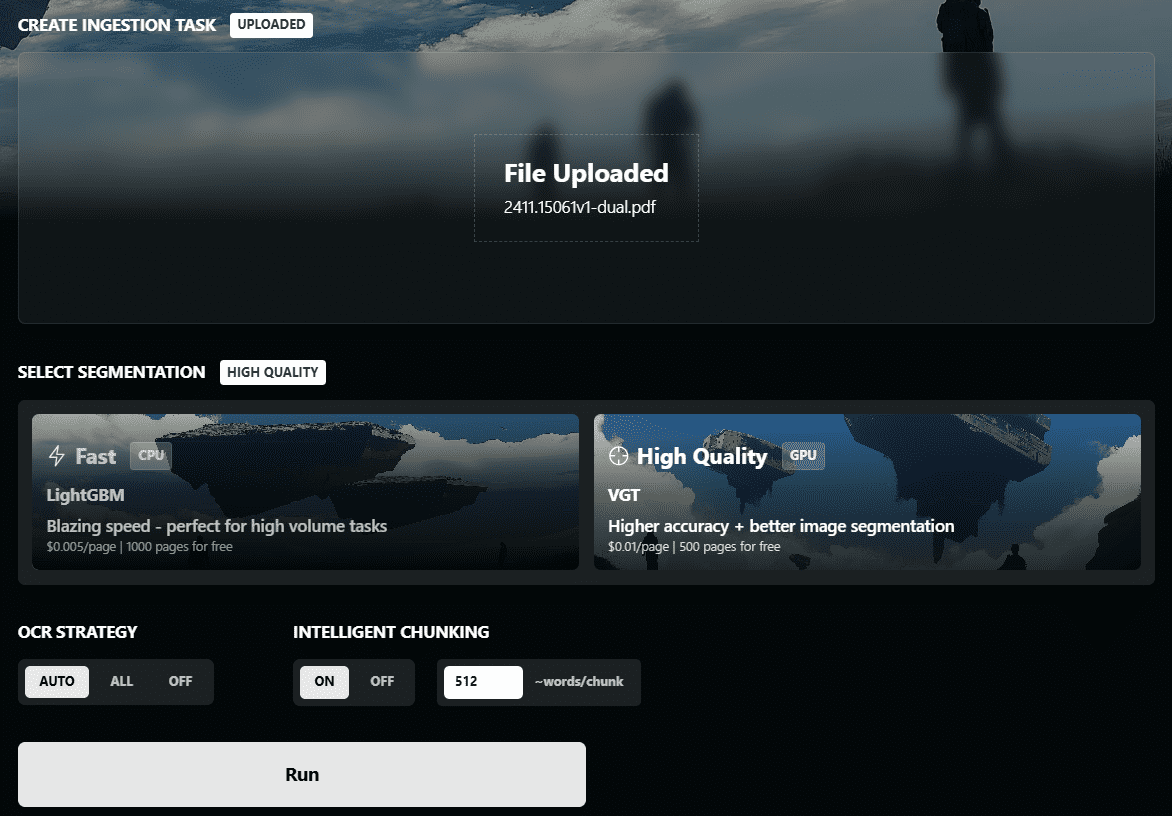

curl http://localhost:8080/v1/chat/completions -H "Content-Type: application/json" -d '{ "model": "LLaMA_CPP", "messages": [{"role": "user", "content": "Hello, world!"}] }' - 이미지 입력예를 들어 이미지를 업로드하고 이에 대해 질문할 수 있습니다:

curl -X POST http://localhost:8080/v1/images -F "image=@path/to/image.jpg" -F "prompt=Describe this image" - 명령줄 모드: llamafile은 스크립트 작업을 위한 명령줄 모드도 지원합니다:

./path/to/llamafile --cli -p "Your prompt here"

일반적인 문제

- 역량 문제권한 문제가 발생하면 파일에 실행 권한이 있는지 확인하세요(

chmod +x명령). - 파일 크기 제한Windows 사용자는 단일 실행 파일의 크기가 4GB를 초과할 수 없으며, 이 문제를 해결하기 위해 외부 웨이트 파일을 사용할 수 있다는 점에 유의해야 합니다.

- 종속성 문제macOS 사용자는 Xcode를 설치해야 합니다. 명령 Line Tools, Linux 사용자는 GPU 가속을 지원하기 위해 CUDA SDK 또는 ROCm SDK를 설치해야 할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...