일반 소개

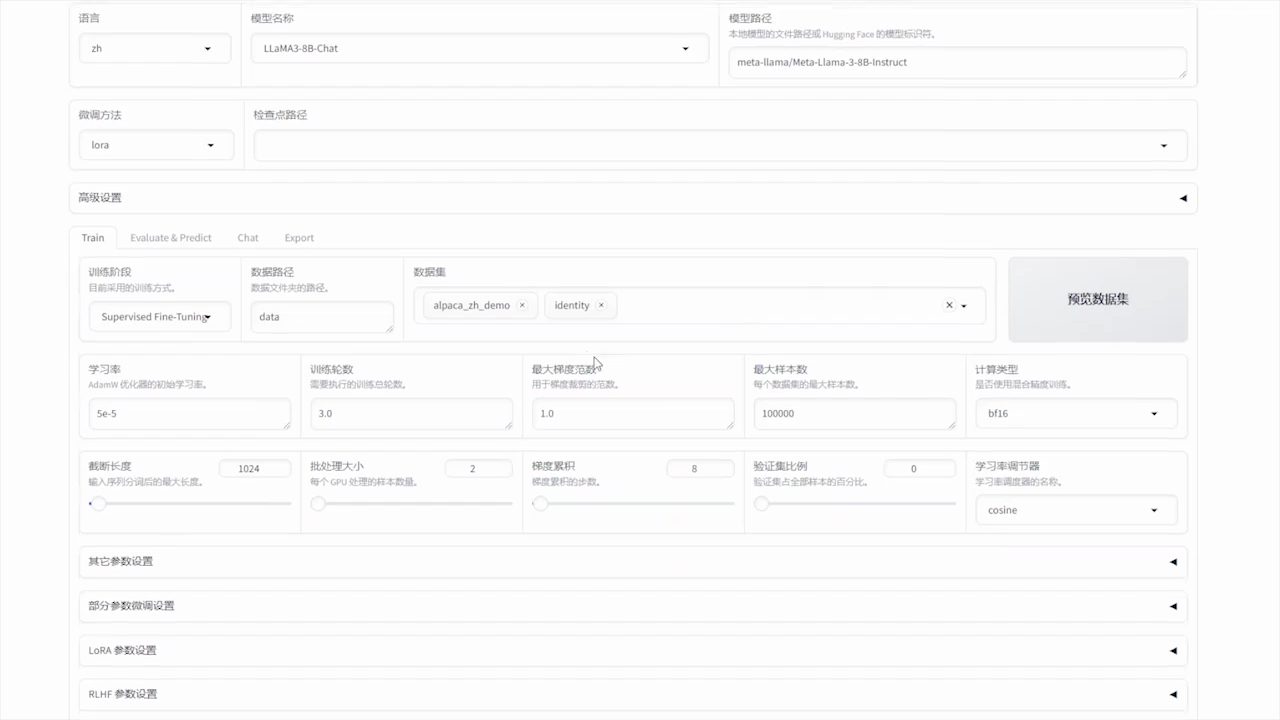

LLaMA-Factory는 100개가 넘는 대규모 언어 모델(LLM)의 유연한 사용자 지정과 효율적인 학습을 지원하는 통합적이고 효율적인 미세 조정 프레임워크입니다. 내장된 LLaMA Board 웹 인터페이스를 통해 사용자는 코드를 작성하지 않고도 모델을 미세 조정할 수 있습니다. 이 프레임워크는 다양한 고급 훈련 방법과 실용적인 팁을 통합하여 훈련 속도와 GPU 메모리 활용도를 크게 향상시킵니다.

기능 목록

- 다중 모델 지원LLaMA, LLaVA, Mistral, Qwen 및 기타 다국어 모델 지원.

- 다양한 교육 방법전체 볼륨 다듬기, 정지 다듬기, LoRA, QLoRA 등을 포함합니다.

- 효율적인 알고리즘GaLore, BAdam, Adam-mini, DoRA 및 기타 고급 알고리즘의 통합.

- 실용적인 기술플래시어텐션-2, 언슬러스, 라이거 커널 등을 지원합니다.

- 실험적 모니터링라마보드, 텐서보드, 완드비, MLflow 등의 모니터링 도구를 제공합니다.

- 빠른 추론OpenAI와 유사한 API, Gradio UI 및 CLI 인터페이스를 제공합니다.

- 데이터 세트 지원사전 학습된 모델 및 데이터 세트 다운로드 지원: HuggingFace, ModelScope 및 기타 플랫폼에서 사전 학습된 모델 및 데이터 세트를 다운로드할 수 있습니다.

도움말 사용

설치 프로세스

- 프로젝트 코드를 복제합니다:

git clone --depth 1 https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

- 종속성을 설치합니다:

pip install -e ".[torch,metrics]"

선택적 종속성에는 토치, 토치-npu, 메트릭, 딥스피드, 라이거-커널, 비트샌드바이트 등이 있습니다.

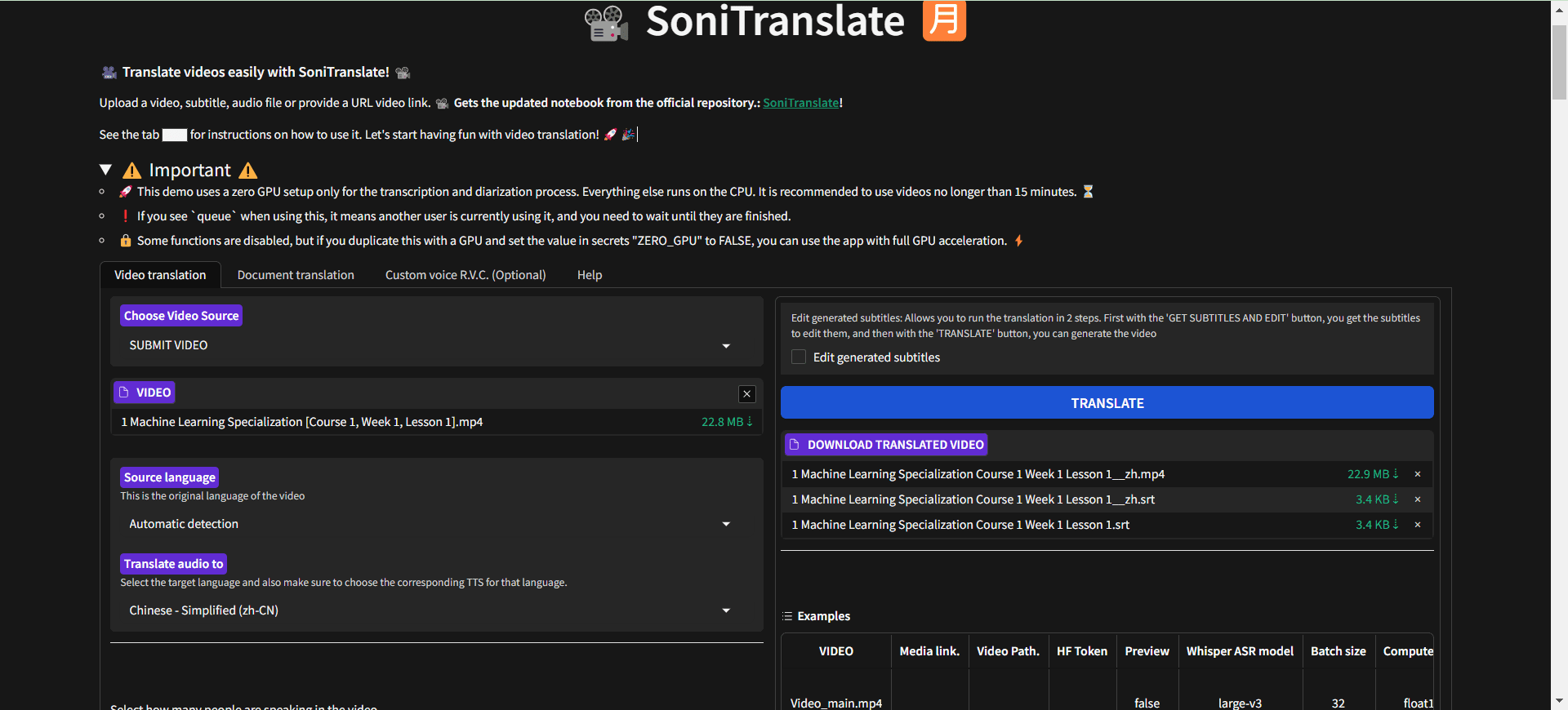

데이터 준비

다음을 참조하십시오. data/README.md 데이터 세트 파일 형식에 대해 자세히 알아보세요. HuggingFace / ModelScope / Modelers 허브에서 데이터 세트를 사용하거나 로컬 디스크에 데이터 세트를 로드할 수 있습니다.

빠른 시작

다음 명령을 사용하여 LoRA를 실행하여 Llama3-8B-Instruct 모델을 미세 조정, 추론 및 병합할 수 있습니다:

llamafactory-cli train examples/train_lora/llama3_lora_sft.yaml

llamafactory-cli chat examples/inference/llama3_lora_sft.yaml

llamafactory-cli export examples/merge_lora/llama3_lora_sft.yaml

고급 사용법은 다음을 참조하세요. examples/README.md.

LLaMA 보드 GUI 사용

미세 조정은 Gradio에서 제공하는 LLaMA 보드 GUI를 통해 이루어집니다:

llamafactory-cli webui

도커 배포

CUDA 사용자용:

cd docker/docker-cuda/

docker compose up -d

docker compose exec llamafactory bash

Ascend NPU 사용자의 경우:

cd docker/docker-npu/

docker compose up -d

docker compose exec llamafactory bash

AMD ROCm 사용자의 경우:

cd docker/docker-rocm/

docker compose up -d

docker compose exec llamafactory bash

API 배포

OpenAI 스타일 API를 사용하고 vLLM 추론:

API_PORT=8000 llamafactory-cli api examples/inference/llama3_vllm.yaml

API 설명서를 보려면 이 페이지를 방문하세요.

모델 및 데이터 세트 다운로드

허깅 페이스에서 모델과 데이터 세트를 다운로드하는 데 문제가 있는 경우 ModelScope를 사용할 수 있습니다:

export USE_MODELSCOPE_HUB=1

모델 스코프 허브의 모델 ID를 지정하여 모델을 학습시킵니다(예: 다음과 같이). LLM-Research/Meta-Llama-3-8B-Instruct.

W&B로 실험 결과 기록하기

사용 방법 가중치 & Biases는 다음 매개변수를 사용하여 실험 결과를 yaml 파일에 기록합니다:

wandb:

project: "your_project_name"

entity: "your_entity_name"

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...