일반 소개

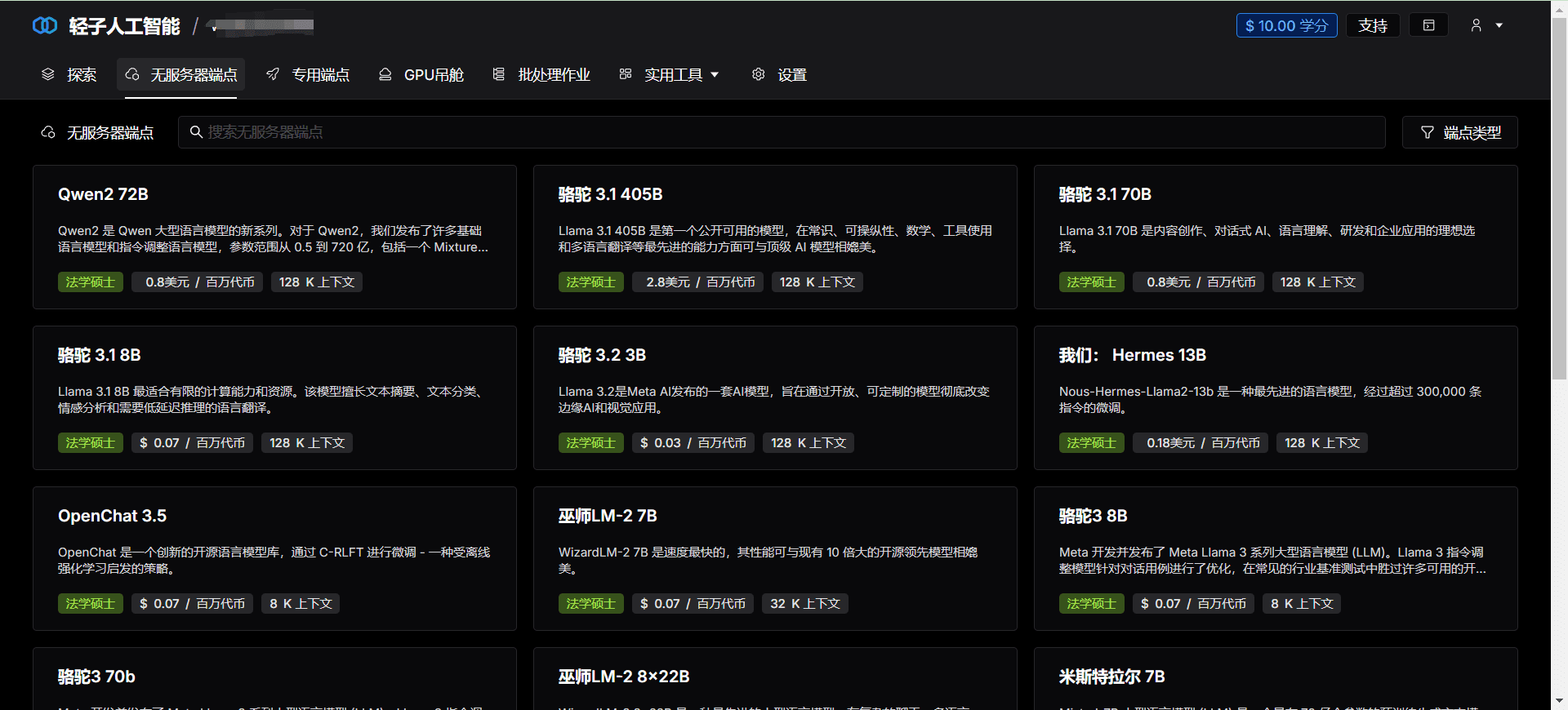

Lepton AI는 개발자와 기업에게 효율적이고 안정적이며 사용하기 쉬운 AI 솔루션을 제공하는 데 전념하는 선도적인 클라우드 네이티브 AI 플랫폼입니다. 강력한 컴퓨팅 기능과 사용자 친화적인 인터페이스를 통해 Lepton AI는 사용자가 복잡한 AI 프로젝트를 빠르게 시작하고 확장할 수 있도록 지원합니다.

기능 목록

- 효율적인 컴퓨팅대규모 AI 모델의 학습 및 추론을 지원하기 위한 고성능 컴퓨팅 리소스를 제공합니다.

- 클라우드 네이티브 경험클라우드 컴퓨팅 기술과 원활하게 통합되어 AI 애플리케이션 개발 및 배포 프로세스를 간소화합니다.

- GPU 인프라최고 수준의 GPU 하드웨어 지원을 제공하여 AI 작업을 효율적으로 실행할 수 있도록 합니다.

- 신속한 배포컨테이너나 Kubernetes를 배울 필요 없이 모델을 빠르게 배포할 수 있도록 네이티브 Python 개발을 지원합니다.

- 유연한 API모든 애플리케이션에서 AI 모델을 쉽게 호출할 수 있는 간단하고 유연한 API를 제공합니다.

- 수평 확장대규모 워크로드를 처리할 수 있도록 수평적 확장을 지원합니다.

도움말 사용

설치 및 사용

- 계정 등록하기렙톤 AI 웹사이트를 방문하여 '등록하기' 버튼을 클릭하고 관련 정보를 입력하여 등록을 완료하세요.

- 프로젝트 만들기로그인 후 '제어판'으로 이동하여 '프로젝트 만들기'를 클릭하고 프로젝트의 이름과 설명을 입력합니다.

- 컴퓨팅 리소스 선택프로젝트 설정에서 GPU 유형 및 개수를 포함하여 필요한 컴퓨팅 리소스를 선택합니다.

- 모델 업로드'모델 관리'에서 '모델 업로드'를 클릭하고 업로드할 로컬 모델 파일을 선택합니다.

- 구성 환경'환경 구성'에서 필요한 런타임 환경 및 종속성 패키지를 선택합니다.

- 배포 모델'배포'를 클릭하면 시스템이 자동으로 모델을 배포하고 API 인터페이스를 생성합니다.

- API 호출하기'API 문서'에서 생성된 API 인터페이스 설명서를 보고 제공된 API 호출 모델을 사용하여 추론합니다.

워크플로

- 모델 교육모델 학습은 모델이 예상대로 작동하는지 확인하기 위해 Python을 사용하여 로컬에서 수행됩니다.

- 모델 테스트로컬에서 모델 테스트를 수행하여 모델의 정확성과 안정성을 검증합니다.

- 모델 업로드온라인 배포를 위해 학습된 모델을 Lepton AI 플랫폼에 업로드합니다.

- 환경 구성모델 요구 사항에 따라 런타임 환경 및 종속성 패키지를 구성하여 모델이 제대로 실행되도록 합니다.

- API 호출생성된 API 인터페이스를 사용하여 애플리케이션에서 추론을 위해 모델을 호출하고 실시간으로 결과를 얻습니다.

- 모니터링 및 유지 관리'모니터' 페이지에서 모델의 실행 상태와 성능 지표를 확인하여 적시에 유지 관리 및 최적화를 수행할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...