일반 소개

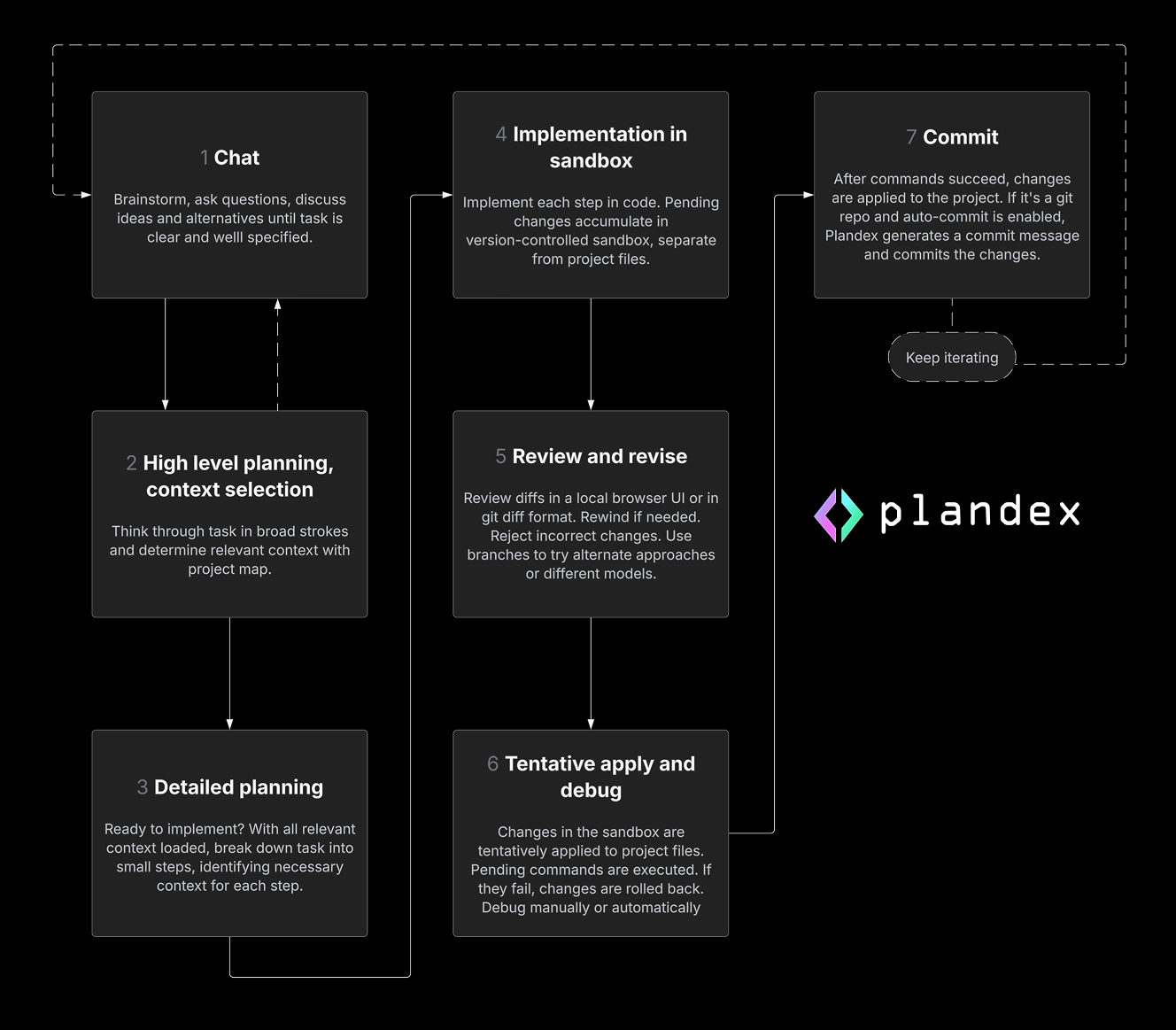

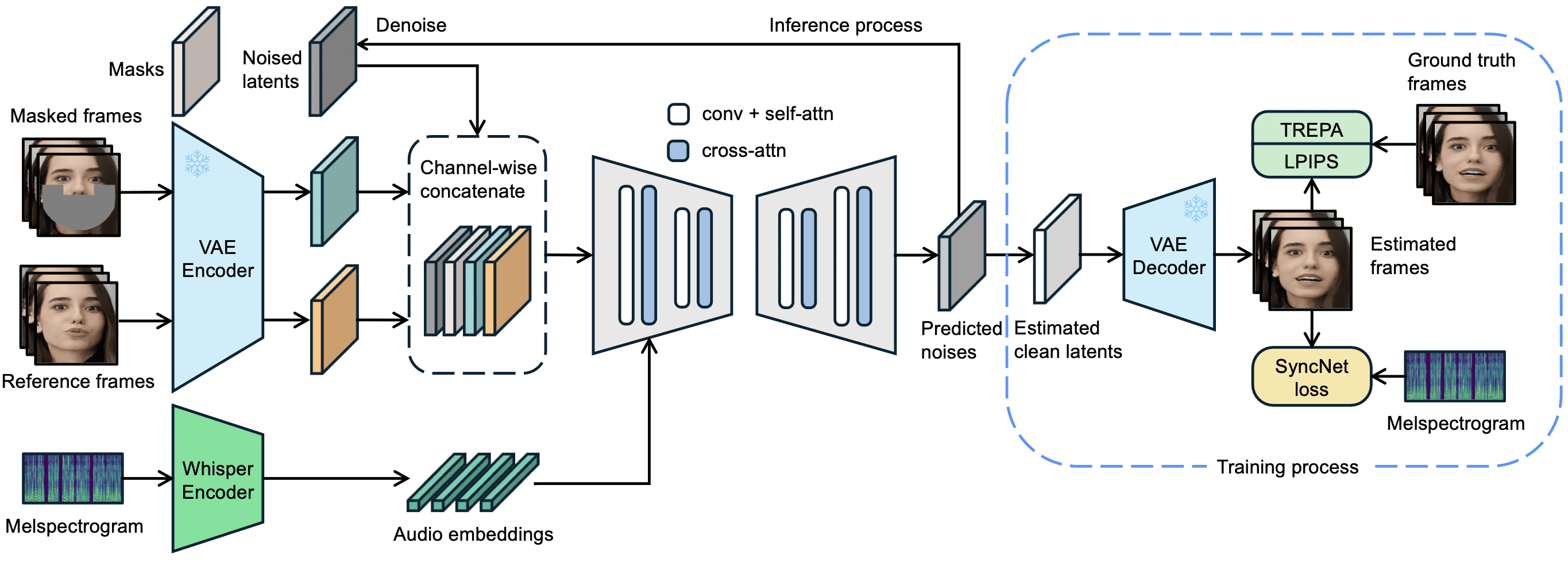

LatentSync는 ByteDance에서 개발하여 깃허브에서 호스팅하는 오픈 소스 툴입니다. 오디오를 통해 비디오 속 캐릭터의 입술 움직임을 직접 구동하여 입 모양이 목소리와 정확하게 일치하도록 합니다. 이 프로젝트는 스테이블 디퓨전의 잠복 확산 모델을 기반으로 하며, 여기에 Whisper 오디오 특징을 추출하여 U-Net 네트워크를 통해 비디오 프레임을 생성합니다. 2025년 3월 14일에 출시된 latentSync 버전 1.5는 시간적 일관성을 최적화하고 중국어 비디오를 지원하며 학습 비디오 메모리 요구량을 20GB로 줄였습니다. 사용자는 6.8GB의 비디오 메모리를 지원하는 그래픽 카드만 있으면 추론 코드를 실행하여 256x256 해상도의 입술 동기화 비디오를 생성할 수 있습니다. 256x256 해상도의 동영상을 생성할 수 있습니다. 이 도구는 코드와 사전 학습된 모델이 제공되는 완전 무료 도구로, 기술 애호가와 개발자 모두에게 적합합니다.

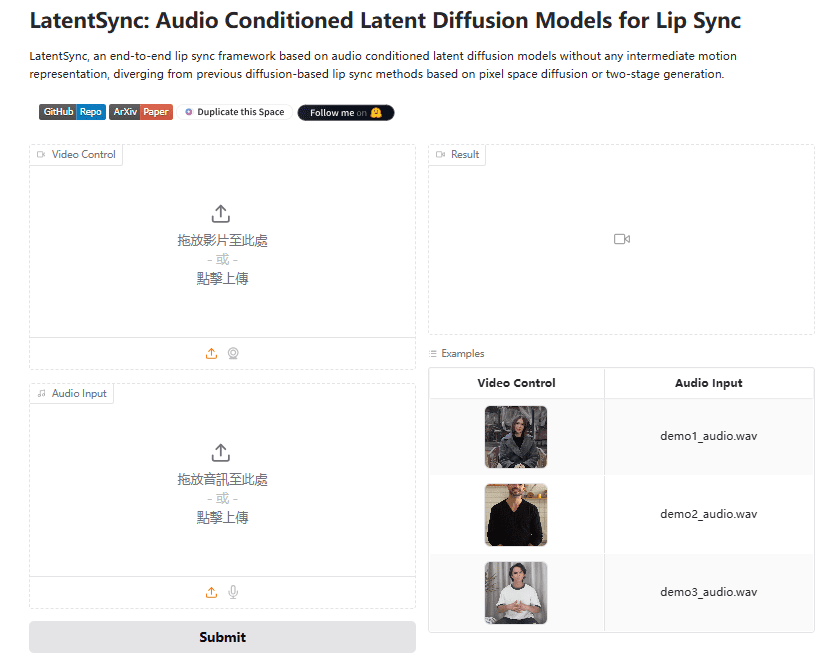

체험: https://huggingface.co/spaces/fffiloni/LatentSync

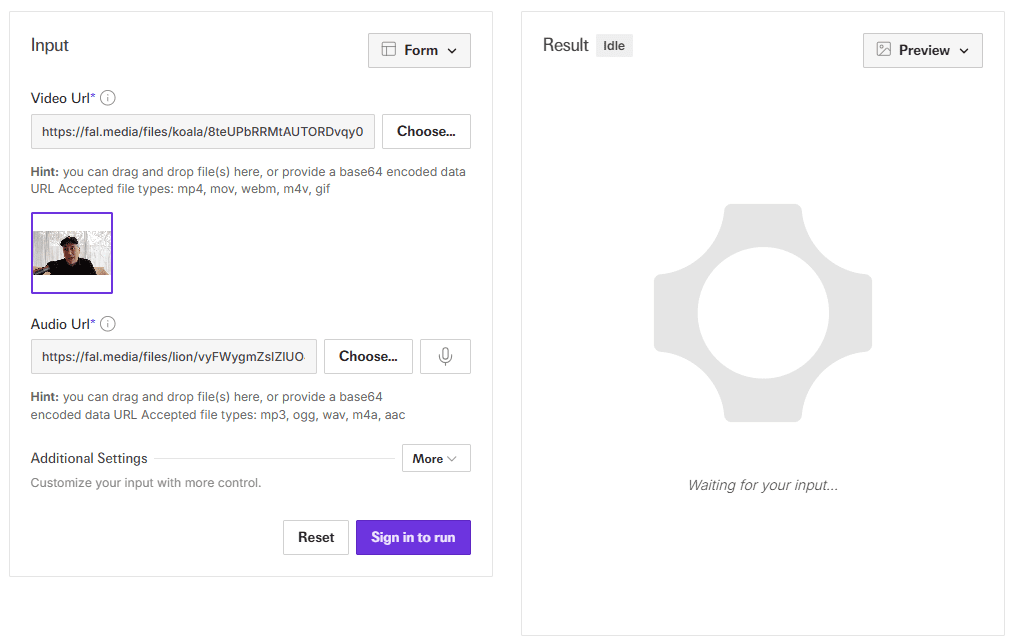

API 데모 주소: https://fal.ai/models/fal-ai/latentsync

기능 목록

- 오디오 드라이버 립싱크오디오 및 비디오를 입력하면 소리와 일치하는 입술 움직임을 자동으로 생성합니다.

- 엔드투엔드 비디오 생성중간 표현이 필요 없고 선명한 립싱크 영상을 직접 출력합니다.

- 시간 일관성 최적화TREPA 기술 및 타이밍 레이어를 통해 화면 점프 현상을 줄입니다.

- 중국어 동영상 지원버전 1.5에서는 중국어 오디오 및 비디오 처리가 개선되었습니다.

- 효율적인 교육 지원U-Net은 다양한 U-Net 구성으로 제공되며 메모리 요구량은 최저 20GB입니다.

- 데이터 처리 파이프라인동영상 데이터를 정리하고 생성 품질을 보장하는 도구가 내장되어 있습니다.

- 매개변수화생성 최적화를 위한 추론 단계 및 안내 척도 조정 지원.

도움말 사용

LatentSync는 기술 기반이 있는 사용자를 위해 로컬에서 실행되는 도구입니다. 설치, 추론 및 교육 과정은 아래에 자세히 설명되어 있습니다.

설치 프로세스

- 하드웨어 및 소프트웨어 요구 사항

- 최소 6.8GB의 비디오 메모리(추론용)를 갖춘 NVIDIA 그래픽 카드가 필요하며, 교육용으로는 20GB 이상 권장됩니다(예: RTX 3090).

- Linux 또는 Windows 지원(Windows는 수동 스크립트 조정 필요).

- CUDA를 지원하는 Python 3.10, Git 및 PyTorch를 설치합니다.

- 코드 다운로드

터미널에서 실행됩니다:

git clone https://github.com/bytedance/LatentSync.git

cd LatentSync

- 종속성 설치

다음 명령을 실행하여 필요한 라이브러리를 설치합니다:

pip install -r requirements.txt

오디오 및 비디오 처리를 위해 ffmpeg를 추가로 설치합니다:

sudo apt-get install ffmpeg # Linux

- 모델 다운로드

- 통해 (틈새) 포옹하는 얼굴 다운로드

latentsync_unet.pt노래로 응답tiny.pt. - 파일을

checkpoints/카탈로그를 다음과 같은 구조로 만들 수 있습니다:checkpoints/ ├── latentsync_unet.pt ├── whisper/ │ └── tiny.pt - SyncNet을 교육하는 경우 다음을 다운로드해야 합니다.

stable_syncnet.pt및 기타 보조 모델.

- 인증 환경

테스트 명령을 실행합니다:

python gradio_app.py --help

오류가 보고되지 않으면 환경이 성공적으로 빌드된 것입니다.

추론 프로세스

LatentSync는 두 가지 추론 방법을 제공하며, 두 방법 모두 6.8GB의 비디오 메모리가 필요합니다.

방법 1: 라디오 인터페이스

- Gradio 애플리케이션을 실행합니다:

python gradio_app.py

- 브라우저를 열고 메시지가 표시되는 로컬 주소를 방문합니다.

- 동영상 및 오디오 파일을 업로드하고 실행을 클릭한 다음 결과가 생성될 때까지 기다립니다.

방법 2: 명령줄

- 입력 파일을 준비합니다:

- 동영상(예

input.mp4), 선명한 얼굴이 포함되어야 합니다. - 오디오(예

audio.wav), 16000Hz 권장.

- 추론 스크립트를 실행합니다:

python -m scripts.inference

--unet_config_path "configs/unet/stage2_efficient.yaml"

--inference_ckpt_path "checkpoints/latentsync_unet.pt"

--inference_steps 25

--guidance_scale 2.0

--video_path "input.mp4"

--audio_path "audio.wav"

--video_out_path "output.mp4"

inference_steps20-50, 값이 높을수록 품질은 높아지고 속도는 느려집니다.guidance_scale1.0~3.0, 값이 높을수록 입술 모양이 더 정확하며 약간의 왜곡이 있을 수 있습니다.

- 프로브

output.mp4립싱크의 효과가 확인되었습니다.

입력 전처리

- 비디오 프레임 속도는 25FPS로 조정하는 것이 좋습니다:

ffmpeg -i input.mp4 -r 25 resized.mp4

- 오디오 샘플 속도는 16000Hz여야 합니다:

ffmpeg -i audio.mp3 -ar 16000 audio.wav

데이터 처리 흐름

모델을 학습시켜야 하는 경우 먼저 데이터를 처리해야 합니다:

- 스크립트를 실행합니다:

./data_processing_pipeline.sh

- 수정

input_dir동영상 카탈로그에 사용할 수 있습니다. - 이 프로세스에는 다음이 포함됩니다:

- 손상된 동영상을 삭제합니다.

- 비디오는 25FPS로, 오디오는 16000Hz로 조정합니다.

- PySceneDetect를 사용하여 씬을 분할합니다.

- 동영상을 5~10초 분량으로 자릅니다.

- 얼굴이 정렬된 얼굴을 감지하고 256x256으로 크기를 조정합니다.

- 동기화 점수가 3점 미만인 동영상을 필터링합니다.

- hyperIQA 점수를 계산하고 40점 미만의 동영상을 삭제합니다.

- 처리된 동영상은

high_visual_quality/카탈로그.

U-Net 교육

- 데이터와 모든 체크포인트를 준비합니다.

- 프로필을 선택합니다(예

stage2_efficient.yaml). - 교육을 실행합니다:

./train_unet.sh

- 구성 파일에서 데이터 경로와 저장 경로를 수정합니다.

- 그래픽 메모리 요구 사항:

stage1.yaml23GB.stage2.yaml30GB.stage2_efficient.yaml일반 그래픽 카드의 경우 20GB.

주의

- Windows 사용자는

.shPython 명령 실행으로 변경합니다. - 화면이 점프하면

inference_steps를 클릭하거나 동영상 프레임 속도를 조정합니다. - 중국어 오디오 지원은 버전 1.5에서 최신 모델을 사용할 수 있도록 최적화되었습니다.

이 단계를 통해 사용자는 LatentSync를 쉽게 설치하고 사용하여 립싱크 비디오를 생성하거나 모델을 추가로 훈련할 수 있습니다.

애플리케이션 시나리오

- 포스트 프로덕션

기존 동영상의 오디오를 교체하여 더빙 조정에 적합한 새 입술을 생성합니다. - 가상 이미지

오디오를 입력하면 라이브 또는 짧은 동영상에서 아바타가 말하는 동영상을 생성할 수 있습니다. - 게임 제작

캐릭터에 역동적인 대화 애니메이션을 추가하여 게임플레이 경험을 향상하세요. - 다국어 지원

전 세계 사용자를 위해 다양한 언어의 오디오가 포함된 교육용 동영상을 제작하세요.

QA

- 실시간 생성을 지원하나요?

지원되지 않습니다. 현재 버전은 전체 오디오 및 비디오가 필요하며 생성하는 데 몇 초에서 몇 분이 걸립니다. - 최소 동영상 메모리는 얼마인가요?

추론에는 6.8GB가 필요하며 교육에는 20GB를 권장합니다(버전 1.5에서 최적화 후). - 애니메이션 동영상을 다룰 수 있나요?

Can. 공식적인 예로는 잘 작동하는 애니메이션 동영상이 있습니다. - 중국어 지원을 개선하려면 어떻게 해야 하나요?

중국어 오디오 처리에 최적화된 LatentSync 버전 1.5를 사용하세요.

LatentSync 원클릭 설치 프로그램

Quark: https://pan.quark.cn/s/c3b482dcca83

WIN/MAC 독립 실행형 설치 프로그램

Quark: https://pan.quark.cn/s/90d2784bc502

바이두: https://pan.baidu.com/s/1HwN1k6v-975uLfI0d8N_zQ?pwd=gewd

LatentSync 강화: https://pan.quark.cn/s/f8d3d9872abb

LatentSync 1.5 로컬 배포 1: https://pan.baidu.com/s/1QLqoXHxGbAXV3dWOC5M5zg?pwd=ijtt

LatentSync 1.5 로컬 배포 2: https://pan.baidu.com/share/init?surl=zIUPiJc0qZaMp2NMYNoAug&pwd=8520

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...