일반 소개

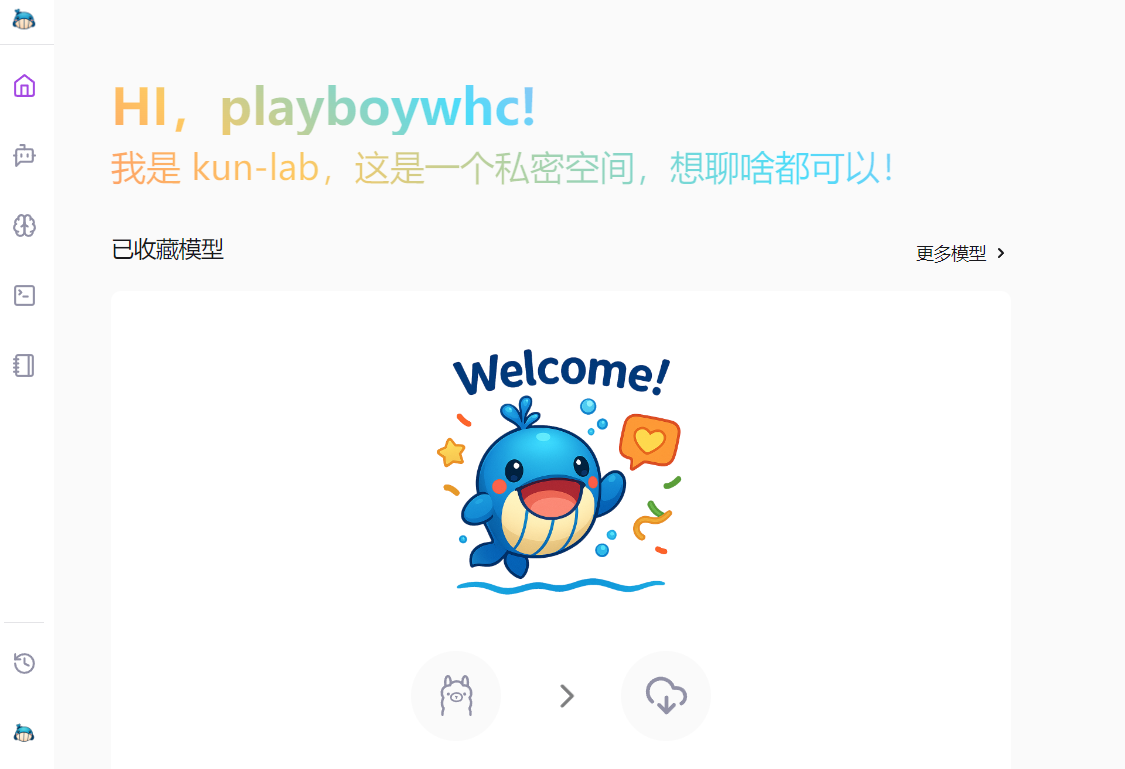

kun-lab은 다음을 기반으로 한 프로그램입니다. Ollama 는 가볍고 빠르며 현지화된 지능형 대화 환경을 제공하는 데 중점을 둔 오픈 소스 AI 대화 앱입니다. Windows, macOS, Linux(현재 Windows가 주력)를 지원하며 복잡한 설정 없이도 사용할 수 있습니다. 사용자는 AI와 원활한 다자간 대화를 나누고, 문서를 파싱하고, 이미지를 식별하고, 온라인에서 답을 검색할 수도 있습니다. 모든 데이터는 개인 정보 보호 및 보안을 위해 로컬에 저장됩니다. 또한 kun-lab은 개발자, 학생 또는 효율적인 AI 도구가 필요한 사람들을 위해 코드 렌더링, 프롬프트 템플릿 및 다국어 인터페이스를 제공합니다.

기능 목록

- 지능형 대화여러 차례의 실시간 대화, 원활한 AI 응답, 보다 포괄적인 답변을 위한 네트워크 검색을 지원합니다.

- 문서 해상도PDF, DOC, PPT, TXT 파일 업로드, AI 내용을 이해하고 질문에 답하세요.

- 이미지 인식JPG, PNG 이미지 인식, 텍스트 추출 또는 장면 분석, 다중 라운드 대화 지원.

- 모델 관리올라마 또는 허깅 페이스 모델 간에 쉽게 전환할 수 있으며, GGUF 및 세이프텐서 형식을 지원합니다.

- 큐 워드 템플릿기본 제공 템플릿과 사용자 지정 지원으로 AI 창의력을 쉽게 발휘할 수 있습니다.

- 코드 렌더링여러 프로그래밍 언어 코드를 자동으로 강조 표시하여 명확하게 표시합니다.

- 빠른 참고 사항마크다운 구문, 실시간 미리보기 및 원클릭 내보내기를 지원합니다.

- 다중 사용자 지원여러 사람이 동시에 로그인하여 각각 별도의 대화 공간을 사용할 수 있습니다.

- 다국어 인터페이스중국어, 영어 및 기타 언어 지원, 보다 친숙한 조작.

도움말 사용

kun-lab은 Ollama에서 실행되는 풍부한 기능을 갖춘 AI 대화 도구로, 조작이 간편하고 현지에서 사용하기에 적합합니다. 다음은 사용자가 빠르게 익힐 수 있도록 설치 과정, 핵심 기능 및 시작 단계에 대한 자세한 설명입니다.

kun-lab 설치

kun-lab은 데스크톱 애플리케이션과 소스 코드 배포를 모두 제공합니다. 현재 데스크톱 애플리케이션은 Windows만 지원하며, 소스 코드 배포는 Windows, macOS 및 Linux를 지원합니다.

모드 1: 데스크톱 애플리케이션(권장)

- GitHub 릴리스 페이지(https://github.com/bahamutww/kun-lab/releases)를 방문하세요.

- 시스템에 적합한 설치 패키지를 다운로드하세요:

- Windows:

.exe문서화. - macOS:

.dmg문서화(향후 지원). - Linux:

.AppImage어쩌면.deb문서화(향후 지원).

- Windows:

- 설치 패키지를 두 번 클릭하고 지시에 따라 설치를 완료합니다.

- 설치 후 바탕화면 아이콘을 클릭하면 추가 구성 없이 kun-lab을 실행할 수 있습니다.

- 실행 후 언어를 선택하고(기본적으로 중국어가 지원됨) 기본 인터페이스로 들어갑니다.

접근 방식 2: 소스 코드 배포

사용자 지정하거나 개발하려면 환경을 설치하고 코드를 실행해야 합니다. 자세한 단계는 다음과 같습니다:

- 환경 준비하기::

- 시스템이 Windows, macOS 또는 Linux인지 확인합니다.

- Python 3.10 이상을 설치합니다(다운로드: https://www.python.org).

- Node.js 20.16.0 이상을 설치합니다(다운로드: https://nodejs.org).

- Ollama를 설치하고 서비스를 시작합니다(참조: https://ollama.com).

- 클론 창고::

git clone https://github.com/bahamutww/kun-lab.git cd kun-lab - 가상 환경 만들기::

python -m venv venv .\venv\Scripts\activate # Windows # source venv/bin/activate # macOS/Linux - 백엔드 종속성 설치::

cd backend pip install -r requirements.txt - 프런트엔드 종속성 설치::

cd frontend npm install - 환경 변수 구성::

cp .env.example .env- 텍스트 편집기로 열기

.env파일을 열고 필요에 따라 구성(예: 포트 번호)을 수정합니다.

- 텍스트 편집기로 열기

- 애플리케이션 실행::

python run_dev.py - 브라우저를 열고 http://localhost:5173 을 방문하여 시작하세요.

핵심 기능 작동

다음은 사용자가 쉽게 시작할 수 있도록 kun-lab의 주요 기능과 구체적인 작동 절차에 대해 설명합니다.

1. 지능형 AI 대화

- 대화 시작하기::

- kun-lab을 열고 "채팅 대화" 또는 "새 대화"를 클릭합니다.

- 모델 목록에서 모델을 선택합니다(기본적으로 Ollama에서 제공하는 모델이 있습니다).

- 질문을 입력하면 AI가 실시간으로 답변합니다.

- 인터넷 검색::

- 질문에 최신 정보가 필요한 경우 '웹 검색 사용' 확인란을 선택합니다.

- AI가 웹 페이지 데이터를 결합하여 보다 포괄적인 답변을 제공합니다.

- 기록 관리::

- 대화는 자동으로 저장되며 사이드바에서 '기록'을 클릭하면 확인할 수 있습니다.

- 대화는 삭제하거나 내보낼 수 있습니다.

- 코드 지원::

- 코드 관련 질문을 입력하면 AI가 강조 표시된 형식으로 코드를 표시합니다.

- Python, JavaScript 및 기타 언어 지원.

2. 문서 구문 분석

- 문서 업로드::

- 문서 대화상자 화면을 클릭합니다.

- '업로드' 버튼을 클릭하고 PDF, DOC, PPT 또는 TXT 파일을 선택합니다.

- 문서가 구문 분석된 후 AI는 문서 요약을 표시합니다.

- 질문하기::

- 대화 상자에 문서와 관련된 질문을 입력합니다.

- AI는 콘텐츠에 기반하여 답변하고 문맥화를 지원합니다.

- 콘텐츠 검색::

- 키워드를 입력하면 AI가 문서에서 관련 부분을 빠르게 찾아냅니다.

- 결과를 클릭하면 원본 글의 위치로 이동합니다.

3. 이미지 인식

- 사진 업로드::

- '그림 대화' 페이지로 이동합니다.

- '이미지 업로드'를 클릭하고 JPG, PNG 또는 JPEG 파일을 선택합니다.

- AI가 자동으로 장면을 인식하거나 텍스트를 추출합니다.

- 다층적 대화::

- "이 사진에는 무엇이 있나요?"와 같이 사진을 기반으로 질문하세요. .

- AI의 답변이 끝나면 계속해서 더 깊이 있는 질문을 할 수 있습니다.

- OCR 기능::

- 이미지에 텍스트가 포함되어 있으면 AI가 텍스트를 추출하여 표시합니다.

- 텍스트를 복사하거나 텍스트 기반 질문을 할 수 있습니다.

4. 모델 관리

- 풀 모델::

- 모델 라이브러리 페이지로 이동합니다.

- "모델 가져오기"를 클릭합니다.

- 다음과 같은 명령을 입력합니다.

ollama run qwq:32b어쩌면ollama run hf.co/Qwen/QwQ-32B-GGUF:Q2_K. - 다운로드가 완료되고 모델을 사용할 준비가 될 때까지 기다립니다.

- 모델 전환::

- 대화 페이지에서 모델 드롭다운 메뉴를 클릭합니다.

- 다운로드한 모델을 선택하면 즉시 전환할 수 있습니다.

- 사용자 지정 모델::

- '사용자 지정' 버튼을 클릭합니다.

- 모델 이름과 시스템 프롬프트(예: "수학 선생님 놀이")를 입력합니다.

- 기본 모델을 선택하고 '만들기'를 클릭합니다.

5. 큐 관리

- 템플릿 사용::

- '프롬프트' 화면을 엽니다.

- '문서 개요 작성' 또는 '코드 디버깅'과 같은 기본 제공 템플릿을 찾아보세요.

- 템플릿을 클릭하여 대화에 바로 적용합니다.

- 사용자 지정 단서::

- "새 큐"를 클릭합니다.

- 이름과 콘텐츠를 입력하고 저장한 다음 정렬하고 관리할 수 있습니다.

- 빠른 앱::

- 대화 중에 프롬프트 단어를 선택하면 AI가 설정한 대로 응답합니다.

6. 빠른 참고 사항

- 노트 만들기::

- 메모 페이지를 클릭합니다.

- 제목, 목록, 코드 등의 콘텐츠를 마크다운 형식으로 입력합니다.

- 오른쪽에서 효과를 실시간으로 미리 볼 수 있습니다.

- 노트 내보내기::

- "내보내기" 버튼을 클릭하고 다른 이름으로 저장합니다.

.md문서화. - 다른 도구로 공유하거나 가져올 수 있습니다.

- "내보내기" 버튼을 클릭하고 다른 이름으로 저장합니다.

주의

- Ollama 서비스가 실행 중인지 확인합니다. 그렇지 않으면 AI 기능을 사용할 수 없습니다.

- 모델을 처음 가져오는 데 시간이 걸릴 수 있으며 인터넷 연결을 확인하는 것이 좋습니다.

- 로컬에 저장된 데이터는 많은 공간을 차지하며 주기적으로 기록을 정리합니다.

- 문제가 발생하면 GitHub의

issues페이지로 이동하거나 피드백을 제출하세요.

다음 단계에 따라 kun-lab의 기능을 쉽게 설치하고 사용할 수 있습니다. 대화, 문서 파싱, 이미지 분석 등 직관적이고 편리한 조작이 가능합니다.

애플리케이션 시나리오

- 개인 학습 도우미

학생들은 쿤랩을 사용하여 코스웨어나 교과서를 파싱하고 질문을 하면 AI가 자세히 답변해 줍니다. 수학 유인물을 업로드하면 AI가 공식을 단계별로 설명해 줍니다. - 개발자 도구

프로그래머는 kun-lab을 사용하여 코드를 디버깅하거나 새로운 언어를 배울 수 있습니다. 코드 스니펫을 입력하면 AI가 최적화를 제안하고 강조 표시해 줍니다. - 문서

커리어 전문가들은 문서 구문 분석 기능으로 보고서를 빠르게 요약할 수 있습니다. 긴 PPT를 업로드하면 AI가 핵심 사항을 추출하여 간결한 노트를 생성합니다. - 창의적 탐색

크리에이터는 즉석 단어 템플릿으로 스토리를 만들거나 디자인 영감을 얻을 수 있습니다. AI가 분석하고 개선점을 제안하는 스케치를 업로드하세요.

QA

- 쿤랩을 사용하려면 인터넷 연결이 필요한가요?

핵심 기능은 로컬에서 실행되며 네트워킹이 필요하지 않습니다. 인터넷 검색 기능은 선택 사항이며 수동으로 켜야 합니다. - 어떤 문서 형식이 지원되나요?

PDF, DOC, PPT, TXT 파일을 지원하며 향후 더 많은 포맷으로 확장될 수 있습니다. - 새 모델을 추가하려면 어떻게 하나요?

모델 라이브러리 화면에서 다음을 입력합니다.ollama run명령을 사용하여 올라마 또는 포옹하는 얼굴 모델을 가져옵니다. - 데이터는 안전한가요?

모든 데이터는 개인 정보 보호 및 보안을 위해 클라우드에 업로드되지 않고 로컬에 저장됩니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...