일반 소개

KTransformers: 대규모 모델 추론의 병목 현상을 해결하기 위해 설계된 고성능 Python 프레임워크입니다. KTransformers는 단순한 모델 실행 도구가 아니라 극한의 성능 최적화 엔진과 유연한 인터페이스 강화 플랫폼입니다. KTransformers는 대규모 모델 추론의 효율성을 상향식으로 개선하고, 고급 커널 최적화, 강력한 병렬 처리 전략(다중 GPU, 스파스 주의) 및 기타 핵심 기술을 통해 모델 추론 속도를 크게 가속화하고 하드웨어 임계값을 낮추는 데 전념하고 있습니다.

단순히 모델을 실행하는 것 외에도 KTransformers는 다양한 성능 개선과 애플리케이션 확장성을 제공합니다. 기존 프로젝트를 원활하게 마이그레이션할 수 있는 기본 트랜스포머 호환 인터페이스를 제공할 뿐만 아니라, OpenAI와 호환되는 애플리케이션을 쉽게 구축할 수 있습니다. Ollama 모든 유형의 애플리케이션에 빠르게 통합할 수 있는 표준 RESTful API 서비스를 제공합니다. 또한 즉시 사용 가능한 ChatGPT 지루한 설정 없이 모델 효과를 빠르게 경험하고 테스트할 수 있는 스타일 웹 인터페이스입니다.

KTransformers는 더 높은 성능을 요구하는 사용자를 위해 설계되었습니다. 최고의 추론 속도를 원하는 개발자, 대용량 모델 애플리케이션을 효율적으로 배포해야 하는 엔지니어, 고성능 대용량 모델을 로컬에서 쉽게 경험하고 싶은 사용자 등 모든 사용자가 혁신적인 애플리케이션을 구동하기 위해 대용량 모델의 잠재력을 최대한 발휘할 수 있도록 강력한 지원을 제공하는 KTransformers입니다.

핵심 강점:

- 극한의 성능: 커널 수준 최적화와 병렬 전략은 다음과 같은 이점을 제공합니다.훨씬 더 빠른 추론.

- 유연한 인터페이스: 트랜스포머 호환 인터페이스, RESTful API 및 웹 인터페이스.다양한 애플리케이션 시나리오의 요구 사항 충족.

- 폭넓은 호환성: 여러 GPU, 여러 CPU 아키텍처, 여러 메인스트림 매크로 모델을 지원합니다.다양한 하드웨어 및 모델링 옵션 지원.

- 사용 편의성은 사용자 지정 기능과 밀접한 관련이 있습니다: 기존즉시 사용 가능한 편의성또한 사용 가능다양한 구성 옵션를 통해 고급 사용자의 심층적인 최적화 요구 사항을 충족합니다.

기능 목록

- 고성능 변압기 호환 인터페이스 는 트랜스포머 라이브러리와 완벽하게 호환되는 인터페이스를 제공합니다.기존 프로젝트를 무료로 마이그레이션하고 즉시 성능 개선을 경험하세요!.

- 유연하고 사용하기 쉬운 RESTful API 서비스 : OpenAI 및 Ollama 표준을 따릅니다.확장 가능한 API 서비스를 신속하게 구축이 회사의 제품은 다양한 애플리케이션과 플랫폼에 쉽게 통합될 수 있도록 설계되었습니다.

- 즉시 사용 가능한 ChatGPT 스타일의 웹 인터페이스 친숙한 대화형 인터페이스 제공.제로 코딩으로 모델 성능을 빠르게 경험하고 테스트를 사용하여 쉽게 데모하고 검증할 수 있습니다.

- 멀티 GPU 병렬 컴퓨팅 엔진 :: 다중 GPU의 강력한 성능 활용를 사용하여 추론 속도를 선형적으로 개선하고 응답 시간을 획기적으로 단축했습니다.

- 심층적인 커널 수준 성능 최적화 : 고급 커널 최적화 기법 사용.아래로부터의 하드웨어 잠재력 활용를 사용하여 모델 추론 성능의 질적 도약을 달성했습니다.

- 지능형 스파스 어텐션 프레임워크 블록 희소주의 메커니즘을 지원합니다.메모리 사용량 대폭 감소CPU 효율적인 디코딩을 지원합니다.하드웨어 병목 현상 해결.

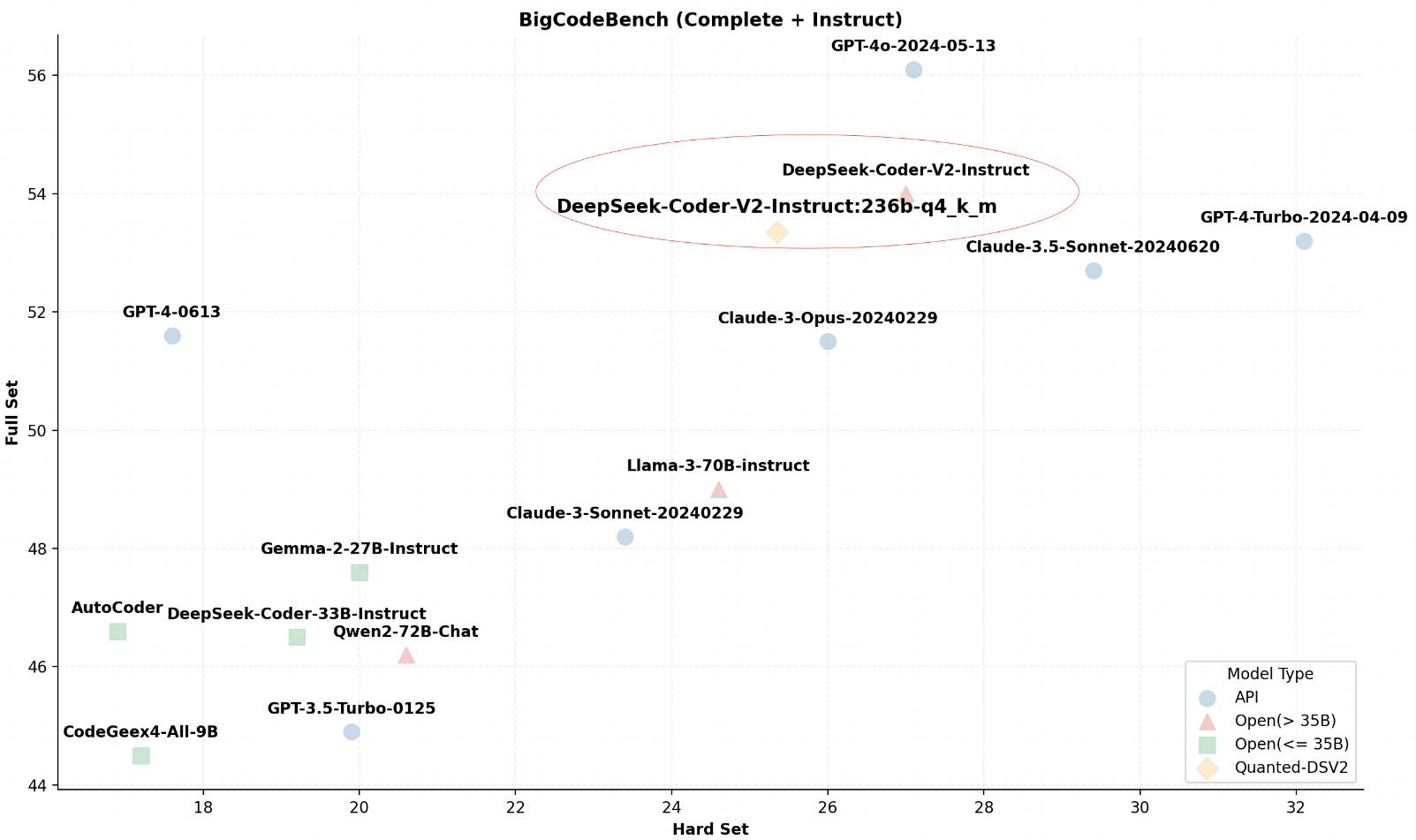

- 대형 모델을 위한 광범위한 생태 지원 InternLM, DeepSeek-Coder 등과 호환 가능.다양한 메인스트림 대형 모델 (지속적인 확장 중).최상의 모델링 솔루션을 선택할 수 있는 유연성.

- 경량 로컬 고성능 추론 고가의 특수 하드웨어가 필요 없습니다.일반적인 데스크톱 환경에서의 뛰어난 추론 성능를 클릭해 사용 문턱을 낮춥니다.

도움말 사용

마운팅

- 클론 창고 ::

git clone https://github.com/kvcache-ai/ktransformers.git

cd ktransformers

- 종속성 설치 ::

pip install -r requirements-local_chat.txt

- KT트랜스포머 설치 ::

python setup.py install

시작하기

- 모델 로드 ::

from ktransformers import KTransformers

model = KTransformers(model_name="your_model_name")

- 추론의 예 ::

input_text = "你好,KTransformers!"

output = model.infer(input_text)

print(output)

- RESTful API 사용 : API 서비스를 시작합니다:

python -m ktransformers.api

요청 보내기:

curl -X POST "http://localhost:8000/infer" -d '{"text": "你好,KTransformers!"}'

고급 기능

- 멀티 GPU 지원 프로젝트 루트 디렉터리에서 구성 파일을 편집합니다.

config.yaml를 클릭하고 멀티 GPU 설정을 지정하여 추론 속도를 향상시킵니다. - 짧은 주의 집중 시간 : 프로젝트 루트 디렉토리에 있는 구성 파일

config.yaml특히 리소스가 제한된 환경에서 메모리 사용을 최적화하기 위해 스파스 어텐션 구성을 추가하세요. - 로컬 추론 : 프로젝트 루트 디렉토리에 있는 구성 파일

config.yaml로컬 데스크톱 환경에서 효율적인 추론을 위해 메모리 및 비디오 메모리 매개변수를 지정하여 24GB VRAM 및 150GB DRAM을 지원합니다.

구성 세부 정보

- 여러 GPU 구성 : 구성 파일 편집

config.yaml::

gpu:

- id: 0 # GPU 设备索引 0

- id: 1 # GPU 设备索引 1

- 집중력 향상 : 구성 파일에 추가합니다:

attention:

type: sparse

- 로컬 추론 설정 구성 파일에서 메모리 및 비디오 메모리 매개변수를 지정합니다:

memory:

vram: 24GB # 显存限制 (GB),根据实际情况调整

dram: 150GB # 内存限制 (GB),根据实际情况调整© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...