에서 재미있는 논문을 발견했습니다.생각은 사방에 널려 있습니다: o1-Like LLM의 잘못된 생각에 대해'라는 주제는 사고 경로의 잦은 전환과 사고의 집중력 부족을 나타내는 O1 유형의 추론 모델을 분석하는 것입니다."생각 부족".완화 방법도 제공됩니다. 이 글은 추론 모델이 다시 생각하고 있는지 여부에 대한 질문에 대한 답을 동시에 제시하며, 독자가 스스로 답을 찾을 수 있기를 바랍니다.

I. 배경:

최근 몇 년 동안 OpenAI의 o1 모델로 대표되는 대규모 언어 모델(LLM)은 추론 과정에 관련된 계산량을 확장하여 인간의 사고의 깊이를 모방하는 복잡한 추론 작업에서 뛰어난 능력을 보여주었습니다. 하지만 기존 연구들은 인공 지능의 사고의 깊이에 의문을 제기했습니다:이 모델들은 정말 깊이 생각하고 있을까요?

이 질문에 답하기 위해 이 백서의 저자는 다음과 같이 제안합니다."언더씽킹."의 개념을 체계적으로 분석합니다. 저자들은생각할 음식이 충분하지 않음는 복잡한 문제를 푸는 데 있어 LLM의 O1 클래스입니다.유망한 추론 경로를 너무 일찍 포기하면 사고의 깊이가 부족해져 궁극적으로 모델 성능에 영향을 미칩니다.. 이 현상은 특히 수학 퍼즐에서 두드러지게 나타납니다.

II. 성찰 및 연구 방법:

저자들은 언더씽킹 현상을 더 깊이 파고들기 위해 다음과 같은 연구를 진행했습니다:

1. 반사 결핍 현상의 정의 및 관찰

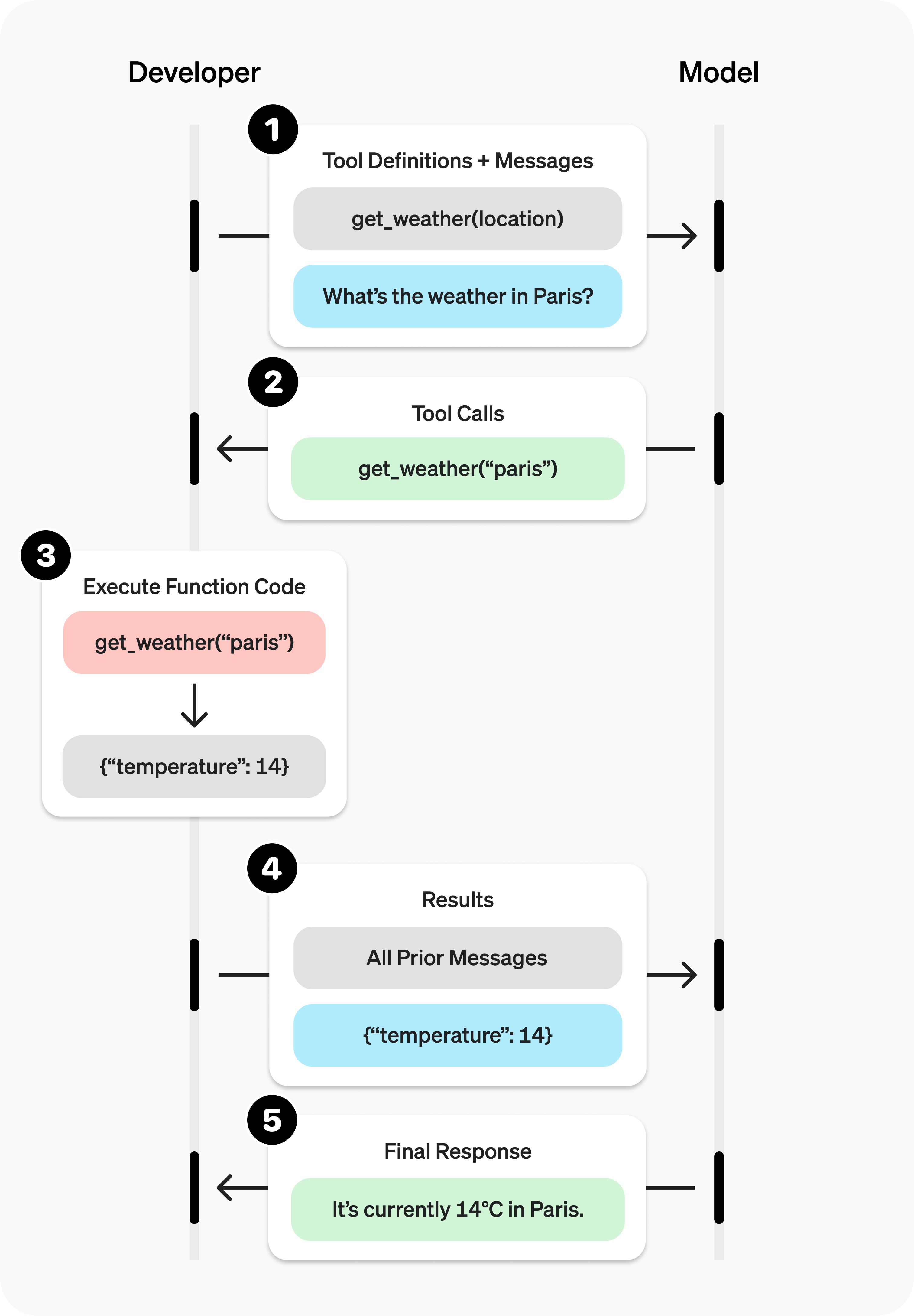

- 사고의 정의: 저자들은 '사고'를 모델의 추론 과정에서 중간 인지 단계로 정의하고, '대안'과 같은 용어를 사고의 전환을 나타내는 신호로 사용합니다.

- 예시: 그림 2에서 저자는 25개의 사고 단계가 포함된 모델의 결과물 예시를 보여주고 이를 과잉 사고의 결과물과 비교합니다.

- 실험 설계:

- 테스트 세트: 저자들은 세 가지 도전적인 테스트 세트를 선택했습니다:

- MATH500. 난이도 1부터 5까지 다양한 고등학교 수학 경시대회 문제가 포함되어 있습니다.

- GPQA 다이아몬드. 물리학, 화학 및 생물학 분야의 대학원 수준의 객관식 문제가 포함되어 있습니다.

- AIME2024. 미국 초청 수학 경시 대회의 주제는 대수, 수 세기, 기하학, 수 이론, 확률 등 다양한 분야를 다룹니다.

- 모델 선택: 저자들은 긴 생각의 사슬이 눈에 띄는 o1 클래스의 오픈 소스 모델 두 가지, 즉 QwQ-32B-Preview와 DeepSeek-R1-671B를 선택했고, R1 모델 제품군의 발전을 보여주기 위한 보충 자료로 DeepSeek-R1-Preview를 사용했습니다.

- 테스트 세트: 저자들은 세 가지 도전적인 테스트 세트를 선택했습니다:

2. 부적절한 성찰의 징후 분석하기

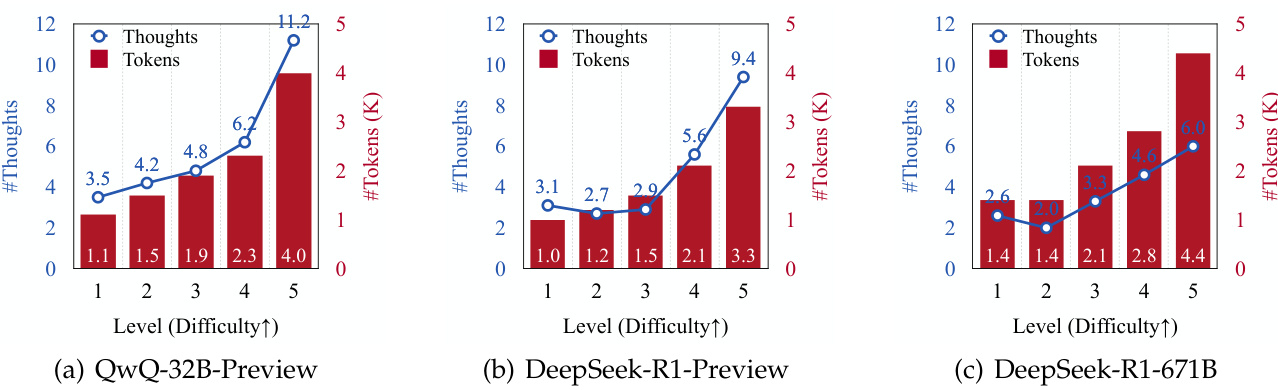

- 전환 빈도 및 문제 난이도에 대해 생각해 보세요:

- 저자들은 문제의 난이도가 높아질수록 모든 모델에서 생성된 추론 반사 횟수와 생성된 토큰 수가 증가한다는 사실을 발견했습니다(그림 3 참조).

- 이는 클래스 o1 LLM이 더 복잡한 문제에 대처하기 위해 추론 프로세스를 동적으로 조정할 수 있음을 시사합니다.

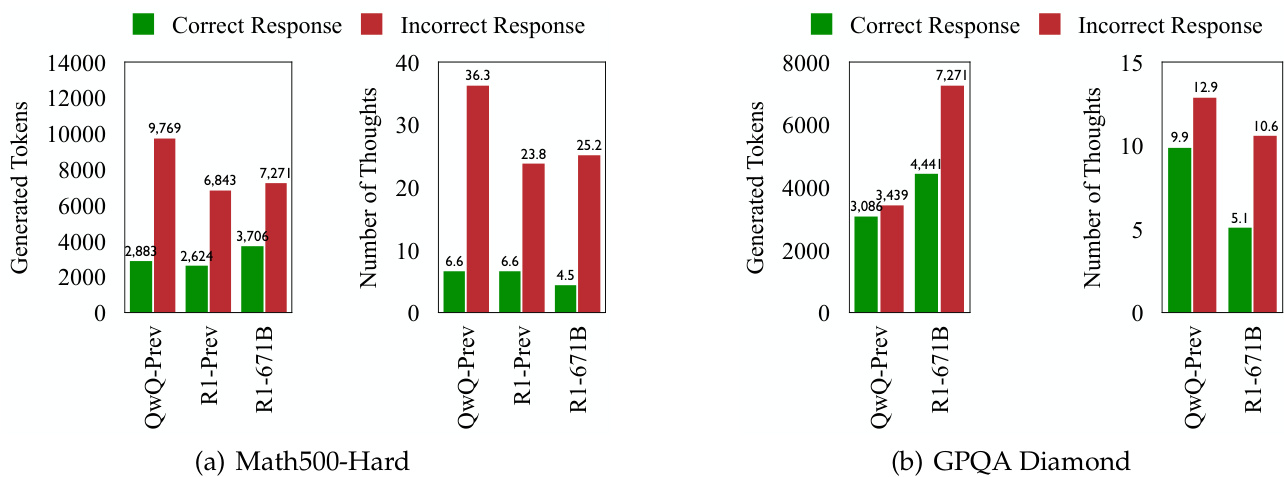

- 전환 및 오류 대응에 대해 생각해 보세요:

- 모든 테스트 세트에서 클래스 o1 LLM은 오답을 생성할 때 더 자주 사고를 전환하는 것으로 나타났습니다(그림 1 및 4 참조).

- 이는 이 모델이 문제 해결을 위해 인지 과정을 동적으로 조정하는 것을 목표로 하지만, 사고의 전환이 잦다고 해서 반드시 정확도가 높아지는 것은 아니라는 것을 시사합니다.

3. 사고력 결핍의 본질에 대한 심층 탐구

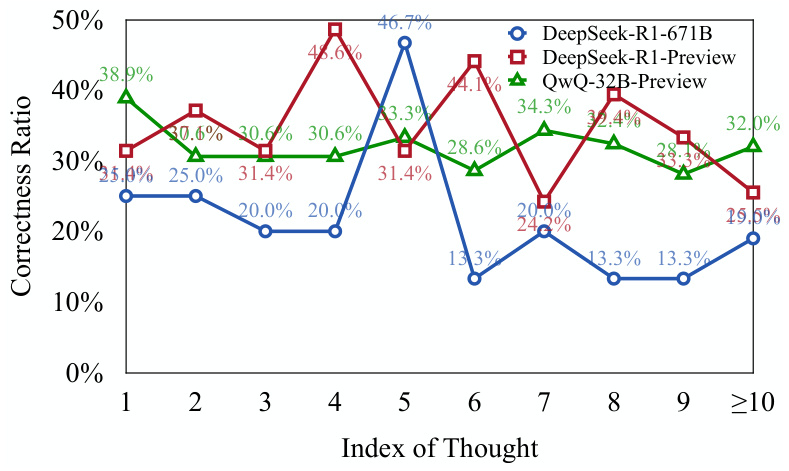

- 사고의 정확성을 평가합니다:

- 저자는 각 사고 단계가 올바른지 평가하기 위해 라마와 퀀을 기반으로 한 두 가지 모델(DeepSeek-R1-Distill-Llama-70B 및 DeepSeek-R1-Distill-Qwen-32B)을 사용했습니다.

- 결과는 다음과 같습니다.오류 응답의 초기 사고 단계 중 상당 부분이 정확하지만 완전히 탐색되지 않았습니다.(그림 5 참조).

- 이는 이 모델이 복잡한 문제에 직면했을 때유망한 추론 경로를 조기에 포기하여 사고의 깊이가 부족해지는 경향이 있습니다..

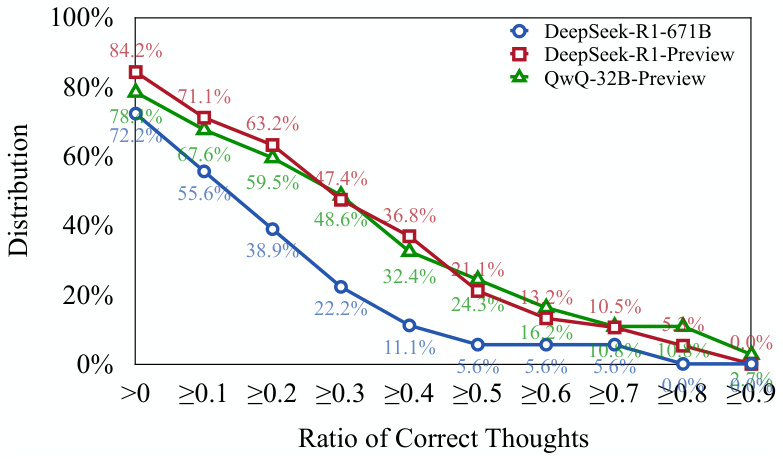

- 정확도 분포에 대해 생각해 보세요:

- 저자들은 701개 이상의 TP3T 오류 응답에 적어도 한 가지 이상의 올바른 사고 단계가 포함되어 있음을 발견했습니다(그림 6 참조).

- 이는 위의 견해를 더욱 뒷받침합니다:o 1등급 모델은 올바른 추론 경로를 시작할 수 있지만, 이러한 경로를 올바른 결론으로 이어가는 것은 어려울 수 있습니다..

4. 성찰의 부족을 정량화하기: 평가를 위한 새로운 지표 제안

- 언더 지표(UT)에 대해 생각해 보세요:

- 이 메트릭은 오류 응답을 생성할 때 토큰의 효율성을 측정하여 사고 부족의 정도를 정량화합니다.

- 특히 UT 메트릭은 다음과 같은 오류 응답을 계산합니다.처음부터 첫 번째 토큰까지 올바르게 생각한 토큰의 수를 총 토큰 수의 비율로 표시합니다..

- UT 값이 높을수록 사고 부족 수준이 높음을 나타냅니다.즉, 오류에 대한 응답으로 모델에서 생성된 토큰의 비율이 높을수록 올바른 사고를 생성하는 데 효과적으로 기여하지 못한다는 의미입니다.

5. 과소 사고가 모델 성능에 미치는 영향:

- 저자는 다음과 같은 사실을 발견했습니다.생각 부족 현상은 데이터 집합과 작업에 따라 다르게 나타납니다.::

- MATH500-Hard 및 GPQA Diamond 데이터 세트에서 DeepSeek-R1-671B 모델은 더 정확했지만 UT 값도 더 높아서 오류 응답에 더 많은 미숙함이 있음을 시사했습니다.

- AIME2024 테스트 세트에서 DeepSeek-R1-671B 모델은 정확도가 높을 뿐만 아니라 UT 값도 낮아 보다 집중적이고 효율적인 추론 프로세스를 보여줍니다.

III. 중요한 결론:

- 불충분한 사고력은 복잡한 문제에 대한 o1 LLM의 저조한 성과의 중요한 요인입니다. 사고 전환이 잦으면 모델이 유망한 추론 경로를 깊이 있게 탐색할 수 없게 되어 궁극적으로 정확도에 영향을 미칩니다.

- 생각 부족 현상은 문제 난이도 및 모델링 능력과 관련이 있습니다. 어려운 문제는 과소사고를 악화시키고, 더 강력한 모델이 항상 과소사고를 줄이는 것은 아닙니다.

- 과소 사고는 과대 사고와 다릅니다. 과잉 사고는 모델이 단순한 문제에 계산 리소스를 낭비하는 경우이며, 과소 사고는 모델이 복잡한 문제에 대해 유망한 추론 경로를 조기에 포기하는 경우입니다.

- 언더씽킹 지표(UT)는 언더씽킹의 정도를 효과적으로 정량화할 수 있습니다. 이 메트릭은 클래스 o1의 LLM의 추론 효율성을 평가하는 새로운 관점을 제공합니다.

IV. 대응 전략:

부적절한 사고의 문제를 완화하기 위해 저자는 다음과 같이 제안합니다.사고 전환 페널티를 이용한 디코딩 전략(팁)::

- 핵심 아이디어: 디코딩 중 씽크 스위치와 관련된 토큰에 페널티를 적용합니다.모델이 새로운 사고로 전환하기 전에 현재의 사고를 더 깊이 탐구하도록 장려하세요..

- 결과: TIP 전략은 모든 테스트 세트에서 QwQ-32B-Preview 모델의 정확도를 향상시켜 언더씽킹 문제를 완화하는 데 효과적임을 입증합니다.

V. 향후 전망:

저자는 다음과 같은 향후 연구 방향을 제안합니다:

- 모델이 사고 전환을 스스로 조절할 수 있는 적응 메커니즘을 개발합니다.

- 클래스 o1의 LLM의 추론 효율성을 더욱 개선합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 게시물

댓글 없음...