1월: 오픈 소스 오프라인 AI 어시스턴트, ChatGPT 대체, 로컬 AI 모델 실행 또는 클라우드 AI 연결

일반 소개

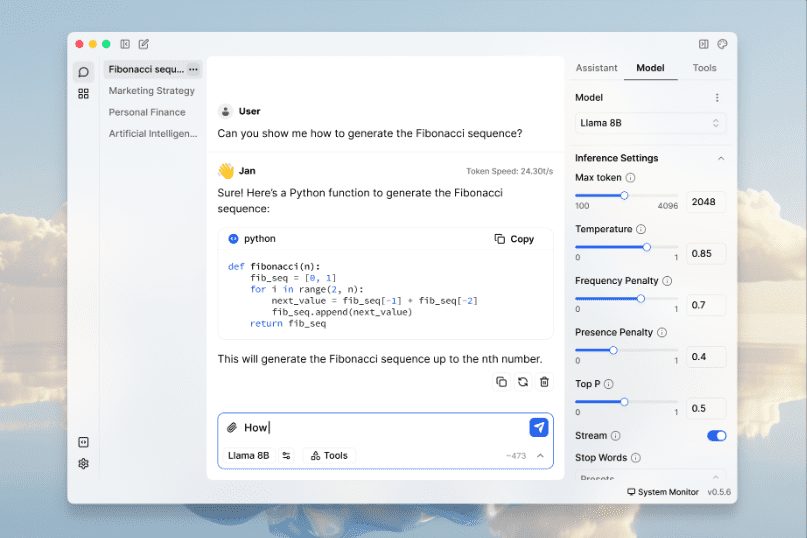

Jan은 오픈 소스입니다. ChatGPT Jan은 사용자 디바이스 100%에서 다운로드하여 오프라인으로 실행할 수 있는 풍부한 모델 라이브러리를 제공합니다. 이 제품은 Cortex 엔진으로 구동되며 NVIDIA GPU 및 Apple의 M 시리즈 칩을 비롯한 다양한 하드웨어 플랫폼을 지원합니다. Jan은 사용자가 다운로드하여 실행할 수 있는 풍부한 모델 라이브러리(예: Llama, Gemma 및 미스트랄 Jan은 PC부터 멀티 GPU 클러스터까지 모든 하드웨어에서 실행할 수 있는 임베디드 가능한 네이티브 AI 엔진인 Cortex로 구동됩니다.

기능 목록

- 로컬에서 AI 모델 실행라마, 젬마, 미스트랄 및 기타 여러 인기 모델 지원.

- 멀티 엔진 지원llama.cpp, TensorRT-LLM 및 기타 여러 엔진과 호환됩니다.

- 오프라인 작업인터넷 연결이 필요하지 않으며 모든 데이터 처리가 로컬에서 이루어집니다.

- 모델 라이브러리다양한 모델 다운로드 및 관리 기능을 제공합니다.

- 원격 AI 연결OpenAI, Groq, Cohere 등과 같은 원격 AI 서비스에 연결합니다.

- 로컬 API 서버: OpenAI 호환 로컬 API 서버를 설정하고 실행합니다.

- 높이 사용자 지정 가능확장 플러그인을 통해 기능 사용자 지정을 지원합니다.

- 개인정보 보호모든 데이터는 로컬에 저장되며 사용자가 데이터를 완전히 제어할 수 있습니다.

도움말 사용

설치 프로세스

- 다운로드액세스 Jan 공식 웹사이트 어쩌면 깃허브 페이지 Windows, MacOS 또는 Linux용 설치 패키지를 다운로드합니다.

- 마운팅::

- Windows(컴퓨터)다운로드한

jan.exe파일을 열고 지시에 따라 설치를 완료합니다. - MacOS: 다운로드

jan.dmg파일을 두 번 클릭하여 열고 Jan을 응용 프로그램 폴더로 끌어다 놓습니다. - Linux: 다운로드

.deb어쩌면.AppImage파일을 다운로드하여 명령줄을 사용하여 설치하거나 직접 실행하세요.

- Windows(컴퓨터)다운로드한

사용 가이드라인

- 애플리케이션 실행설치가 완료되면 Jan 애플리케이션을 엽니다.

- 모델 선택모델 라이브러리에서 라마, 젬마, 미스트랄 등 원하는 AI 모델을 선택하여 다운로드합니다.

- 로컬 운영다운로드한 모델을 선택하고 '실행' 버튼을 클릭하면 로컬 장치에서 모델이 실행됩니다.

- 원격 AI 연결더 많은 컴퓨팅 성능이 필요한 경우 설정에서 OpenAI, Groq 등과 같은 원격 AI 서비스를 구성하고 연결할 수 있습니다.

- API 서버 사용설정에서 로컬 API 서버를 활성화하고 지시에 따라 API 키를 구성하면 OpenAI 호환 API로 개발 및 테스트할 수 있습니다.

- 사용자 지정 확장 프로그램확장 센터를 방문하여 필요한 확장 플러그인을 다운로드하여 설치하고 특정 요구사항에 맞게 Jan의 기능을 사용자 지정하세요.

세부 운영 절차

- 모델 다운로드 및 관리::

- Jan 애플리케이션을 열고 모델 라이브러리로 이동합니다.

- 사용 가능한 모델을 찾아보고 '다운로드' 버튼을 클릭하여 다운로드하세요.

- 다운로드가 완료되면 해당 모델이 '다운로드됨' 목록에 표시됩니다.

- 모델을 선택하고 '실행' 버튼을 클릭하여 모델을 시작합니다.

- 로컬 API 서버 구성::

- '설정' 페이지로 이동하여 'API 서버' 옵션을 찾습니다.

- API 서버를 활성화하고 API 키를 설정합니다.

- 제공된 API 설명서를 사용하여 네이티브 API를 호출하여 개발을 시작하세요.

- 확장 플러그인 설치::

- 확장 프로그램 센터를 방문하여 사용 가능한 확장 프로그램을 찾아보세요.

- '설치' 버튼을 클릭하고 지시에 따라 설치를 완료합니다.

- 설치가 완료되면 확장 프로그램이 '설치됨' 목록에 표시됩니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...