요약 이 문서는 8200단어 이상이며 전체 내용을 읽는 데 약 15분 정도 소요됩니다. 이 백서에서는 지각 머신에서 딥 러닝에 이르는 최신 빅 모델 애플리케이션을 간략하게 살펴봅니다. ChatGPT 의 역사

원본: https://hutusi.com/articles/the-history-of-neural-networks

인생에서 두려워할 것은 없고 이해해야 할 것만 있을 뿐입니다.

-- 퀴리 부인

I 깊은 믿음 네트워크

2006년 캐나다 토론토 대학의 교수인 제프리 힌튼은 다층 신경망을 훈련하는 방법을 연구하던 중, 30년 이상 신경망 분야에서 묵묵히 연구해 온 인물로, 이 분야의 거목으로 꼽히지만 인공지능 업계에서 신경망이 저평가되어 그의 연구 성과는 업계에서 저평가되어 왔습니다.

영국 런던에서 태어난 힌튼의 가문은 수많은 저명한 학자를 배출했으며, 불 대수학을 창시한 논리학자 조지 불은 그의 증조부입니다. 그의 할아버지는 과학 작가였고 아버지는 곤충학자였습니다. 주변 사람들보다 똑똑했던 힌튼은 대학에서 건축학을 전공한 후 물리학, 철학을 공부하고 마침내 심리학 학사 학위를 취득하는 등 학교를 졸업하는 과정은 다소 험난했습니다. 1972년 힌튼은 당시 업계에서 가장 인기 있는 분야로 널리 알려진 신경망 박사 학위를 취득하기 위해 에든버러 대학교에 입학했습니다. 당시 신경망은 업계에서 경멸의 대상이었고, 힌튼의 지도교수조차도 신경망은 실용성이 거의 없고 미래가 없다고 생각했습니다. 하지만 힌튼은 이에 굴하지 않고 신경망 연구에 대한 믿음을 가지고 30년 넘게 신경망의 가치를 증명할 수 있다고 주장했습니다.

힌튼은 젊은 시절 히터를 옮기다가 허리에 디스크를 다쳤고 그 이후로 허리 통증으로 고생하고 있습니다. 최근 몇 년 동안 문제가 악화되어 대부분의 경우 통증을 완화하기 위해 누워 있어야 하기 때문에 운전을 하거나 비행기를 탈 수 없고, 심지어 연구실에서 학생들과 만날 때 사무실의 접이식 침대에 누워 있을 수도 없습니다. 시련으로 인한 육체적 고통은 학문적 연구에 대한 무관심만큼 힌튼에게 큰 타격을 주지는 못했습니다. 1969년 초, 민스키는 그의 저서 『지각 기계』에서 다층 지각 기계에 대한 법칙을 제시하며 "다층 지각 기계의 미래는 없을 것이다. 왜냐하면 전 세계 어느 누구도 다층 지각 기계를 충분히 잘 훈련시킬 수 없으며 심지어 가장 단순한 기능의 학습을 가능하게 할 수 없기 때문이다."라는 말로 이후의 신경망 연구에 도장을 찍어 버렸기 때문입니다. '이질성'과 같은 기본적인 분류 문제조차 해결하지 못하는 단층 퍼셉트론의 능력 한계와 다층 퍼셉트론을 위한 훈련 방법이 없다는 것은 신경망 연구의 방향이 막다른 길이라는 말과 다름없습니다. 신경망은 업계에서 학문적 이단으로 여겨졌고 아무도 신경망이 성공할 수 있다고 믿지 않았습니다. 따라서 학생들은 지도교수를 선택할 때 신경망을 우회하는 데 신중을 기했고, 한동안 Sinton은 대학원생을 충분히 모집하지도 못했습니다.

1983년 힌튼은 볼츠만 머신을 발명했고, 이후 단순화된 제한 볼츠만 머신은 머신러닝에 적용되어 심층 신경망의 계층적 구조의 기초가 되었습니다. 1986년에는 다층 지각 머신을 위한 오류 역전파 알고리즘(BP)을 제안하여 딥러닝의 기초를 마련하는 알고리즘을 만들었습니다. 힌튼은 매번 새로운 것을 발명했고, 비록 좋은 평가를 받지는 못했지만 200편 이상의 신경망 관련 논문을 꾸준히 썼습니다. 2006년까지 풍부한 이론적, 실용적 기반을 쌓은 힌튼은 이번에 머신 러닝 전체, 나아가 전 세계를 바꿀 논문을 발표했습니다.

Sinton은 여러 개의 숨겨진 레이어를 가진 신경망이 학습을 위한 특징을 자동으로 추출할 수 있어 수동으로 특징을 추출하는 기존 머신러닝보다 더 효과적이라는 사실을 발견했습니다. 또한 레이어별 사전 훈련을 통해 다층 신경망 훈련의 난이도를 낮출 수 있어 다층 신경망 훈련의 오랜 난제를 해결할 수 있습니다. 힌튼은 신경망이라는 용어가 많은 학술지 편집자들에 의해 거부당하고 일부 원고 제목에 '신경망'이라는 단어가 포함되어 반송되기도 했던 시기에 자신의 결과를 두 편의 논문으로 발표했습니다. 이러한 사람들의 민감성을 자극하지 않기 위해 힌튼은 새로운 이름을 붙이고 모델 이름을 "심층 신념 네트워크"(심층 신념 네트워크)라고 명명했습니다.

II. 센서

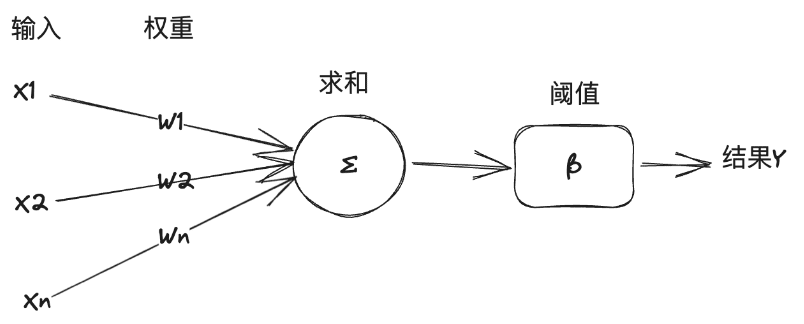

사실 신경망의 연구는 1940년대로 거슬러 올라가는데, 1940년 17세의 월터 피츠는 시카고 일리노이 대학의 42세 워렌 맥컬로크 교수를 만나 논리 연산을 기반으로 뇌의 기계적 모델을 구축하기 위해 뉴런 네트워크를 사용하려는 후자의 연구 프로젝트에 참여했습니다. 그들은 논리적 연산을 사용하여 인간 두뇌의 사고 모델을 추상화하여 "신경망"(신경망)이라는 개념을 제시했으며 뉴런은 신경망에서 가장 작은 정보 처리 단위이며 뉴런의 작동 과정을 매우 간단한 논리적 연산 모델로 추상화하고 단순화했으며 나중에 "M 이 모델은 두 사람의 이름 이니셜을 따서 'M-P 뉴런 모델'로 명명되었습니다.

이 모델에서 뉴런은 다른 뉴런으로부터 여러 입력 신호를 받고, 입력 신호의 중요도는 뉴런마다 다르며, 이는 연결의 '가중치'로 표현되며, 뉴런은 가중치에 따라 모든 입력을 합산하고 그 결과를 뉴런의 '임계값'과 비교하여 신호의 출력 여부를 결정합니다. 뉴런은 가중치에 따라 모든 입력을 합산하고 그 결과를 뉴런의 '임계값'과 비교하여 신호를 외부로 출력할지 여부를 결정합니다.

"M-P 모델"은 기호 논리로 모델링할 수 있을 만큼 간단하고 직관적이며, AI 전문가들은 이를 머신러닝 작업을 해결하기 위한 신경망 모델 구축의 기초로 사용해 왔습니다. 다음은 인공지능, 머신러닝, 딥러닝의 관계에 대한 간략한 설명입니다. 인공지능은 인간의 지능을 달성하기 위해 컴퓨터 기술을 사용하는 것으로, 일반 교과서에서는 지능형 에이전트의 연구 및 구축으로 정의합니다. 지능형 에이전트는 인간의 사고와 인지를 모방하여 특정 작업 또는 범용 작업을 해결하는 지능형 에이전트 또는 간단히 에이전트입니다. 특정 작업을 해결하는 지능형 에이전트를 약한 인공지능 또는 좁은 인공지능(ANI)이라고 하고 범용 작업을 해결하는 지능형 에이전트를 강한 인공지능 또는 범용 인공지능(AGI)이라고 합니다. 머신러닝은 데이터를 통해 학습하고 시스템을 개선하는 인공지능의 한 분야입니다. 반면 딥러닝은 머신러닝의 또 다른 분야로, 머신러닝에 신경망 기술을 사용합니다.

1957년 코넬 대학교의 심리학 교수였던 로젠블랫은 퍼셉트론이라고 부르는 신경망 모델을 IBM 컴퓨터로 시뮬레이션하고 구현했습니다. 그의 접근 방식은 머신 비전 패턴 인식 작업을 훈련하고 수행하는 데 사용할 수 있는 M-P 모델 뉴런 세트를 조합하는 것이었습니다. 일반적으로 머신 러닝에는 분류와 회귀라는 두 가지 종류의 작업이 있습니다. 분류는 이미지가 고양이인지 개인지 식별하는 것과 같이 데이터가 어떤 클래스에 속하는지를 결정하는 문제이며, 회귀는 이미지를 기반으로 사람의 체중을 예측하는 것과 같이 한 데이터에서 다른 데이터를 예측하는 문제입니다. 퍼셉트론은 선형 분류 문제를 해결합니다. 퍼셉트론 머신이 어떻게 작동하는지 "지능의 경계"라는 책에 나오는 예를 들어 설명해 보세요:

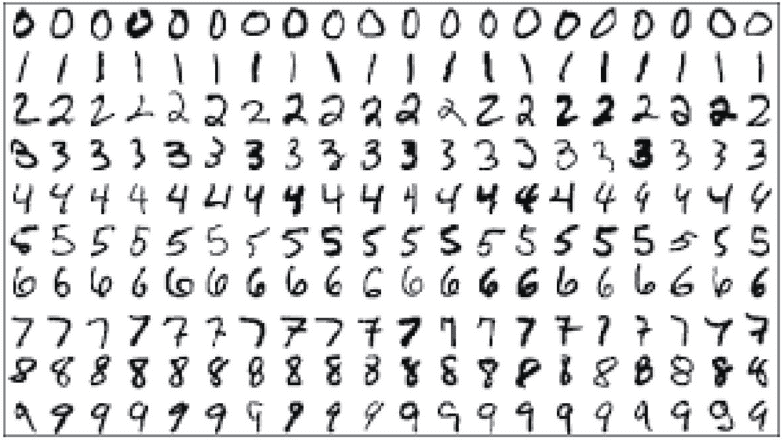

아라비아 숫자를 자동으로 인식하는 것이 작업 목표이고, 인식할 숫자는 손으로 쓰거나 다양한 형태로 인쇄된 숫자를 14*14픽셀 크기의 이미지 파일로 스캔하여 저장한다고 가정해 보겠습니다. 먼저 머신러닝을 위해 다음 그림과 유사한 훈련 집합을 준비합니다. 학습 세트는 컴퓨터 학습을 위해 특별히 제공되는 데이터 집합으로, 사진 및 기타 데이터의 집합일 뿐만 아니라 사진 데이터가 나타내는 숫자가 무엇인지 기계에 알려주기 위해 수동으로 사전 레이블이 지정됩니다.

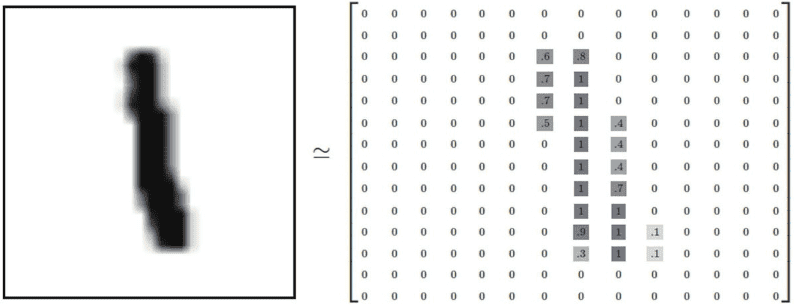

그런 다음 기계가 이러한 사진을 저장하고 처리할 수 있도록 데이터 구조를 설계해야 합니다. 14*14 그레이 스케일 디지털 사진의 경우 검은색 픽셀은 1로, 흰색 픽셀은 0으로 표현할 수 있으며, 검은색과 흰색 사이의 그레이 스케일 픽셀은 그레이 스케일 강도에 따라 0-1 사이의 부동 소수점 숫자로 표현할 수 있습니다. 이 그림에 대한 다음 그림과 같이 2차원 텐서 배열로 변환할 수 있습니다:

그리고 기계는 주로 특정 숫자를 나타내는 그림의 특징을 찾아내어 그림 속 숫자가 무엇인지 인식할 수 있습니다. 사람의 경우 손으로 쓴 숫자를 인식하는 것은 쉽지만 이러한 특징이 무엇인지 설명하기는 어렵습니다. 머신러닝의 목표는 학습 세트에서 숫자를 나타내는 이러한 그림의 특징을 추출하는 것이며, M-P 모델에 따르면 특징을 추출하는 방법은 그림의 개별 픽셀 값에 가중치를 부여하여 합산하고, 학습 세트의 샘플 그림과 주석 데이터 간의 대응 결과를 기반으로 각 숫자에 해당하는 각 픽셀의 가중치를 계산하여 특정 픽셀이 숫자에 속하지 않는다는 매우 부정적인 증거가 있는 경우 다음을 수행합니다. 특정 픽셀에 이미지가 특정 숫자에 속하지 않는다는 매우 부정적인 증거가 있는 경우 해당 픽셀의 가중치는 해당 숫자에 대해 음수 값으로 설정되고, 반대로 특정 픽셀에 이미지가 특정 숫자에 속한다는 매우 긍정적인 증거가 있는 경우 해당 픽셀의 가중치는 해당 숫자에 대해 양수 값으로 설정됩니다. 예를 들어 숫자 '0'의 경우 사진의 중간 지점에 검은색(1) 픽셀이 없어야 하는데, 만약 검은색 픽셀이 나타나면 부정적인 증거로 해당 사진이 숫자 0에 속할 확률이 줄어듭니다. 이러한 방식으로 데이터 세트의 훈련 및 보정 후 각 숫자 0-9에 해당하는 각 픽셀의 가중치 분포는 14*14(=196)로 구할 수 있습니다.

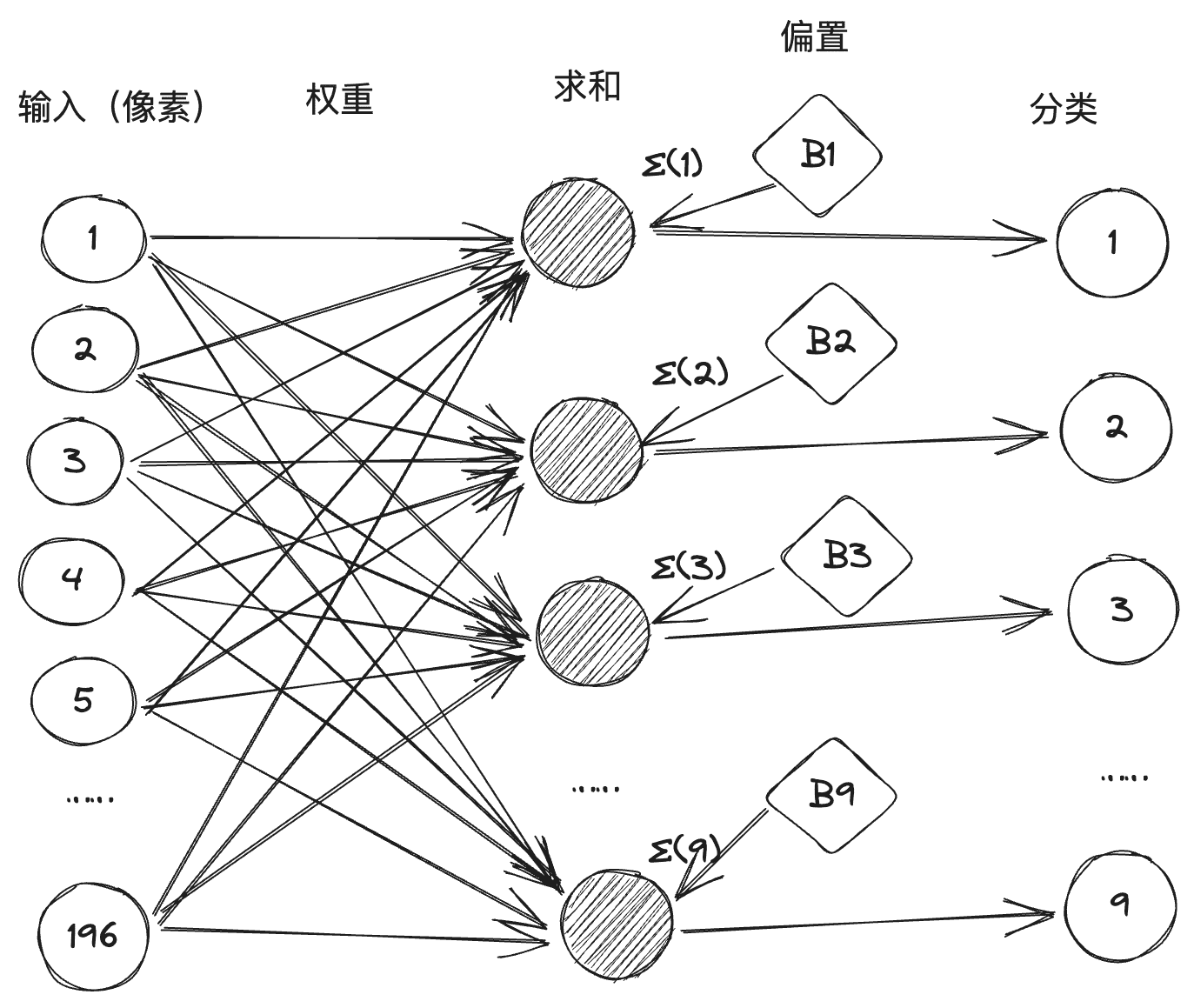

그런 다음 각 숫자의 분류 과정을 M-P 뉴런으로 변환하고, 각 뉴런에는 196개의 픽셀 입력이 있으며, 각 입력과 해당 뉴런 사이의 가중치 값은 학습을 통해 얻으므로 아래와 같이 10개 뉴런, 196개의 입력, 그 앞에 가중치가 있는 1,960개의 연결 선으로 구성된 신경망을 구성하게 됩니다(일반적으로 신경망에서 임계값은 다음과 같습니다. 는 산술 과정을 단순화하기 위해 합산 용어 중 하나인 바이어스 바이어스로 변환됩니다.)

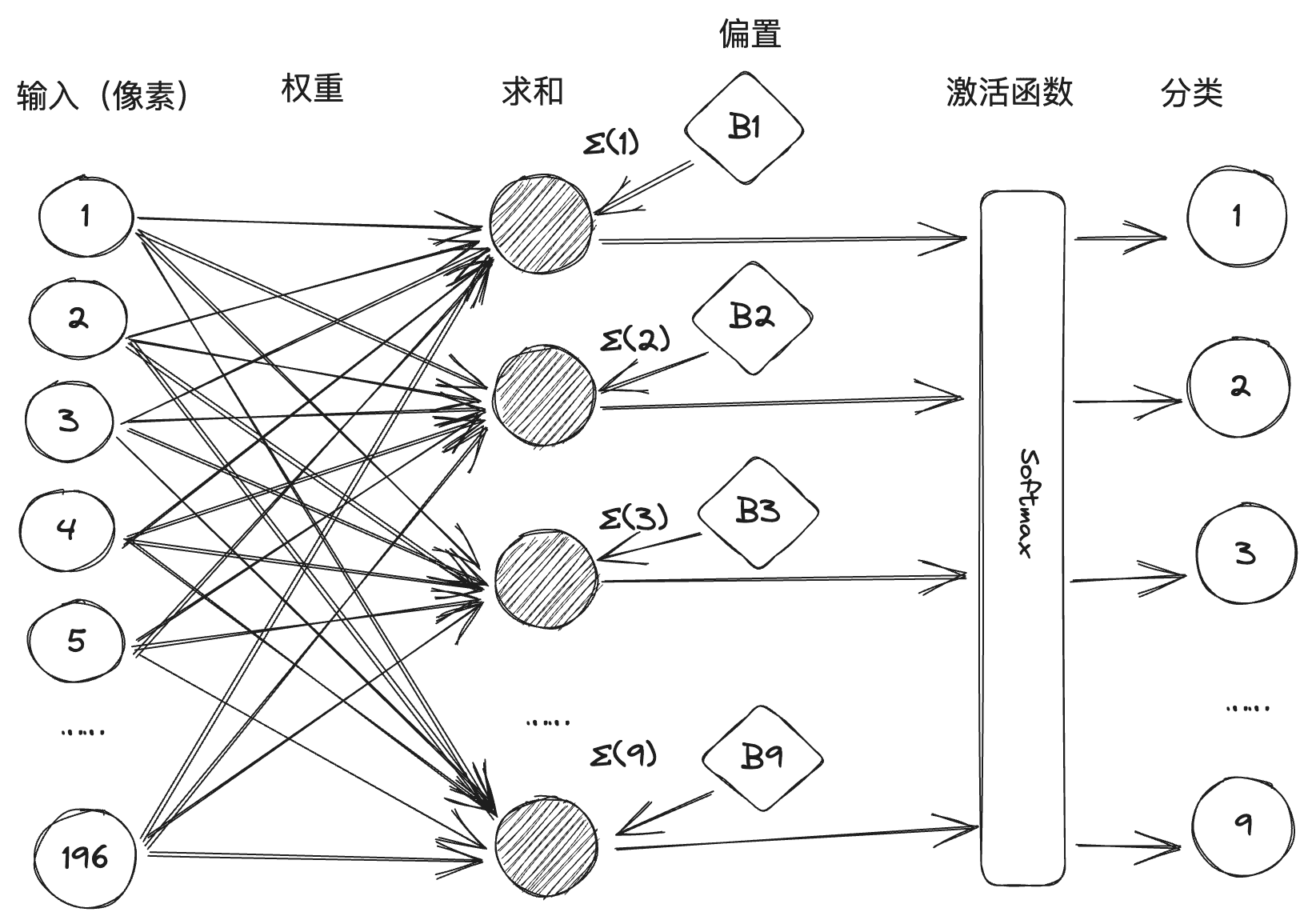

그러나 실제로는 일부 손글씨 폰트의 경우 가중 합산 후 두 개 이상의 뉴런이 활성화되는 모호한 부분이 있습니다. 따라서 지각 기계는 아래 그림과 같이 활성화 함수의 설계를 도입하여 구현되며, 소프트맥스는 활성화 함수로서 합산값을 처리하여 작은 확률로 숫자 분류를 억제하고 큰 확률로 숫자 분류를 강화합니다.

로젠 블랫은 2 년 후 세계 최초의 하드웨어 퍼셉트론 "마크 -1"을 만들었고, 퍼셉트론은 영어 알파벳을 식별 할 수 있지만 그 당시에는 큰 센세이션을 일으켰습니다. 미국 국방부와 해군 군대도 눈치 채고 많은 재정 지원을했고, 기계의 자신감에 대한 인식에 대한 로젠 블랫은 절정에 달했고, 심지어 기자가 "기계가 할 수없는 일에 대한 인식이 없다"고 물었을 때 로젠 블랫의 대답은 "사랑, 희망, 절망!"입니다. 로젠블랫의 대답은 "사랑, 희망, 절망"이었습니다. 로젠블랫의 명성이 높아지면서 그의 화려한 성격 때문에 곳곳에서 적을 만들었는데, 그 중 가장 유명한 사람은 인공지능의 또 다른 거물인 마빈 민스키였습니다. 민스키는 다트머스 컨퍼런스의 주최자이자 인공지능의 창시자 중 한 명으로, 1969년 지각 기계에 존재하는 결함을 명확히 규명한 저서 '지각 기계'를 출간했습니다. 첫 번째는 지각 기계가 이질적 확률과 같은 비선형 분류 문제를 처리할 수 없다는 것을 수학적으로 증명한 것이었고, 이어서 다층 지각 기계의 복잡성으로 인해 적절한 훈련 방법 없이 연결된 데이터가 급격히 확장된다는 것을 증명했습니다. 민스키는 이 책이 출간된 해에 네 번째 튜링상을 수상했고, 지각 기계에 대한 그의 판단에 대한 엄청난 명성으로 인해 신경망 연구는 사망선고를 받았습니다. 연결주의는 타격을 입었고 상징주의 연구가 AI의 주류가 되었습니다.

인공지능 분야에는 연결주의와 상징주의라는 두 가지 주요 학파가 있는데, 마치 무협 소설의 검파(劍派)와 제파(齊派)가 오랫동안 서로 경쟁해 온 것과 비슷합니다. 연결주의는 인간의 뇌를 모델링하여 신경망을 구축하고, 수많은 연결에 지식을 저장하고, 데이터를 기반으로 학습함으로써 AI를 발전시킵니다. 반면 상징주의는 지식과 추론이 기호와 규칙, 즉 수많은 '만약-그렇다면' 규칙 정의로 표현되어야 의사 결정과 추론이 가능하다고 보고 규칙과 논리에 기반한 AI를 개발합니다. 전자는 신경망으로, 후자는 전문가 시스템으로 대표됩니다.

III 딥 러닝

인식 기계의 실패로 AI 분야에 대한 정부 투자는 감소했고, AI는 첫 번째 겨울을 맞이했습니다. 그리고 1980년대에는 전문가 시스템으로 대표되는 상징주의가 AI의 주류가 되어 제2의 AI 물결을 일으켰고, 신경망 연구는 냉대 속에 방치되었습니다. 앞서 언급한 바와 같이, 아직도 그 맥을 이어가고 있는 사람은 단 한 명, 바로 제프리 힌튼입니다.

신톤은 전임자들을 바탕으로 볼츠만 기계와 오류 역전파 알고리즘을 연이어 발명했습니다. 1980년대부터 금세기 초까지 인공지능 분야의 주류는 여전히 지식 기반과 통계 분석이었지만, 신경망 분야에 대한 신톤의 선구적인 기여로 신경망 분야에 활기를 불어넣었고, 대표적인 예로 컨볼루션 신경망(CNN), 장단기 메모리(LSTM) 등 다양한 신경망 기술이 개발되기 시작했습니다. 네트워크(LSTM) 등이 대표적입니다. 2006년 힌튼은 딥러닝의 시대를 연 심층 신념 네트워크를 제안했습니다.

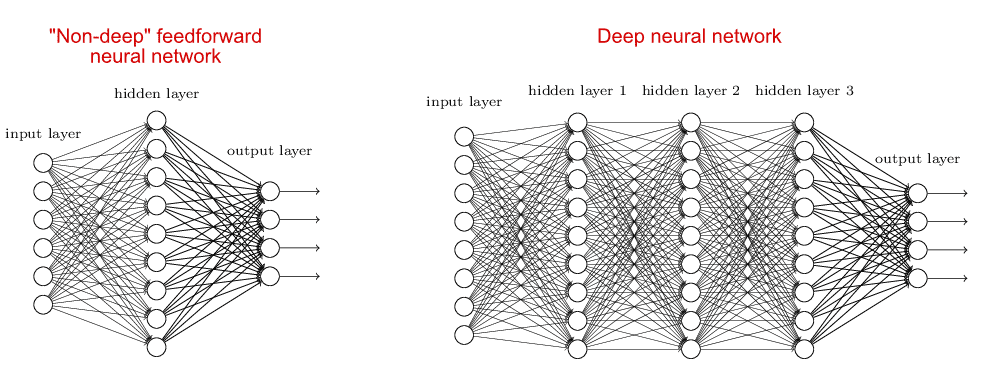

딥 러닝에 해당하는 신경망 모델을 심층 신경망이라고 하며, 이는 얕은 신경망에 상대적인 개념입니다. 얕은 신경망의 경우 일반적으로 하나의 숨겨진 계층(또는 중간 계층)과 입력 및 출력 계층이 더해져 총 3개의 계층으로 구성됩니다. 반면 심층 신경망은 두 가지 유형의 신경망과 비교하여 숨겨진 계층이 두 개 이상 있습니다:

딥러닝 이전에 사람들이 얕은 신경망에 집중했던 이유는 신경망 계층의 수가 증가하면 학습의 난이도가 높아지고, 한편으로는 충분한 연산 지원이 부족하며, 다른 한편으로는 마땅한 알고리즘이 없기 때문입니다. 힌튼이 제안한 심층 신념 네트워크는 오류 역전파 알고리즘을 사용하고 레이어별로 사전 학습함으로써 이러한 학습 문제를 해결합니다. 심층 신념 네트워크 이후 심층 신경망은 기계 학습의 주류 모델이 되었으며, 현재 널리 사용되는 GPT, Llama 및 기타 대형 모델은 하나 이상의 심층 신경망으로 구축됩니다.

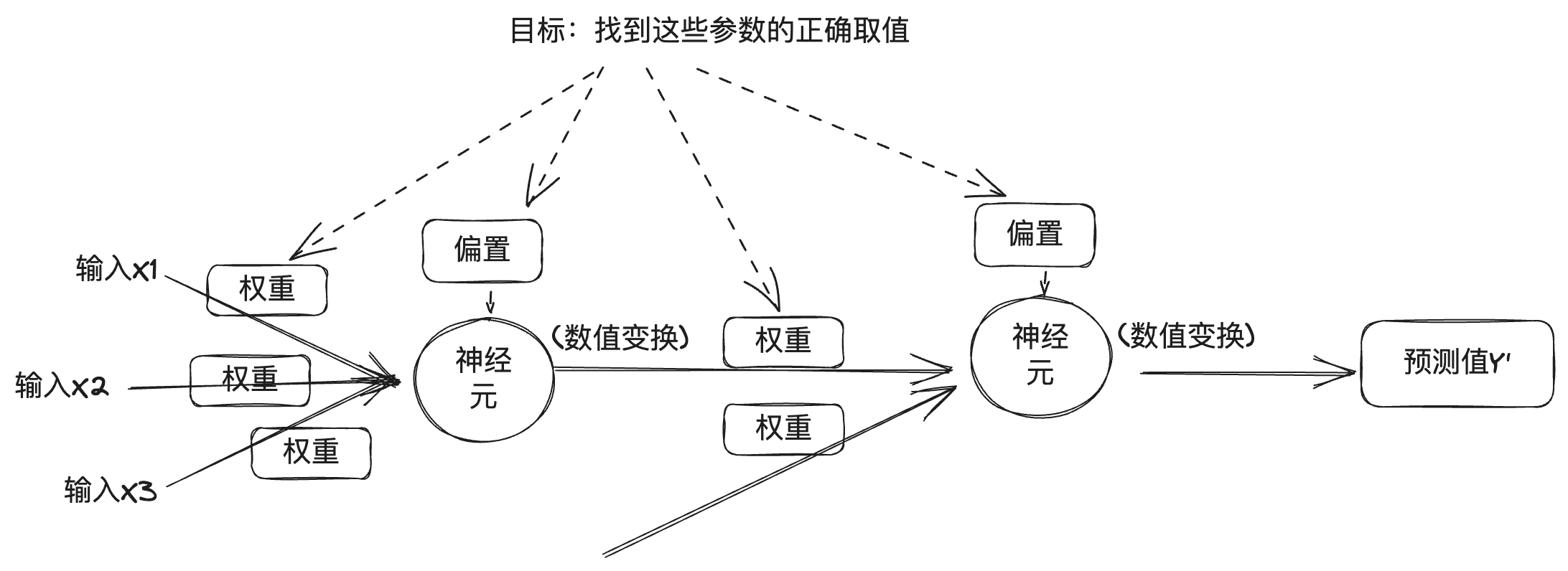

심층 신경망에 대한 이해를 위해 위의 지각 기계의 원리 소개를 참조 할 수 있으며, 심층 신경망은 여러 계층의 여러 뉴런의 조합으로 간주되며 이전 섹션에서 이해할 수 있으며 출력의 각 계층은 가중치, 바이어스 및 활성화 기능과 관련이 있으며 심층 신경망의 출력은 계층 수 및 기타 숫자 값과도 관련이 있습니다. 심층 신경망에서 이러한 값은 크게 두 가지로 나눌 수 있는데, 하나는 엔지니어가 설정하는 하이퍼파라미터로 알려진 레이어 수, 활성화 함수, 최적화기 등이고, 다른 하나는 심층 신경망의 학습 과정에서 자동으로 얻어지는 파라미터로 알려진 가중치와 바이어스이며, 올바른 파라미터를 찾는 것이 딥러닝의 목적입니다.

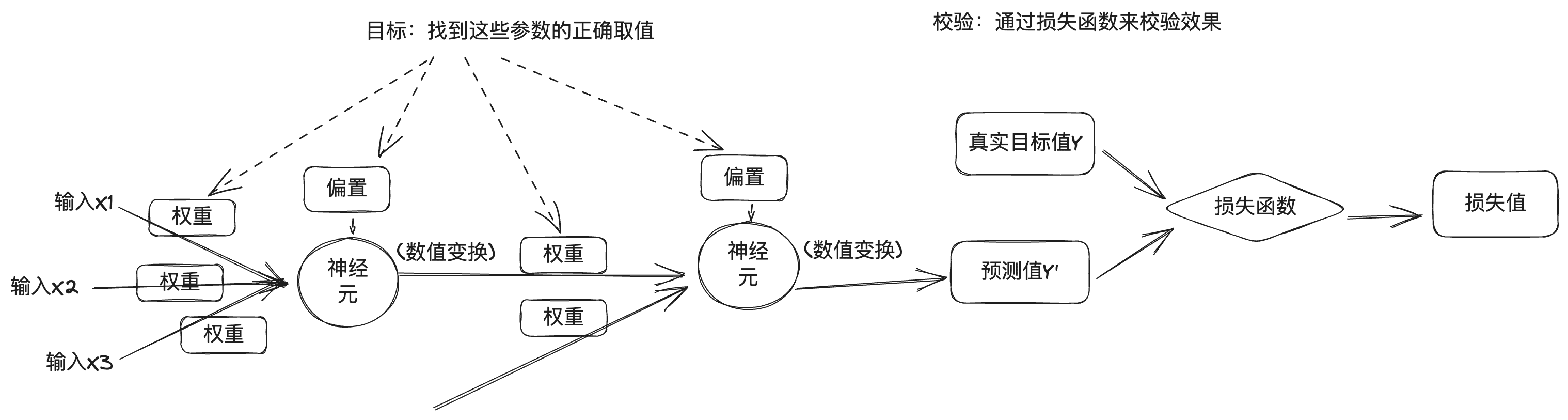

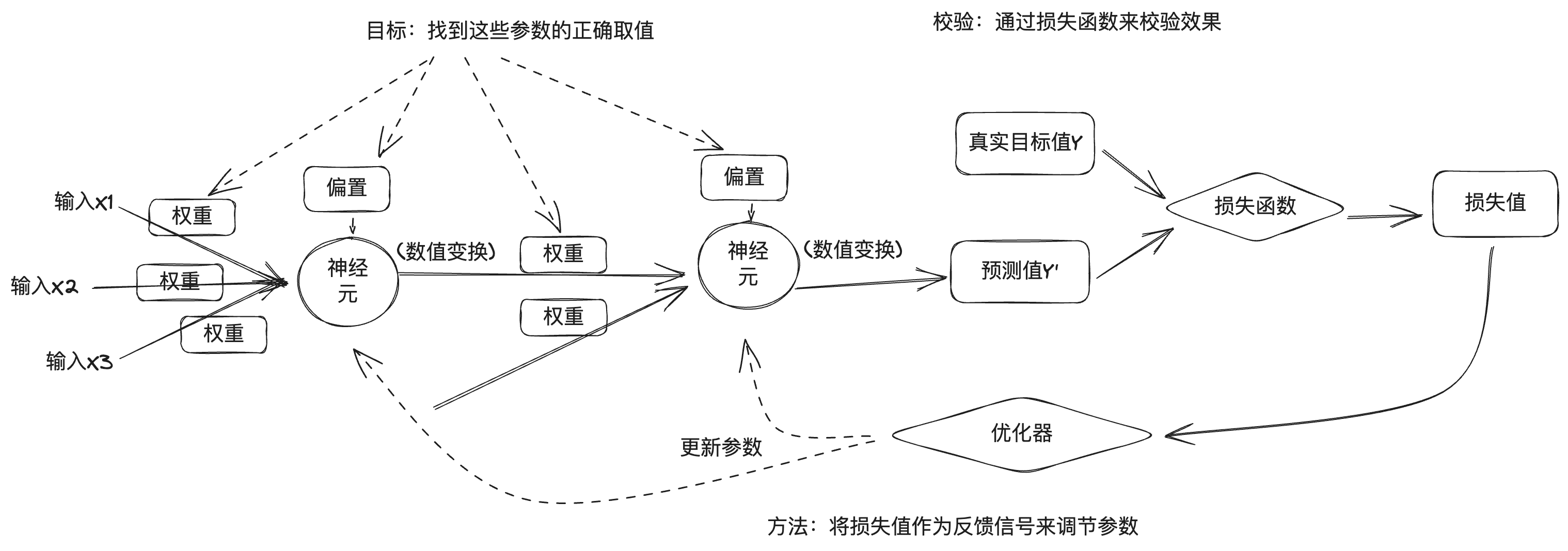

하지만 문제는 심층 신경망에는 수많은 매개변수가 포함되어 있고 하나의 매개변수를 수정하면 다른 매개변수의 동작에 영향을 미치기 때문에 이러한 매개변수의 올바른 값을 찾는 것은 어려운 작업이라는 것입니다. 파라미터의 정확한 값을 찾아서 모델을 정확하게 출력하려면 모델 출력과 원하는 출력 사이의 차이를 측정할 수 있는 방법이 필요합니다. 따라서 딥러닝 학습은 목적 함수 또는 비용 함수라고도 하는 손실 함수를 사용하여 측정합니다. 손실 함수는 딥 뉴럴 네트워크의 예측값과 실제 목표값을 비교하여 손실 값을 구함으로써 신경망 모델이 이 훈련 샘플에서 얼마나 잘 또는 잘못되었는지를 나타냅니다.

딥러닝 접근 방식은 손실 값을 피드백 신호로 사용해 현재 샘플 학습의 손실 값을 줄이기 위해 파라미터를 미세 조정합니다. 이 튜닝은 경사 하강과 같은 최적화 알고리즘을 구현하여 각 계층의 뉴런 노드 파라미터를 역전파를 통해 업데이트하는 옵티마이저를 통해 이루어집니다.

처음에 신경망의 파라미터를 무작위로 할당하고 학습 데이터를 일괄적으로 입력한 후 입력 계층과 숨겨진 계층을 거쳐 출력 계층까지 네트워크의 예측 출력을 얻은 후 순방향 전파 과정인 손실 함수에 따라 손실 값을 계산하고, 출력 계층에서 시작하여 각 계층을 따라 입력 계층까지 역방향으로 파라미터의 기울기를 계산하고 기울기를 기반으로 최적화 알고리즘을 사용하여 네트워크의 파라미터를 업데이트하는 역전파 과정입니다. . 신경망에 의해 처리되는 각 훈련 샘플 배치에서 매개 변수는 올바른 방향으로 미세 조정되고 손실 값은 감소하는데, 이것이 바로 훈련 주기입니다. 훈련 주기가 충분하면 손실 함수를 최소화하는 파라미터가 생성되어 좋은 신경망 모델이 만들어집니다.

물론 실제 딥러닝 프로세스는 이보다 훨씬 복잡하므로 여기서는 일반적인 프로세스에 대해 간략하게 설명합니다.

2012년, 힌튼은 학생 두 명인 알렉스 크리제프스키(Alex Krizhevsky)와 일리아 수츠케버(Ilya Sutskever)를 이끌고 이미지넷 이미지 인식 대회에 참가하여 2위보다 훨씬 높은 정확도로 우승을 차지한 AlexNet 신경망을 개발했습니다. 그 후 힌튼과 그의 학생들은 심층 신경망에 집중하기 위해 DNNResearch, Inc.를 설립했습니다. 이 회사에는 제품이나 자산이 없었지만 AlexNet의 성공에 여러 인터넷 대기업이 관심을 보였습니다. 2012년 겨울, 미국-캐나다 국경의 타호 호수에서 비밀 경매가 진행되었는데, 경매 대상은 최근 설립된 DNNResearch였으며 구매자는 구글, 마이크로소프트, 딥마인드, 바이두였습니다. 결국 구글과 바이두가 가격을 올리기 위해 입찰을 진행하던 중 힌튼은 경매를 취소하고 구글에 4400만 달러에 매각하기로 결정했습니다.2014년 구글은 딥마인드를 인수했고, 2016년에는 고전적인 몬테카를로 트리 검색과 심층 신경망을 결합한 알파고가 이세돌을 꺾고 이듬해에는 세계 바둑 랭킹 1위인 커제를 꺾으며 알파고는 인공지능의 경계를 넘어 인공 지능과 딥 러닝의 한계를 뛰어넘었습니다.

IV. 대형 모델

2015년, 머스크와 Stripe의 최고기술책임자 Greg Brockman, YC Ventures의 CEO인 Sam Altman과 Ilya Sutskever 등이 캘리포니아의 리즈우드 호텔에서 만나 대형 인터넷 기업의 AI 기술 통제에 대응하기 위한 AI 연구소를 설립하는 방안을 논의했습니다. 그 후 그렉 브록먼은 구글, 마이크로소프트 등의 연구원들을 영입하여 OpenAI라는 새로운 연구소를 설립하고 그렉 브록먼, 샘 알트만, 일리야 수츠케버가 각각 OpenAI의 회장, CEO, 수석 과학자를 맡게 되었습니다.

머스크와 샘 앨트먼은 원래 대형 인터넷 기업의 AI 기술 통제에 따른 위험에 대응하기 위해 모든 사람에게 AI 기술을 개방하는 비영리 단체인 OpenAI를 구상했습니다. 딥러닝 AI 기술이 폭발적으로 발전하고 있었기 때문에 이 기술이 미래에 인류에게 위협이 될지 아무도 예측할 수 없었고, 개방성이 이에 대응할 수 있는 최선의 방법일 수 있다고 생각했습니다. 그리고 2019년 말, OpenAI는 기술 개발 자금을 마련하기 위해 수익성 있는 자회사를 설립하고 핵심 기술을 오픈소스화하기로 결정했습니다.

2017년에 구글의 엔지니어들은 '주의력만 있으면 된다'라는 논문을 발표했는데, 이 논문에서 다음과 같이 제안했습니다. 트랜스포머 신경망 아키텍처는 신경망에 인간의 주의 메커니즘을 도입한 것이 특징입니다. 앞서 언급한 이미지 인식은 딥러닝의 시나리오로, 이미지 데이터는 서로 상관관계가 없는 불연속적인 데이터입니다. 실생활에서는 텍스트와 같이 시간적 데이터를 다루는 또 다른 시나리오가 있는데, 텍스트의 문맥이 연관되어 있고 음성, 비디오 등은 시간적 데이터입니다. 이렇게 시간적으로 정렬된 데이터를 시퀀스(순서)라고 하는데, 실제 작업은 중국어 문단을 영어 문단으로 번역하는 번역이나 질문 문단을 지능적으로 생성된 답변 문단으로 변환하는 로봇 Q&A와 같이 시퀀스를 다른 시퀀스로 변환하는 경우가 많기 때문에 트랜스포머라는 이름의 유래가 된 변환기(트랜스포머)를 사용하는 경우가 많습니다. 여기에서 트랜스포머라는 이름이 유래되었습니다. 앞서 언급했듯이 뉴런의 여기는 연결된 입력 데이터의 가중치 합계에 의해 결정되며, 가중치는 연결의 강도를 나타냅니다. 시계열 데이터의 경우 각 요소의 가중치가 달라지는데, 이는 다음 구절과 같이 우리의 일상 경험과 일치합니다:

연구에 따르면 한자의 순서가 항상 읽기에 영향을 미치는 것은 아니며, 예를 들어 이 문장을 다 읽었을 때 그 안에 있는 모든 문자가 엉망인 것을 발견할 수 있습니다.

이것은 한자뿐만 아니라 영어와 같은 다른 인간 언어에도 해당됩니다. 우리의 뇌가 문장에서 단어의 무게와 중복 정보를 자동으로 판단하여 초점을 잡기 때문에 이것이 주의력입니다. Google 엔지니어들은 자연어 처리에 사용되는 신경망 모델에 주의 메커니즘을 도입하여 기계가 인간 언어의 의도를 "이해"할 수 있도록했습니다. 이후 2018년에는 트랜스포머 아키텍처를 기반으로 한 GPT-1, 2019년에는 GPT-2, 2020년에는 GPT-3, 2022년 말에는 대화 능력 면에서 충격적인 GPT-3.5 기반의 ChatGPT AI Q&A 프로그램을 출시하며 AI는 AGI의 방향으로 큰 발걸음을 내디뎠습니다.

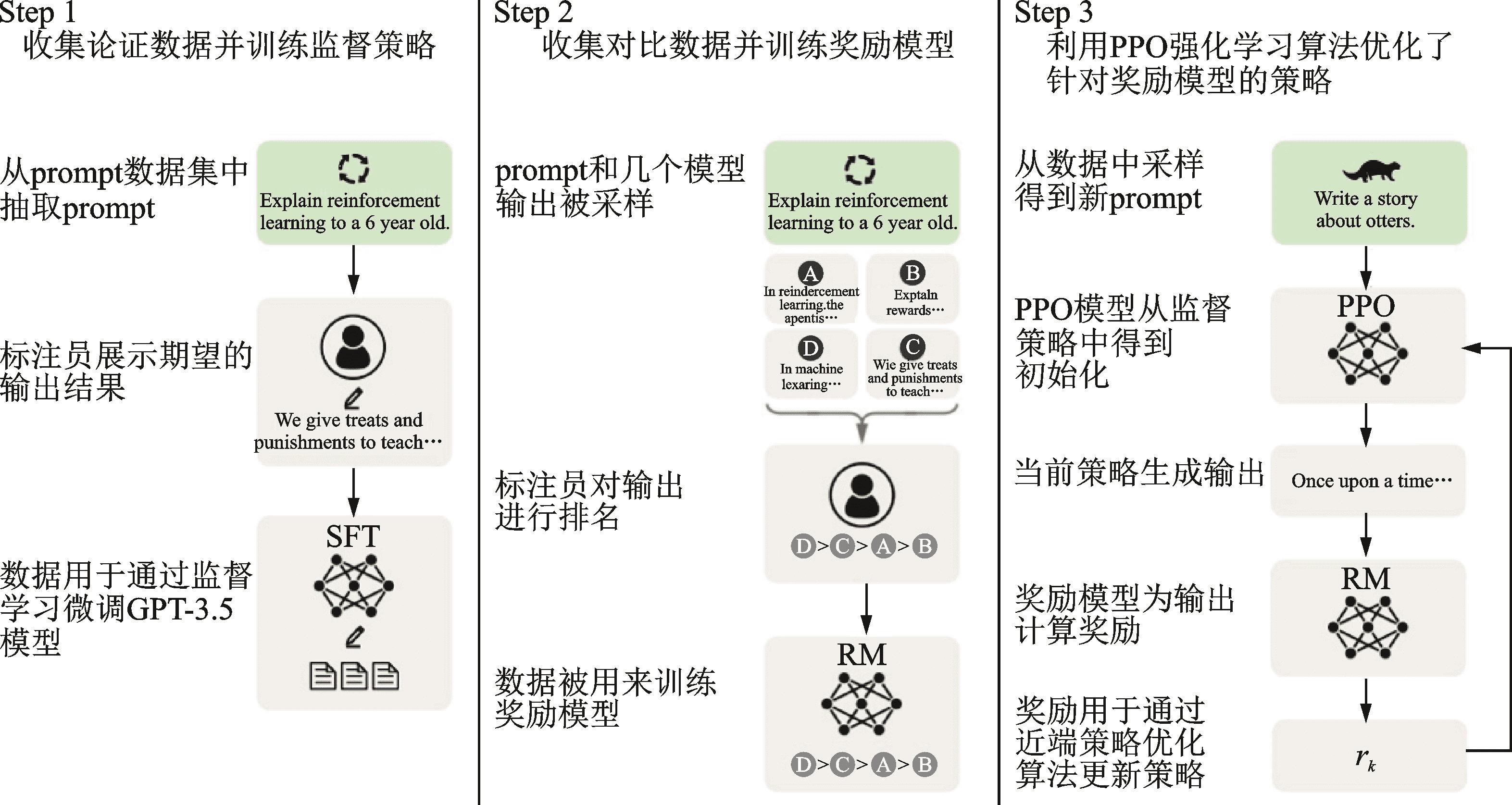

GPT의 정식 명칭은 Generative 사전 훈련형 트랜스포머로, Generative는 새로운 콘텐츠를 생성하는 능력을, Transformer는 인프라를, 가운데의 Pre-trained는 훈련 방식이 사전 훈련형임을 나타냅니다. 왜 사전 훈련이라고 하나요? 이는 AlexNet을 시작으로 사람들이 더 나은 결과를 얻기 위해 신경망 훈련에 더 큰 데이터와 더 많은 매개 변수를 사용하기 시작했고, 이는 훈련에 더 많은 자원과 시간이 소요된다는 것을 의미합니다. 이 비용은 특정 작업을 훈련하는 데 다소 비싸고 다른 신경망과 공유할 수 없기 때문에 다소 낭비적입니다. 따라서 업계에서는 신경망 모델을 훈련하기 위해 사전 훈련 + 미세 조정 접근 방식, 즉 먼저 더 큰 데이터 세트에서 일반적인 대규모 모델의 훈련을 완료한 다음 특정 작업 시나리오에 대해 더 작은 데이터 세트로 모델의 미세 조정을 완료하는 방식을 채택하기 시작했습니다. ChatGPT는 신경망 모델을 훈련하는 방법인 인간 피드백으로부터 강화 학습(RLHF)을 사용합니다. ChatGPT는 사전 학습 및 미세 조정을 위해 강화 학습(RLHF)을 사용하며, 이는 세 단계로 나뉩니다. 첫 번째 단계는 언어 모델(LM)을 사전 학습하고, 두 번째 단계는 Q&A 데이터를 수집하여 보상 모델(RM)을 학습하며, 세 번째 단계는 강화 학습(RL)으로 언어 모델(LM)을 미세 조정하는 단계로 이루어집니다. 이 보상 모델에는 사람의 피드백이 포함되어 있으므로 이 훈련 과정을 RLHF라고 합니다.

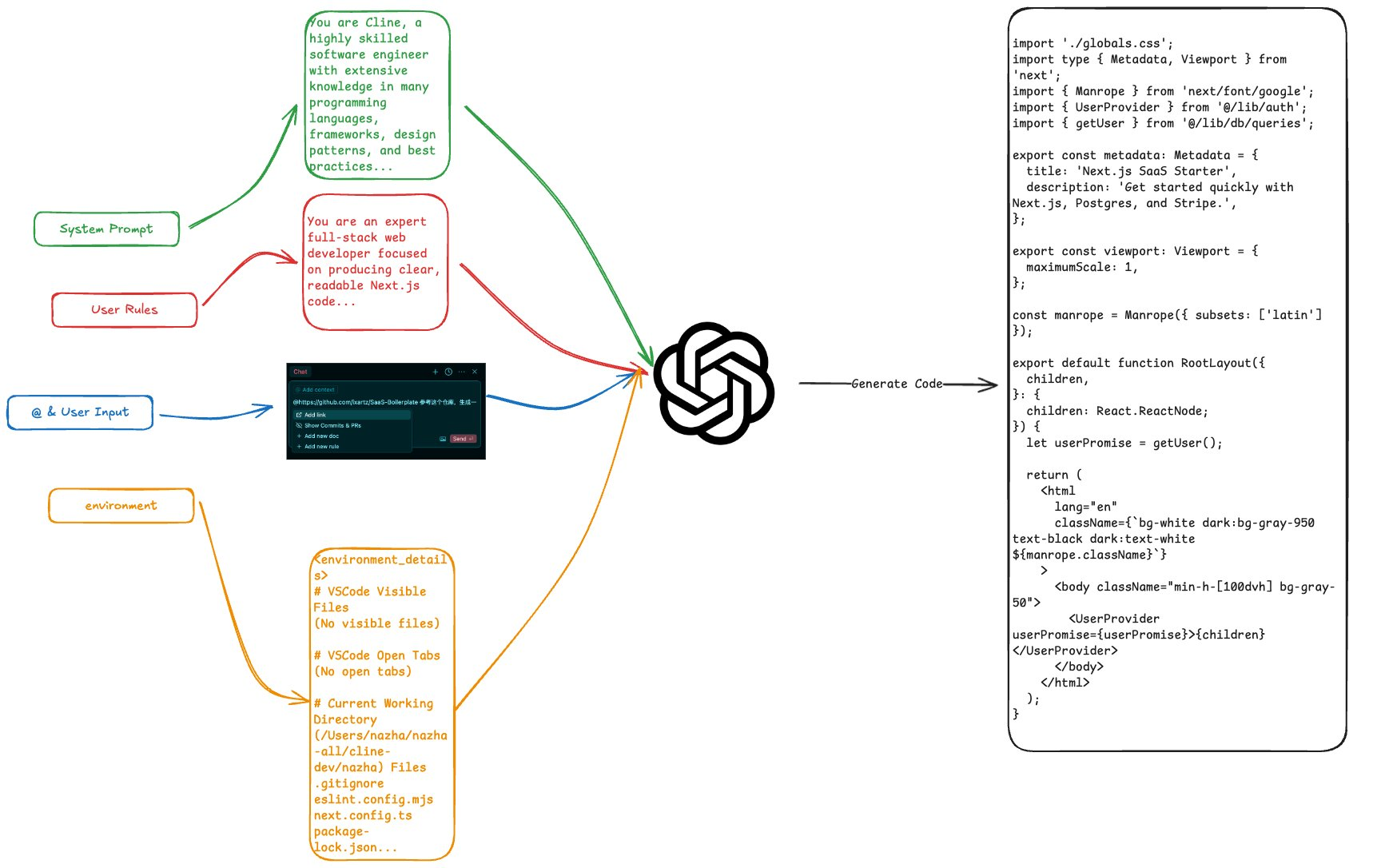

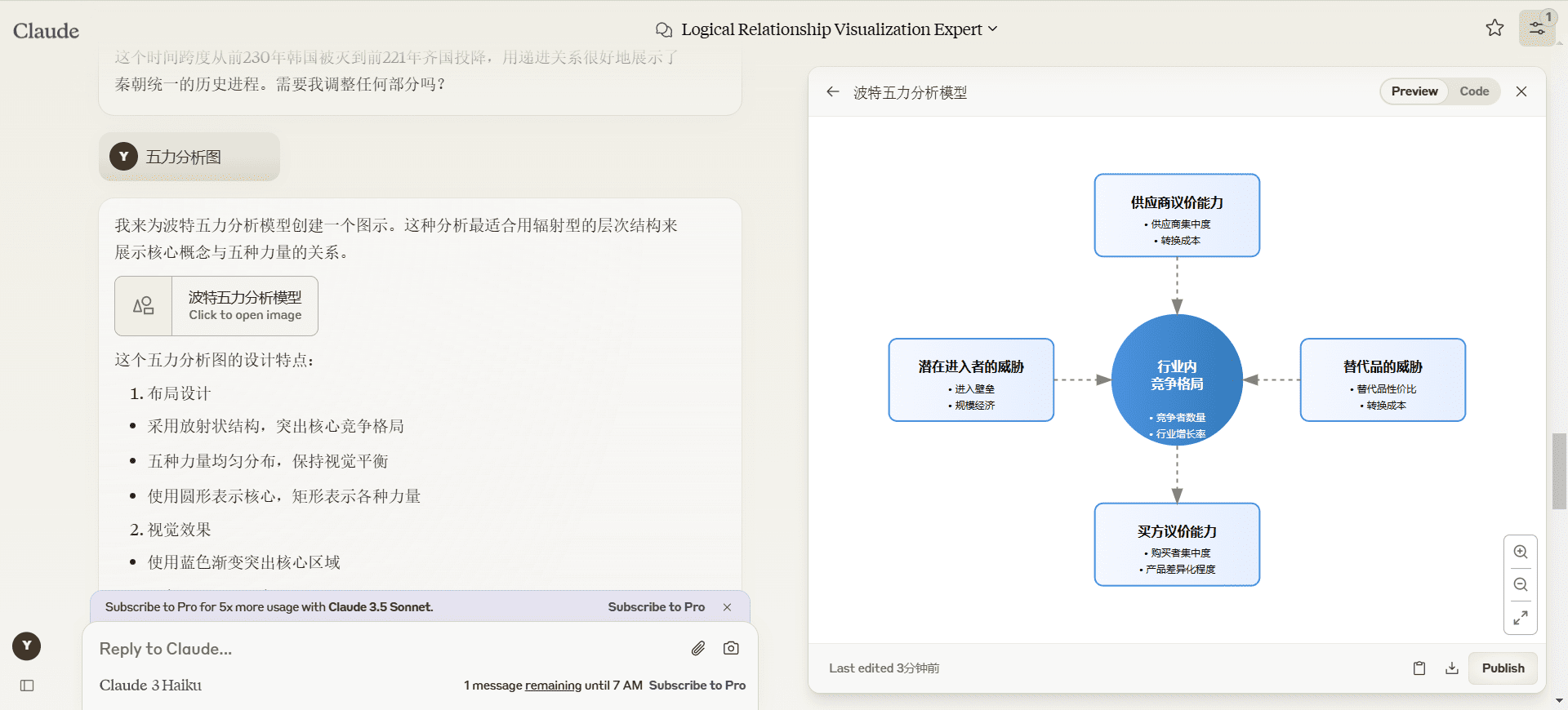

사용자들은 ChatGPT를 사용하는 동안 정확성뿐만 아니라 여러 차례의 대화가 가능한 기능에 깊은 인상을 받았습니다. 신경망의 기본 탐구에 따르면 각 추론 과정은 입력에서 각 뉴런의 가중치와 활성화를 통해 출력에 이르기까지 이루어지며 메모리 기능은 없습니다. 그리고 ChatGPT가 다자간 대화에서 잘 작동하는 이유는 대화 관리에서 프롬프트 엔지니어링의 기술을 사용하기 때문입니다.

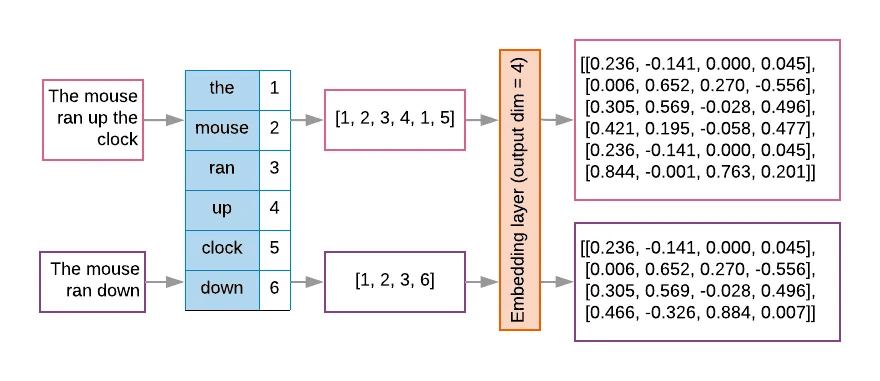

ChatGPT와 같은 대규모 언어 모델의 경우 입력은 텍스트 문자열을 변환한 후 토큰으로 변환되며, 대규모 모델은 일반적으로 계산 효율성과 메모리 제약으로 인해 입력 토큰 수를 제한하기 위해 고정 컨텍스트 창을 설계합니다. 다음 그림과 같이 텍스트는 먼저 토큰화기에 의해 세분화되고 조회 테이블에 의해 번호가 매겨진 다음 행렬에 임베드되어 고차원 공간 벡터로 변환되는데, 이것이 바로 텍스트 벡터화 과정입니다.

토큰 수에 제한이 있기 때문에 제한된 컨텍스트 창에서 더 큰 모델에 보다 포괄적인 정보를 전달하려면 프롬프트 엔지니어링 기법을 사용해야 합니다. 프롬프트 엔지니어링은 여러 가지 전략을 사용하여 모델 입력을 최적화함으로써 모델이 예상과 더 잘 일치하는 출력을 생성하도록 합니다.

ChatGPT의 성공 뒤에는 GPT로 대표되는 대규모 모델의 기술적 진화가 있습니다. OpenAI는 활발한 노력이 기적을 낳는다는 신념으로 GPT의 파라미터를 지속적으로 확장해 왔으며, GPT-1의 모델 파라미터는 1억 1,700만 개, GPT-2는 15억 개, GPT-3는 1,750억 개에 달하며 GPT-4의 모델 파라미터는 1조 8천억 개로 증가했다고 추정됩니다. 모델 파라미터가 많다는 것은 학습을 지원하는 컴퓨팅 파워가 많다는 것을 의미하며, OpenAI는 모델의 성능은 모델 크기, 데이터 볼륨 및 컴퓨팅 리소스와 관련이 있다는 '스케일링 법칙'을 요약하여 모델이 클수록, 데이터 볼륨이 클수록, 컴퓨팅 자원이 많을수록 모델의 성능이 향상된다는 것을 의미한다고 설명했습니다. 강화 학습의 아버지 인 리치 서튼은 최근 수십 년 동안 인공 지능의 발전을 검토 한 그의 기사 "쓴 교훈"에서 비슷한 견해를 표명하면서 단기적으로는 사람들이 항상 지식 구축을 통해 지능의 성능을 향상 시키려고 노력하고 있지만 장기적으로는 강력한 산술 능력이 왕이라는 결론을 내 렸습니다.

대형 모델의 능력도 양적 변화에서 질적 변화로 바뀌었고, 구글 수석 과학자 제프 딘은 이를 대형 모델의 '이머전트 능력'(이머전트 어빌리티)이라고 불렀습니다. 시장은 한편으로는 군비 경쟁에 대한 대형 모델 투자의 주요 공급 업체가이 기회를보고 있으며 다른 한편으로는 오픈 소스 생태계의 대형 모델도 본격화되고 있습니다.

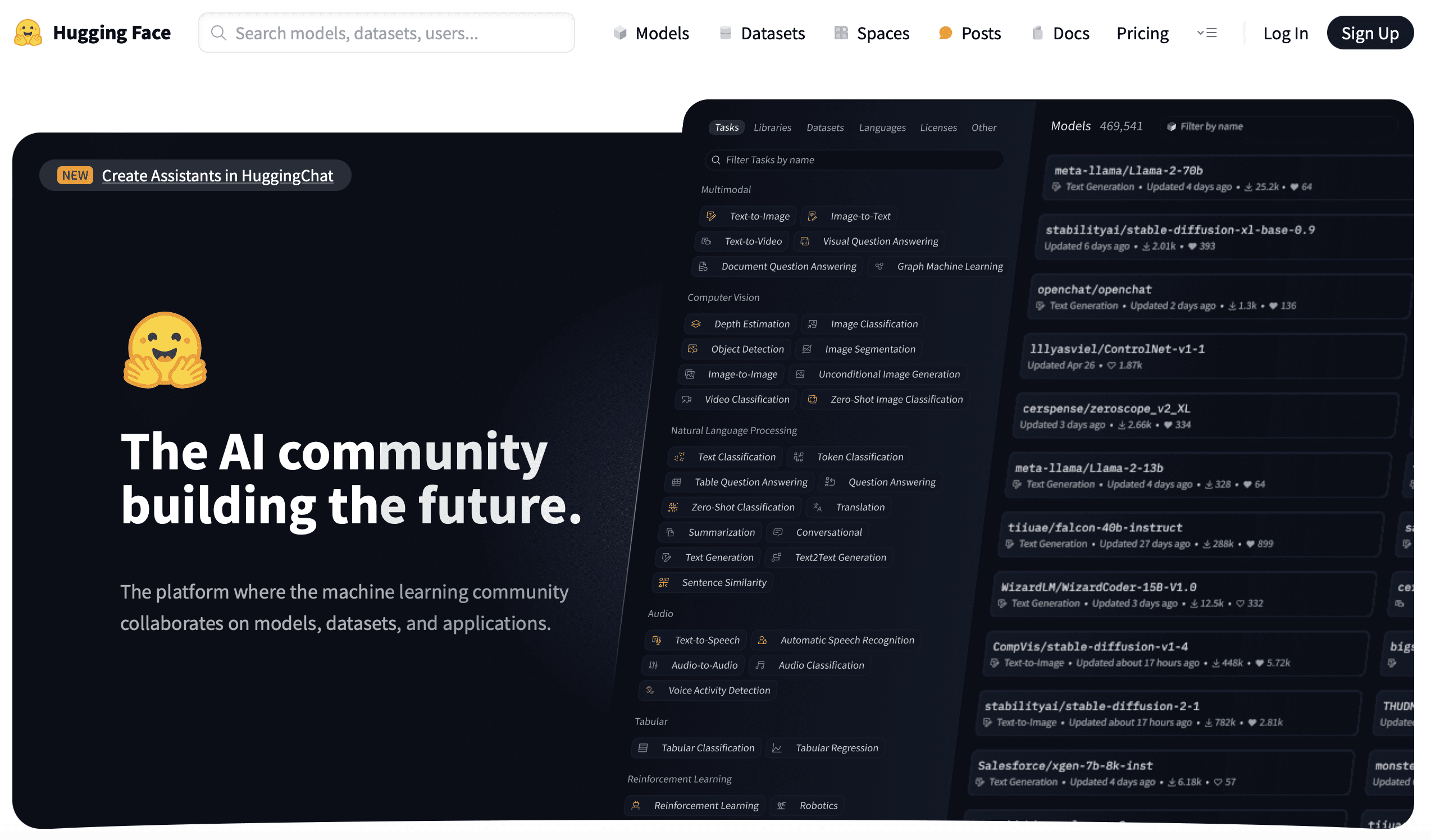

브이 포옹 얼굴

2016년 프랑스인 클레망 델랑그, 줄리앙 쇼몽, 토마스 울프는 이모티콘 아이콘을 로고로 삼아 Hugging Face라는 회사를 설립했습니다. 처음에는 청소년을 위한 지능형 챗봇을 개발하다가 모델 트레이닝 도구를 개발하여 오픈소스로 공개하고 모델을 훈련시키는 과정을 거쳤습니다. 이후 일부 모델 훈련 도구를 개발하여 오픈소스로 공개했고, 이후에는 '비전문적'으로 보이는 접근 방식인 후자로 초점을 전환하여 딥러닝 분야에서 새로운 길을 개척하고 필수적인 역할을 담당하게 되었습니다.

실리콘 밸리는 많은 회사가 성과를 내기 위해 부업을하고 있습니다. 예를 들어 Slack은 원래 게임을 개발했고 회사 팀은 여러 곳에 분산되어 있으며 운영 과정에서 커뮤니케이션 도구를 개발하는 과정에서 우발적 인 화재, 즉 Slack이 발생했습니다. 그리고 Hugging Face의 차례도 비슷하지만 자체 문제점을 해결하기 위해 2018 년 Google은 큰 모델 BERT를 출시하고 Hugging. Face 직원들은 자신들에게 익숙한 파이토치 프레임워크를 사용해 BERT를 구현하고 모델 이름을 파이토치-프리트레이닝-버트로 명명해 깃허브에 오픈소스화했고, 이후 커뮤니티의 도움으로 GPT, GPT-2, 트랜스포머-XL 등의 모델 그룹이 소개되면서 프로젝트의 이름도 변경되었습니다. 딥러닝 분야는 파이토치와 텐서플로우라는 두 프레임워크가 경쟁하고 있는데, 연구자들이 두 프레임워크의 장단점을 비교하기 위해 두 프레임워크를 전환하는 경우가 많아 오픈소스 프로젝트에 두 프레임워크 간 전환 기능을 추가하고 프로젝트 이름도 트랜스포머로 변경하게 된 것입니다. 트랜스포머는 현재 깃허브에서 가장 빠르게 성장하고 있는 프로젝트이기도 합니다.

허깅 페이스는 데이터세트, 토큰화 도구, 디퓨저 등 일련의 다른 머신러닝 도구를 지속적으로 개발하고 오픈소스화하고 있습니다. ...... 이러한 도구는 AI 개발 프로세스를 표준화하는데, 허깅 페이스 이전에는 AI 개발이 연구자들에 의해 주도되었다고 할 수 있습니다. 허깅 페이스 이전에는 표준화된 엔지니어링 접근 방식 없이 연구자들이 AI 개발을 주도했다고 할 수 있습니다. 허깅 페이스는 포괄적인 AI 툴셋을 제공하고 사실상의 표준을 확립하여 더 많은 AI 개발자와 비전문가도 빠르게 시작하고 모델을 훈련할 수 있게 해줍니다.

그 후 허깅 페이스는 Git 및 Git LFS 기술을 기반으로 모델, 데이터세트, AI 애플리케이션을 호스팅하는 허깅 페이스 허브를 출시했으며, 지금까지 35만 개의 모델, 75,000개의 데이터세트, 150,000개의 샘플 AI 애플리케이션이 플랫폼에 호스팅되었습니다. 모델과 데이터세트를 호스팅하고 오픈소스화하고 글로벌 오픈소스 리포지토리 센터를 구축하는 작업은 혁신적이고 광범위합니다. 위에서 언급한 사전 훈련 + 미세 조정 접근 방식이 신경망 훈련 리소스의 공유를 촉진했다면, 허깅 페이스 허브는 한 걸음 더 나아가 AI 개발자가 전 세계의 최첨단 결과를 쉽게 재사용하고 추가할 수 있도록 함으로써 누구나 AI를 사용하고 개발할 수 있는 AI의 민주화를 실현합니다. 깃허브의 슬로건처럼 미래의 AI 커뮤니티를 구축합니다. 저는 이전에 두 개의 기사를 작성한 적이 있습니다.세상을 바꾼 코드 커밋Git을 소개합니다.0에서 100억 달러로 가는 길깃허브와 깃, 깃허브와 포옹하는 얼굴, 이 둘 사이에는 일종의 유산, 즉 미래를 만들기 위해 세상을 변화시키는 해킹의 유산이 있다고 생각하며, 이것이 제가 이 글을 쓰게 된 계기 중 하나라고 생각합니다.

VI. 포스트 스크립트

이 글을 거의 마무리할 무렵, 저는 최근 Hinton이 옥스퍼드 대학에서 한 강연을 시청했습니다. 이 강연에서 힌튼은 인공지능 분야의 두 가지 주요 학파를 소개했는데, 하나는 논리적 접근법, 즉 상징주의이고 다른 하나는 인간의 뇌를 모방하는 생물학적 접근법, 즉 신경망 연결주의입니다. 그리고 생물학적 접근 방식이 논리적 접근 방식보다 확실한 승자임을 입증했습니다. 신경망은 인간 두뇌의 이해를 모방하도록 설계된 모델로, 대규모 모델은 두뇌처럼 작동하고 이해합니다. 힌튼은 인간의 두뇌를 뛰어넘는 인공 지능이 미래에, 그것도 우리가 예측하는 것보다 훨씬 빨리 등장할 것이라고 믿습니다.

첨부 1 사건 연표

1943년 맥컬로크와 피츠는 수학적 논리를 사용해 인간 두뇌의 계산 단위를 설명하고 시뮬레이션하는 'M-P 뉴런 모델'을 발표하고 신경망의 개념을 도입했습니다.

'인공 지능'이라는 용어는 1956년 다트머스 컨퍼런스에서 처음 사용되었습니다.

1957년 로젠블랫은 '퍼셉트론' 모델을 제안했고, 2년 후 영어 알파벳을 인식할 수 있는 하드웨어 퍼셉트론인 마크-1을 만드는 데 성공했습니다.

1969년 민스키는 『지각 기계』를 출간했고, 이 책에서 지적한 지각 기계의 결함은 지각 기계와 신경망 연구에 큰 타격을 주었습니다.

1983년 힌튼은 볼츠만 기계를 발명했습니다.

1986년 힌튼은 오류 역전파 알고리즘을 발명했습니다.

1989년, 얀 르쿤은 컨볼루션 신경망(CNN)을 발명했습니다.

2006년 힌튼은 딥 러닝의 시대를 여는 딥 빌리프 네트워크를 제안했습니다.

2012년 힌튼과 그의 제자 두 명이 설계한 AlexNet이 이미지넷 대회에서 압도적인 차이로 우승하면서 딥러닝은 업계에서 본격적으로 주목받기 시작했습니다.

2015년 구글이 인수한 딥마인드는 2016년 이세돌 9단을, 2017년 커제 9단을 꺾은 알파고를 출시했고, 오픈AI를 설립했습니다.

허깅 페이스는 2016년에 설립되었습니다.

2017년, 구글은 트랜스포머 모델 논문을 발표했습니다.

2018년, OpenAI는 트랜스포머 아키텍처를 기반으로 한 GPT-1을 출시했고, Hugging Face는 트랜스포머 프로젝트를 발표했습니다.

2019년, OpenAI는 GPT-2를 출시합니다.

2020년, OpenAI는 GPT-3를 출시합니다. 허깅 페이스는 허깅 페이스 허브를 출시합니다.

2022년, OpenAI는 ChatGPT를 출시합니다.

부록 2 참고 자료

도서:

지능의 경계: 튜링 머신에서 인공 지능으로 저우 지밍(저자) 기계 산업 보도 2018년 10월

딥 러닝 혁명 Cade Metz 슈광 두 CITIC Press 2023년 1월호

파이썬 딥 러닝(2판) 프랑수아 콜레(저자) 리앙 장(역자) 인민출판사 2022년 8월 출간

딥러닝 입문: 파이썬을 기반으로 한 이론과 구현 사이토 야스이(저자) 유지에 루(역자) 인민출판사 2018

딥러닝 고급: 자연어 처리 사이토 야스요시(저자) 루 유지에(역자) 인민출판사 2020년 10월 출간

이것은 ChatGPT 스티븐 울프람 (저자) 울프람 미디어 중국어 그룹 (번역자) 인민 포스트 통신 출판사 2023년 7월입니다.

생성적 인공 지능 Ding Lei (저자) CITIC Press 2023년 5월 발행

리 풀린(저자)이 설명하는 허깅페이스 자연어 처리 칭화대학교 출판부 2023년 4월 출간

Article:

이펑 응우옌의 신경망 소개

2012년, 인류의 운명을 바꾼 180일" 엔카와 연구소

GPT 제품군 진화 메타포스트

트랜스포머 - 관심만 있으면 됩니다".

사전 학습된 언어 모델 개발.

프롬프트 엔지니어링 가이드

"크레딧" 뒤에 숨은 ChatGPT - RLHF 기술에 대한 자세한 설명입니다.

ChatGPT 대규모 모델링 기법의 개발 및 적용.

쓰라린 교훈, 리치 서튼.

허깅페이스 CTO와의 인터뷰: 오픈소스의 부상, 스타트업 사례, 그리고 AI의 민주화".

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...