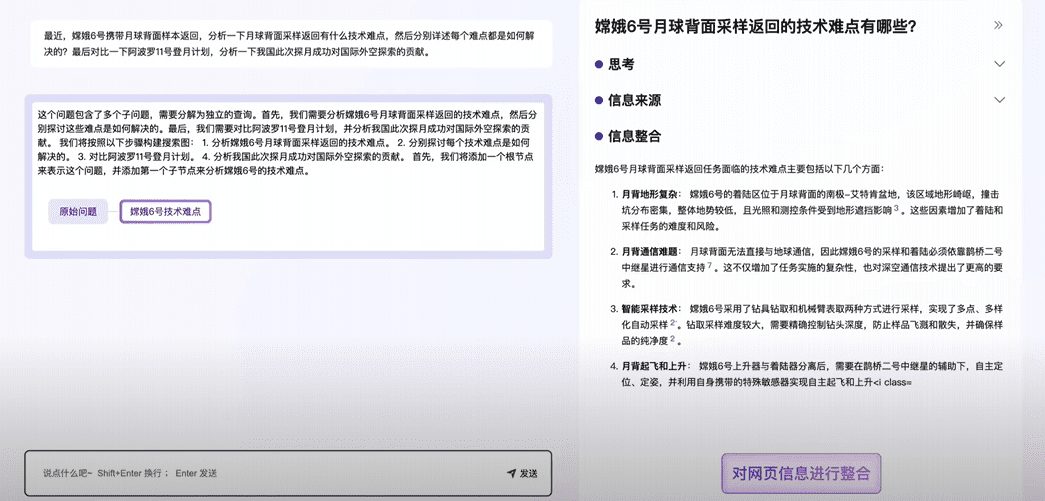

일반 소개

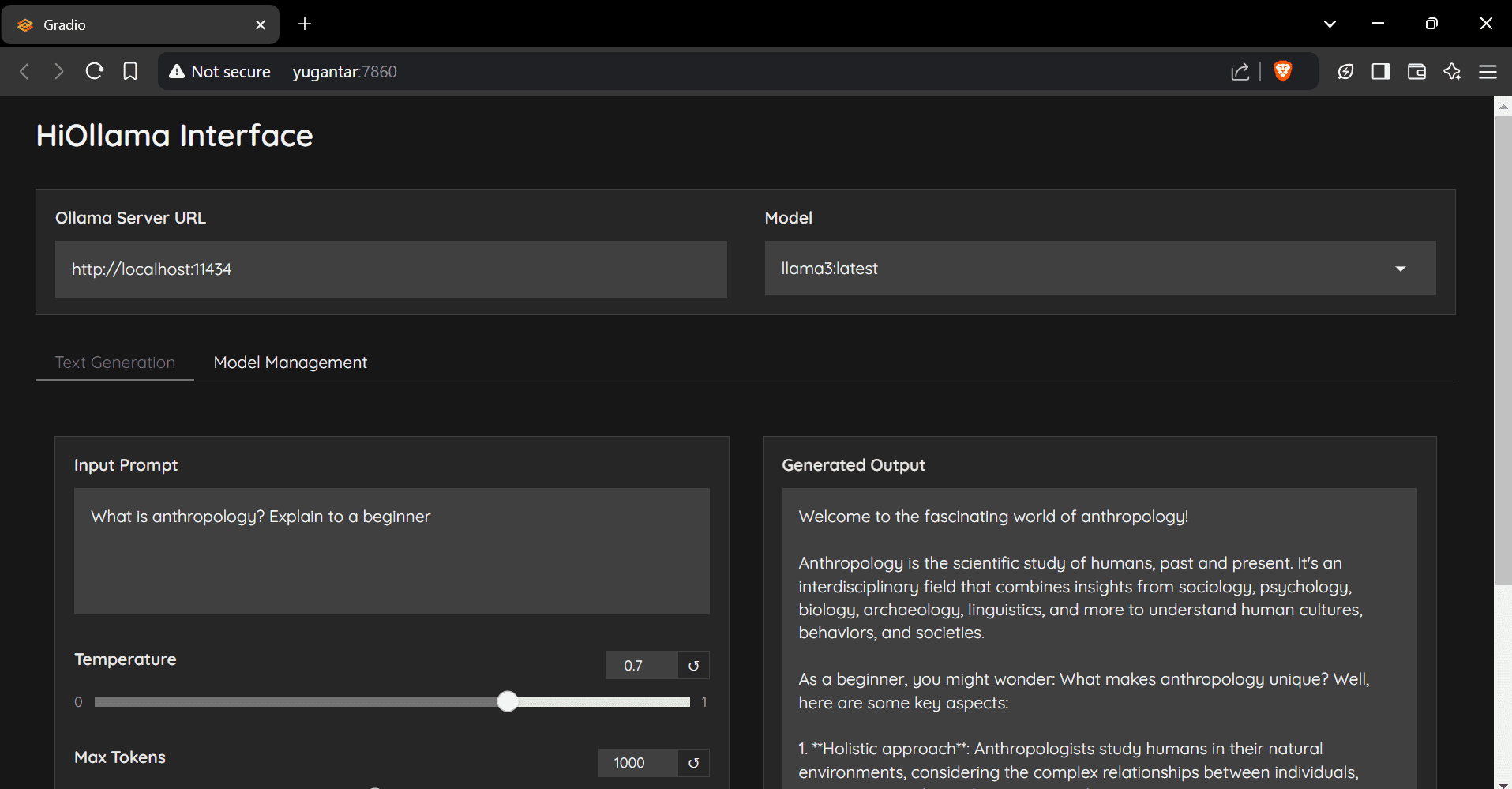

HiOllama는 Ollama 모델과 상호 작용하도록 설계된 Python 및 Gradio 기반의 사용자 친화적인 인터페이스입니다. 실시간 텍스트 생성 및 모델 관리 기능을 지원하는 간단하고 직관적인 웹 인터페이스를 제공합니다. 사용자는 온도 및 최대 토큰 수와 같은 매개변수를 조정할 수 있으며, 여러 개의 올라마 모델 관리 및 사용자 지정 서버 URL 구성을 지원합니다.

추천: 올라마 vs. WebUI 열기 통합이 더 친숙하지만 배포 비용이 약간 더 높습니다.

기능 목록

- 간단하고 직관적인 웹 인터페이스

- 실시간 텍스트 생성

- 조정 가능한 매개변수(온도, 최대 토큰 수)

- 모델 관리 기능

- 여러 올라마 모델 지원

- 사용자 지정 서버 URL 구성

도움말 사용

설치 단계

- 복제 창고:

git clone https://github.com/smaranjitghose/HiOllama.git cd HiOllama - 가상 환경을 만들고 활성화합니다:

- Windows.

python -m venv env .\env\Scripts\activate - Linux/Mac.

python3 -m venv env source env/bin/activate

- Windows.

- 필요한 패키지를 설치합니다:

pip install -r requirements.txt - Ollama를 설치합니다(아직 설치하지 않은 경우):

- Linux/Mac.

curl -fsSL https://ollama.ai/install.sh | sh - Windows.

먼저 WSL2를 설치한 다음 위의 명령을 실행합니다.

- Linux/Mac.

사용 단계

- 올라마 서비스를 시작합니다:

ollama serve - HiOllama를 실행합니다:

python main.py - 브라우저를 열고 다음으로 이동합니다:

http://localhost:7860

빠른 시작 가이드

- 드롭다운 메뉴에서 모델을 선택합니다.

- 텍스트 영역에 프롬프트를 입력합니다.

- 필요에 따라 온도와 최대 토큰 수를 조정합니다.

- '생성'을 클릭하여 응답을 받습니다.

- 모델 관리 옵션을 사용하여 새 모델을 가져올 수 있습니다.

구성

기본 설정은main.py수정됨:

DEFAULT_OLLAMA_URL = "http://localhost:11434"

DEFAULT_MODEL_NAME = "llama3"

일반적인 문제

- 연결 오류Ollama가 실행 중인지 확인합니다(

ollama serve), 서버 URL이 올바른지 확인하고 포트 11434에 액세스할 수 있는지 확인합니다. - 모델을 찾을 수 없음모델을 먼저 당깁니다:

ollama pull model_name를 클릭하고 사용 가능한 모델을 확인하세요:ollama list. - 포트 충돌: in

main.py포트 변경app.launch(server_port=7860) # 更改为其他端口

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...