일반 소개

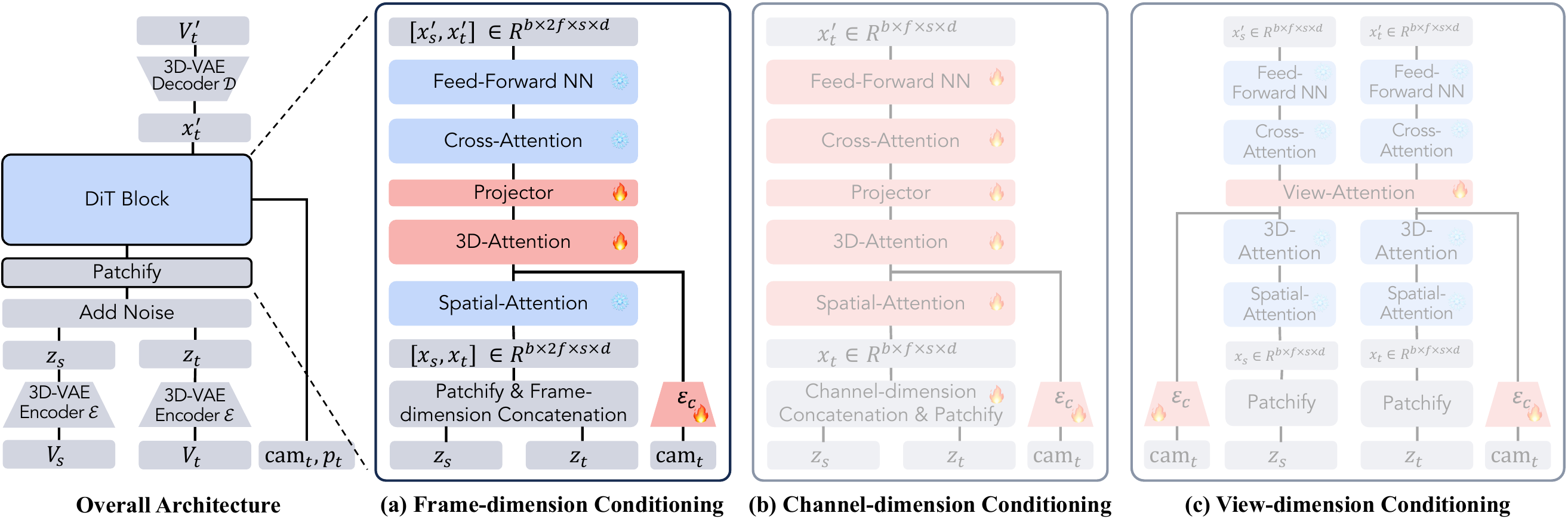

히비키는 규타이 랩에서 개발한 고충실도 실시간 음성 번역 모델입니다. 기존의 오프라인 번역기와 달리 히비키는 대상 언어로 자연스러운 음성 번역을 생성하고 사용자가 말하는 대로 실시간으로 텍스트 번역을 제공합니다. 이 모델은 입력 음성 스트림을 동시에 처리하고 대상 음성을 생성하는 다중 스트림 아키텍처를 채택하여 일관되고 정확한 번역을 보장하며, 지도 학습을 통해 소스 및 대상 음성과 텍스트를 정렬하고 합성 데이터 생성 기술을 활용하여 제한된 실제 데이터로 고품질 번역을 보장합니다.

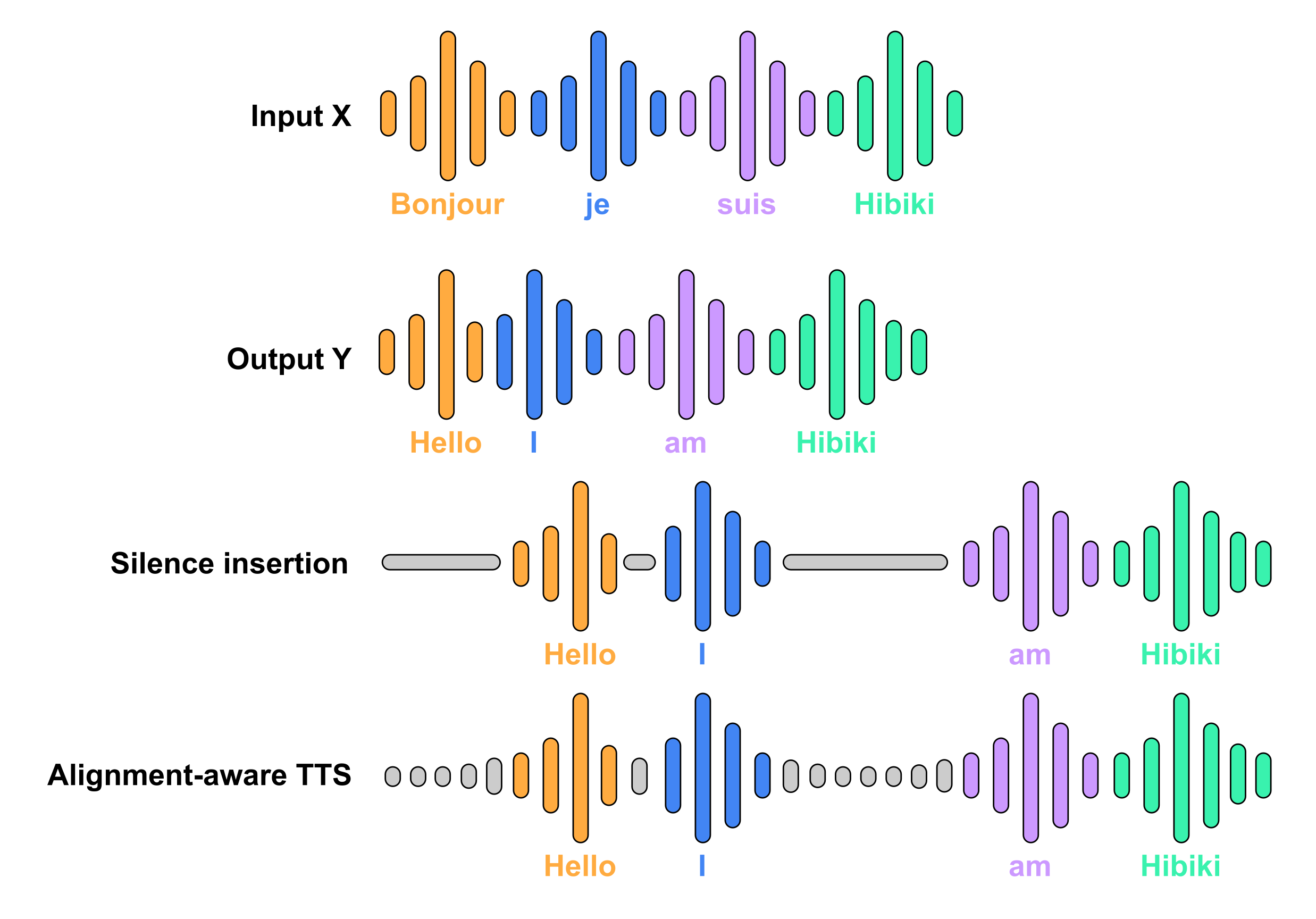

히비키는 동일한 화자의 소스 및 대상 음성 및 텍스트의 정렬된 지도 학습에 의존합니다. 이러한 데이터의 양이 충분하지 않기 때문에 합성 데이터 생성에 의존합니다. 소스 트랜스크립트와 타깃 트랜스크립트 간의 단어 수준 매칭은 기성 MADLAD 기계 번역 시스템을 사용하여 약하게 감독되는 문맥 정렬 방식을 사용하여 수행됩니다. 도출된 정렬 규칙(소스 언어에서 예측할 수 있는 경우에만 대상 언어에 단어가 표시됨)은 음성 제어, 정렬 인식 TTS를 사용하여 침묵을 삽입하거나 대상 음성을 합성하여 적용됩니다.

기능 목록

- 실시간 음성 번역사용자가 말하는 동안 대상 언어의 자연스러운 음성 번역을 실시간으로 생성합니다.

- 텍스트 번역: 음성과 동기화된 텍스트 번역을 제공합니다.

- 멀티스트림 아키텍처(컴퓨팅): 입력 음성 스트림을 동시에 처리하고 대상 음성을 생성하여 일관되고 정확한 번역을 보장합니다.

- 높은 충실도지도 학습 및 합성 데이터 생성 기술을 통해 고품질의 번역을 보장합니다.

- 음성 전이보다 자연스러운 번역 음성을 위한 음성 전송 기능(옵션).

도움말 사용

설치 프로세스

PyTorch

- 마운팅

moshi패키지:pip install -U moshi - 예제 파일을 다운로드하세요:

wget https://github.com/kyutai-labs/moshi/raw/refs/heads/main/data/sample_fr_hibiki_crepes.mp3 - 번역을 실행합니다:

python -m moshi.run_inference sample_fr_hibiki_crepes.mp3 out_en.wav --hf-repo kyutai/hibiki-1b-pytorch-bf16- 선택적 매개 변수

--cfg-coef기본값은 1이며, 값이 클수록 생성된 음성이 원본 음성에 가까워지며, 권장 값은 3입니다.

- 선택적 매개 변수

MLX

- 마운팅

moshi_mlx패키지(버전 0.2.1 이상 필요):pip install -U moshi_mlx - 예제 파일을 다운로드하세요:

wget https://github.com/kyutai-labs/moshi/raw/refs/heads/main/data/sample_fr_hibiki_crepes.mp3 - 번역을 실행합니다:

python -m moshi_mlx.run_inference sample_fr_hibiki_crepes.mp3 out_en.wav --hf-repo kyutai/hibiki-1b-mlx-bf16- 선택적 매개 변수

--cfg-coef기본값은 1이며, 값이 클수록 생성된 음성이 원본 음성에 가까워지며, 권장 값은 3입니다.

- 선택적 매개 변수

MLX-Swift

kyutai-labs/moshi-swift이 리포지토리에는 iPhone에서 실행되며 iPhone 16 Pro에서 테스트된 MLX-Swift의 구현이 포함되어 있습니다. 이 코드는 아직 실험 단계에 있다는 점에 유의하세요.

Rust

- 로 이동

hibiki-rs카탈로그:cd hibiki-rs - 예제 파일을 다운로드하세요:

wget https://github.com/kyutai-labs/moshi/raw/refs/heads/main/data/sample_fr_hibiki_crepes.mp3 - 번역을 실행합니다:

cargo run --features metal -r -- gen sample_fr_hibiki_crepes.mp3 out_en.wav- 활용

--features cudaNVIDIA GPU에서 실행하거나--features metalMac에서 실행됩니다.

- 활용

모델링

프랑스어에서 영어로 번역할 수 있는 두 가지 모델을 출시했습니다:

- 히비키 2B16개의 RVQ 스트림이 있는 PyTorch 및 MLX용.

- 히비키 1B파이토치 및 MLX의 경우, 디바이스 측 추론에 이상적인 8개의 RVQ 스트림이 있습니다.

모델 목록:

- 파이토치용 히비키 2B(bf16):

kyutai/hibiki-2b-pytorch-bf16 - 파이토치용 히비키 1B(bf16):

kyutai/hibiki-1b-pytorch-bf16 - MLX용 히비키 2B(bf16):

kyutai/hibiki-2b-mlx-bf16 - MLX용 히비키 1B(bf16):

kyutai/hibiki-1b-mlx-bf16

모든 모델은 CC-BY 4.0 라이선스에 따라 출시됩니다.

사용 프로세스

- 프라이밍 모델: 설치 프로세스에 따라 모델을 시작합니다.

- 음성 입력마이크를 통해 소스 언어로 음성을 입력합니다.

- 실시간 번역히비키는 대상 언어로 실시간 음성 번역을 생성하고 동시에 텍스트 번역을 표시합니다.

- 설정 조정보다 자연스러운 번역을 위해 필요에 따라 음성 전송 등의 설정을 조정합니다.

주요 기능

- 실시간 음성 번역모델을 실행한 후 마이크에 직접 음성을 입력하면 히비키가 자동으로 번역해 줍니다.

- 텍스트 번역히비키는 음성 번역과 동시에 텍스트 번역을 생성하여 인터페이스에 표시합니다.

- 음성 전이설정에서 음성 전달 기능을 활성화하여 번역된 음성을 대상 언어의 자연스러운 발음에 더 가깝게 만들 수 있습니다.

세부 운영 절차

- 프라이밍 모델설치 프로세스에 따라 모델을 시작하여 모든 종속성이 올바르게 설치되었는지 확인합니다.

- 음성 입력마이크를 통해 소스 언어로 음성을 입력하면 히비키가 자동으로 번역을 시작합니다.

- 번역 결과 보기인터페이스에서 대상 언어로 실시간 생성된 음성 및 텍스트 번역을 볼 수 있습니다.

- 설정 조정최적의 번역을 위해 필요에 따라 설정에서 음성 전송과 같은 기능을 조정하세요.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...