일반 소개

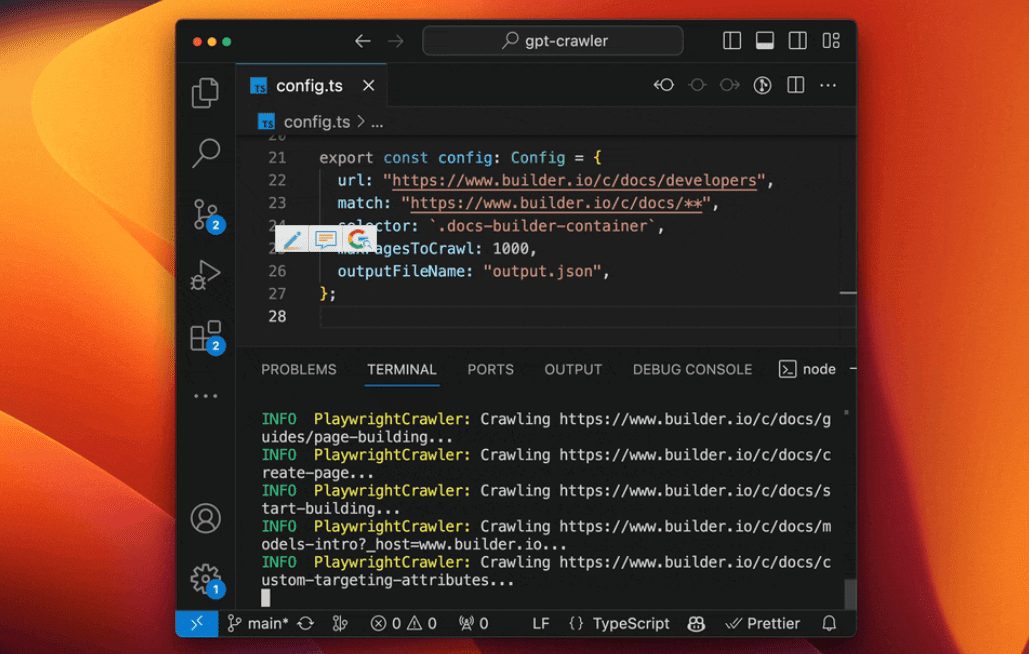

GPT-Crawler는 BuilderIO 팀이 개발한 오픈 소스 도구로 GitHub에서 호스팅됩니다. 하나 이상의 웹사이트 URL을 입력하여 페이지 콘텐츠를 크롤링하여 구조화된 지식 문서를 생성합니다(output.json)를 사용하여 사용자 지정 GPT 또는 AI 어시스턴트를 만들 수 있습니다. 사용자는 시작 URL과 콘텐츠 선택기를 지정하는 등 크롤링 규칙을 구성할 수 있으며, 도구가 자동으로 텍스트를 추출하여 파일로 정리합니다. 이 도구는 사용이 간편하고 로컬 실행, Docker 컨테이너 배포 및 API 호출을 지원하므로 개발자가 웹사이트 콘텐츠로부터 독점적인 AI 비서를 신속하게 구축하는 데 이상적입니다. 지금까지 기술 커뮤니티에서 효율성과 오픈 소스 특성으로 인기를 얻으며 주목을 받고 있습니다.

기능 목록

- 하나 이상의 URL에서 웹사이트 콘텐츠를 크롤링하여 다음을 생성합니다.

output.json문서화. - 시작 URL, 링크 매칭 패턴, CSS 선택기 등 사용자 정의 크롤링 규칙을 지원합니다.

- 헤드리스 브라우저를 사용하여 동적 웹 페이지를 처리하고 클라이언트 측 렌더링 콘텐츠를 크롤링할 수 있습니다.

- POST 요청을 통해 크롤링 작업을 시작할 수 있는 API 인터페이스를 제공합니다.

- 최대 페이지 수 설정 지원(

maxPagesToCrawl), 문서 크기(maxFileSize) 및 토큰 수(maxTokens). - 생성된 파일은 OpenAI에 직접 업로드하여 사용자 지정 GPT 또는 AI 어시스턴트를 만들 수 있습니다.

- 다양한 환경에 쉽게 배포할 수 있는 Docker 컨테이너 실행을 지원합니다.

- 특정 리소스 유형(예: 이미지, 동영상 등)을 제외하여 크롤링 효율을 최적화할 수 있습니다.

도움말 사용

설치 및 작동(로컬 모드)

GPT-Crawler는 Node.js 개발을 기반으로 하며, 실행하려면 관련 환경을 설치해야 합니다. 자세한 단계는 다음과 같습니다:

- 환경 확인

컴퓨터에 Node.js(버전 16 이상)와 npm이 설치되어 있는지 확인합니다. 다음 명령을 실행하여 확인합니다:

node -v

npm -v

아직 설치되어 있지 않다면 Node.js 웹사이트에서 다운로드하여 설치하세요.

- 복제 프로젝트

터미널에 명령을 입력하여 프로젝트를 로컬로 다운로드합니다:

git clone https://github.com/BuilderIO/gpt-crawler.git

- 카탈로그에 액세스

다운로드가 완료되면 프로젝트 폴더로 이동합니다:

cd gpt-crawler

- 종속성 설치

다음 명령을 실행하여 필요한 패키지를 설치합니다:

npm install

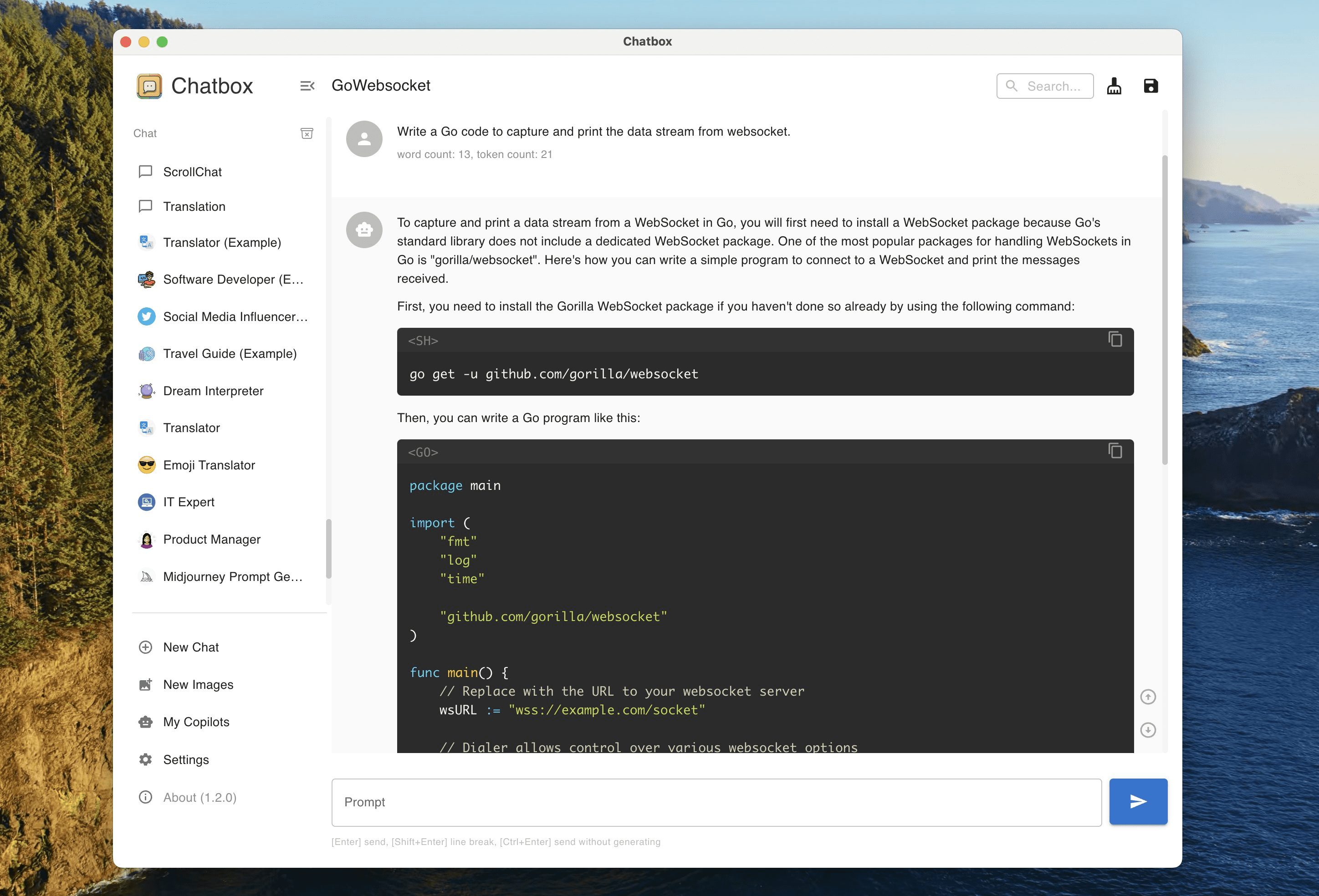

- 크롤러 구성

쇼(티켓)config.ts파일에서 크롤링 매개변수를 수정합니다. 예를 들어 Builder.io 문서를 크롤링하려면 다음과 같이 하세요:

export const defaultConfig: Config = {

url: "https://www.builder.io/c/docs/developers",

match: "https://www.builder.io/c/docs/**",

selector: ".docs-builder-container",

maxPagesToCrawl: 50,

outputFileName: "output.json"

};

url: 크롤링 주소 시작.match와일드카드를 지원하는 링크 매칭 패턴.selector: 콘텐츠 추출을 위한 CSS 선택기입니다.maxPagesToCrawl크롤링할 최대 페이지 수입니다.outputFileName: 출력 파일 이름입니다.

- 크롤러 실행

구성이 완료되면 다음 명령을 실행하여 크롤링을 시작합니다:

npm start

완료되면output.json 파일이 프로젝트 루트 디렉토리에 생성됩니다.

대체 작동 모드

Docker 컨테이너 사용

- Docker가 설치되어 있는지 확인합니다(Docker 웹사이트에서 다운로드).

- 로 이동

containerapp폴더, 편집config.ts. - 다음 명령을 실행하여 컨테이너를 빌드하고 시작합니다:

docker build -t gpt-crawler .

docker run -v $(pwd)/data:/app/data gpt-crawler

- 출력 파일은

data폴더로 이동합니다.

API로 실행하기

- 종속 요소를 설치한 후 API 서비스를 시작합니다:

npm run start:server

- 이 서비스는 기본적으로

http://localhost:3000. - 다음 주소로 POST 요청을 보내세요.

/crawl를 예로 들 수 있습니다:

curl -X POST http://localhost:3000/crawl -H "Content-Type: application/json" -d '{"url":"https://example.com","match":"https://example.com/**","selector":"body","maxPagesToCrawl":10,"outputFileName":"output.json"}'

- 접근성

/api-docsAPI 문서 보기(Swagger 기준).

OpenAI에 업로드

- 사용자 지정 GPT 만들기

- ChatGPT를 엽니다.

- 왼쪽 하단에 있는 자신의 이름을 클릭하고 '내 GPT'를 선택합니다.

- "GPT 만들기" > "구성" > "지식"을 클릭합니다.

- 업로드

output.json문서화. - 파일이 너무 크면

config.ts설정maxFileSize어쩌면maxTokens파일 분할.

- 사용자 지정 어시스턴트 만들기

- OpenAI 플랫폼을 엽니다.

- "+ 만들기" > "업로드"를 클릭합니다.

- 업로드

output.json문서화.

기능

- 콘텐츠 크롤링

명확하고 확실하게 표시url노래로 응답selector그 후 도구가 페이지 텍스트를 추출합니다. 예를 들어.docs-builder-container해당 지역의 콘텐츠만 가져옵니다. - 파일 생성

출력 파일 형식은 다음과 같습니다:

[{"title": "页面标题", "url": "https://example.com/page", "html": "提取的文本"}, ...]

- 최적화된 출력

활용resourceExclusions외부 리소스 제외(예png및jpg)를 사용하여 파일 크기를 줄입니다.

주의

- 사용자 지정 GPT를 만들려면 OpenAI 유료 계정이 필요합니다.

- 동적 웹 크롤링은 의존성 무결성을 보장하기 위해 헤드리스 브라우저에 의존합니다.

- 파일이 너무 큰 경우 업로드를 분할하도록 구성을 조정할 수 있습니다.

애플리케이션 시나리오

- 기술 지원 도우미

제품 설명서 웹사이트를 크롤링하여 사용자가 기술적 질문에 답할 수 있도록 도와주는 AI 어시스턴트를 생성합니다. - 콘텐츠 정리 도구

블로그나 뉴스 사이트에서 기사를 가져와 지식창고 또는 Q&A 도우미를 만드세요. - 교육 및 훈련 도우미

온라인 코스 페이지를 크롤링하여 코스 관련 답변을 제공하는 학습 도우미를 생성합니다.

QA

- 여러 웹사이트를 크롤링할 수 있나요?

Can. 에서config.ts여러 URL과 일치 규칙을 설정하기만 하면 됩니다. - 파일이 너무 커서 업로드할 수 없으면 어떻게 하나요?

설정maxFileSize어쩌면maxTokens를 클릭하면 파일이 여러 개의 작은 파일로 분할됩니다. - 중국어 웹사이트를 지원하나요?

지원. 헤드리스 브라우저에서 사이트 콘텐츠를 구문 분석할 수 있는 한 제대로 크롤링할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...