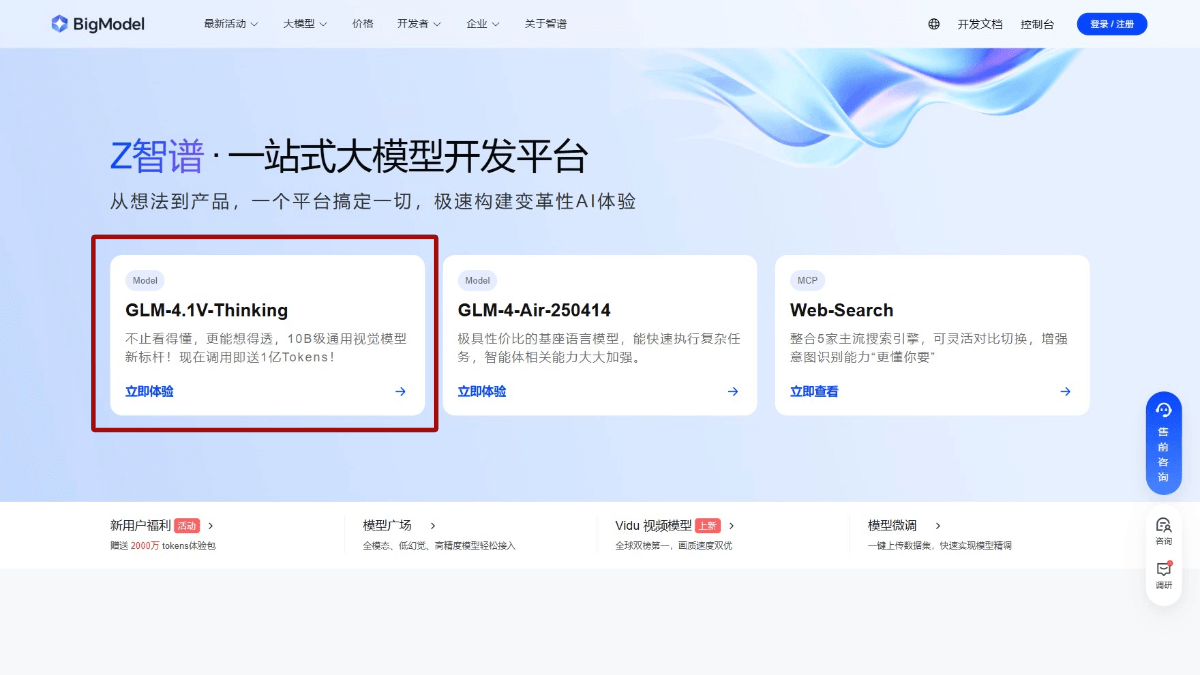

GLM-4.1V-Thinking이란 무엇인가요?

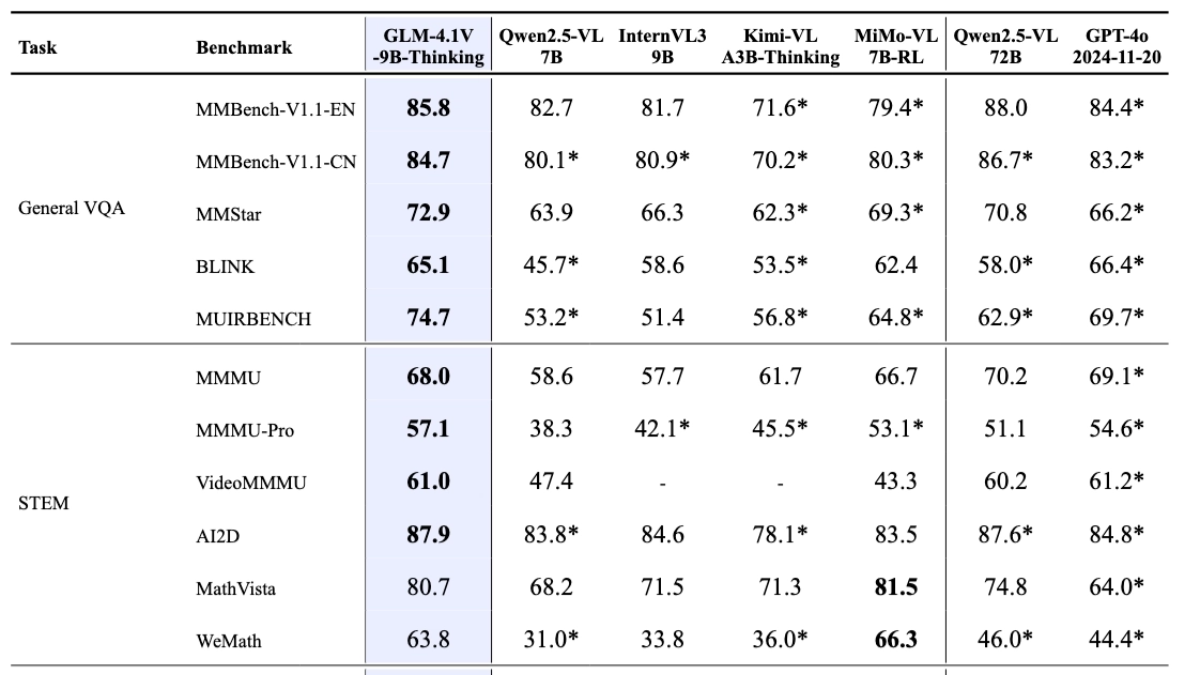

스마트 스펙트럼 AI에서 출시한 오픈 소스 시각 언어 모델인 GLM-4.1V-Thinking은 복잡한 인지 작업을 위해 설계되었으며 이미지, 비디오 및 문서를 포괄하는 멀티모달 입력을 지원합니다. GLM-4V 아키텍처를 기반으로 하는 이 모델은 연쇄적 사고 추론 메커니즘을 도입하고 코스 샘플링으로 학습 전략을 강화하며 모달 간 인과 추론과 안정성을 크게 향상시킵니다. GLM-4.1V-9B-Thinking의 경량 버전(GLM-4.1V-9B-Base 기본 모델 및 심층 사고 및 추론 능력을 갖춘 GLM-4.1V-9B-Thinking)은 매개 변수 수가 10B이며 28개의 권위 있는 리뷰 중 23개에서 10B 수준 모델 중 최고 점수를 획득했으며, 그중 18개는 Qwen-의 72B 매개 변수 수와 동일합니다. 2.5-VL의 72B 매개 변수 수와 동일하여 소형 모델의 우수한 성능을 충분히 입증했습니다. 이 모델은 교육 상담, 콘텐츠 제작, 지능형 상호 작용, 산업 응용 프로그램은 물론 엔터테인먼트 및 생활과 같은 다양한 분야에서 광범위한 응용 가능성을 가지고 있습니다.

GLM-4.1V-Thinking의 주요 기능

- 강력한 시각적 이해력간단한 대상 감지, 보다 복잡한 이미지 분류 작업, 이미지에 대한 포괄적인 이해와 정답이 필요한 시각적 퀴즈 등 이미지의 다양한 콘텐츠를 정확하게 식별하고 분석할 수 있습니다.

- 높은 수준의 비디오 처리뛰어난 타이밍 분석 및 이벤트 로직 모델링 기능으로 동영상 이해를 위한 심층적인 동영상 입력 처리, 정확한 동영상 설명 생성 및 동영상 콘텐츠와 관련된 질문에 대한 답변을 지원합니다.

- 모든 기능을 갖춘 문서 구문 분석문서 내 이미지와 텍스트 콘텐츠의 동시 처리, 긴 문서 이해, 차트 및 그래프의 정확한 구문 분석, 문서 콘텐츠에 기반한 Q&A를 모두 효율적으로 지원합니다.

- 뛰어난 추론 능력수학 및 과학 분야에서 다단계 수학 문제 해결, 과학의 공식 이해 및 논리적 추론 등 복잡한 추론 문제를 해결하여 관련 분야의 학습 및 연구를 강력하게 지원합니다.

- 논리적 추론의 정확성복잡한 논리적 추론 및 인과 관계 분석을 지원하여 다단계 추론 및 논리적 판단과 같은 작업에 대응하여 사용자가 다양하고 복잡한 상황을 더 잘 이해하고 분석할 수 있도록 도와줍니다.

- 효율적인 교차 모드 추론시각적 정보와 언어적 정보를 유기적으로 결합하여 효율적인 교차 모드 추론, 그래픽 이해, 시각적 퀴즈 및 시각적 앵커링과 같은 작업을 완료하고 다중 모드 정보의 통합 처리를 위한 강력한 지원을 제공합니다.

GLM-4.1V-사고의 성능 이점

MM스타, MMMU-Pro, 차트큐아프로, OS월드 등 28개의 권위 있는 평가에서 GLM-4.1V-Thinking은 23개 항목에서 10B급 모델의 최고 성능에 도달했고, 18개 항목은 72B에 달하는 파라미터 수를 가진 Qwen-2.5-VL과 대등하거나 심지어 능가하는 우수한 결과를 달성하여 소형 모델의 강력한 성능을 충분히 보여주었습니다. 이는 소형 모델의 강력한 성능을 충분히 보여줍니다.

GLM-4.1V-Thinking의 공식 웹사이트 주소

- GitHub 리포지토리:: https://github.com/THUDM/GLM-4.1V-Thinking

- 허깅페이스 모델 라이브러리:: https://huggingface.co/collections/THUDM/glm-41v-thinking-6862bbfc44593a8601c2578d

- arXiv 기술 논문:: https://arxiv.org/pdf/2507.01006v1

- 온라인 경험 데모:: https://huggingface.co/spaces/THUDM/GLM-4.1V-9B-Thinking-Demo

GLM-4.1V-Thinking 사용 방법

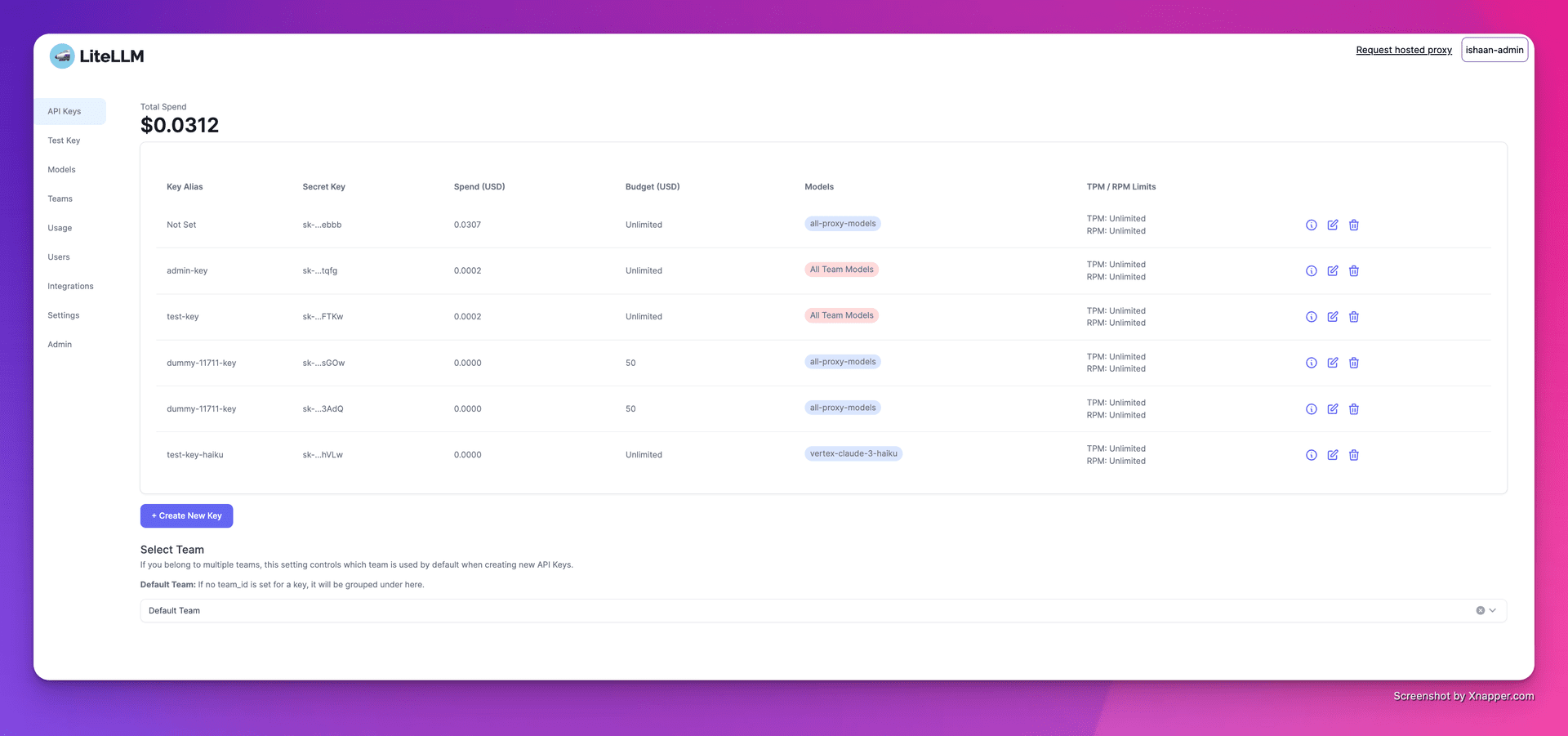

- API 인터페이스 사용::

- API 키 가져오기스마트 스펙트럼 AI 플랫폼에서 전용 API 키를 받으려면 앱을 만드세요: https://bigmodel.cn/注册账号.

- API 호출하기API 설명서에 따르면 HTTP 요청으로 모델 인터페이스를 호출하여 입력 데이터(예: 이미지 URL 또는 Base64로 인코딩된 데이터, 텍스트 등)를 모델에 전송하고 모델의 출력을 가져옵니다. 예를 들어 Python 코드로 호출합니다:

import requests

import json

api_url = "https://api.zhipuopen.com/v1/glm-4.1v-thinking"

api_key = "your_api_key"

input_data = {

"image": "image_url_or_base64_encoded_data",

"text": "your_input_text"

}

headers = {

"Authorization": f"Bearer {api_key}",

"Content-Type": "application/json"

}

response = requests.post(api_url, headers=headers, data=json.dumps(input_data))

result = response.json()

print(result)- 오픈 소스 모델 사용::

- 모델 다운로드허깅 페이스 플랫폼을 방문하여 GLM-4.1V-사고하는 모델 페이지를 찾은 후 필요한 모델 파일을 다운로드하세요.

- 모델 로드다운로드한 모델을 PyTorch와 같은 딥러닝 프레임워크로 로드합니다. 예시:

from transformers import AutoModelForVision2Seq, AutoProcessor

import torch

model_name = "THUDM/glm-4.1v-thinking"

model = AutoModelForVision2Seq.from_pretrained(model_name)

processor = AutoProcessor.from_pretrained(model_name)- 추론 도출모델에 입력 데이터(예: 이미지 경로 또는 URL, 텍스트 등)를 전처리하여 모델의 출력을 얻습니다. 예시:

image_url = "image_url_or_image_path"

text = "your_input_text"

inputs = processor(images=image_url, text=text, return_tensors="pt")

with torch.no_grad():

outputs = model(**inputs)

result = processor.decode(outputs.logits[0], skip_special_tokens=True)

print(result)- 온라인 경험 플랫폼 사용::

- 경험 링크에 액세스허깅 페이스 플랫폼에서 직접 GLM-4.1V-Thinking 체험 페이지를 방문하세요.

- 입력 데이터이미지 등의 데이터를 업로드하거나 웹 페이지에 텍스트를 입력합니다.

- 결과 얻기복잡한 코드 작성이나 모델 배포 없이도 '실행' 버튼을 클릭하고 모델이 처리될 때까지 기다렸다가 출력을 확인할 수 있습니다.

GLM-4.1V-사고의 핵심 이점

- 멀티모달 입력 지원이미지, 동영상, 문서 등 여러 입력을 지원하며 복잡한 작업의 요구 사항을 충족하기 위해 다중 소스 정보를 종합적으로 처리할 수 있습니다.

- 강력한 추론복잡한 작업 수행 및 해석 가능성을 개선하기 위해 단계별 사고로 세부적인 추론 과정을 생성하는 연쇄적 사고 추론 메커니즘을 도입했습니다.

- 효과적인 교육 전략학습 난이도를 동적으로 조정하고 대규모 사전 학습과 미세 조정을 결합하여 성능과 효율성을 개선하는 코스 기반 샘플링 강화 학습 전략입니다.

- 뛰어난 성능10B 매개변수 수는 여러 권위 있는 리뷰에서 높은 효율성과 안정성을 입증한 소형 풋프린트 모델입니다.

- 오픈 소스 및 사용 편의성오픈 소스 기능은 사용의 문턱을 낮추고 다양한 사용 방법을 제공하여 개발자의 신속한 통합과 2차 개발을 용이하게 합니다.

GLM-4.1V-Thinking이 대상인 사람들

- 교육 상담교사 보조 수업: 학생들에게 더 풍부한 학습 자료와 더 자세한 문제 해결 단계를 제공합니다.

- 콘텐츠 크리에이터광고 카피라이터, 소셜 미디어 운영자, 뉴스 기자 등이 이미지와 텍스트를 결합하여 창의적인 콘텐츠를 생성하여 제작의 효율성과 품질을 개선합니다.

- 비즈니스 및 개발자기업은 모델을 지능형 고객 서비스 시스템에 통합하여 고객 서비스 품질을 개선하고, 멀티모달 입력을 지원하며, 사용자 요구 사항을 더 잘 이해하고, 정확한 답변을 제공할 수 있습니다.

- 산업 애플리케이션 개발금융, 의료, 산업 분야의 전문가들이 데이터 분석, 보고서 생성, 장비 모니터링 등의 업무를 수행하여 효율성과 정확성을 향상시킵니다.

- (과학) 연구원연구자들은 복잡한 추론 작업을 지원하고 관련 분야의 연구를 발전시키기 위해 멀티모달 데이터의 분석 및 처리를 수행합니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...