FunClip: 비디오 콘텐츠를 단편 영화로 지능적으로 편집하고 정확한 비디오 클립 추출/자르기를 쉽게 수행할 수 있습니다.

일반 소개

펀클립은 알리바바 달마 연구소의 통이 스피치 랩에서 개발한 완전 오픈 소스 현지화 자동 동영상 편집 도구입니다. 이 도구는 산업 등급의 Paraformer-Large 음성 인식 모델을 통합하여 비디오의 음성 콘텐츠를 정확하게 식별하고 텍스트로 변환할 수 있습니다. 펀클립은 LLM(대규모 언어 모델링)을 통해 지능형 편집을 지원하고 화자 인식을 통합하여 다른 화자를 자동으로 식별하는 것이 특징입니다. 사용자는 간단한 인터페이스 조작을 통해 관심 있는 텍스트 클립을 선택하고 클릭 한 번으로 해당 비디오 클립을 내보낼 수 있습니다. 이 도구는 다중 세그먼트 무료 편집을 지원하며 완전한 SRT 자막 파일과 대상 세그먼트에 대한 자막을 자동으로 생성하여 사용자에게 간단하고 편리한 비디오 처리 경험을 제공합니다. 최신 버전은 이중 언어 인식을 지원하고 풍부한 자막 삽입 및 내보내기 기능을 제공하며, 강력하고 사용하기 쉬운 오픈 소스 동영상 처리 도구입니다.

FunClip 최적화 - 개인-ASR

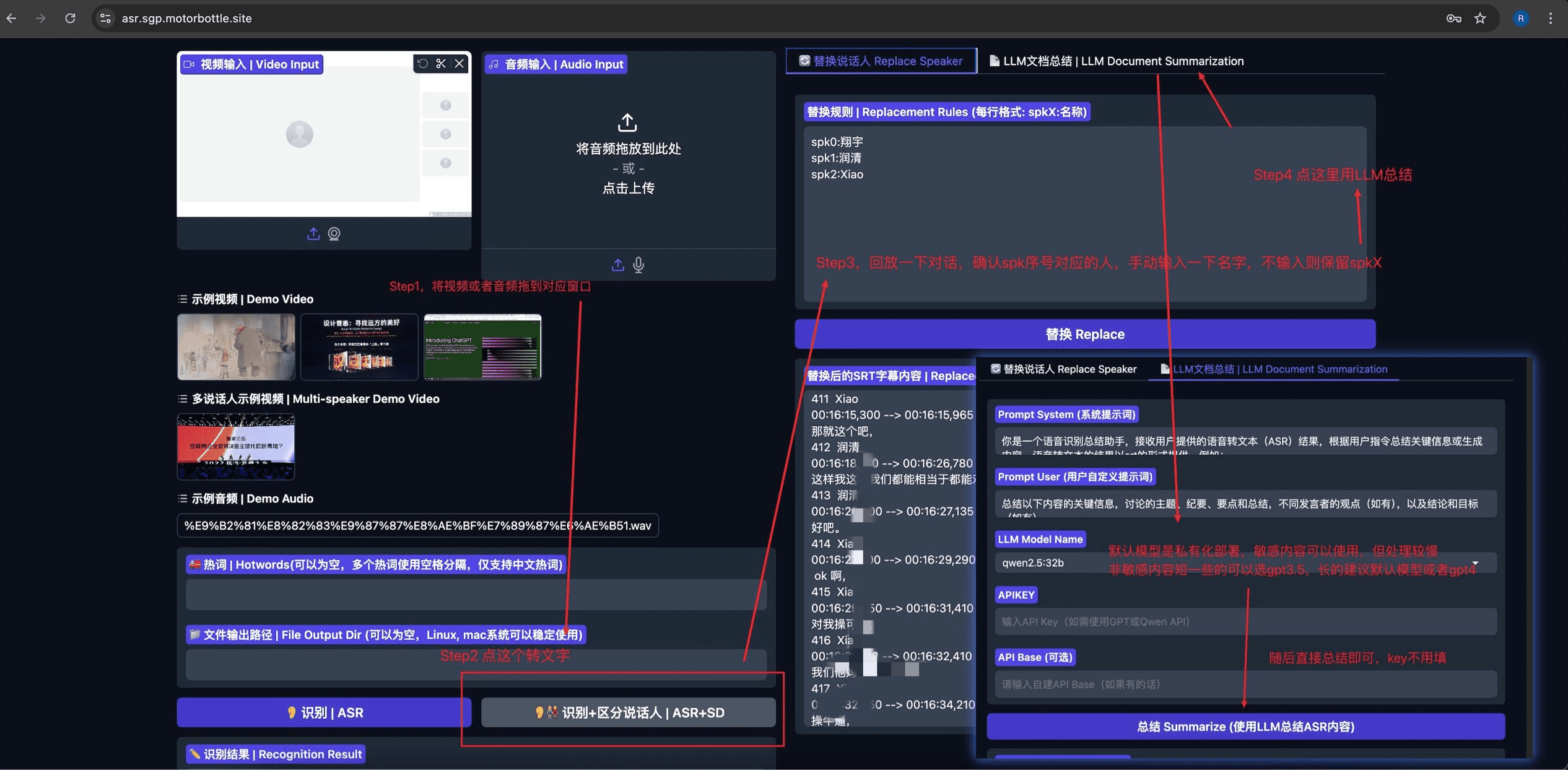

Private-ASR 오픈 소스 프로젝트 기반 펀클립 자동 음성 인식(ASR), 화자 분리, SRT 자막 편집, LLM 기반 요약 기능을 통합하도록 수정되었습니다. 이 프로젝트는 다음을 사용합니다. Gradio 직관적이고 사용하기 쉬운 사용자 인터페이스를 제공합니다.

기능 목록

- 정확한 음성 인식: 중국어와 영어 음성 인식을 지원하는 Alibaba의 오픈 소스 Paraformer-Large 모델을 통합했습니다.

- LLM 지능형 클립: 대규모 언어 모델을 통해 콘텐츠의 지능형 분석 및 클립 포인트 자동 결정을 지원합니다.

- 화자 인식: 다양한 화자를 자동으로 식별할 수 있는 CAM++ 화자 인식 모델 통합

- 핫워드 사용자 지정: 특정 단어 인식의 정확도를 높이기 위해 SeACo-Paraformer의 핫워드 사용자 지정 기능이 지원됩니다.

- 다중 세그먼트 편집: 일괄 편집을 위해 여러 텍스트 세그먼트를 자유롭게 선택할 수 있도록 지원합니다.

- 자막 생성: 전체 동영상 SRT 자막과 타겟 클립 자막을 자동으로 생성합니다.

- 이중 언어 지원: 중국어 및 영어 동영상 인식 및 편집 지원

- 로컬 배포: 완전한 오픈 소스, 로컬 배포 지원, 개인 정보 보호 및 데이터 보안 지원

- 친숙한 인터페이스: Gradio 프레임워크 개발 기반, 간단하고 직관적인 웹 인터페이스 제공

도움말 사용

1. 설치 및 배포

기본 환경 설치

- 코드 리포지토리를 복제합니다:

git clone https://github.com/alibaba-damo-academy/FunClip.git

cd FunClip

- Python 종속성을 설치합니다:

pip install -r ./requirements.txt

선택적 기능 설치(임베디드 자막의 경우)

자막 임베딩 기능을 사용하려면 ffmpeg 및 imagemagick을 설치해야 합니다:

- 우분투:

apt-get -y update && apt-get -y install ffmpeg imagemagick

sed -i 's/none/read,write/g' /etc/ImageMagick-6/policy.xml

- MacOS:

brew install imagemagick

sed -i 's/none/read,write/g' /usr/local/Cellar/imagemagick/7.1.1-8_1/etc/ImageMagick-7/policy.xml

- Windows:

- 공식 웹사이트에서 이미지매직 다운로드 및 설치: https://imagemagick.org/script/download.php#windows

- Python 설치 경로를 찾아서

site-packages\moviepy\config_defaults.py정곡을 찌르세요IMAGEMAGICK_BINARY이미지매직 설치 경로 - 글꼴 파일을 다운로드합니다:

wget https://isv-data.oss-cn-hangzhou.aliyuncs.com/ics/MaaS/ClipVideo/STHeitiMedium.ttc -O font/STHeitiMedium.ttc

2. 사용 방법

A. 로컬 라디오 서비스 사용

- 서비스를 시작합니다:

python funclip/launch.py

# 使用 -l en 参数支持英文识别

# 使用 -p xxx 设置端口号

# 使用 -s True 开启公共访问

- 인터뷰

localhost:7860를 클릭하고 아래 단계를 따르세요:

- 1단계: 동영상 파일 업로드

- 2단계: 원하는 텍스트 클립을 '클립할 텍스트' 영역에 복사합니다.

- 3단계: 필요에 따라 자막 설정 조정하기

- 4단계: '자르기' 또는 '자막 자르기 및 생성'을 클릭하여 편집합니다.

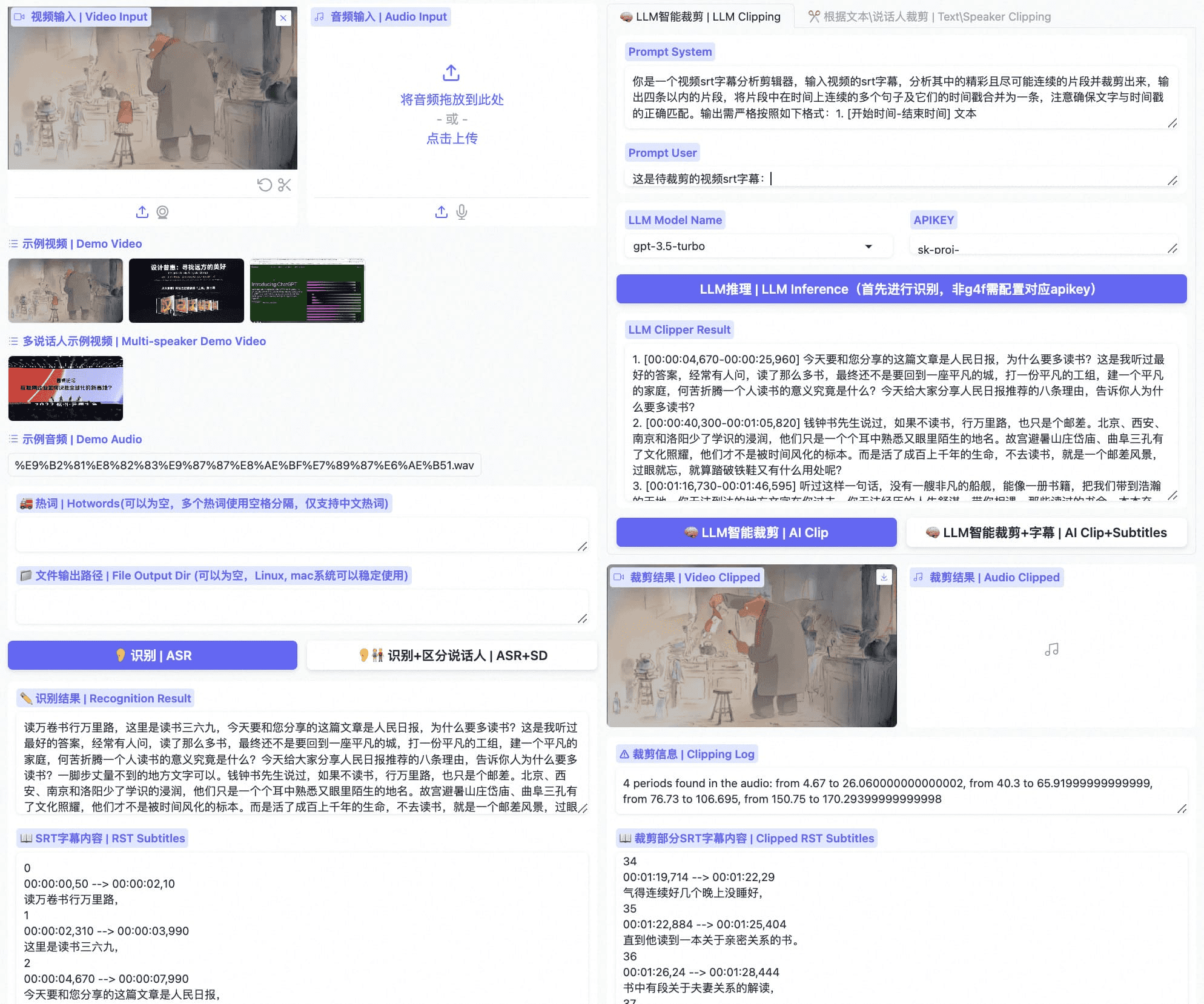

B. LLM 스마트 클립

- 인식이 완료되면 큰 언어 모델을 선택하고 apikey를 구성합니다.

- 'LLM 추론' 버튼을 클릭하면 시스템이 자동으로 동영상 자막과 사전 설정된 단서를 결합합니다.

- 'AI 클립' 버튼을 클릭하면 대규모 언어 모델의 출력을 기반으로 편집할 타임스탬프를 자동으로 추출할 수 있습니다.

- 대규모 언어 모델의 출력은 큐 단어를 수정하여 최적화할 수 있습니다.

C. 명령줄 사용

- 음성 인식:

python funclip/videoclipper.py --stage 1 \

--file examples/video.mp4 \

--output_dir ./output

- 비디오 클립:

python funclip/videoclipper.py --stage 2 \

--file examples/video.mp4 \

--output_dir ./output \

--dest_text '待剪辑文本' \

--start_ost 0 \

--end_ost 100 \

--output_file './output/res.mp4'

또한 사용자는 다음 온라인 플랫폼을 통해 펀클립을 경험할 수 있습니다:

- 모델 범위 공간:펀클립@모델스코프 스페이스

- 허깅페이스 스페이스:펀클립@허깅페이스 스페이스

사용 중 문제가 발생하면 프로젝트에서 제공하는 고정된 그룹이나 위챗 그룹을 통해 커뮤니티 지원을 받을 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...