일반 소개

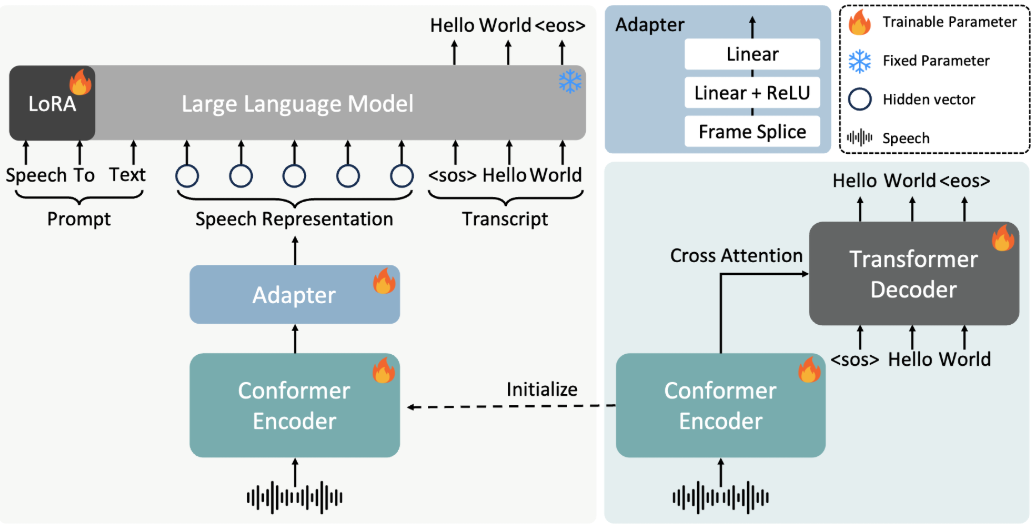

FireRedASR은 자동 음성 인식(ASR) 솔루션에 고정밀 다국어 지원을 제공하는 데 중점을 둔 Little Red Book FireRed 팀이 개발하여 오픈소스로 공개한 음성 인식 모델입니다. 개발자 및 연구원을 대상으로 하는 이 프로젝트는 GitHub에서 호스팅되며, 산업 등급 설계를 제공하고 중국어, 중국어 방언, 영어 및 가사 인식과 같은 시나리오를 지원하며, FireRedASR은 두 가지 주요 버전으로 나뉩니다: FireRedASR-LLM은 극도의 정확도를 추구하며 전문적인 요구에 적합하고, FireRedASR-AED는 효율과 성능의 균형을 맞추며 실시간 애플리케이션에 적합합니다. 2025년 현재 이 모델은 중국어 만다린 테스트(CER 3.05%)에서 최적의 기록을 세웠으며, 다중 시나리오 테스트에서 우수한 성능을 보여 지능형 비서, 동영상 자막 생성 및 기타 분야에 널리 적용될 수 있습니다.

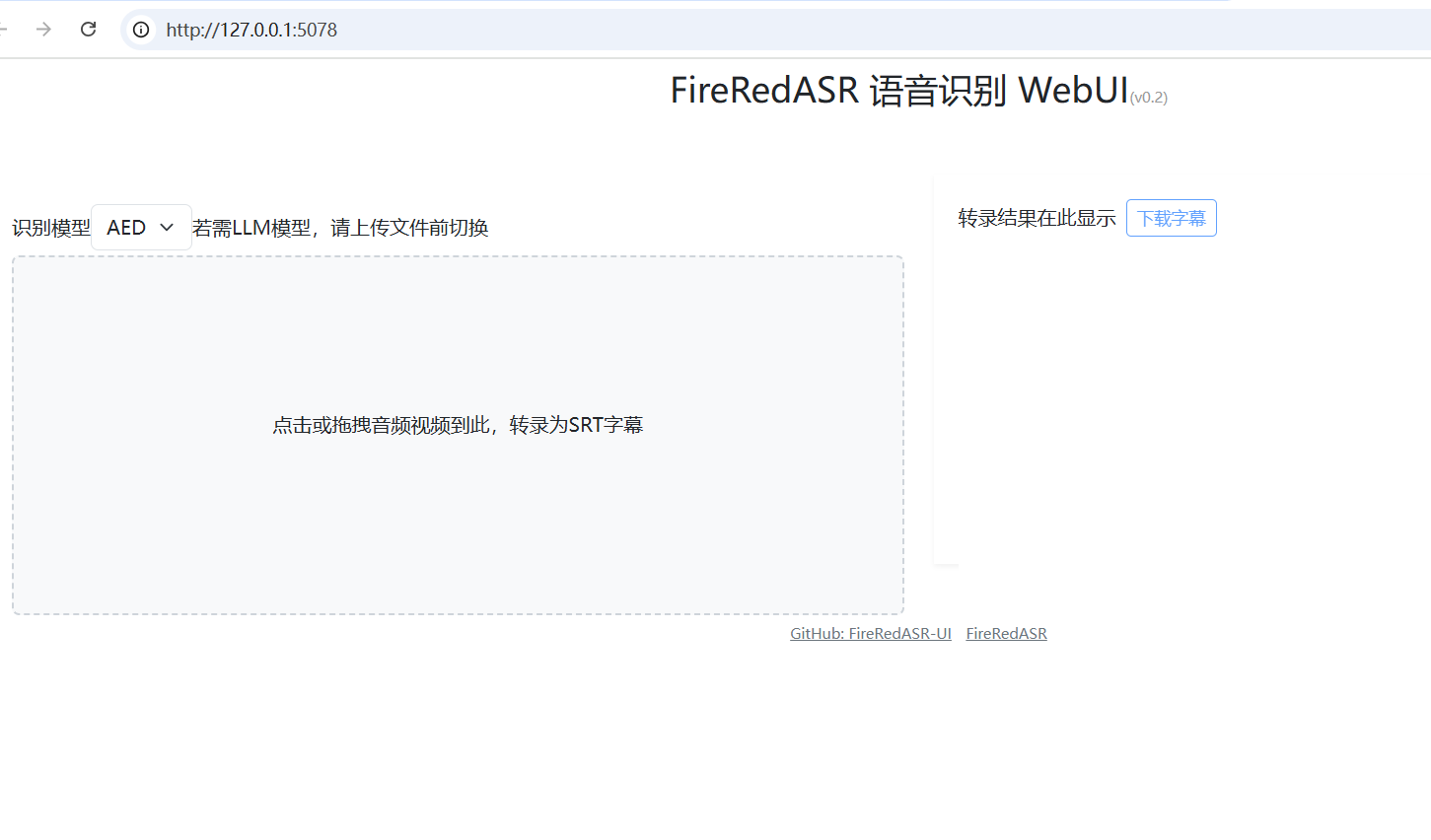

FireRedASR: 웹UI 원클릭 설치 프로그램: https://github.com/jianchang512/fireredasr-ui

기능 목록

- 업계 최고의 인식 정확도로 중국어, 중국어 방언, 영어의 음성-텍스트 변환을 지원합니다.

- 특히 멀티미디어 콘텐츠 처리에 적합한 가사 인식 기능을 제공합니다.

- 각각 고정밀 및 고효율 추론의 요구 사항을 충족하기 위해 FireRedASR-LLM과 FireRedASR-AED의 두 가지 버전이 포함되어 있습니다.

- 커뮤니티 보조 개발 및 맞춤형 애플리케이션을 지원하는 오픈 소스 모델 및 추론 코드.

- 짧은 동영상, 라이브 스트리밍, 음성 입력 등 다양한 오디오 입력 시나리오를 처리할 수 있습니다.

- 대규모 데이터 전사 작업에 적합한 일괄 오디오 처리를 지원합니다.

도움말 사용

설치 프로세스

FireRedASR을 실행하려면 특정 개발 환경 구성이 필요하며, 자세한 설치 단계는 다음과 같습니다:

1.프로젝트 저장소 복제

터미널을 열고 다음 명령을 입력하여 FireRedASR 프로젝트를 로컬로 복제합니다:

git clone https://github.com/FireRedTeam/FireRedASR.git

완료되면 프로젝트 카탈로그로 이동합니다:

cd FireRedASR

- Python 환경 만들기

종속성 격리를 보장하기 위해 Conda를 사용하여 별도의 Python 환경을 만드는 것이 좋습니다. 다음 명령을 실행합니다:

conda create --name fireredasr python=3.10

환경을 활성화합니다:

conda activate fireredasr

- 종속성 설치

이 프로젝트는requirements.txt파일에 필요한 모든 종속성이 포함되어 있습니다. 설치 명령은 다음과 같습니다:

pip install -r requirements.txt

설치가 완료될 때까지 기다렸다가 네트워크가 원활한지 확인하고 다운로드 속도를 높이려면 과학적인 인터넷 도구가 필요할 수 있습니다.

- 사전 학습된 모델 다운로드

- FireRedASR-AED-L사전 학습된 모델을 GitHub 또는 허깅 페이스에서 직접 다운로드하고, 이 모델을

pretrained_models/FireRedASR-AED-L폴더. - FireRedASR-LLM-L모델을 다운로드하는 것 외에도 Qwen2-7B-Instruct 모델을 다운로드해야 합니다.

pretrained_models폴더와FireRedASR-LLM-L디렉토리에 소프트 링크를 생성합니다:

ln -s ../Qwen2-7B-Instruct

- 설치 확인

다음 명령을 실행하여 설치가 성공했는지 확인합니다:

python speech2text.py --help

도움말 메시지가 표시되면 환경이 올바르게 구성된 것입니다.

사용 방법

FireRedASR은 명령줄과 Python API를 사용하는 두 가지 방법을 제공하며, 다음은 작업 프로세스의 주요 기능에 대한 자세한 설명입니다.

명령줄 작업

- 단일 파일 전사(AED 모델)

FireRedASR-AED-L을 사용하여 오디오 파일을 처리합니다(최대 60초):

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "aed" --model_dir pretrained_models/FireRedASR-AED-L

--wav_path: 오디오 파일 경로를 지정합니다.--asr_type모델 유형(이 경우 "AED")을 선택합니다.--model_dir: 모델 폴더를 지정합니다.

출력은 단말기에 표시되며, 예를 들어 텍스트 콘텐츠가 전사됩니다.

- 단일 파일 전사(LLM 모델)

FireRedASR-LLM-L을 사용하여 오디오를 처리합니다(최대 30초):

python speech2text.py --wav_path examples/wav/BAC009S0764W0121.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L

매개변수의 의미는 위와 동일하며 출력은 텍스트로 변환된 텍스트입니다.

Python API 작업

- 모델 로드 및 전사

Python 스크립트에서 FireRedASR 모델을 호출합니다:

from fireredasr.models.fireredasr import FireRedAsr

# 初始化 AED 模型

model = FireRedAsr.from_pretrained("aed", "pretrained_models/FireRedASR-AED-L")

batch_uttid = ["BAC009S0764W0121"]

batch_wav_path = ["examples/wav/BAC009S0764W0121.wav"]

results = model.transcribe(

batch_uttid, batch_wav_path,

{"use_gpu": 1, "beam_size": 3, "nbest": 1, "decode_max_len": 0}

)

print(results)

- from_pretrained: 지정된 모델을 로드합니다.

- 전사: 전사 작업을 수행하고 결과를 텍스트 목록으로 반환합니다.

- 결과 최적화를 위한 매개변수 조정

- use_gpuGPU 가속을 사용하려면 1, CPU를 사용하려면 0으로 설정합니다.

- 빔 크기검색 번들의 너비, 클수록 정밀도는 높아지지만 시간이 더 많이 소요되며 기본값은 3입니다.

- nbest: 최적의 결과 수를 반환합니다(기본값은 1).

주요 기능 작동

- 가사 인식

FireRedASR-LLM은 가사 인식에 탁월합니다. 노래 오디오를 입력하고(30초 이상 걸리지 않도록 하세요) 실행합니다:python speech2text.py --wav_path your_song.wav --asr_type "llm" --model_dir pretrained_models/FireRedASR-LLM-L**업계 최고의 인식률로 노래 텍스트로 출력합니다. **

- 다국어 지원

방언 또는 영어 오디오의 경우 위의 명령어 또는 API를 직접 사용하면 모델이 자동으로 조정됩니다. 예를 들어 영어 오디오를 처리합니다:model = FireRedAsr.from_pretrained("llm","pretrained_models/FireRedASR-LLM-L") results = model.transcribe(["english_audio"],["path/to/english.wav"],{"use_gpu":1}) print(results)

주의

- 오디오 길이 제한최대 60초까지 지원되며, 그 이후에는 환각 문제가 발생할 수 있습니다. LLM은 30초까지 지원되며, 그 이상의 동작은 정의되지 않았습니다.

- 배치 파일성능 저하를 방지하기 위해 입력 오디오 길이가 비슷한지 확인합니다.

- 하드웨어 요구 사항CPU가 느려질 수 있으므로 대형 모델을 실행할 때는 GPU를 사용하는 것이 좋습니다.

위의 단계를 통해 사용자는 FireRedASR을 쉽게 시작하고 설치부터 사용까지 전체 프로세스를 완료할 수 있으며 다양한 음성 인식 시나리오에 적용할 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...