일반 소개

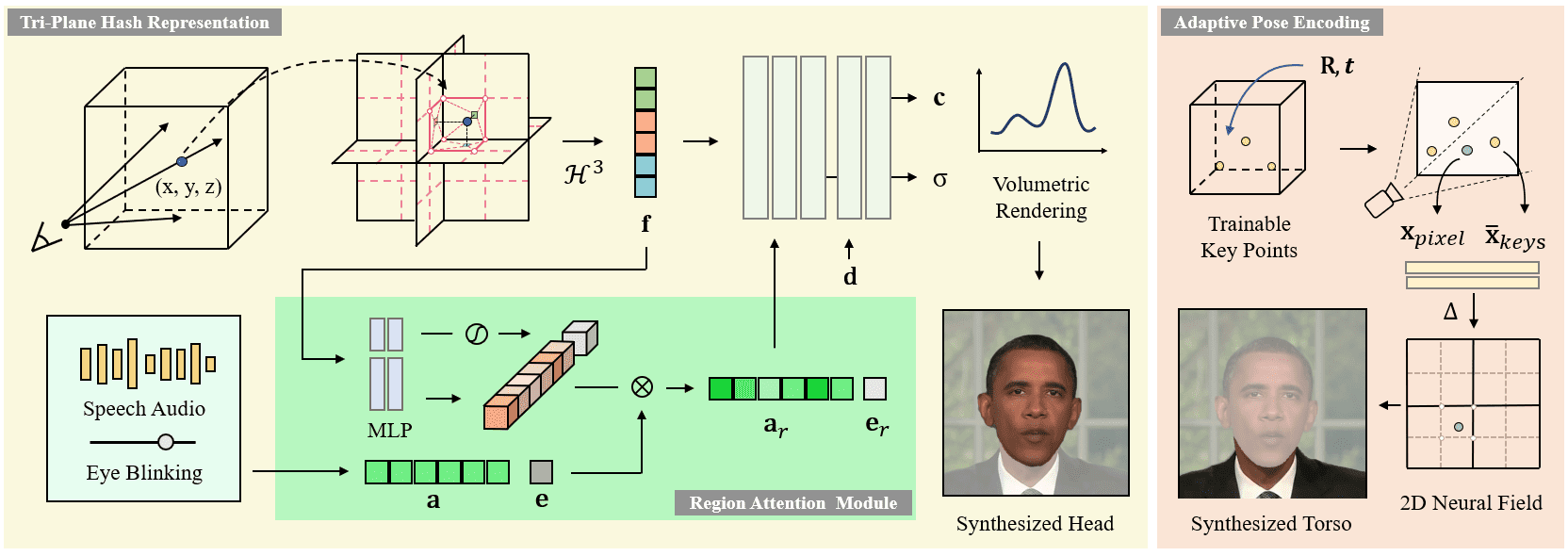

ER-NeRF(효율적인 영역 인식 신경 방사 필드)는 ICCV 2023에서 발표된 오픈 소스 말하는 캐릭터 합성 시스템입니다. 이 프로젝트는 지역 인식 신경 방사 필드 기술을 활용하여 말하는 캐릭터의 고충실도 비디오를 효율적으로 생성합니다. 이 시스템의 주요 특징은 캐릭터의 머리와 몸통을 개별적으로 모델링하는 지역화된 처리 방식과 보다 정확한 입술 동기화를 가능하게 하는 혁신적인 오디오 공간 분해 기법입니다. 이 프로젝트는 완전한 훈련 및 추론 코드를 제공하고, 맞춤형 훈련 비디오를 지원하며, 다양한 오디오 특징 추출기(예: DeepSpeech, Wav2Vec, HuBERT 등)를 사용하여 오디오 입력을 처리할 수 있습니다. 이 시스템은 시각적 품질과 계산 효율성 모두에서 상당한 개선을 달성하여 말하는 캐릭터 합성 분야에서 중요한 기술 솔루션을 제공합니다.

새 프로젝트: https://github.com/Fictionarry/TalkingGaussian

기능 목록

- 말하는 헤드의 고음질 비디오 합성

- 영역 인식을 위한 신경 방사선 필드 렌더링

- 머리와 몸통의 별도 모델링 지원

- 정확한 립싱크 동기화

- 다중 오디오 특징 추출 지원(DeepSpeech/Wav2Vec/HuBERT)

- 맞춤형 비디오 교육 지원

- 오디오 기반 캐릭터 애니메이션 생성

- 부드러운 머리 움직임 제어

- 깜박임 모션 지원(AU45 기능)

- LPIPS 미세 조정 최적화 기능

도움말 사용

1. 환경 설정

시스템 운영 환경 요구 사항:

- 우분투 18.04 운영 체제

- PyTorch 버전 1.12

- CUDA 11.3

설치 단계:

- 콘다 환경을 만듭니다:

conda create -n ernerf python=3.10

conda install pytorch==1.12.1 torchvision==0.13.1 cudatoolkit=11.3 -c pytorch

pip install -r requirements.txt

- 추가 종속성을 설치합니다:

pip install "git+https://github.com/facebookresearch/pytorch3d.git"

pip install tensorflow-gpu==2.8.0

전처리 모델 준비 2.

다음 모델 파일을 다운로드하여 준비해야 합니다:

- 얼굴 구문 분석 모델

- 3DMM 머리 자세 추정 모델

- 바젤 페이스 모델 2009

3. 비디오 교육 프로세스 사용자 지정

- 동영상 준비 요구 사항:

- 형식: MP4

- 프레임 속도: 25FPS

- 해상도: 512x512 권장

- 소요 시간: 1~5분

- 각 프레임에 말하는 캐릭터가 포함되어야 합니다.

- 데이터 전처리:

python data_utils/process.py data/<ID>/<ID>.mp4

- 오디오 특징 추출(세 가지 중 하나):

- 딥스피치 특징 추출:

python data_utils/deepspeech_features/extract_ds_features.py --input data/<n>.wav

- Wav2Vec 특징 추출:

python data_utils/wav2vec.py --wav data/<n>.wav --save_feats

- 휴버트 특징 추출(권장):

python data_utils/hubert.py --wav data/<n>.wav

4. 모델 교육

훈련은 머리 훈련과 몸통 훈련의 두 단계로 나뉩니다:

- 헤드 트레이닝:

python main.py data/obama/ --workspace trial_obama/ -O --iters 100000

python main.py data/obama/ --workspace trial_obama/ -O --iters 125000 --finetune_lips --patch_size 32

- 몸통 훈련:

python main.py data/obama/ --workspace trial_obama_torso/ -O --torso --head_ckpt <head>.pth --iters 200000

5. 모델 테스트 및 추론

- 모델 효과를 테스트합니다:

# 仅渲染头部

python main.py data/obama/ --workspace trial_obama/ -O --test

# 渲染头部和躯干

python main.py data/obama/ --workspace trial_obama_torso/ -O --torso --test

- 타겟 오디오로 추론하기:

python main.py data/obama/ --workspace trial_obama_torso/ -O --torso --test --test_train --aud <audio>.npy

팁: --smooth_path 파라미터를 추가하면 헤드 지터가 줄어들지만 자세 정확도가 떨어질 수 있습니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...