일반 소개

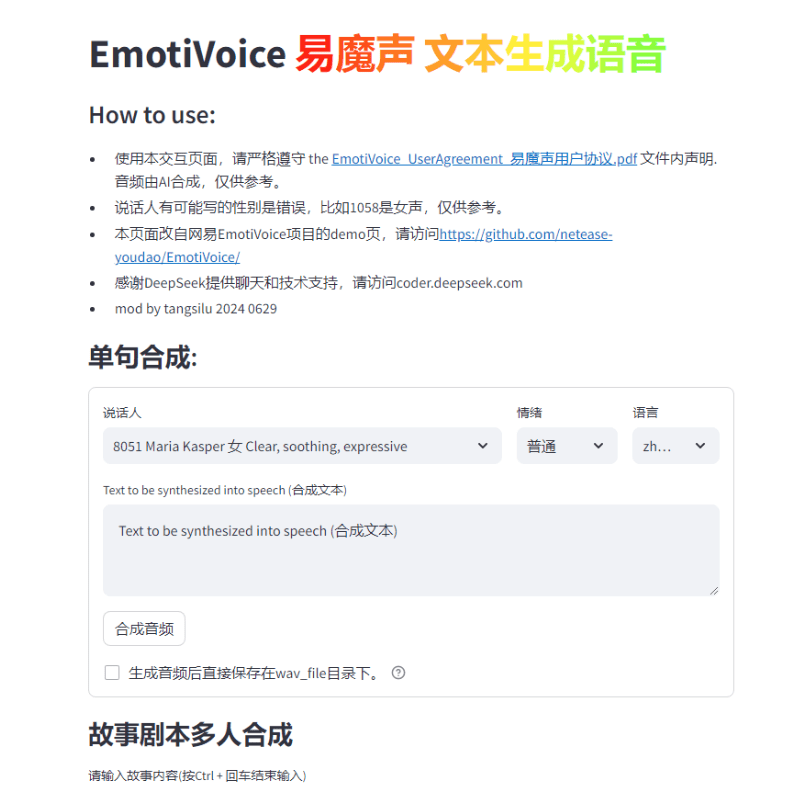

EmotiVoice는 넷이즈유다오에서 개발한 다중 음성 및 감정 단서 제어 기능을 갖춘 텍스트 음성 변환(TTS) 엔진입니다. 이 오픈 소스 TTS 엔진은 영어와 중국어를 지원하며 2000개 이상의 다양한 음성을 보유하고 있고 감정 합성 기능을 통해 행복, 흥분, 슬픔, 분노 등 다양한 감정을 가진 음성을 생성할 수 있습니다. 사용하기 쉬운 웹 인터페이스와 스크립트 인터페이스의 일괄 생성 결과를 제공합니다.

기능 목록

웹 인터페이스 및 스크립트 일괄 처리 인터페이스 제공

감정 합성 지원

다양한 사운드 옵션

중국어 및 영어 합성 지원

도움말 사용

설치, 사용 지침은 GitHub 리포지토리에서 확인하세요.

도커 이미지를 실행하여 EmotiVoice 체험하기

사전 학습된 모델과 같은 추가 정보를 다운로드하려면 위키 페이지를 참조하세요.

WeChat 그룹에 가입하여 피드백 교환

커뮤니티의 요청에 따라, 저희는 기쁜 마음으로 다음과 같이사운드 복제 기능를 통해 두 가지 예제 튜토리얼을 제공합니다!

참고.

- 이 기능을 사용하려면 최소한 하나 이상의 Nvidia GPU 그래픽 .

- 대상 사운드데이터의 중요성! 자세한 요구 사항은 다음 섹션에서 확인할 수 있습니다.

- 현재 이 기능은 중국어와 영어로만 지원되므로 중국어 데이터 또는 영어 데이터로 다음과 같이 학습할 수 있습니다.두 가지 언어를 구사할 수 있는 음색 모델 가져오기.

- EmotiVoice는 감정 제어를 지원하지만, 음성으로 감정을 전달하려면 학습 데이터도 감정적이어야 합니다.

- 데이터만 사용하여 훈련한 후, EmotiVoice의원본 사운드가 변경됩니다.. 즉, 새 모델은 사용자의 데이터에 완전히 맞춤화됩니다. EmotiVoice의 2000개 이상의 오리지널 음성을 사용하려면 사전 학습된 오리지널 모델을 사용하는 것이 좋습니다.

학습 데이터에 대한 세부 요구 사항

- 오디오 데이터는 고품질이어야 하며 한 사람의 목소리를 선명하고 왜곡 없이 전달할 수 있어야 합니다. 길이나 문장 수는 당분간 필수는 아니며, 몇 문장 정도는 괜찮지만 100문장 이상은 권장됩니다.

- 각 오디오에 해당하는 텍스트는 음성의 내용과 엄격하게 일치해야 합니다. 훈련 전에 원시 텍스트는 G2P를 사용하여 음소로 변환됩니다. 일시 정지(sp*) 및 다성 변환 결과는 교육 품질에 큰 영향을 미칩니다.

- 음성으로 감정을 전달하려면 학습 데이터도 감정적이어야 합니다. 또한 각 오디오에 대해 **태그 '프롬프트'**의 내용을 수정해야 합니다. 프롬프트의 내용에는 감정, 말 속도, 말하기 스타일에 대한 모든 형태의 텍스트 설명이 포함될 수 있습니다.

- 그러면 다음과 같은 파일이 생성됩니다.

data directory디렉토리에 두 개의 하위 디렉터리인train노래로 응답valid. 각 하위 디렉터리에는datalist.jsonl파일과 각 줄의 서식이 지정됩니다:{"key": "LJ002-0020", "wav_path": "data/LJspeech/wavs/LJ002-0020.wav", "speaker": "LJ", "text": ["<sos/eos>", "[IH0]", "[N]", "engsp1", "[EY0]", "[T]", "[IY1]", "[N]", "engsp1", "[TH]", "[ER1]", "[T]", "[IY1]", "[N]", ".", "<sos/eos>"], "original_text": "In 1813", "prompt": "common"}.

교육 단계 배포.

중국어는 다음을 참조하세요. 데이터베이커 레시피영어 버전을 참조하세요:LJSpeech 레시피. 다음은 요약한 내용입니다:

- 교육 환경 준비 - 한 번만 구성하면 됩니다.

# create conda enviroment conda create -n EmotiVoice python=3.8 -y conda activate EmotiVoice # then run: pip install EmotiVoice[train] # or git clone https://github.com/netease-youdao/EmotiVoice pip install -e .[train]

- 상담 학습 데이터에 대한 세부 요구 사항 데이터 준비 수행, 권장 참조 예제데이터베이커 레시피 노래로 응답 LJSpeech 레시피메서드 및 스크립트의

- 다음으로 다음 명령을 실행하여 교육용 디렉터리를 만듭니다:

python prepare_for_training.py --data_dir <data directory> --exp_dir <experiment directory>. 교체<data directory>를 준비된 데이터 디렉토리의 실제 경로로 사용합니다.<experiment directory>는 실험 디렉터리의 원하는 경로입니다. - 서버 구성 및 데이터에 따라 수정 가능

<experiment directory>/config/config.py. 수정을 완료한 후 다음 명령을 실행하여 교육 프로세스를 시작합니다.torchrun --nproc_per_node=1 --master_port 8018 train_am_vocoder_joint.py --config_folder <experiment directory>/config --load_pretrained_model True. (이 명령은 지정된 구성 폴더를 사용하여 학습 프로세스를 시작하고 지정된 사전 학습된 모델을 로드합니다). 이 방법은 현재 Linux에서 사용할 수 있으며, Windows에서는 문제가 발생할 수 있습니다! - 몇 가지 교육 단계를 완료한 후 체크포인트를 선택하고 다음 명령을 실행하여 결과가 예상대로 나오는지 확인합니다:

python inference_am_vocoder_exp.py --config_folder exp/DataBaker/config --checkpoint g_00010000 --test_file data/inference/text. 수정하는 것을 잊지 마세요.data/inference/text의 스피커 필드에 있는 내용 결과가 만족스럽다면 자유롭게 사용하세요! 데모 페이지의 수정된 버전이 제공됩니다.demo_page_databaker.py데이터베이커로 복제 후 톤의 효과를 직접 체험해 보세요. - 결과가 만족스럽지 않은 경우 교육을 계속하거나 데이터와 환경을 점검할 수 있습니다. 물론 커뮤니티에서 자유롭게 토론하거나 문제를 제출하세요!

런타임 참조 정보.

참조를 위해 다음과 같은 런타임 정보와 하드웨어 구성 정보를 제공합니다:

- Pip 패키지 버전: Python 3.8.18, torch 1.13.1, cuda 11.7

- GPU 카드 모델: NVIDIA GeForce RTX 3090, NVIDIA A40

- 훈련 시간 소요: 10,000보 훈련에는 약 1~2시간이 소요됩니다.

GPU 그래픽 카드 없이 CPU만 사용하여 훈련할 수도 있습니다. 좋은 소식을 기다려주세요!

원클릭 설치 패키지 다운로드 주소

압축 해제 비밀번호는 jian27 또는 jian27.com입니다.

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 문서

댓글 없음...