Edge TTS Worker: Cloudflare, OpenAI 호환 형식 및 패키지 웹 인터페이스를 사용하여 Microsoft 음성 합성 API 배포하기

일반 소개

Edge TTS Worker(종속성) edge-tts Edge TTS Worker는 클라우드플레어 워커에 배포된 프록시 서비스로, Microsoft Edge TTS 서비스를 OpenAI 형식과 호환되는 API 인터페이스로 캡슐화합니다. 이 프로젝트를 통해 사용자는 Microsoft의 인증 없이도 Microsoft의 고품질 음성 합성 서비스를 쉽게 사용할 수 있으며, Edge TTS Worker는 중국어, 영어, 일본어, 한국어 등 다국어 지원을 제공하며, Cloudflare Worker 무료 요금제를 기반으로 완전히 무료입니다. 또한 이 서비스는 보안 및 제어를 보장하기 위해 사용자 지정 API 키를 지원하며 몇 분 내에 신속하게 배포할 수 있습니다.

테스트 API: https://tts.aishare.us.kg/ KEY: aisharenet

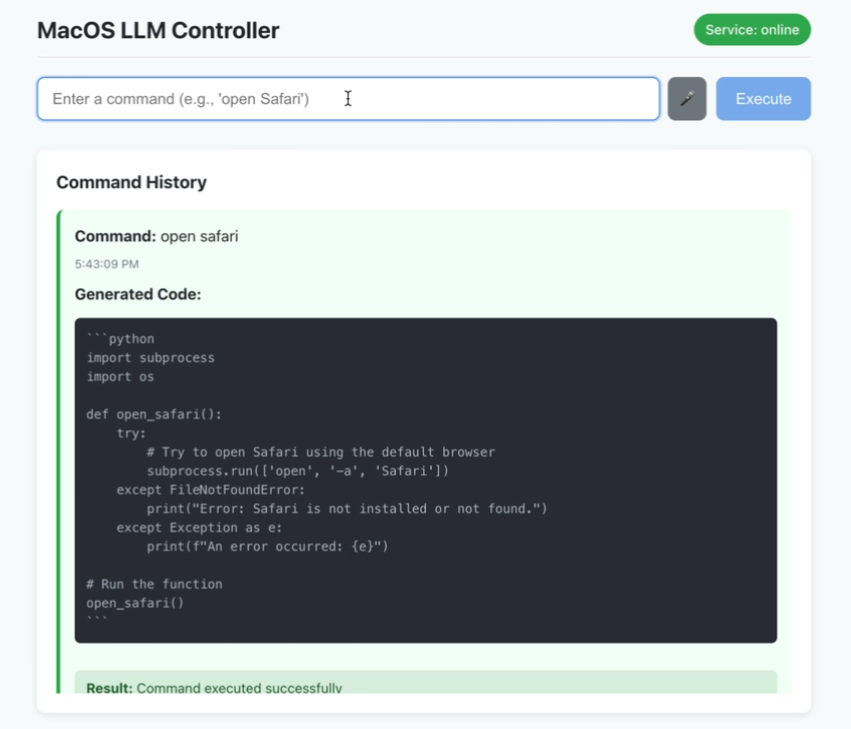

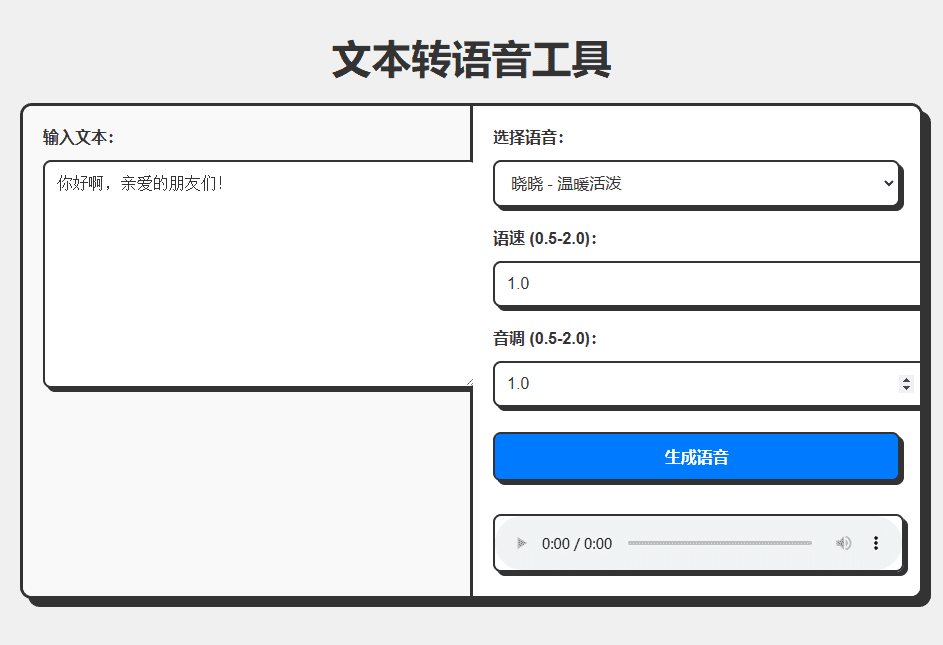

Cloudflare 배포로 완성되는 패키징 API 및 인터페이스:

전체 코드는 CHATGPT에 의해 생성되며, 코드가 문서 끝에 첨부되어 있으며 추가할 수 있는 옵션이 있습니다. AI 프로그래밍 도구 또는 용도 트리클 (원클릭 온라인 접근성 음성 생성 서비스):

체험: https://edgetts.aishare.us.kg/

기능 목록

- OpenAI 호환 인터페이스 형식 제공

- 본토 액세스 제한 우회 및 Microsoft 서비스 인증 단계 제거

- 중국어, 영어, 일본어, 한국어 등 다국어 지원

- 완전 무료, Cloudflare Worker 무료 요금제 기준

- 보안 및 제어를 위한 사용자 지정 API 키 지원

- 몇 분 만에 준비되는 신속한 배포

- 다양한 음성 효과를 테스트할 수 있는 테스트 스크립트 제공

도움말 사용

설치 프로세스

- 워커 만들기

- Cloudflare 대시보드에 로그인

- 작업자 및 페이지로 이동하여 작업자 만들기를 클릭합니다.

- 작업자의 이름을 지정합니다(예: edge-tts).

- 배포 코드

- 편집기에서 기본 코드를 제거합니다.

- 복사본 만들기

worker.js에 코드를 붙여넣고 - 저장 및 배포를 클릭합니다.

- API 키 설정(선택 사항)

- 워커의 설정 페이지에서 설정 찾기 -> 변수를 찾습니다.

- 변수 추가를 클릭하고 원하는 키의 이름과 값을 API_KEY에 입력합니다.

- 저장 및 배포를 클릭합니다.

- 사용자 정의 도메인 이름 구성(선택 사항)

- 전제 조건: 도메인이 이미 Cloudflare에서 호스팅되고 있으며 도메인의 DNS 레코드가 Cloudflare를 통해 프록시되었습니다(프록시 상태는 주황색 클라우드).

- 구성 단계:

- 작업자 상세정보 페이지에서 설정 탭을 클릭합니다.

- 도메인 및 라우팅 섹션을 찾아 추가 버튼을 클릭합니다.

- 사용자 정의 도메인을 선택하고 사용하려는 도메인 이름을 입력합니다(예: tts.example.com).

- 도메인 추가를 클릭하고 인증서 배포가 완료될 때까지 기다립니다(보통 몇 분 이내).

사용법

- TTY(텍스트 음성 변환 인터페이스)

- 중국어 음성 예시:

curl -X POST https://你的worker地址/v1/audio/speech \ -H "Content-Type: application/json" \ -H "Authorization: Bearer your-api-key" \ -d '{ "model": "tts-1", "input": "你好,世界!", "voice": "zh-CN-XiaoxiaoNeural", "response_format": "mp3", "speed": 1.0, "pitch": 1.0, "style":"general" }' --output chinese.mp3- 영어 연설의 예:

curl -X POST https://你的worker地址/v1/audio/speech \ -H "Content-Type: application/json" \ -H "Authorization: Bearer your-api-key" \ -d '{ "model": "tts-1", "input": "Hello, World!", "voice": "en-US-JennyNeural", "response_format": "mp3", "speed": 1.0, "pitch": 1.0, "style":"general" }' --output english.mp3 - 테스트 스크립트 사용

- 테스트 스크립트 다운로드

test_voices.sh - 스크립트에 실행 권한을 추가합니다:

bash

chmod +x test_voices.sh - 스크립트를 실행합니다:

bash

./test_voices.sh <Worker地址> [API密钥] - 예시:

bash

# 使用 API 密钥

./test_voices.sh https://your-worker.workers.dev your-api-key

# 不使用 API 密钥

./test_voices.sh https://your-worker.workers.dev - 스크립트는 지원되는 각 음성에 대한 테스트 오디오 파일을 생성하며, 이를 재생하여 가장 적합한 음성을 선택할 수 있습니다.

- 테스트 스크립트 다운로드

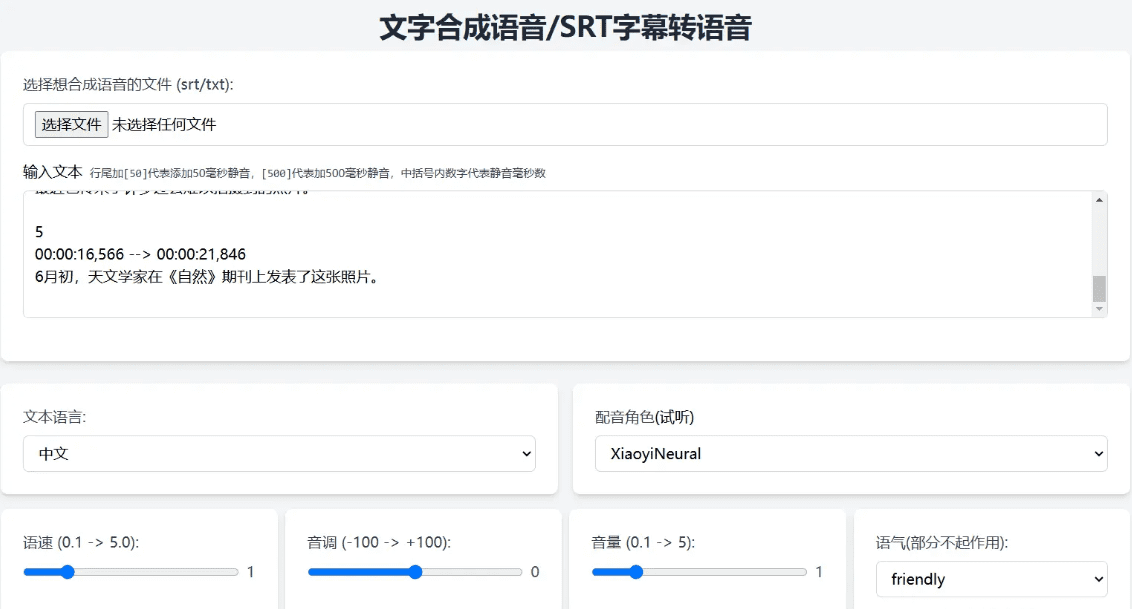

API 매개변수 설명

model(문자열): 모델 이름(고정값), 예: 예tts-1input(문자열): 변환할 텍스트, 예를 들면 다음과 같습니다."你好,世界!"voice(문자열): 음성 이름(예.zh-CN-XiaoxiaoNeuralresponse_format(문자열, 선택 사항): 출력 형식, 기본값은 다음과 같습니다.mp3speed(숫자, 선택 사항): 말하기 속도(0.5-2.0), 기본값은 다음과 같습니다.1.0pitch(숫자, 선택 사항): 톤(0.5-2.0), 기본값은 다음과 같습니다.1.0style(문자열, 선택 사항): 감정, 기본값은general

지원되는 음성 목록

음성에 해당하는 언어 텍스트를 사용해야 합니다(예: 중국어 음성은 중국어 텍스트와 함께 사용해야 합니다). 다음은 일반적으로 사용되는 음성의 예입니다:

zh-CN-XiaoxiaoNeural: 샤오샤오 - 따뜻하고 활기찬zh-CN-XiaoyiNeural: 샤오이 - 따뜻함과 친절함zh-CN-YunxiNeural:: 얌시 - 남성 목소리, 안정적zh-CN-YunyangNeural:: 윤양 - 남성 목소리, 프로페셔널zh-CN-XiaohanNeural: 샤오한 - 자연스러운 흐름zh-CN-XiaomengNeural: 샤오멍 - 달콤하고 활기찬zh-CN-XiaochenNeural샤오첸 - 부드럽고 쉬운- 잠깐만요...

workers.js 코드

const API_KEY = 'aisharenet'; // 替换为你的实际 API key const TOKEN_REFRESH_BEFORE_EXPIRY = 3 * 60; // Token 刷新时间(秒) const DEFAULT_VOICE = 'zh-CN-XiaoxiaoNeural'; // 默认语音 const DEFAULT_SPEED = 1.0; // 默认语速 const DEFAULT_PITCH = 1.0; // 默认音调 let tokenInfo = { endpoint: null, token: null, expiredAt: null }; // 处理请求 addEventListener('fetch', event => { event.respondWith(handleRequest(event.request)); }); async function handleRequest(request) { const url = new URL(request.url); // 如果请求根路径,返回 Web UI if (url.pathname === '/') { return new Response(getWebUI(), { headers: { 'Content-Type': 'text/html' }, }); } // 处理 TTS 请求 if (url.pathname === '/v1/audio/speech') { return handleTTSRequest(request); } // 默认返回 404 return new Response('Not Found', { status: 404 }); } // 处理 TTS 请求 async function handleTTSRequest(request) { if (request.method === 'OPTIONS') { return handleOptions(request); } // 验证 API Key const authHeader = request.headers.get('authorization') || request.headers.get('x-api-key'); const apiKey = authHeader?.startsWith('Bearer ') ? authHeader.slice(7) : null; if (API_KEY && apiKey !== API_KEY) { return createErrorResponse('Invalid API key. Use \'Authorization: Bearer your-api-key\' header', 'invalid_api_key', 401); } try { const requestBody = await request.json(); const { model = "tts-1", input, voice = DEFAULT_VOICE, speed = DEFAULT_SPEED, pitch = DEFAULT_PITCH } = requestBody; // 验证参数范围 validateParameterRange('speed', speed, 0.5, 2.0); validateParameterRange('pitch', pitch, 0.5, 2.0); const rate = calculateRate(speed); const numPitch = calculatePitch(pitch); const audioResponse = await getVoice( input, voice, rate >= 0 ? `+${rate}%` : `${rate}%`, numPitch >= 0 ? `+${numPitch}%` : `${numPitch}%`, '+0%', 'general', // 固定风格为通用 'audio-24khz-48kbitrate-mono-mp3' // 固定音频格式为 MP3 ); return audioResponse; } catch (error) { return createErrorResponse(error.message, 'edge_tts_error', 500); } } // 处理 OPTIONS 请求 function handleOptions(request) { return new Response(null, { headers: { ...makeCORSHeaders(), 'Access-Control-Allow-Methods': 'GET,HEAD,POST,OPTIONS', 'Access-Control-Allow-Headers': request.headers.get('Access-Control-Request-Headers') || 'Authorization', }, }); } // 创建错误响应 function createErrorResponse(message, code, status) { return new Response( JSON.stringify({ error: { message, code } }), { status, headers: { 'Content-Type': 'application/json', ...makeCORSHeaders() }, } ); } // 验证参数范围 function validateParameterRange(name, value, min, max) { if (value < min || value > max) { throw new Error(`${name} must be between ${min} and ${max}`); } } // 计算语速 function calculateRate(speed) { return parseInt(String((parseFloat(speed) - 1.0) * 100)); } // 计算音调 function calculatePitch(pitch) { return parseInt(String((parseFloat(pitch) - 1.0) * 100)); } // 生成 CORS 头 function makeCORSHeaders() { return { 'Access-Control-Allow-Origin': '*', 'Access-Control-Allow-Methods': 'GET,HEAD,POST,OPTIONS', 'Access-Control-Allow-Headers': 'Content-Type, x-api-key', 'Access-Control-Max-Age': '86400', }; } // 获取语音 async function getVoice(text, voiceName, rate, pitch, volume, style, outputFormat) { try { const chunks = text.trim().split("\n"); const audioChunks = await Promise.all(chunks.map(chunk => getAudioChunk(chunk, voiceName, rate, pitch, volume, style, outputFormat))); // 将音频片段拼接起来 const concatenatedAudio = new Blob(audioChunks, { type: `audio/${outputFormat.split('-').pop()}` }); return new Response(concatenatedAudio, { headers: { 'Content-Type': `audio/${outputFormat.split('-').pop()}`, ...makeCORSHeaders(), }, }); } catch (error) { console.error("语音合成失败:", error); return createErrorResponse(error.message, 'edge_tts_error', 500); } } // 获取单个音频片段 async function getAudioChunk(text, voiceName, rate, pitch, volume, style, outputFormat) { const endpoint = await getEndpoint(); const url = `https://${endpoint.r}.tts.speech.microsoft.com/cognitiveservices/v1`; const slien = extractSilenceDuration(text); const response = await fetch(url, { method: "POST", headers: { "Authorization": endpoint.t, "Content-Type": "application/ssml+xml", "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/127.0.0.0 Safari/537.36 Edg/127.0.0.0", "X-Microsoft-OutputFormat": outputFormat, }, body: getSsml(text, voiceName, rate, pitch, volume, style, slien), }); if (!response.ok) { const errorText = await response.text(); throw new Error(`Edge TTS API error: ${response.status} ${errorText}`); } return response.blob(); } // 提取静音时长 function extractSilenceDuration(text) { const match = text.match(/\[(\d+)\]\s*?$/); return match && match.length === 2 ? parseInt(match[1]) : 0; } // 生成 SSML function getSsml(text, voiceName, rate, pitch, volume, style, slien) { const slienStr = slien > 0 ? `` : ''; return ` ${text} ${slienStr} `; } // 获取 Endpoint async function getEndpoint() { const now = Date.now() / 1000; if (tokenInfo.token && tokenInfo.expiredAt && now < tokenInfo.expiredAt - TOKEN_REFRESH_BEFORE_EXPIRY) { return tokenInfo.endpoint; } // 获取新 Token const endpointUrl = "https://dev.microsofttranslator.com/apps/endpoint?api-version=1.0"; const clientId = crypto.randomUUID().replace(/-/g, ""); try { const response = await fetch(endpointUrl, { method: "POST", headers: { "Accept-Language": "zh-Hans", "X-ClientVersion": "4.0.530a 5fe1dc6c", "X-UserId": "0f04d16a175c411e", "X-HomeGeographicRegion": "zh-Hans-CN", "X-ClientTraceId": clientId, "X-MT-Signature": await sign(endpointUrl), "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/127.0.0.0 Safari/537.36 Edg/127.0.0.0", "Content-Type": "application/json; charset=utf-8", "Content-Length": "0", "Accept-Encoding": "gzip", }, }); if (!response.ok) { throw new Error(`获取 Endpoint 失败: ${response.status}`); } const data = await response.json(); const jwt = data.t.split(".")[1]; const decodedJwt = JSON.parse(atob(jwt)); tokenInfo = { endpoint: data, token: data.t, expiredAt: decodedJwt.exp, }; return data; } catch (error) { console.error("获取 Endpoint 失败:", error); if (tokenInfo.token) { console.log("使用过期的缓存 Token"); return tokenInfo.endpoint; } throw error; } } // 签名 async function sign(urlStr) { const url = urlStr.split("://")[1]; const encodedUrl = encodeURIComponent(url); const uuidStr = uuid(); const formattedDate = dateFormat(); const bytesToSign = `MSTranslatorAndroidApp${encodedUrl}${formattedDate}${uuidStr}`.toLowerCase(); const decode = await base64ToBytes("oik6PdDdMnOXemTbwvMn9de/h9lFnfBaCWbGMMZqqoSaQaqUOqjVGm5NqsmjcBI1x+sS9ugjB55HEJWRiFXYFw=="); const signData = await hmacSha256(decode, bytesToSign); const signBase64 = await bytesToBase64(signData); return `MSTranslatorAndroidApp::${signBase64}::${formattedDate}::${uuidStr}`; } // 格式化日期 function dateFormat() { return (new Date()).toUTCString().replace(/GMT/, "").trim() + " GMT"; } // HMAC SHA-256 签名 async function hmacSha256(key, data) { const cryptoKey = await crypto.subtle.importKey( "raw", key, { name: "HMAC", hash: { name: "SHA-256" } }, false, ["sign"] ); const signature = await crypto.subtle.sign("HMAC", cryptoKey, new TextEncoder().encode(data)); return new Uint8Array(signature); } // Base64 转字节数组 async function base64ToBytes(base64) { const binaryString = atob(base64); const bytes = new Uint8Array(binaryString.length); for (let i = 0; i < binaryString.length; i++) { bytes[i] = binaryString.charCodeAt(i); } return bytes; } // 字节数组转 Base64 async function bytesToBase64(bytes) { return btoa(String.fromCharCode.apply(null, bytes)); } // 生成 UUID function uuid() { return crypto.randomUUID().replace(/-/g, ""); } // 获取 Web UI function getWebUI() { return `

텍스트 음성 변환 도구

음성이 생성되는 동안 잠시 기다려주세요...

`; }

© 저작권 정책

기사 저작권 AI 공유 서클 모두 무단 복제하지 마세요.

관련 게시물

댓글 없음...